家人们,撰写和修改病历这事儿,那个让无数医生耗时耗力的环节——

病历内涵质控,现在有了大模型来当得力帮手。

所谓病历内涵质控,简单来说指的就是对病历内容的质量控制。

那它为什么会让医生们如此耗时耗力呢?

首先,病历本身就会完整、真实地反映出诊疗的全过程,不论对于患者或者医生,还是对医院的管理而言,重要程度都不言而喻。

毕竟从前期的出诊,到后期的治疗方案、查房、手术等众多环节,病历都会贯穿其中,收纳、承载和呈现所有相关信息。每一份病历涉及到的信息量都是非常大,也是非常关键的。

而病历内涵质控,强调的是一种逻辑质控,难点就是逻辑非常抽象,定义和规则也不通俗;要把控它的质量就需要深厚且全面的临床经验和知识。

也正因如此,一般人还真做不了这事,医院传统的“解法”就是——

组建专家团队,定时对归档病历(尤其是重点病患)进行人工质控。

这种解法自然费时费力,而且它还很难对所有病历进行遍历,更多时候只能针对少部分病历进行抽查。

正如我们刚才提到的,现在这件难事儿,已经靠大模型的辅助,找到了一种能兼顾效率和质量的解法。

而且纵观整个“AI+医疗”赛道,很多医疗信息化厂商都将大模型应用落地的箭头指向类似病历内涵质控这样的应用“靶点”。

之所以如此,是因为处理病历这项工作,正与大模型的“气质”极其相符——专治繁琐、量大的信息处理工作。

由此便可以让医生从中解放出更多的时间,投入到更匹配其专业方向的工作中。

那么具体效果如何?是否能达到医院的标准呢?

在专攻用大模型搞病历内涵质控这件事上,惠每科技可以说是拥有相当丰富的经验,是已经在多家医院(包括三甲医院)“上岗”并收获大量好评的那种。

医疗大模型效果如何,我们不妨来看下惠每科技交出的“作业”。

在惠每科技医疗大模型的加持之下,现在从医生书写病历开始,它就会伴随在旁,像个隐形的“专家级”助手,同步就会开始纠错、提醒的工作了。

例如在上图的三个场景中,分别对应的情况是:

这些细节内容要是放在之前,都是需要医生们仔细比对校验,并根据经验知识来甄别、挑错的,可实际上,不同医生在经验、资历甚至是专业方向上的差别,都会让这些细节的发现、校验和应对变得异常复杂。

但现在,有了医疗大模型的辅助,这个助手总会默默地在合适的时机出现,把可能存在问题的内容给pick出来,供医生们快速做判断。

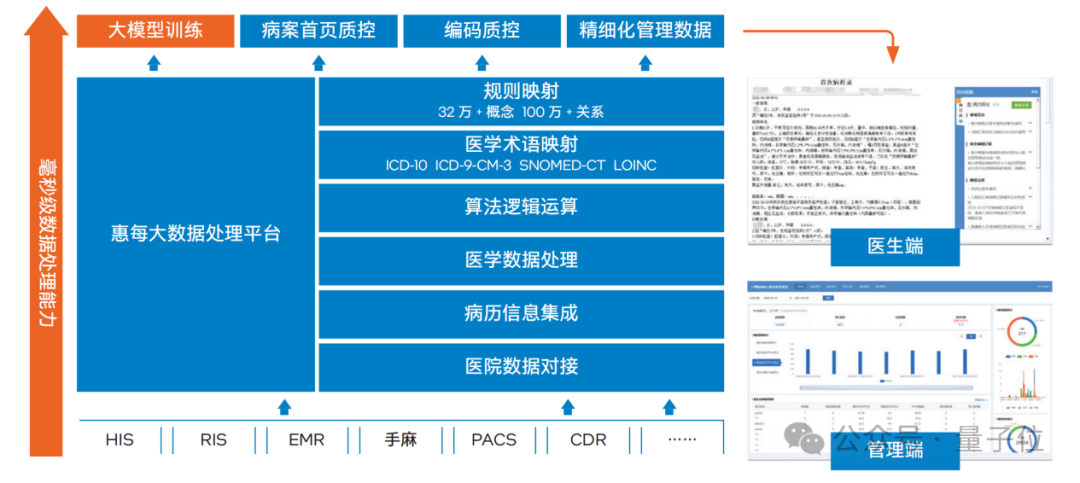

具体到病历内涵质控的运行机制,惠每科技则是以数据中台为核心,向下对接医院的医院信息系统(HIS)、影像归档和信息系统(PACS),以及电子病历归档系统(EMR)等。

在自动抓取内容信息之后,会通过自然语言处理、术语标准化后构建患者画像,再经由惠每医疗大模型推理计算做出提醒或预警,同时大模型还可以基于用户的反馈持续进行优化。

最终,在界面的呈现上,惠每科技这个系统会有医生端和管理端两种:

医生在医生端快速做错误检测和处理,专家在管理端做更进一步的专业性查缺补漏。

由此,原先那种费时费力、费人费脑的病历内涵质控,不但实现了自动化,而且效率也一下子就有了翻天覆地的变化,更重要的是,质控之后的病历质量也随之同步提升。可谓一箭双雕,甚至是一箭三雕!

眼见为实!咱们瞧瞧来自一线用户的真实反馈。

以某三甲医院为例,上线了惠每科技的这套方案之后,病历内涵质控效果的“打开方式”就变成了这样:

全院的甲级病历(下图中的绿色曲线)从原先的75%直接暴涨到了95%!

病历质量的大幅提高就像“作用力与反作用力”,此举反过来也让医生诊疗工作的规范性和病案管理质量得到了提高。

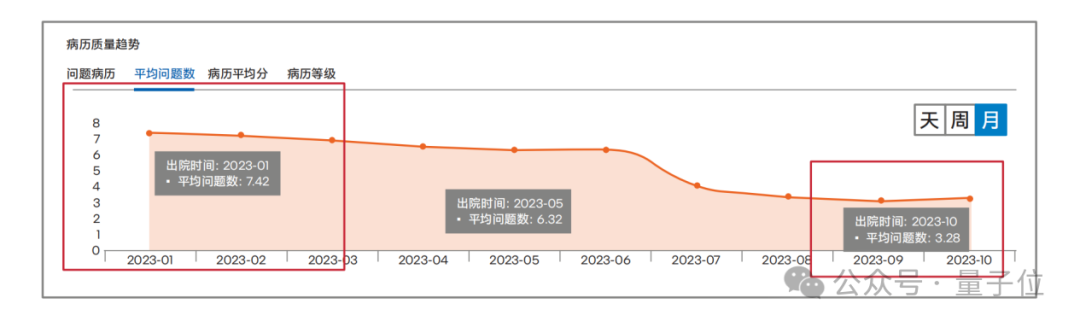

由此双管齐下,有问题的病历数量就变得越来越少,以某医院为例——

仅10个月时间,病历平均问题数从最开始的7.42个,下降到了3.28个,下降比率高达55.79%!

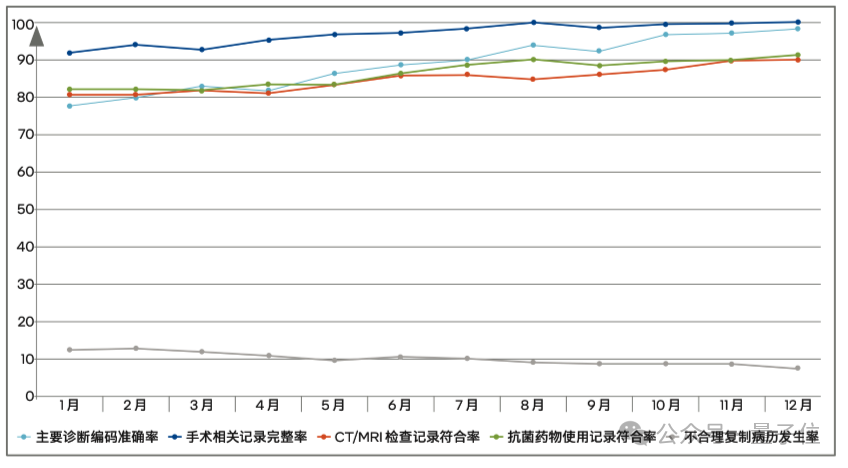

像这样的实际应用效果还可以从某省级病案管理质量控制中心的病历质控监测指标看出。

方案在该省某医院落地后,病案首页质量相关的主要诊断编码正确率从78%提升至97%、病历文书的手术相关记录完整率从92%提升至99%、CT/MRI检查记录完整率从81%提升至90%、抗菌药物使用记录符合率从82%提升至91%,不合格复制病历发生率则从12%下降至8%,很好地满足了该中心的质控监测要求。

那么接下来的一个问题是,毕竟医疗场景涉及患者隐私,就这么交由大模型来训练和推理,够安全吗?

对此,惠每科技也有自己深入的理解和切实可靠的实践路径:

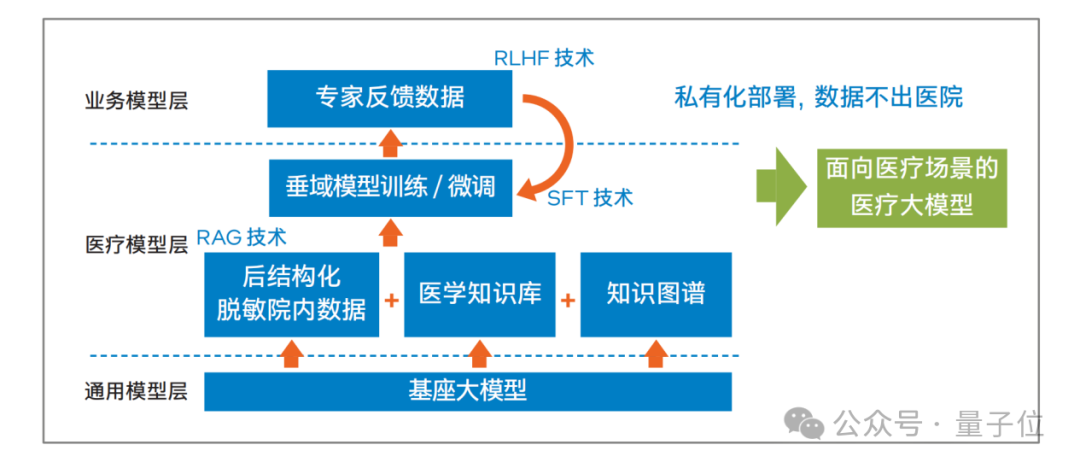

私有化部署,数据不出医院。

具体而言,惠每科技是以ChatGLM等流行的基座大模型为基础,铺于医学知识库和医学知识图谱等,还结合了RAG(检索增强生成)技术,在垂直领域做模型的训练和微调等工作。

与此同步,专家的反馈也会通过RLHF(人类反馈强化学习)技术加入到上述过程,并最终形成面向不同医疗场景的医疗大模型。

而这整个过程中都采用的是私有化部署的方式,微调也是基于SFT(监督微调)来展开,因此便更好地保障了安全性。

由此总结来看,医疗大模型“上岗”医院后,在病历内涵质控这件事上起码做到了三点:

更专业、更安全、更效率。

但有一说一,在这个医疗大模型和系统的背后,还有一个关键因素在默默发力。

医疗大模型方案要想真正落地并发挥价值,除了算法模型本身要够强大之外,还必须克服私有化部署所面临的种种挑战。

不论是出于数据与隐私安全、业务便捷还是成本考量,部署在本地、把控在自己手上,始终是越来越多行业用户的期盼。

特别是对医疗行业来说,私有化的部署和落地更是一种“刚需”。

毕竟不同医院的病历格式本身差异就较大,加之涉及患者隐私,惠每科技的私有化部署策略,几乎成了医疗大模型落地的最基本前提。

这样一来,在基础设施的选择上,又面临一系列问题。

成本角度上,现代化医院本来就是各行业信息化领域的主力军,此前多年在通用计算类IT基础设施上曾有大量投入,在此基础上再导入专用AI加速器需要额外投入,而且这些加速器如今获取难度还在不断加大(你懂的)。

从性能角度看,也要求硬件平台能满足AI模型推理所需的性能,特别是要满足实时性或近实时性标准。

那么有没有一种方案,既可以让医疗大模型更顺滑地落地,还能充分利用现有软硬件设施,并同时兼顾性能、总拥有成本和获取难度呢?

面对这一系列难题,惠每科技可谓是“有备而来”。

它选择了与英特尔合作,基于英特尔® 至强® CPU Max系列处理器、OpenVINO™ 工具套件及开源大模型加速库IPEX-LLM,打造了一套”高性价比医疗大模型私有化落地方案”。

作为业界首款内置高带宽内存 (HBM) 的x86架构CPU,至强® CPU Max系列集成了高达64GB容量的HBM2e内存,其理论带宽可达主流DDR5内存的4倍,足以应对大模型推理时对内存性能的严苛要求。

此外,该处理器还内置有英特尔® AMX(英特尔® 高级矩阵扩展)加速技术,经特定优化后,其每时钟周期可完成多达2048个INT8运算,较上一代同类指令实现了8倍性能飞跃。

除硬件优势之外,在软件方面,英特尔也为惠每科技提供了成熟的优化工具与技术支持。

例如借助IPEX-LLM 大模型库实现推理加速的低精度量化方案,以及基于 OpenVINO™ 工具套件开展的非量化优化方案,双管齐下,能让医疗大模型在至强® 平台上的推理效率得到显著提升。

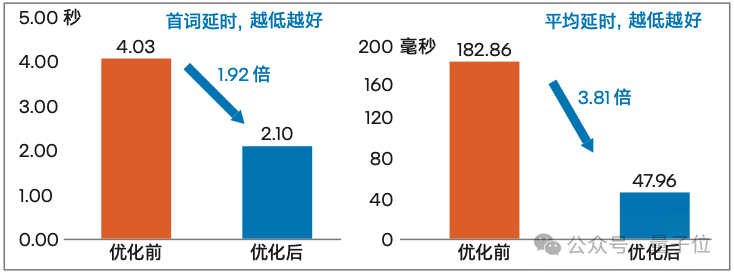

据惠每科技实测,经非量化方案优化后,当输入文本为2K时,模型首词时延由优化前的 4.03秒骤降至2.1秒,性能提升达1.92倍。平均时延则由182.86毫秒每Token缩短至47.96毫秒每 Token,提升幅度高达3.81倍。而这,已经十分接近专用AI加速芯片的性能水平了。

而且,除了让医疗大模型私有化落地从“不可能”变为“可能”,基于英特尔® 至强® 平台还有一个容易被忽视但至关重要的优势,那就是上线效率。

得益于英特尔® 架构平台成熟的生态以及双方的深度协同,更重要的是医疗行业对于该平台广泛的部署和较高的应用水准,医院开展惠每医疗大模型方案私有化部署时,从准备到最终产出收益,仅需3.5 个月左右。

这就让 AI 智能化带来的变革成果显得更加“立竿见影”。

通过惠每科技病历质量控制这一用例,不难看出:英特尔® CPU平台+AI加速工具,不失为大模型从实验室走向行业、加速落地与实践的一剂”良方”。

其实在智慧医疗的背景下,病历质控只是一个缩影。

从智能导诊到辅助诊断,从药物研发到疾病预测,AI正以多种方式为医疗行业带来更多变革。

智慧医疗又何尝不是“人工智能+”时代的一块重要拼图呢?

更广泛的视角下,类似医疗这样涉及隐私、对AI私有化部署有强要求的行业,还有金融、法律、教育、出行……可以说,越是距离每个人生活更近的行业,就越需要考虑这个问题。

如果再考虑到在数字化转型中已有一定投入,希望充分利用原有IT基础设施,以总拥有成本更低的方式开展AI实践的行业,那就更多了。

所以说在这一轮推进智能化转型的浪潮中,像英特尔与惠每科技合作打造的这种"一石多鸟"且“更接地气”的方案,无疑是一个值得参考的选择。

英特尔未来能不能继续以更高性价比、更易于获取和应用的软硬件平台为基础,全力加速AI在各个行业的创新应用,让科技为人类社会持续赋能,就很值得期待了。

为了科普CPU在AI推理新时代的玩法,量子位开设了《最“in”AI》专栏,将从技术科普、行业案例、实战优化等多个角度展开全面解读。

我们希望通过这个专栏,让更多的人了解CPU在AI推理加速,甚至是整个AI平台或全流程加速上的实践成果,重点就是如何更好地利用CPU来提升大模型应用的性能和效率。

文章来源于“量子位”,作者“关注前沿科技”

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner