转折

2018年夏天,夏立雪提交了他在清华大学电子工程系的博士论文。时间往前推5年,他的导师汪玉刚刚成为副教授,有了带博士的资格,于是夏立雪成为了汪玉的第一位博士生,进入了NICS-EFC实验室,这个实验室专注于做一件事:

针对深度学习的软硬件联合优化。

今天已是清华大学目前最年轻系主任的汪玉,博士毕业留在电子系任教时选择了定制应用域加速的方向,这在那时这是个较少人研究的领域。人工智能需要软件和硬件一起实现,区别于今天人们经常会刷到的各种算法层面的优化方法,也区别于以英伟达一代又一代新架构为代表的硬件本身的迭代方法,这个实验室在走第三条路。它希望从软硬件的结合处来切入。汪玉很早提出了“深度学习算法-编译-芯片联合设计”的路线,这也成为软硬件联合优化的一个典型路线。

这个实验室在2016年孵化了AI芯片公司深鉴科技,它从软件的升级来提升硬件的效率,并在2018年被赛灵思用3亿美元收购。这证明了这个技术的产业价值,然而这个技术路线一直无法更进一步:当时的AI领域,落地解决各个场景的算法都是一个个特定的小算法,要服务100个场景,就要做100次联合优化。

它没有规模效应。

“在2018年的时候,我们没有预料到这个问题最终解决的方式,但我们相信硬件一定会遇到瓶颈,这时就需要新的东西去做极致的跟进。”夏立雪对我说。深鉴是第一条路,而夏立雪们走了另一条路:

“我们相信一定会不断有新的计算范式能覆盖全新应用场景,使得软硬件联合优化这件事成为行业不断发展的关键。”

这个“赌注”在2022年底有了结果:ChatGPT征服了世界,基于Transformer架构的大模型统一了天下。

胜出的不只是这个赌注,软硬件联合优化这件事一下子变成了可以标准化和规模化的技术——从要服务100个场景就要做100次联合优化,到一次联合优化就能满足80%的需求,一个十余年积累的技术等来了一个意料之外的转折时刻。

“等”了十年的人们自然知道其中意义。作为汪玉实验室“大师兄”的夏立雪与汪玉以及诸多师兄弟密集沟通后,只用几个月快速完成了团队组建。在2023年初,一家叫做无问芯穹的公司成立。汪玉为无问芯穹的发起人,夏立雪担任CEO, 原商汤科技数据与计算平台部执行研究总监、时任北京大学副研究员的颜深根,以及现任上海交通大学长聘教轨副教授,清源研究院人工智能设计自动化创新实验室负责人戴国浩为联合创始人,分别担任CTO和首席科学家。之后它也快速完成了数亿元人民币融资。

无问芯穹希望把汪玉实验室过去十年积累的全栈技术,变成可以规模化服务整个模型产业的标准化产品。“MxN”是他们创业以来主打的标签:它希望打破不同芯片不同模型的阻隔,用软硬件联合优化的方式把M种模型和N种芯片统一起来。

但可能性远不止于此。

用夏立雪的话说,模型成本下降本质上是要做三件事:能源公司负责确定每一度电的价格,模型公司决定一个token能做多少事情。而在这中间,就是每一个 token 用多少度电的问题。

“我们要解决的是这个问题。”

AI Infra公司终于可以成为“安卓”

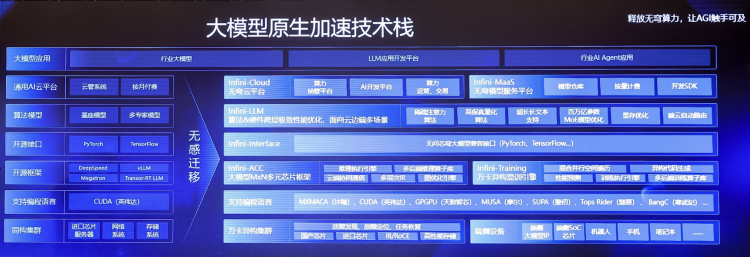

第一次召开产品发布会时,夏立雪站在台上,背后是无问芯穹的一整个技术产品图。它全面而细致,涵盖了大模型从训练到推理,从芯片到应用的各个环节。

无问芯穹构建了一整套从底层芯片到上层模型的“全栈垂直优化”技术:

在推理层,无问芯穹将其前沿研究成果FlashDecoding++以及在多款异构芯片上的FP16、INT4精度的计算优化技术集成在Infini-ACC大模型计算优化引擎里,同时结合请求服务层面的高效调度技术,显著提升推理速度和系统吞吐率,超越国际最主流的推理框架vLLM。

对推理进行优化已经是个确定的需求,也有很多创业公司在做相似的事情。

更重要的在于训练层面。无问芯穹的Infini-AI能实现异构混训,也就是在训练阶段,用不同厂商的芯片来一起提供算力。

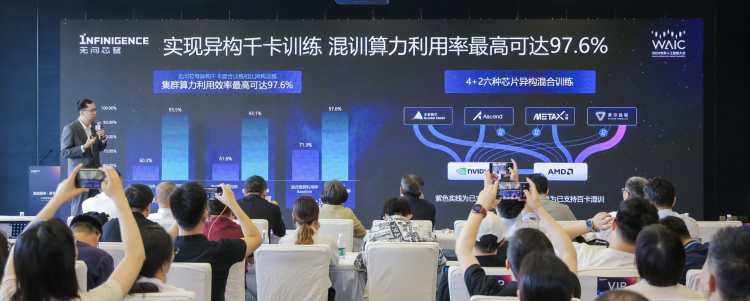

站在2024年上海世界人工智能大会的舞台上,夏立雪发布了无问芯穹大规模模型的异构分布式混合训练系统,千卡异构混合训练集群算力利用率最高达到了97.6%。同时,他宣布无问芯穹Infini-AI云平台已集成大模型异构千卡混训能力,是全球首个可进行单任务千卡规模异构芯片混合训练的平台,具备万卡扩展性,支持包括AMD、华为昇腾、天数智芯、沐曦、摩尔线程、NVIDIA六种异构芯片在内的大模型混合训练。

无问芯穹希望把这一切用标准产品提供给用户,让他们可以在无感知的情况下用上异构、高性价比且好用的算力,那些其他方式或平台训练而来的模型也可以0成本迁移到无问芯穹的平台上。

深度学习本质上是一个拟合器,让模型通过学习大量数据,产生预测数据的能力,然后用神经网络把参数定下来,再通过给足够多的X、Y做标记,从算法的层面上去支持不同的应用。这些计算通过GPU为主的芯片完成。而优化就是要帮助这个过程中的各个环节去繁从简,多余的边和点去掉,可以进一步压缩的地方抽象成一个层级,芯片的电路等设计也根据这些特点做出改进。过往对于人脸识别,语音识别等各种场景,要用不同的模型,也就要做不同的优化。而现在一个Transformer统一了大部分模型的底层,优化也就可以更加集中。

无问芯穹这样的AI Native Infra公司终于可以封装一切。

“因为模型通用了之后,把原本Infra的切面从一个更底层的东西推到了大家面前,把这个赛道的所有的事情都变宽了。”夏立雪说。

但除了技术范式演变带来的机会,显然无问芯穹的新模式也也与今天算力市场被英伟达“垄断”的格局有关。

最理想的情况当然是所有开发者都可以用到性能最强的芯片。但现实显然骨感很多。一方面,英伟达性能最强的芯片本身也在遭遇产能限制,另一方面,中国市场面对的是更严峻的现实,英伟达的高端产品进不来,芯片高端工艺受限,国产品牌选择较多但又都处在追赶状态,模型厂商们需要异构集群。

无问芯穹的MxN方案可以帮助这些芯片厂商与英伟达竞争,同时帮助模型厂商从英伟达享受的紧俏资源竞争中脱身。

事实上,英伟达也是软硬件联合优化路线的集大成者。

人们对英伟达展开过无尽的分析,但这些视角总是从硬件或软件的单一维度去分析英伟达:强大的CUDA已经是黄仁勋钦定的护城河;硬件上英伟达已经开启智能手机的节奏一年一代,并且优先享受制造厂最先进制程的产量。

因此外界也很容易会认为英伟达内负责软硬件之间协同的部门,似乎会处在不可一世的CUDA和贡献现金的硬件芯片的“夹缝”中,忙于处理衔接两者的需求。但据英伟达内部员工介绍,事实上,英伟达的软硬件协同部门,是一个可以给CUDA团队和芯片硬件团队同时下需求的存在。

而这样的路线终将迎来对手,无问芯穹是其中之一。但这个对手不是一个芯片公司,于是一个问题也随之而来:英伟达把一切掌握在自己手里来做协同优化,而作为一个AI Infra公司的无问芯穹,面对的则是各个独立的芯片和模型公司,它要如何带着大家“团结”起来?

“原因很明显,过度依赖单一硬件平台可能会使企业面临供应链风险,现在算力集群也有多种选择,绝大部分集群已经或正在从同构转向异构,这个事情现在是成立的。”夏立雪说。

“大模型现在在落地的关键阶段,它对于成本是有很强的诉求。所以我们其实是要联合模型、联合硬件,共同把模型成本打下去,让它的市场需求无限大。”

今天所有人有共同的目标,这是一个难得的共识,也是一个难得的机会。

这些变化也带来了新的打法上的可能。

在过往挑战英伟达的各种路线里,如何穿越CUDA的护城河是一个绕不开的话题。很多公司选择从CUDA的兼容入手。但夏立雪认为现在可以有新的身位。

“CUDA其实可以理解为一个硬件的说明书,当然最简单的方法是把所有人的说明书都汇总起来,甚至编写一个自己的说明书。但问题是,这样做,我面向的还是那些翻看说明书的人。”他说。“但其实每个人用手机的时候,根本就没有翻过手机说明书。”

“所以我们想做的是把所谓的CUDA做厚,厚到算法语言的这一层,这样的话它看上去统一了CUDA,但我其实不需要把说明书合并,我只需要把所有的手机的界面通过一个安卓系统,接到不同家的芯片,接到不同家的手机。”

从这个意义上,无问芯穹的全栈系统其实就是一个全新的操作系统,一个要把各家的“CUDA”都接入其上的安卓。

“而这件事的基础就是真的可以存在一个安卓。”他说。“是大模型使得这件事从不可能变成了可能。”

在大模型统一了底层框架带来规模化的可能之前,AI Infra公司没机会成为一个“高兼容的安卓”。现在无问芯穹认为,天时地利人和都齐了。

“今天能做成这件事,天时地利人和都有。当前我们来牵头可以得到认可。因为不是我们在追着别人干,而是大家都会认可我们的价值。”夏立雪说。

“清华电子系奠定了这样一个技术基础,我们和这些模型公司和这些硬件公司都有充分信任关系,所以更应该在这个时代站出来做这个事情。”

算力的运营商

任何因为新的技术机会而诞生的公司都会面对两个问题,一是当下的商业模式,二是未来行业稳定下来后它的定位。无问芯穹对这两个问题都想的挺明白。

在商业模式上,无问芯穹没有走ToB领域最常见的软件付费模式。这也是中国toB一直绕不开的一个坎。美国的每一个细分领域都可以基于软件付费生长出成功的ToB公司,但在中国市场似乎总是走不通。

无问芯穹找到了另一条路。夏立雪把它形容为“运营商”模式。

在夏立雪看来,无问芯穹是一个运营商的角色——它本质上在运营算力资源,软件平台是运营资源所需要的工具。

“我们看到了能够带着硬件,带着资源去售卖,而且客户是认可我们的价值的。”

而它的大客户就是模型厂商。

大模型在今天是个由算法在带着上下游走的行业。“它中间尖,像大雁飞行的阵容一样,由模型指导着下面需要什么样的集群和算力,上面需要什么样的应用,能做什么样的场景。”夏立雪说。

“那么,整个行业由算法驱动,算法其实是大模型公司在做。我们的大客户就是大模型公司们。我要跟着这个行业最先进的信息跑,我才能持续知道我上下游对应的资源要怎么配置,我对应的场景会在什么地方爆发,会有什么样的客户。我会顺着大客户带动小客户的方式,这样我们的决策风险和效率指向都是更可控的。”

2018年从清华博士毕业之后,夏立雪加入了阿里云。此前更多在对内提供技术服务的阿里云,在当时开始对外服务,并承担营收任务,夏立雪负责起阿里云的用户增长产品,从一个技术人的角色变为业务的负责人。

这段云计算的从业经历对他影响很深。

“我认为云厂商有一个非常成功的逻辑,就是他愿意付出成本去做一些大客户,但是这些客户对他来说是非常重要的,他所有技术产品的能力并不仅仅因为自己的开发很厉害,更重要的是他们会跟客户深度绑定之后,知道客户需要什么。”他说。“说白了就是这些产品其实是被大客户‘训’出来的。但拿着这些产品去服务中小客户就会建立优势和规模。我们现在也是这样。”

4个月前,无问芯穹Infini-AI大模型开发与服务云平台宣布首次公测,至今已有智谱AI、月之暗面、生数科技等大模型公司客户,另有20余家AI Native应用创业公司在使用无问芯穹提供的工具链开发自身业务模型。

在和芯片厂商的关系上,无问芯穹更像是一种生态伙伴的关系。大家都在抢英伟达的市场,需要一个这样的角色帮助大家快速扩张。无问芯穹也在一个一个的和这些芯片厂商建立深度的合作。2024年1月,它与AMD达成战略合作,5月与摩尔线程合作完成基于国产GPU千卡集群的3B模型实训,这次发布大模型异构千卡混训平台,在技术面也得到了AMD、华为昇腾、天数智芯、沐曦、摩尔线程等异构芯片的支持。

不过,夏立雪认为未来不管是算力不足还是大模型的落地问题,一定都会逐渐被解决。到那时候无问芯穹的模式不一定是现在这样一个“团结”大家的角色,而是在一个稳定的链条里找到它自己的固定的位置。

“在那个时候,其实我们就不是再去做纯MxN的事。而是像一个云厂商一样,形成规范的上下游合作。我们在其中会成为必要的一环。”

文章来源于“硅星人Pro”,作者“ 王兆洋”