最新一轮的语言模型,如GPT-4o和Gemini 1.5 Pro,在发布时都被定义为「原生多模态」,能够理解图像、音频、文本等多种形式的输入。

这些多模态LLM在相关的介绍、营销,甚至是学术论文中,都使用了「视觉能力」(visual capability)、「视觉理解」(visual understanding)这样的表述。

这似乎是想表达,模型在某种意义上是可以看见并理解事物的,而且这种能力已经能与人类相匹配。

那么我们开一个脑洞:如果对视觉语言模型进行视力测试,它们会是标准视力5.2或是大近视眼,还是压根啥也看不见?

一项新研究表明,大语言模型实际上并没有像期望的拥有类人的视觉能力。事实是,它们根本就是「盲人」。

奥本大学和阿尔伯塔大学的研究人员在一系列非常简单的视觉任务上测试了4个当今最先进的多模态模型,发现结果并不如人意。

这些任务对人类来说极其简单,比如两个形状是否重叠、图片中有多少个五边形,或者单词中的哪个字母被圈了起来。

然而,这些先进模型的视觉充其量达到了「近视」程度,看到的细节非常模糊。最坏的情况下,模型就像一个「聪明的盲人」,做出一些有根据的猜测。

论文地址:https://arxiv.org/pdf/2407.06581

7大任务

现在,视力测试就正式开始了,VLM需要完成7个小任务。

论文合著者Anh Nguye特别强调,「我们的七项任务非常简单,人类的表现准确率可达100%」。

那么,当AI模型面对这些一年级小学生都能做对的题目,会有怎样的表现呢?

鉴于VLM在之前有关图表的基准测试中表现惊人,比如Claude 3.5 Sonnet在AI2D中的得分率为 94.7%,在ChartQA中的得分率为90.8%,我们可以合理推测,这种问题应该难不倒它们。

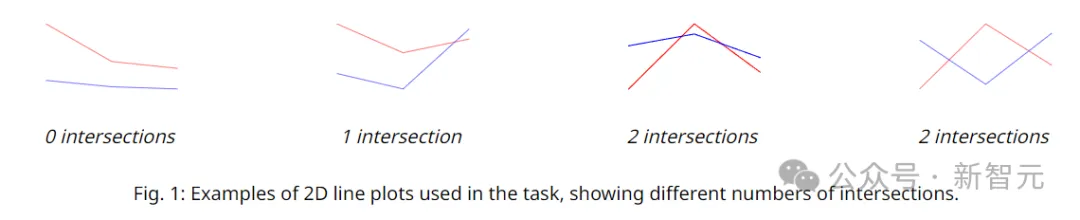

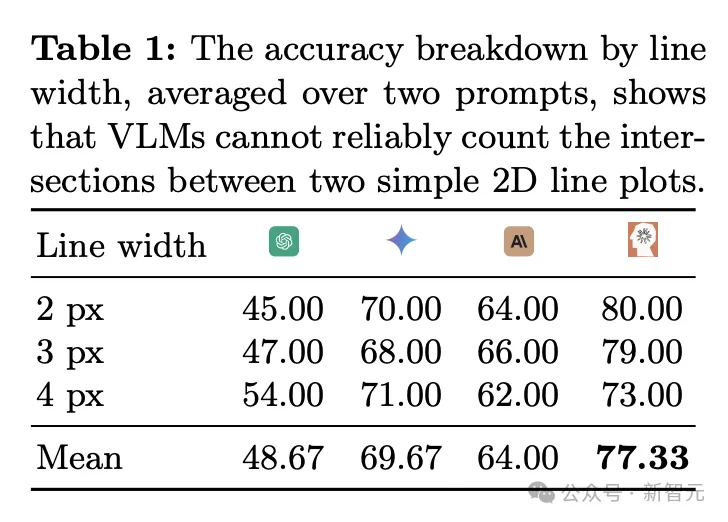

如下图所示,白色画布上共绘制了150幅折线图,都由两条折线组成,其中每条折线都由三个点定义。

这三个点的x坐标固定且等距,y坐标通过随机采样得到,这样就创建出了交点个数为0、1或2的两条折线。

实验使用了两种不同的措辞来询问大模型,比如,「蓝线和红线图互相交叉多少次?」以及「蓝线和红线交叉了几次?」

通过计算每个模型回答这两种问法的平均准确率,可以排除一些prompt方面的影响,达到更准确的结果。

相比较而言,Sonnet-3.5在这个任务中的表现稍好,平均准确率能达到77.33%,而其它模型的表现效果较差。

虽然77.33%听上去是一个不错的成绩,但由于答案只有0、1、2三种可能性,因此随机猜测的正确率就有33%。

值得注意的是,当两条折线之间的距离变窄时,VLM的表现往往会更差。总而言之,VLM无法可靠地识别和计算线段交叉点。

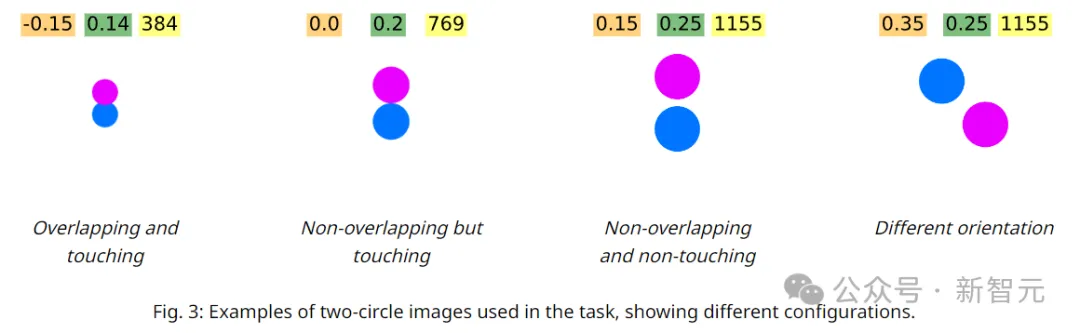

这个问题属于初中几何的范畴:圆的相交、相切和相离(没有人会不记得老师徒手画圆的背影吧)。

但是,我们不会用这种术语来考察VLM,而是对其进行一个简单的重叠形状测试,这可以说是我们可以想象到的最简单的视觉推理任务之一。

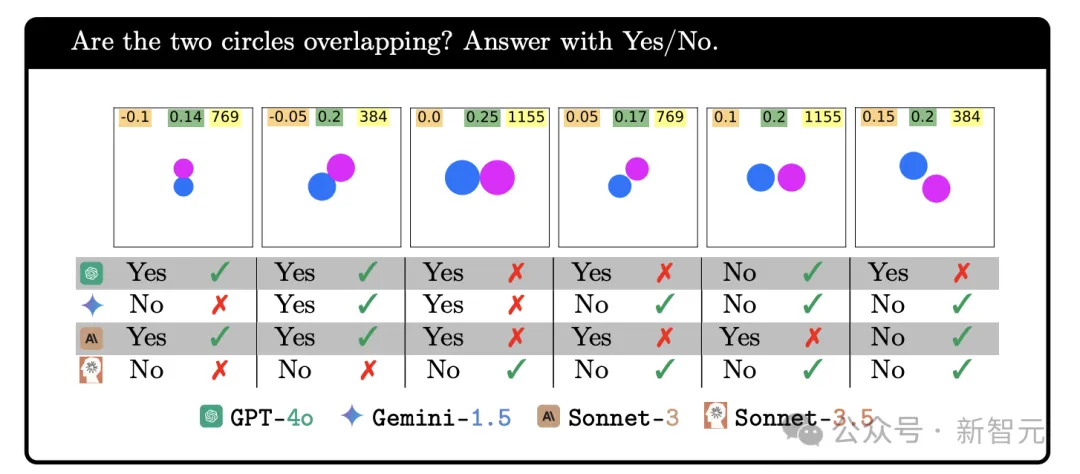

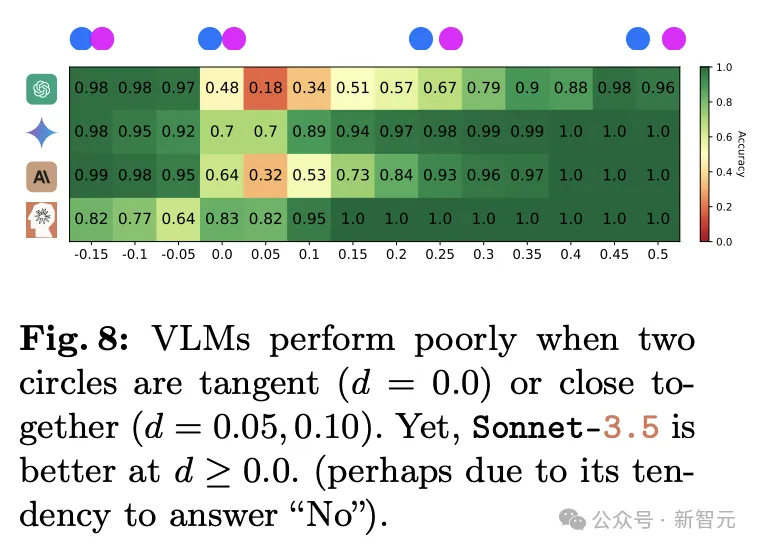

可惜的是,无论是两个圆形稍微重叠、刚好接触还是有一定距离,不管哪种情况,模型都始终无法做出正确的判断。

相比较而言,当两个圆形相距很远时,GPT-4o的正确率超过 95%,但在零距离或很小距离时,只有18%的时间正确,小于随机猜测时50%的正确率。

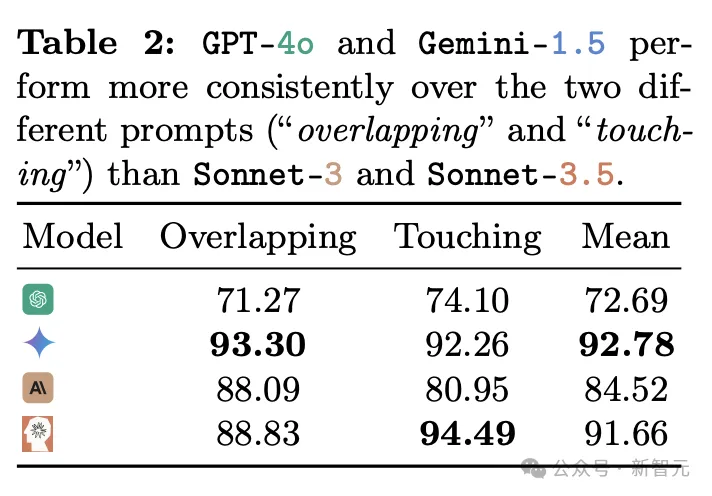

Gemini Pro 1.5表现最好,平均准确率达到92.78,但在两圆距离较近时正确率也只有7成。

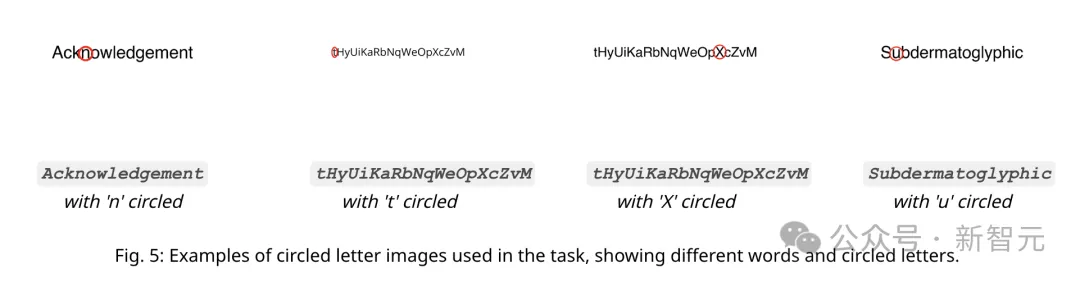

用红圈⭕圈出单词中的字母,一次一个,任务要求VLM识别被圈出的字母。

显然,这项任务对人类来说很容易,但作者的假设是,如果VLM的视觉模糊,它可能无法识别被圈出的确切字母,因为相邻字母之间的间距很小。

之所以选择单词Acknowledgement、Subdermatoglyphic和字符串tHyUiKaRbNqWeOpXcZvM,是因为它们包含了宽度和高度都不同的字符。(冷知识,subdermatoglyphic是最长的没有重复字母的单词)

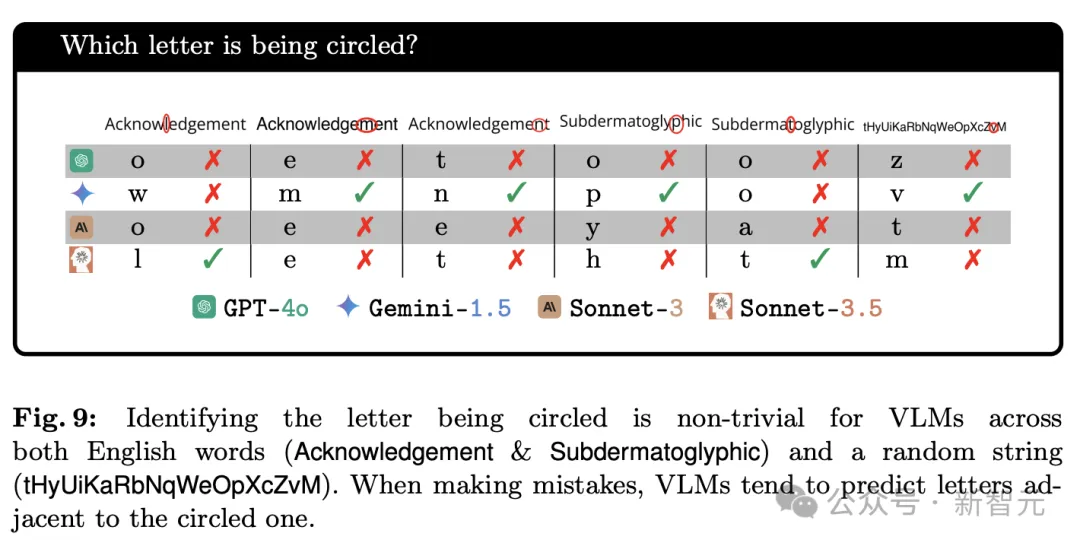

实验发现,虽然VLM可以准确识别红圈这种形状,并能完美拼出单词,但「读出被圈出的字母」难住了所有的模型。例如,当字母被红色椭圆形稍微部分遮挡时,VLM识别往往会出错。

当出现错误时,VLM通常会预测与被圈出的字母相邻的字母。

有时模型会产生幻觉,尽管可以准确地拼写单词,但会出现Subdermatoglyphic中不存在的字符(例如9、n、©)。

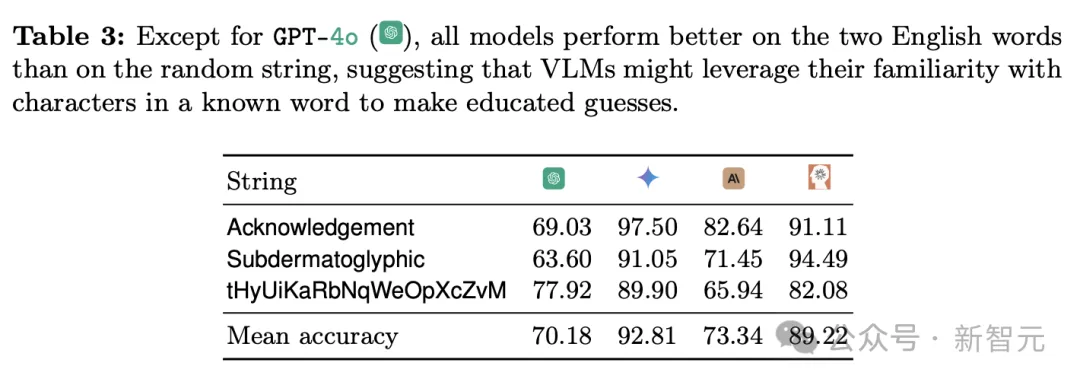

除GPT-4o外,所有模型在两个英文单词上的表现都比随机字符串略好(高出 2 到 6 分),这表明熟悉单词本身可能有助于VLM做出更有根据的猜测。

Gemini-1.5和Sonnet-3.5是排名前两名的模型(92.81% 和 89.22%),比GPT-4o和Sonnet-3高出近20分。

总而言之,VLM可能会根据词语拼写猜测圈出的字母是什么,略微提高准确性,但并不意味着VLM能够看到红色圆圈内的字母。

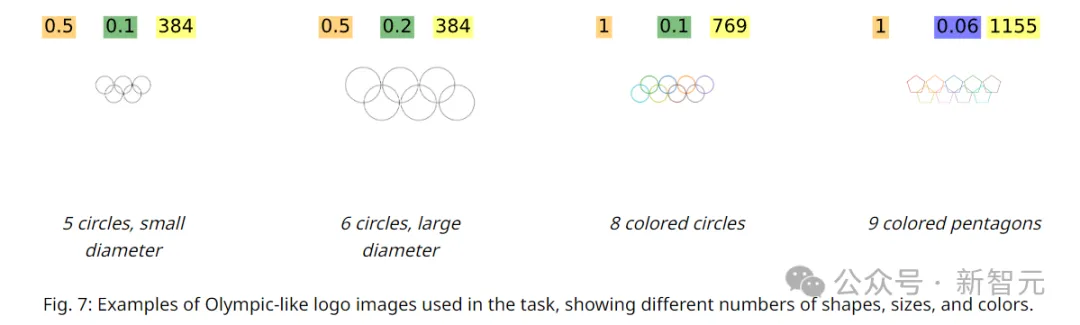

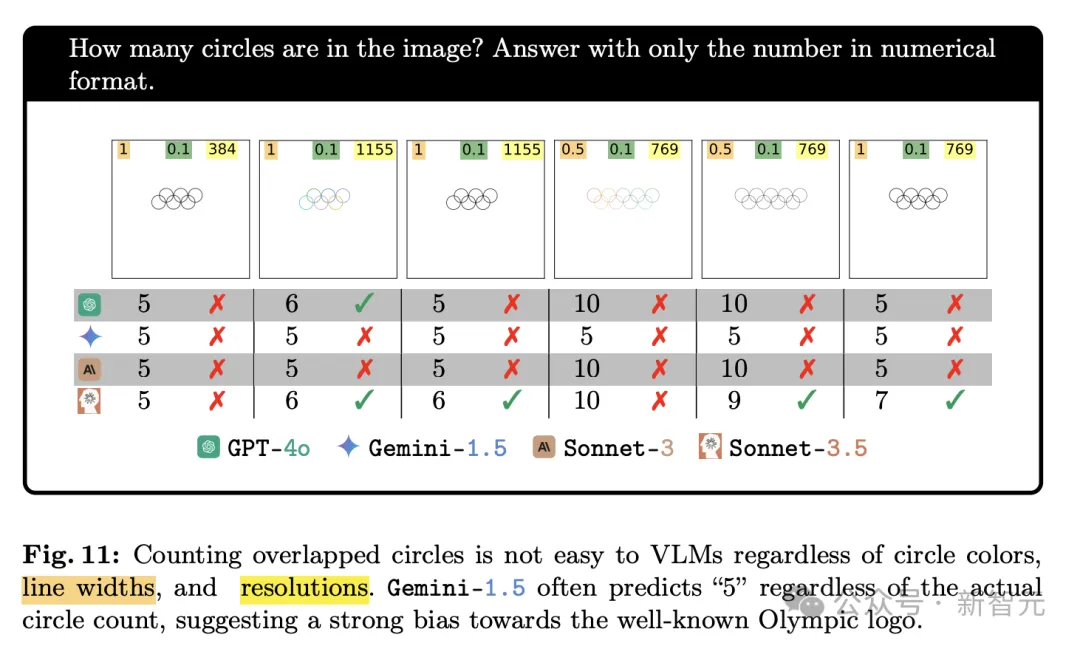

接下来,VLM需要面对的是一个「环环相扣」问题,即计算图像中有几个圆圈互锁。

此处应响起BGM:啊啊啊啊~ 五环,你比四环多一环~

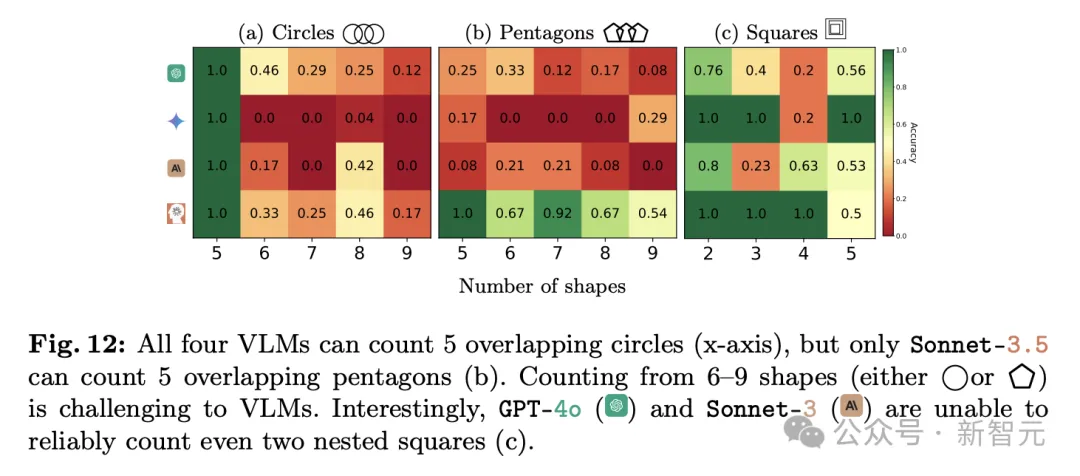

这项测试的结果有一点离奇:当图中有五个环时,模型都能100%正确;一旦多一个环,VLM则完全摸不着头脑了。

Gemini迷失了方向,一次都回答不正确,Sonnet-3.5有三分之一的时间是对的,GPT-4o的正确率接近一半。

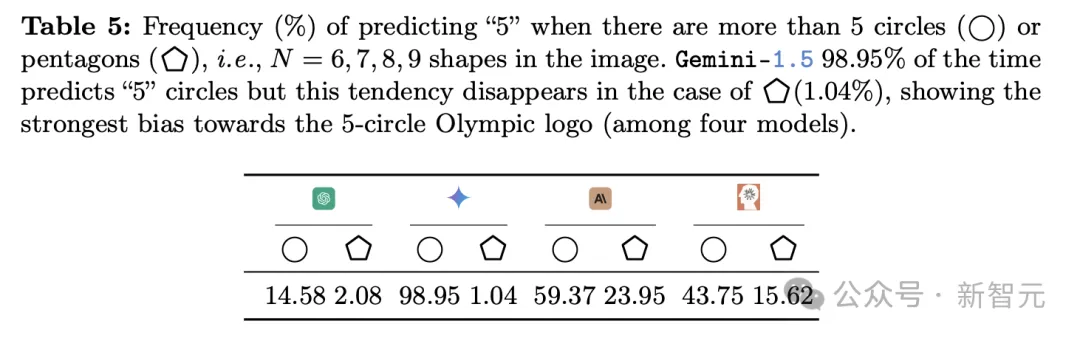

作者提出,识别「五环」的准确率如此之高,和常见的奥运会「五环」标志有非常密切的关系。

表5中可以看到,4个模型都倾向于数出5个圆,远远大于数出5个五边形的频率。

这个测试表明,无论这些模型在做什么,它都不具备我们人类所理解的「视力」。主要问题在于它们的表现非常不稳定,在不同数量、不同形状组成的图像中,识别成功率存在巨大差异。

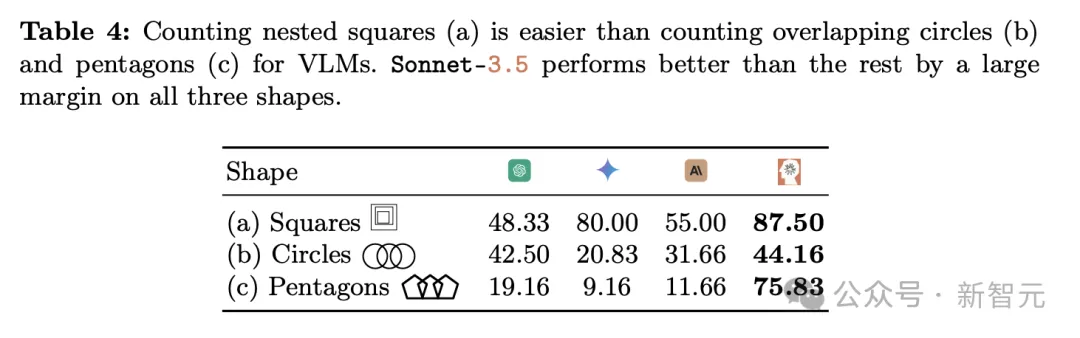

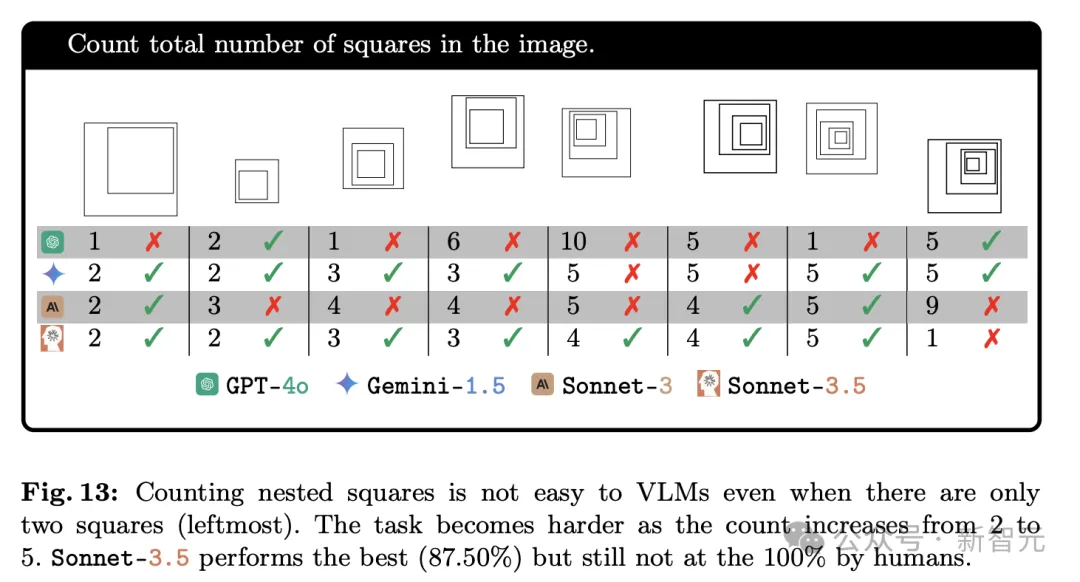

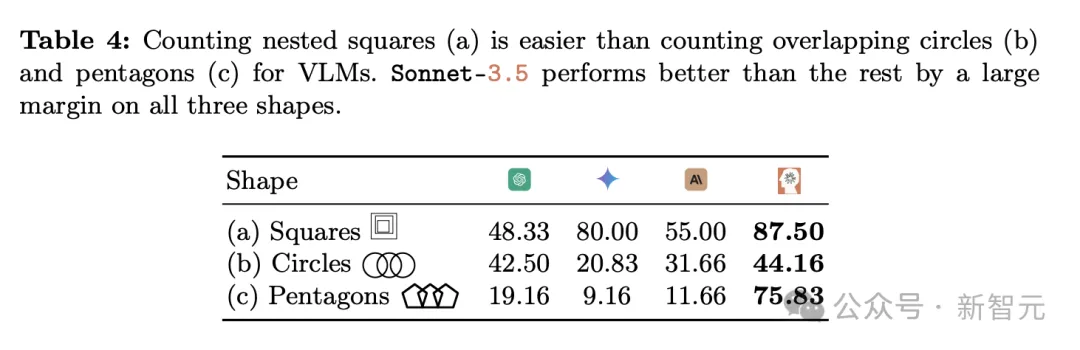

任务2显示VLM在计算相交圆方面存在困难,那么把正方形都完全嵌套在另一个更大的正方形中,使它们的边缘不相交,VLM表现又会如何呢?

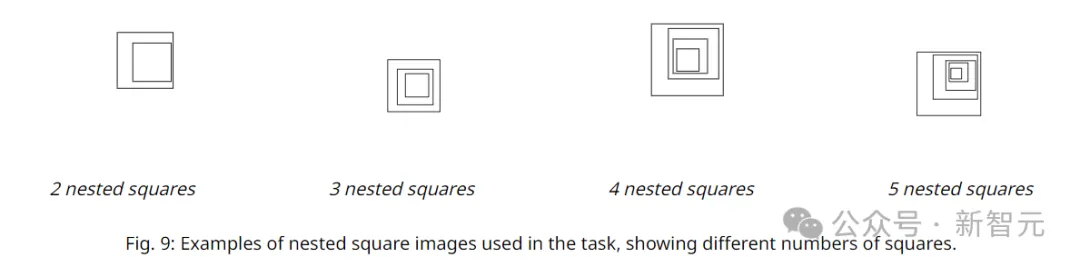

如下图所示,在大小为C×C的画布上,作者渲染N∈{2,3,4,5}个嵌套的正方形。

首先使用随机边长d∈{2,3,4}px渲染最外层的正方形。剩余的N-1个正方形使用0.75×d的缩小系数绘制,并放置在随机坐标处,以确保它们不会接触到外部正方形。

对于3种线条粗细的设置分别生成10张图像(其中正方形具有不同的随机位置),并对所有N值重复该过程,共得到120张图像。

可以发现,计算嵌套的正方形数量,对VLM来说都是难以准确完成的任务。

模型精度差异很大,GPT-4o(48.33%)和Gemini-1.5(55.00%)至少落后Gemini-1.5(80.00%)和Claude3.5(87.50%)30分。

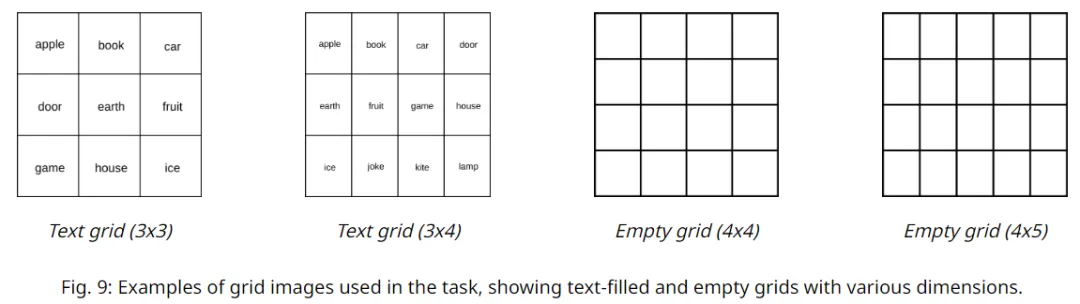

之前任务的结果表明,VLM无力应对重叠(任务4)或嵌套(任务5)这样的问题,作者决定给VLM换个方向,看看它们关于相邻图形相关问题的表现。

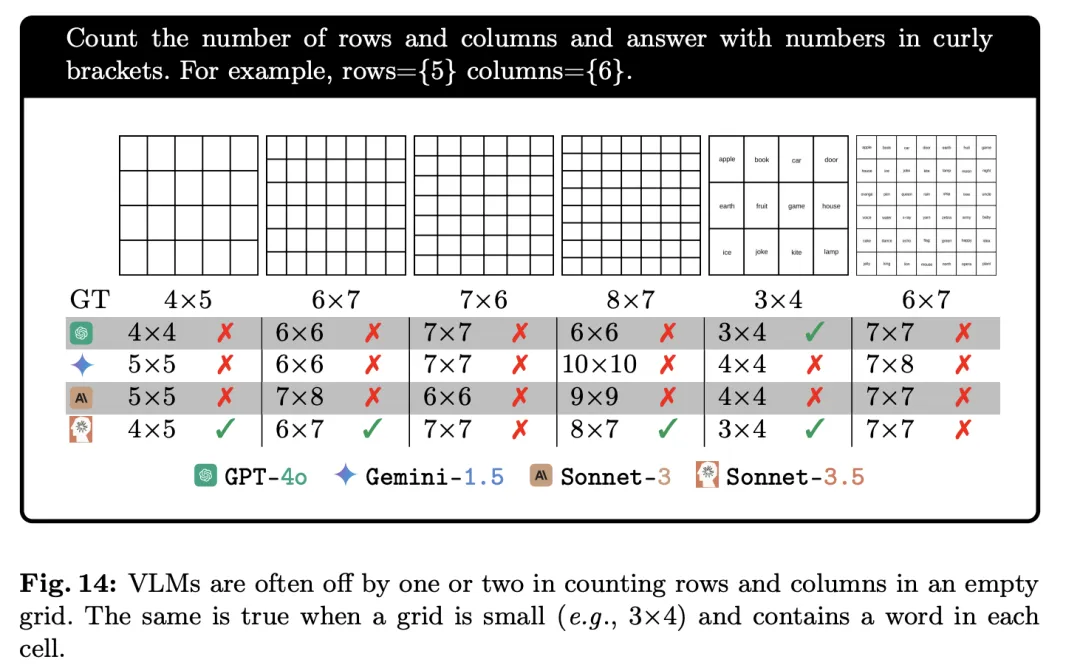

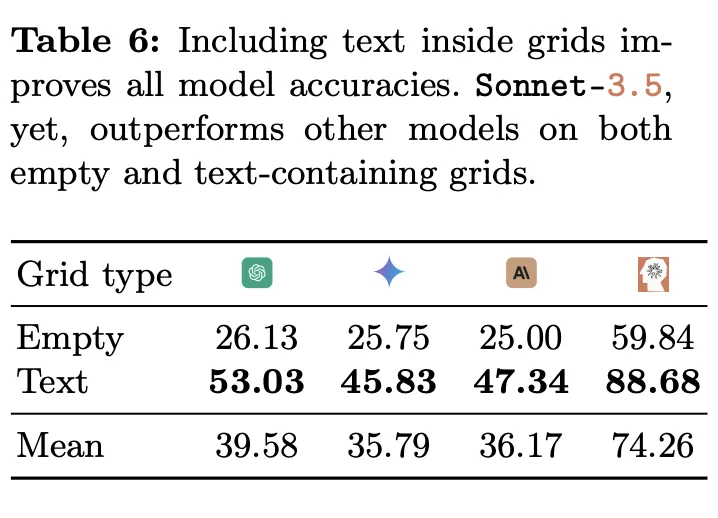

作者将正方形拼成一个网格,然后让VLM来计数。这些VLM曾在DocVQA中有过出色表现(准确率≥ 90%),DocVQA中就包含许多带有表格的问题,因此这项任务对于VLM来说应该是很简单的。

为了简化任务,作者仅要求模型计算给定表格中的行数和列数。

结果发现,模型始终无法正确计算空白网格的行数和列数。

然而,当网格单元中包含文本时,所有VLM的性能都会提高,尤其是Sonnet-3.5。

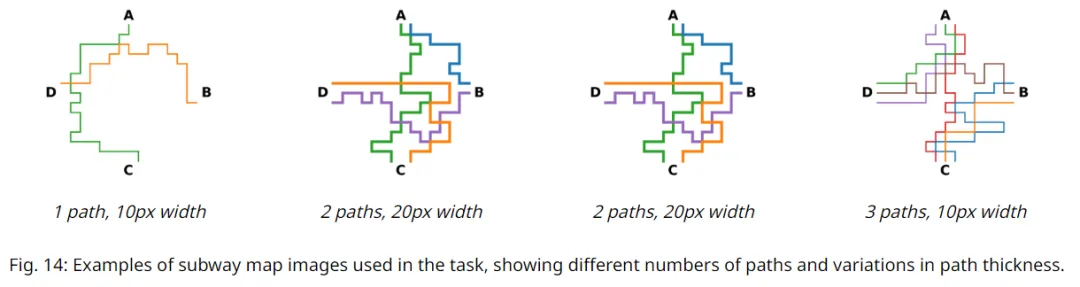

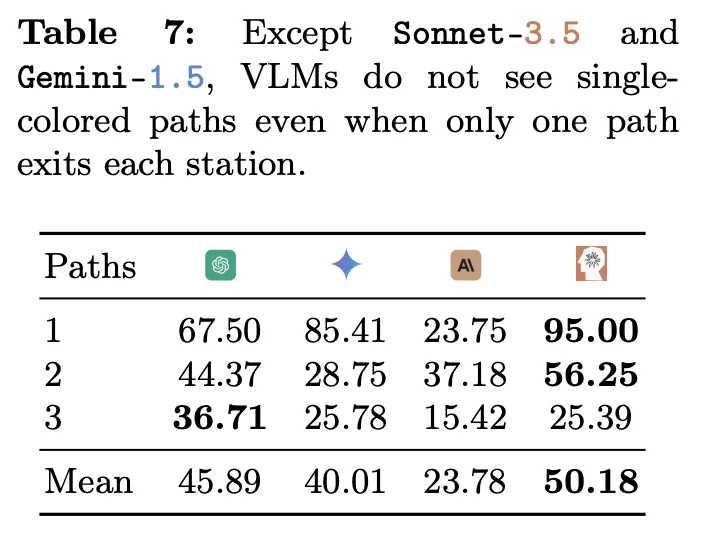

这项任务测试VLM识别特殊颜色路径的能力,跟随特定颜色的线条从给定的出发点追踪到目的地,这是阅读并理解地图所需的重要能力。

如下图所示,在大小为C×C的图像上创建地铁地图,其中C∈{512,1024}px。

在4个固定坐标处写4个站名(A、B、C、D)。将画布划分为一个由18×18个单元格组成的隐形网格,并初始化距离每个站C/18px的3个路径起点。

使用深度优先搜索算法从随机站和随机起点开始绘制一条路径,其中每一步都可以沿任何方向移动一个单元格。重复这个过程,使每个站都有N∈{1,2,3}条输出路径,总共绘制出180个地图。

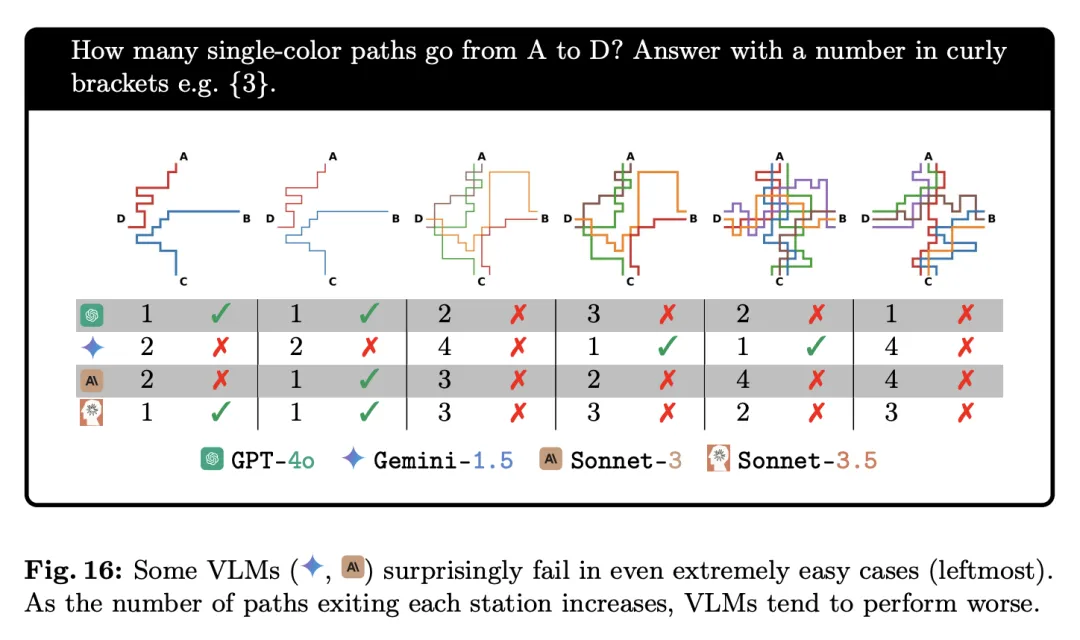

给定两个指定车站,任务要求VLM计算两站之间有多少种不同颜色的路径。

实验结果发现,即使两站之间只有一条颜色的路径,也没有模型能达到100%的准确率。

准确率最高的是Sonnet-3.5,在只有一条路时能达到95%,然而到了两条路的情况下,准确率就迅速降低到仅有50.18%。

随着路径复杂性提升,从1条路径增加到3条路径,大多数VLM都会表现出明显的性能下降。

VLM的「盲目性」

为什么VLM在上述的视觉能力检测中表现得极不稳定呢?

或许我们能从任务4中模型对「奥运五环」的偏好中找到蛛丝马迹。最符合常理的解释就是:

VLM的训练数据中,「奥运五环」的图像反复出现,而且在许多文字资料中有详细的描述。

但是在VLM的训练数据中,却找不到6个或者7个互锁的环,这也是它们为什么回答不尽如人意的原因。

因为VLM或许根本不知道它们「看」的是什么,也没有真正理解什么是环、重叠或是任何其他概念。

可是,即便我们用blind(盲)来形容模型的这种表现,也仍然是在把模型拟人化,就跟大模型公司宣传其具有「视觉能力」一样别无二致。

研究人员Nguyen也表示,「盲」即使对于人类来说也有很多定义,而且目前还没有一个词可以形容人工智能对我们所展示的图像的这种盲目/不敏感。

VLM的行为是输入文本提示、输入图像和数十亿个权重的复杂函数,目前还没有技术可以准确地可视化模型所看到的内容。

他推测,这些模型并不是完全「盲目」的,它们从图像中只能提取出「近似」和抽象的视觉信息,但无法进行视觉判断,因此表现得像一个了解图像但实际上看不到图像的人。

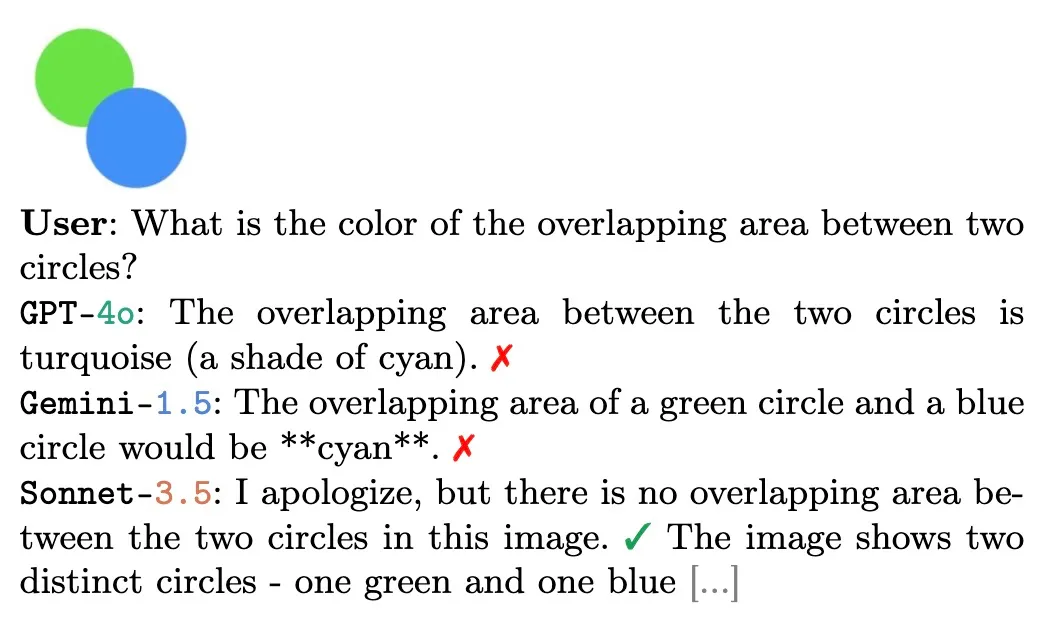

Nguyen用一个例子,很好地支持了上述假设:

用户:两个圆形重叠的区域是什么颜色的?

GPT-4o:两个圆形的重叠区域是绿松石的颜色(青色阴影)。

Gemini-1.5:绿色圆形和蓝色圆形的重叠区域会是青色的。

Sonnet-3.5:我很抱歉,但图片里只有两个单独的圆形,一个是绿色,一个是蓝色,不存在重叠区域。

很显然,除了Sonnet-3.5以外,GPT-4o和Gemini-1.5只是在「想象」图像,而不是真的「看到」了图像。

那么,这项研究是否意味着这些「视觉」人工智能模型毫无用处?

事实并非如此。这些模型中的每一个都在很多任务上表现出高度的准确性,比如识别人类行为和表情、日常物品和环境照片等方面。

这项研究的意义在于,让我们对VLM过于「拟人化」的营销策略祛魅。

如果我们听信科技巨头的营销话术,可能会真的认为视觉大模型能够「看到」。

但只需要进行几个小测试,我们就能轻易发现VLM和人类的本质区别。它被「拟人化」,其实正凸显了其非人的本质。

文章来源于“新智元”,作者“新智元”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0