视觉推理模型Top1易主了,智谱GLM-4.6V开源

视觉推理模型Top1易主了,智谱GLM-4.6V开源这一次,AI真的是快要砸掉我的饭碗了。智谱最新升级的新一代视觉推理模型——GLM-4.6V。在深度体验一波之后,我们发现写图文并茂的公众号推文,还只是GLM-4.6V能力的一隅。

这一次,AI真的是快要砸掉我的饭碗了。智谱最新升级的新一代视觉推理模型——GLM-4.6V。在深度体验一波之后,我们发现写图文并茂的公众号推文,还只是GLM-4.6V能力的一隅。

REG 是一种简单而有效的方法,仅通过引入一个 class token 便能大幅加速生成模型的训练收敛。其将基础视觉模型(如 DINOv2)的 class token 与 latent 在空间维度拼接后共同加噪训练,从而显著提升 Diffusion 的收敛速度与性能上限。在 ImageNet 256×256 上,

Black Forest Labs的开源视觉模型FLUX.2上新,这是一款专为现实创意工作流程打造,绝非演示噱头的生产力工具,与前代FLUX.1相比,实现了从「会画」到「懂你要画什么」的跃升。

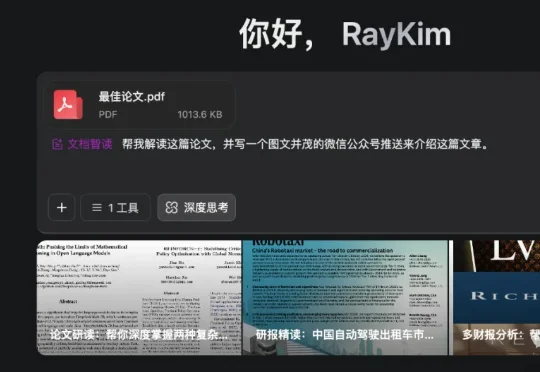

Meta开源DepthLM,首证视觉语言模型无需改架构即可媲美纯视觉模型的3D理解能力。通过视觉提示、稀疏标注等创新策略,DepthLM精准完成像素级深度估计等任务,解锁VLM多任务处理潜力,为自动驾驶、机器人等领域带来巨大前景。

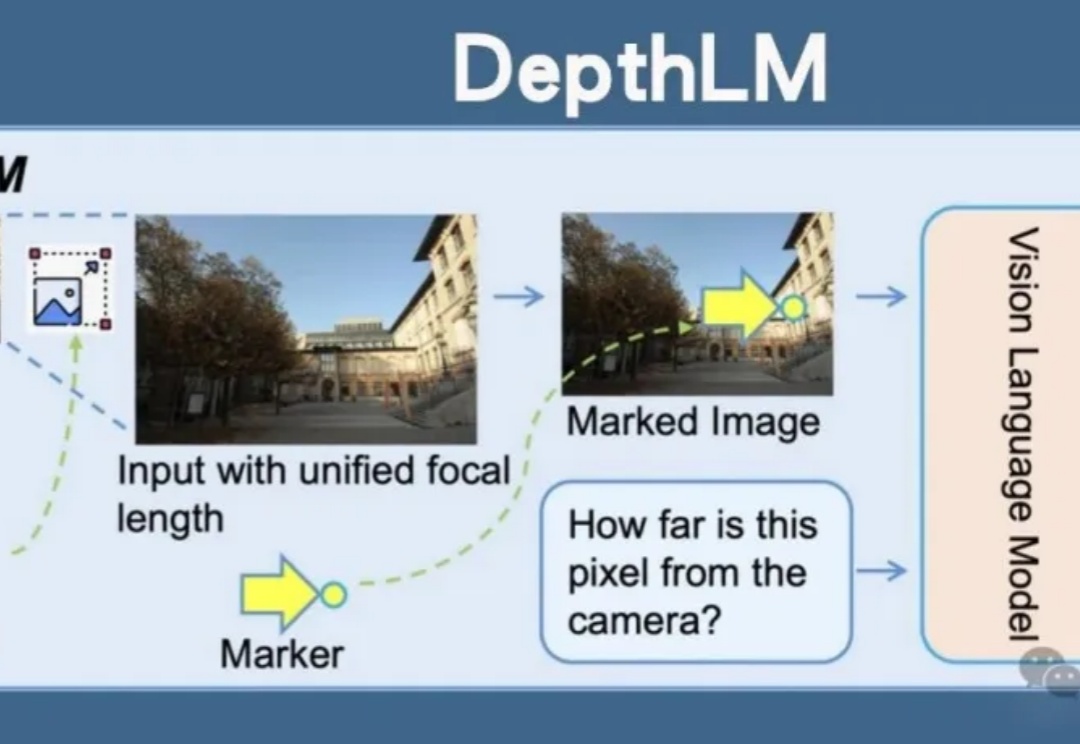

智东西10月15日报道,今日,阿里通义千问团队推出其最强视觉语言模型系列Qwen3-VL的4B与8B版本,两个尺寸均提供Instruct与Thinking版本,在几十项权威基准测评中超越Gemini 2.5 Flash Lite、GPT-5 Nano等同级别顶尖模型。

github排名第一,视觉模型与自动化 这两年,RPA+AI(智能自动化流程)经常被提及,在企业/机构数字化转型过程中,自动化和智能化是提升效能的重要方式,而迈向自动化和智能化的第一步则是机器人流程自动化(RPA)。

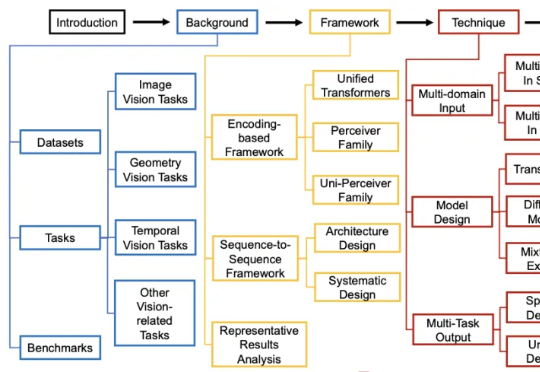

过去几年,通用视觉模型(Vision Generalist Model,简称 VGM)曾是计算机视觉领域的研究热点。

今天,Gemini 家族迎来了一个新成员:Gemini Robotics On-Device。这是谷歌 DeepMind 首个可以直接部署在机器人上的视觉-语言-动作(VLA)模型,可以帮助机器人更快、更高效地适应新任务和环境,同时无需持续的互联网连接。

最近也是好起来了,上周四去杭州参加了字节火山的线下meetup开发者大会。在会议现场亲自体验了他们这次新发布的大模型和产品,整个过程还挺有意思的。视觉模型Doubao-1.5-vision-pro也非常nice

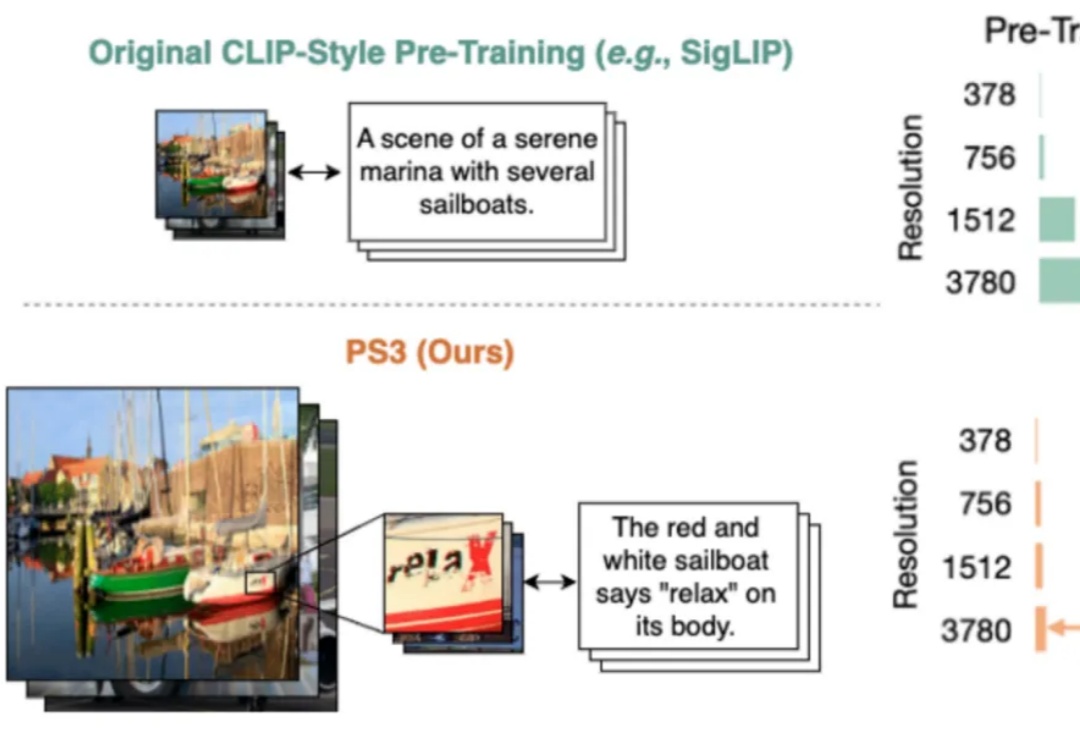

当前,所有主流的视觉基础模型(如 SigLIP、DINOv2 等)都仍然在低分辨率(如 384 * 384 分辨率)下进行预训练。对比人类视觉系统可以轻松达到 10K 等效分辨率,这种低分辨率预训练极大地限制了视觉模型对于高清细节的理解能力。