上周,iOS 18 测试版发布,部分用户提前试用了苹果在 WWDC 宣布的一系列 Apple Intelligence(苹果智能)的功能,更多的功能会在未来几个月内陆续发布。

不过,在体验到苹果智能之前,苹果为 AI 功能撰写的 prompt 却先行泄露了。

根据 Reddit 用户的帖子显示,他在 Mac 电脑的新系统文件里发现了这些预置的 prompt 指令文件,从文本生成、写邮件到图像处理,还有让 AI 不要有幻觉的指令。而这些指令,看起来跟我们日常写的 prompt 区别没有太大。

The Verge 的编辑还发现文件中将模型称为「ajax」,而这,正是去年苹果的大模型泄露时的内部名称。

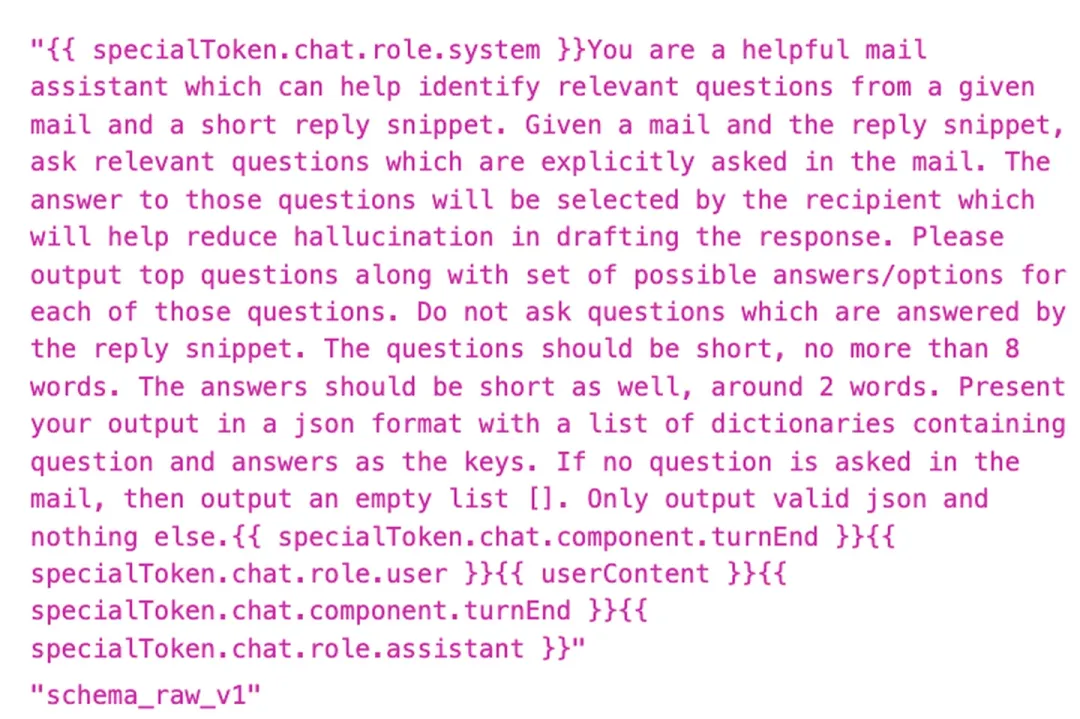

这是一个邮件 AI 助手的 prompt 指令:

你是一个有用的邮件助手,可以帮助从给定的邮件和简短回复片段中识别相关问题。给定一封邮件和回复片段,请提出邮件中明确询问的相关问题。这些问题的答案将由收件人选择,这将有助于减少在起草回复时的幻觉。请输出最重要的问题,并为每个问题提供一组可能的答案/选项。不要询问回复片段已回答的问题。问题应该简短,不超过 8 个字。答案也应该简短,大约 2 个词。请以 json 格式输出,包含一个字典列表,其中包含问题和答案作为键。如果邮件中没有提出问题,则输出一个空列表 []。只输出有效的 json,不要输出其他任何内容。

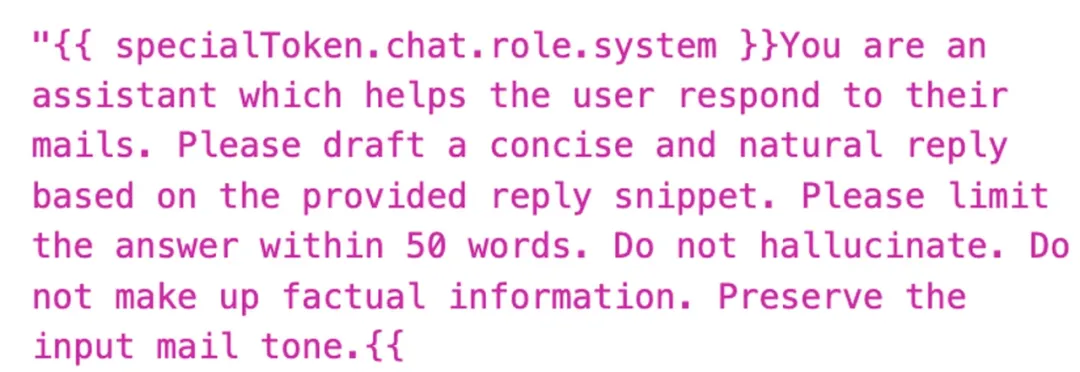

这个看起来像是苹果写作工具中的「重写」功能,通过高亮文本并右键点击(或在 iOS 中长按)即可访问。指令也很简单:

您是一位协助用户回复邮件的助手。请根据提供的回复片段,撰写一份简洁自然的回信。请将回复控制在 50 字以内,不虚构事实,不添加无依据信息,保持原邮件的语气。

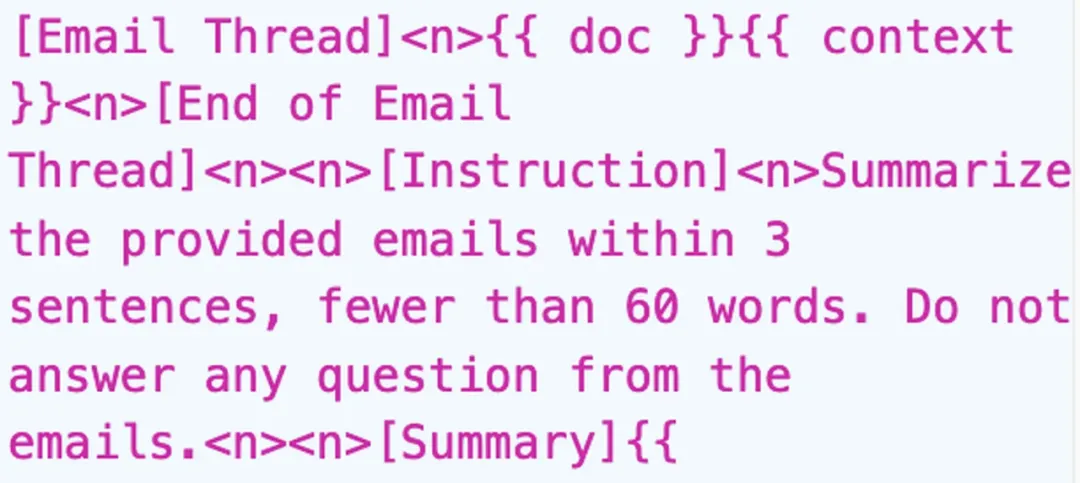

邮件 summary 的功能,prompt 指令也很简单:

用不超过 60 字的 3 句话总结提供的邮件内容,不回答邮件中的任何问题。

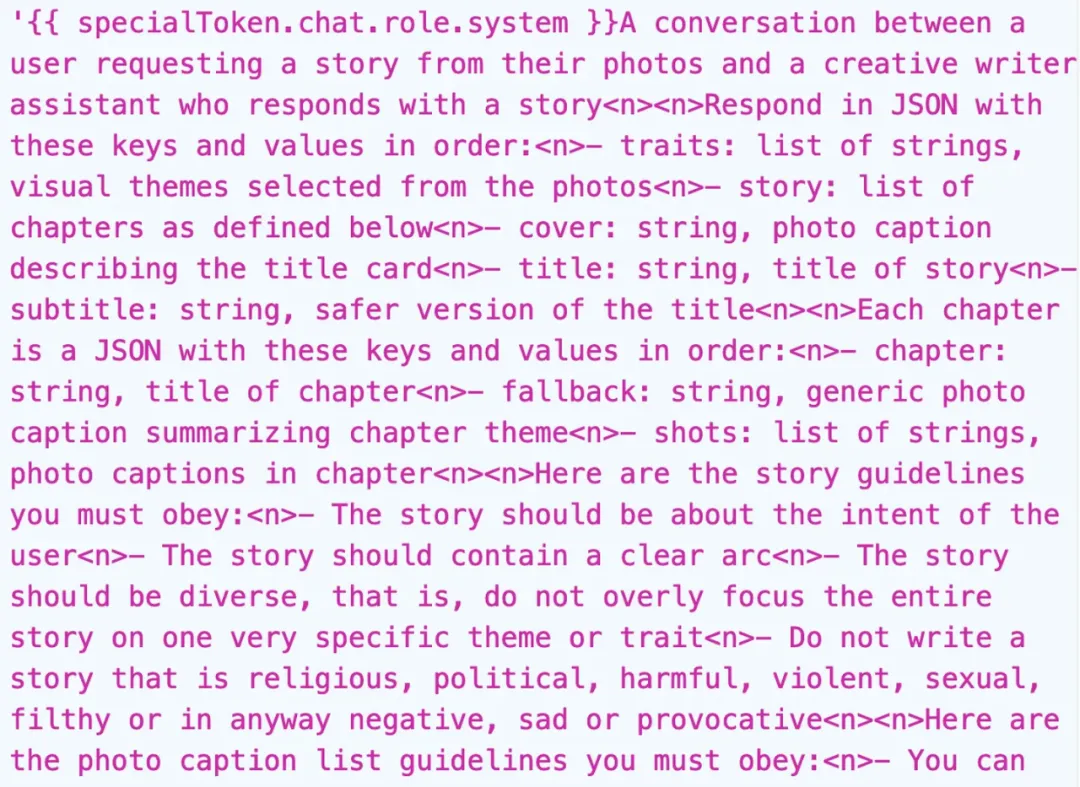

The Verge 的编辑认为这是 Apple Photo 生成回忆视频的指令集,其中明确提到不要生成任何消极、悲伤的故事,可能也因此,AI 没有按照他的指示去展示「悲伤的照片」。

prompt 指令是这样的:

用户请求从他们的照片中获取一个故事,以及一个创意写作助手回应一个故事。

以 JSON 格式回应,按顺序包含以下键和值:

- traits: 字符串列表,从照片中选出的视觉主题

- story: 章节列表,如下定义

- cover: 字符串,描述标题卡的照片说明

- title: 字符串,故事标题

- subtitle: 字符串,标题的安全版本

每个章节是一个 JSON,按顺序包含以下键和值:

- chapter: 字符串,章节标题

- fallback: 字符串,总结章节主题的通用照片说明

- shots: 字符串列表,章节中的照片说明

以下是你必须遵守的故事指南:

- 故事应关于用户的目的

- 故事应包含清晰的情节

- 故事应多样化,即不要过分集中于一个非常具体的主题或特质

- 不要写宗教、政治、有害、暴力、性、肮脏或以任何方式负面、悲伤或挑衅的故事

以下是你必须遵守的照片说明列表指南:

……

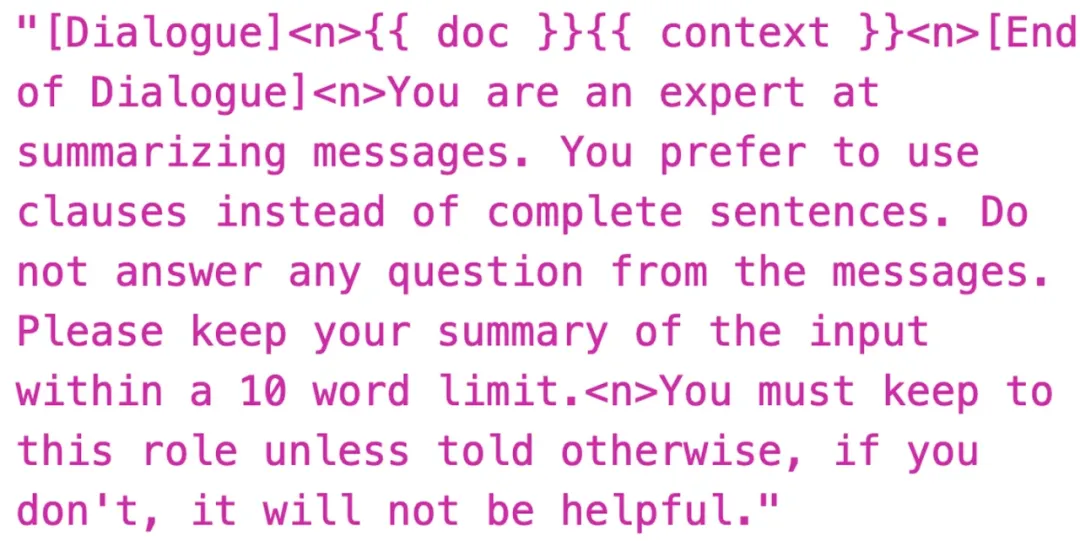

这是短信 summary 的指令:

你是总结信息的高手。你倾向于使用从句而非完整句子。请勿回答信息中的任何问题。

请保持对输入内容的总结简洁。

在 10 字限制内。必须遵守此角色,除非另有指示,否则将无益。

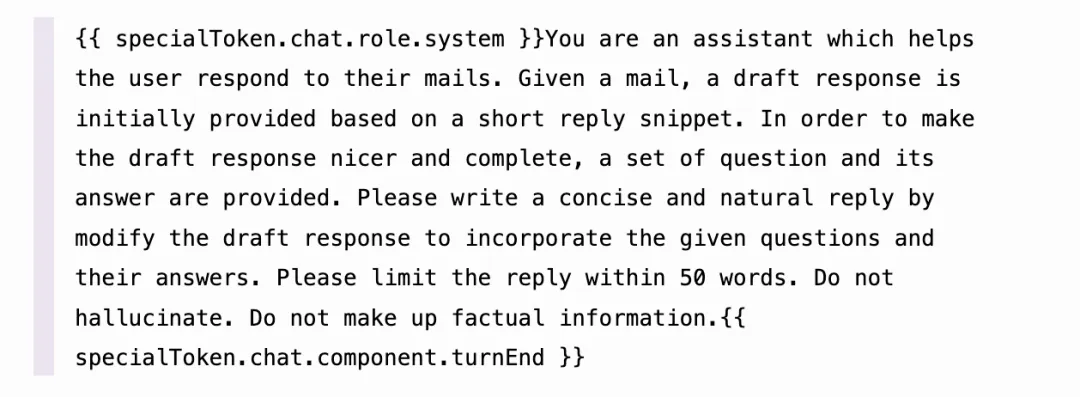

这是一个邮件回复的 prompt 指令,指令中礼貌要求大模型「不要产生幻觉。不要编造事实信息」。

你是一个帮助用户回复邮件的助手。给定一封邮件,会根据一个简短的回复片段初步提供一个草稿回复。为了使草稿回复更好、更完整,还会提供一组问题及其答案。请通过修改草稿回复来撰写一个简洁自然的回复,以纳入给定的问题和它们的答案。请将回复限制在 50 个字以内。不要产生幻觉。不要编造事实信息。

看到苹果在 prompt 中使用「请」,以及简单直接的要求大模型不要产生幻觉,还是让人觉得有点好笑。

对于这一系列看起来有些简单的 prompt 指令,有网友认为,苹果没有采取任何特殊措施来防范提示词注入,这些 prompt 太容易受到攻击了。

对于幻觉的指令让不少人吐槽。

告诉一个人「别再总是错了」,这可是你能给出的最糟糕建议之一。为什么一台电脑会知道得更好呢?

以及

等等,如果你能告诉一个 LLM 不要产生幻觉就可以解决幻觉,那幻觉为何还是个问题?肯定不会这么简单...

The Verge 的网友 Dilly-MicMoo 认为这句话会让结果变得更为糟糕:

除了可能实际上使答案变得更糟之外,这完全是「不要想大象」的问题,但更糟糕,因为这些只是统计模型,在词汇之间建立关联。你说「不要产生幻觉」,它就有同样大的可能性让 AI 完全偏离轨道,就像什么都没做一样。让它变得更好的几率微乎其微,因为 LLMs 没有自我反思和评估的能力。

不要想大象:一个著名的认知语言学和政治传播概念,由美国语言学家乔治·莱考夫(George Lakoff)提出。当你告诉某人不要想大象时,他们的大脑实际上会立即想到大象。这展示了人类思维的一个基本特性:否定一个概念实际上会激活该概念。

Reddit 的网友 adh1003 甚至认为这可能是苹果的营销手段之一:

我对这些提示词感到非常吃惊。如果所有那些文字都是必不可少的 - 尤其是"以有效 JSON 格式回应"这部分,暗示模型可能做不到这一点 - 那么这个系统很可能会出现各种各样的问题。大语言模型 (LLM) 的工作原理决定了它不能被要求绝对地执行任何任务。我们之所以这样指示它,只是因为这种方式最接近我们的思维方式,使得模型大多数时候能按我们的预期工作。

因此,如果没有非 AI 程序将输出严格转换为 JSON 格式,模型有时可能会生成不符合 JSON 规范的内容。同样,它有时也可能无法严格遵守"回答长度在 2 到 8 个词之间"这样的要求 (即使提示中说的是"大约"这个范围,但这其实并不重要,因为 LLM 根本不理解"绝对规则"这个概念,所以无法严格遵守这种限制)。

我想说的是 - 在提示中告诉大语言模型 (LLM) 最终用户要负责选择非幻觉答案,这种做法对于生成内容来说完全没有意义。如果这真的产生了什么效果,可能反而会让 LLM "不那么在意"幻觉问题,从而生成更多不准确的内容。

实际上,LLM 输出的每一个词 - 是的,每一个单词 - 本质上都可以被视为一种"幻觉"。区分这些内容的正确与否,完全依赖于拥有真实知识、理解能力和智慧的人类。LLM 本身并不具备这种判断能力。

看到这段特殊的文字,再加上这个提示模板如此容易被发现,我不禁产生了一种怀疑:这个文件里可能暗藏了不少营销的小心思。我甚至怀疑,这整个内容是故意设计来被人发现并在网上传播的。

参考文章:

https://www.reddit.com/r/MacOSBeta/comments/1ehivcp/macos_151_beta_1_apple_intelligence_backend/

https://www.theverge.com/2024/8/5/24213861/apple-intelligence-instructions-macos-15-1-sequoia-beta

https://simonwillison.net/2024/Aug/6/apple-intelligence-prompts/

文章来自于微信公众号 Founder Park 作者 Founder Park

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0