本届 ACL 大会,投稿者「收获满满」。

为期六天的 ACL 2024 正在泰国曼谷举办。

ACL 是计算语言学和自然语言处理领域的顶级国际会议,由国际计算语言学协会组织,每年举办一次。一直以来,ACL 在 NLP 领域的学术影响力都位列第一,它也是 CCF-A 类推荐会议。

今年的 ACL 大会已是第 62 届,接收了 400 余篇 NLP 领域的前沿工作。昨天下午,大会公布了最佳论文等奖项。此次,最佳论文奖 7 篇(两篇未公开)、最佳主题论文奖 1 篇、杰出论文奖 35 篇。

大会还评出了资源论文奖(Resource Award)3 篇、社会影响力奖(Social Impact Award)3 篇、时间检验奖 2 篇。

此外,本届大会终身成就奖颁给了纽约大学计算机科学系教授 Ralph Grishman。

以下是具体的获奖信息。

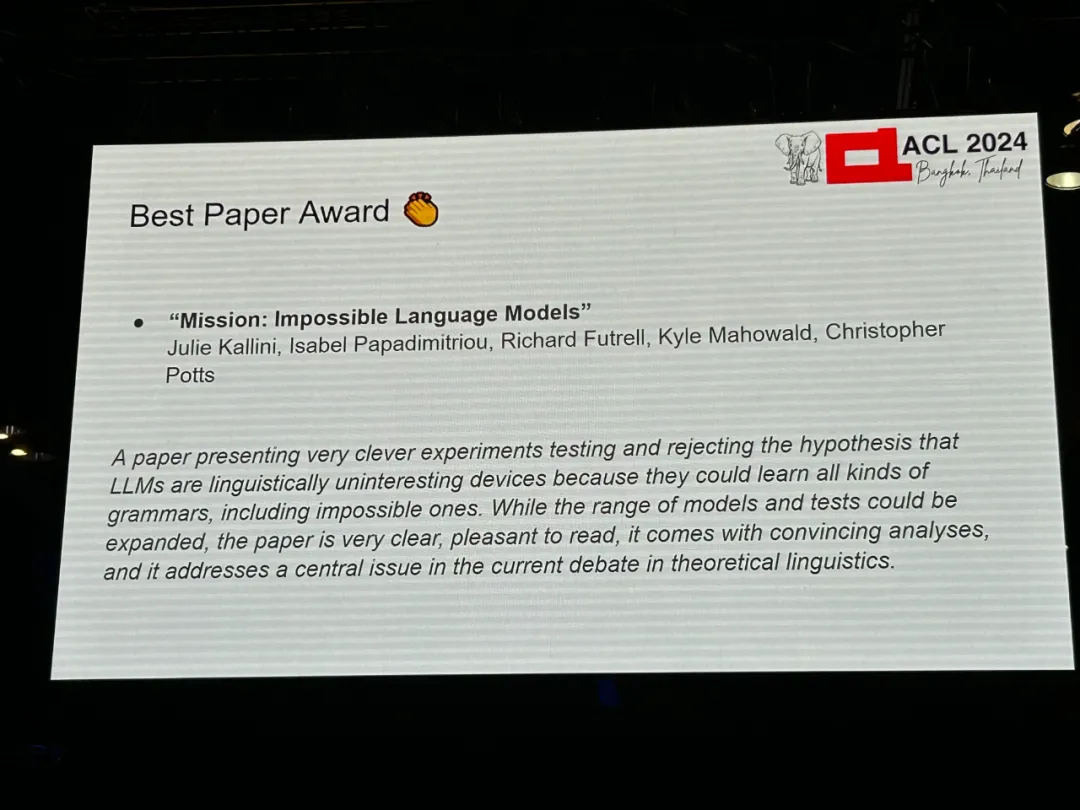

最佳论文

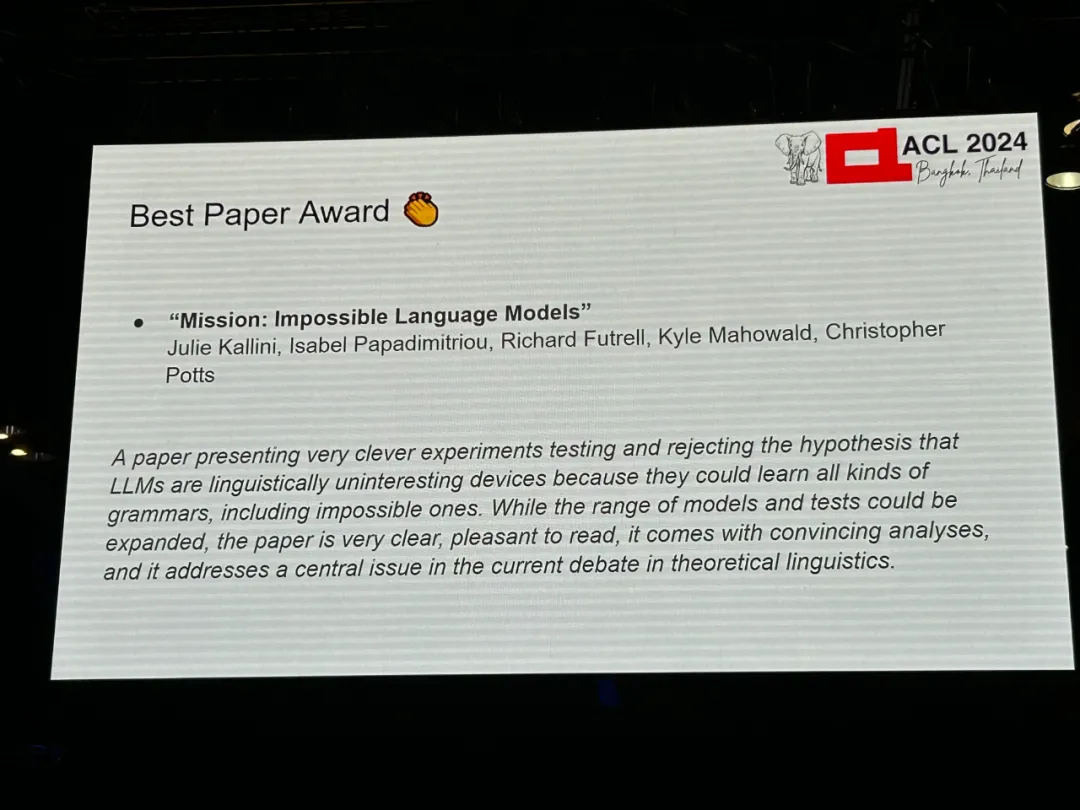

论文 1:Mission: Impossible Language Models

- 作者:Julie Kallini, Isabel Papadimitriou, Richard Futrell, Kyle Mahowald, Christopher Potts

- 机构:斯坦福大学、加州大学尔湾分校、得克萨斯大学奥斯汀分校

- 论文链接:https://arxiv.org/abs/2401.06416

论文简介:乔姆斯基等人认为:对于人类可能或不可能学会的语言,大型语言模型(LLM)的学习能力是一样的。然而,几乎没有公开的实验证据来支持这种说法。

该研究开发了一组具有不同复杂性的合成语言,每一种都是通过使用不自然的词序和语法规则系统地改变英语数据而设计的,旨在合成人类不可能学会的语言。

该研究进行了广泛的评估实验,以评估 GPT-2 小模型学习这些「不可能语言」的能力,并且在整个训练的不同阶段进行这些评估,以比较每种语言的学习过程。该研究的核心发现是:与英语相比,GPT-2 很难学习「不可能语言」,这挑战了乔姆斯基等人的主张。

更重要的是,该研究希望其方法能够开辟一条富有成效的探究路线,让不同的 LLM 架构在各种「不可能语言」上进行测试,以了解如何将 LLM 用作认知和类型学调查工具。

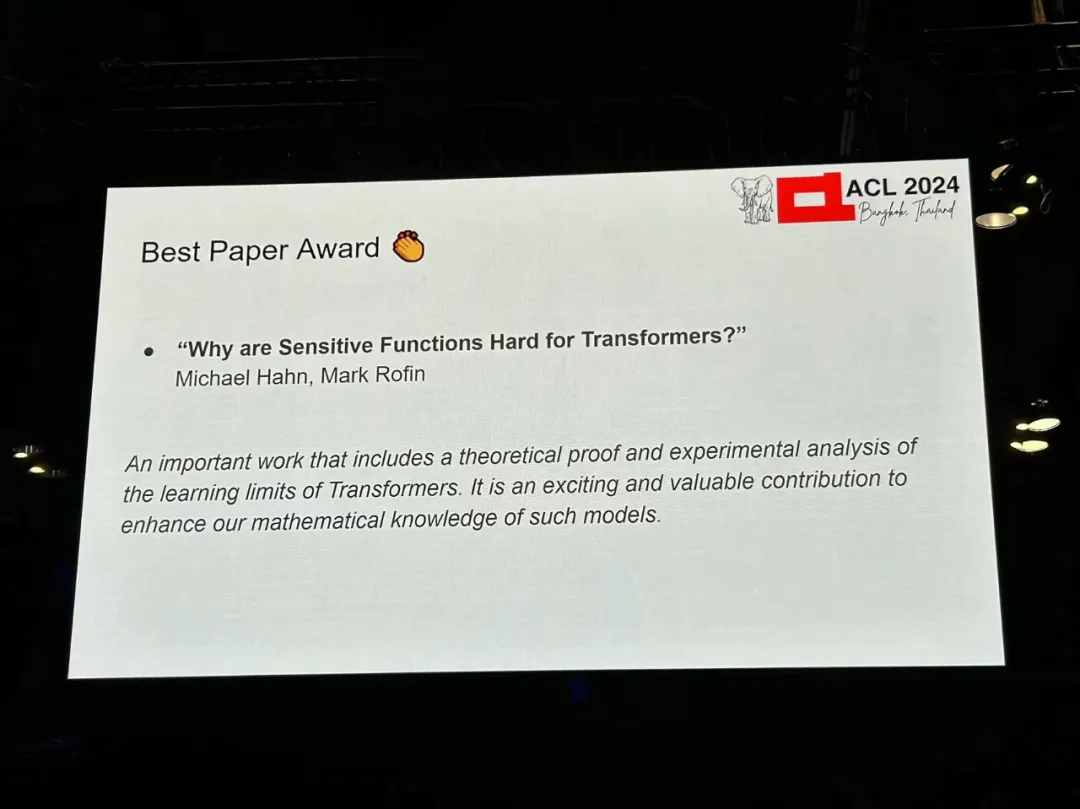

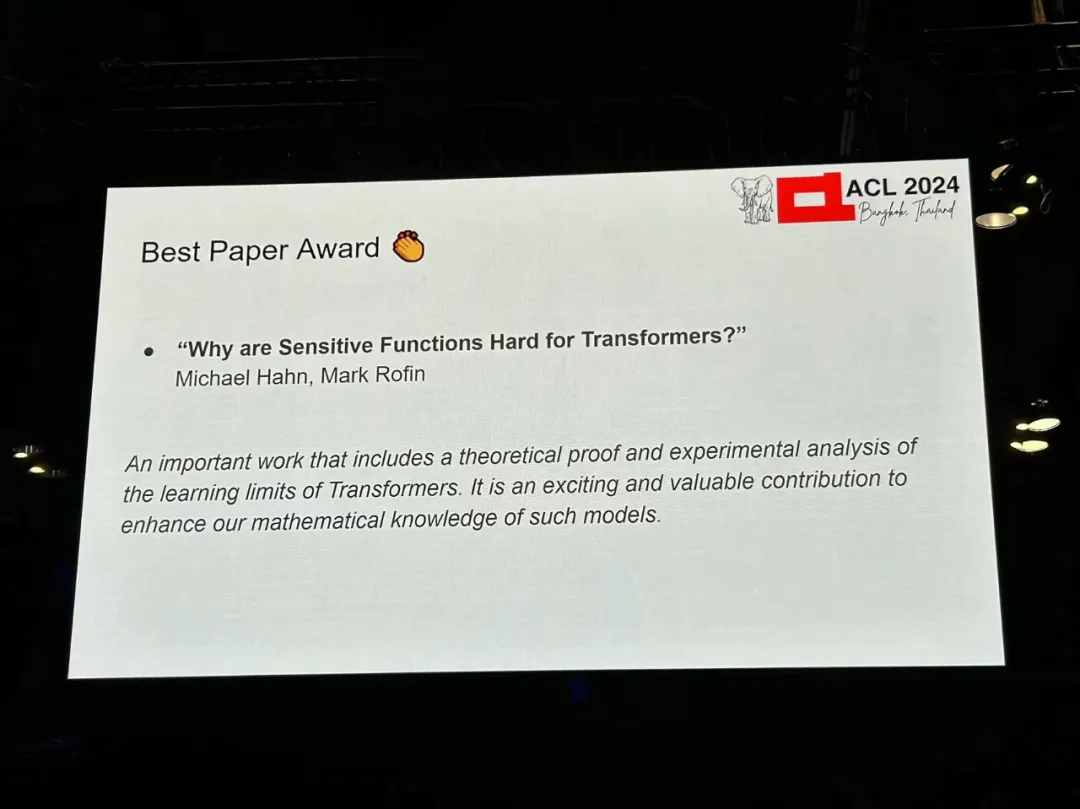

论文 2:Why are Sensitive Functions Hard for Transformers?

- 作者:Michael Hahn, Mark Rofin

- 机构:萨尔大学

- 论文链接:https://arxiv.org/abs/2402.09963

论文简介:实验研究已经确定了 transformer 的一系列可学习性偏置和局限性,例如学习计算 PARITY 等简单形式语言的持续困难,以及对低度(low-degree)函数的偏置。然而,理论理解仍然有限,现有的表达理论要么高估要么低估现实的学习能力。

该研究证明,在 transformer 架构下,损失函数景观(loss landscape)受到输入空间灵敏度的限制:输出对输入串的许多部分敏感的 transformer 位于参数空间中的孤立点,导致泛化中的低灵敏度偏置。

该研究从理论上和实验上表明,该理论统一了关于 transformer 学习能力和偏置的广泛实验观察,例如它们对低灵敏度和低度的泛化偏置,以及奇偶校验长度泛化的困难。这表明,了解 transformer 的归纳偏置(inductive biases)不仅需要研究其原则上的表达能力,还需要研究其损失函数景观。

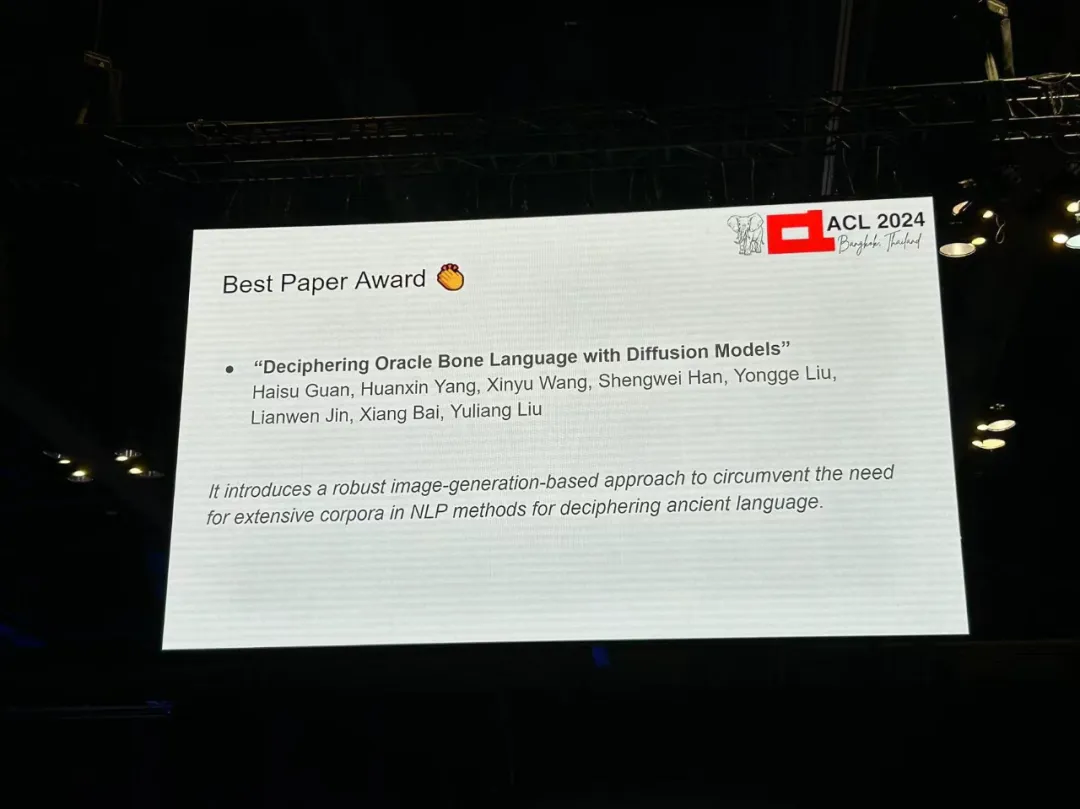

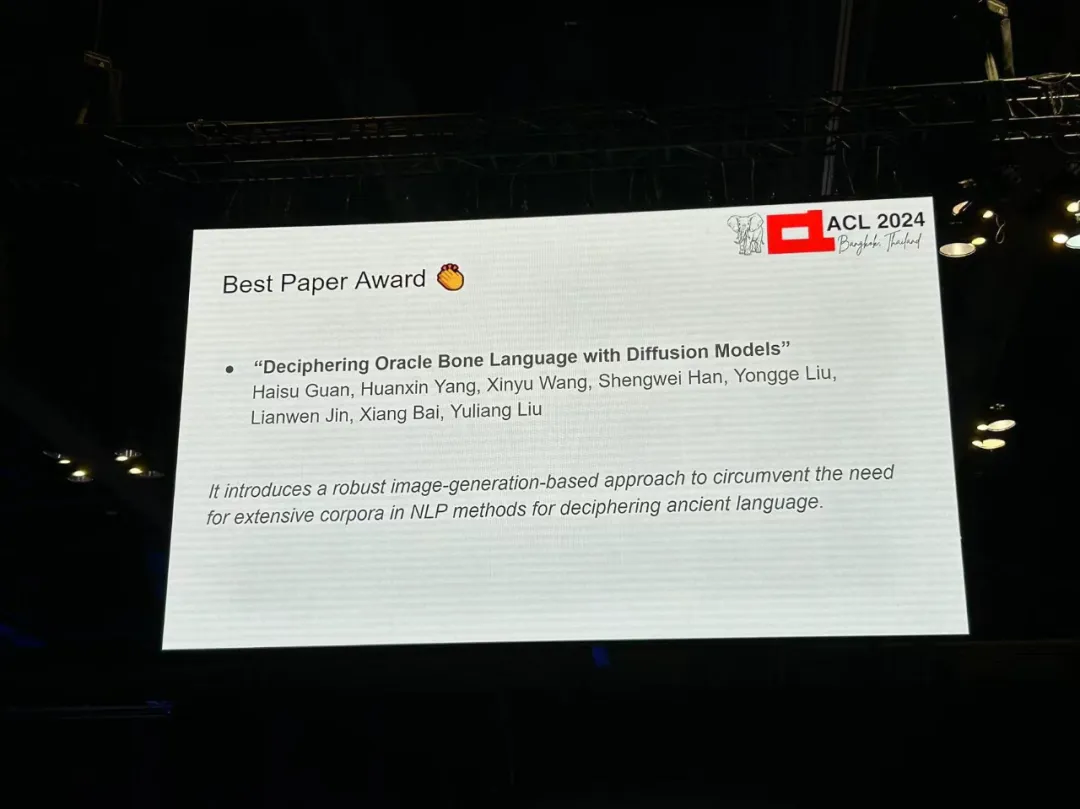

论文 3:Deciphering Oracle Bone Language with Diffusion Models

- 作者:Haisu Guan, Huanxin Yang, Xinyu Wang, Shengwei Han 等

- 机构:华中科技大学、阿德莱德大学、安阳师范学院、华南理工大学

- 论文链接:https://arxiv.org/pdf/2406.00684

论文简介:甲骨文(Oracle Bone Script,OBS)起源于约 3000 年前的中国商朝,是语言史上的基石,早于许多既定的书写系统。尽管发现了数千份铭文,但仍有大量的甲骨文未被破译,从而为这一古老的语言蒙上了一层神秘的面纱。现代 AI 技术的出现为甲骨文破译开辟了新的领域,对严重依赖大型文本语料库的传统 NLP 方法提出了挑战。

本文介绍了一种采用图像生成技术的新方法,开发出了针对甲骨文破译优化的扩散模型 Oracle Bone Script Decipher (OBSD)。利用条件扩散策略,OBSD 为甲骨文破译生成了重要的线索,并为 古代语言的 AI 辅助分析开辟了新方向。为了验证有效性,研究者在甲骨文数据集上进行了广泛的实验,定量结果证明了 OBSD 的有效性。

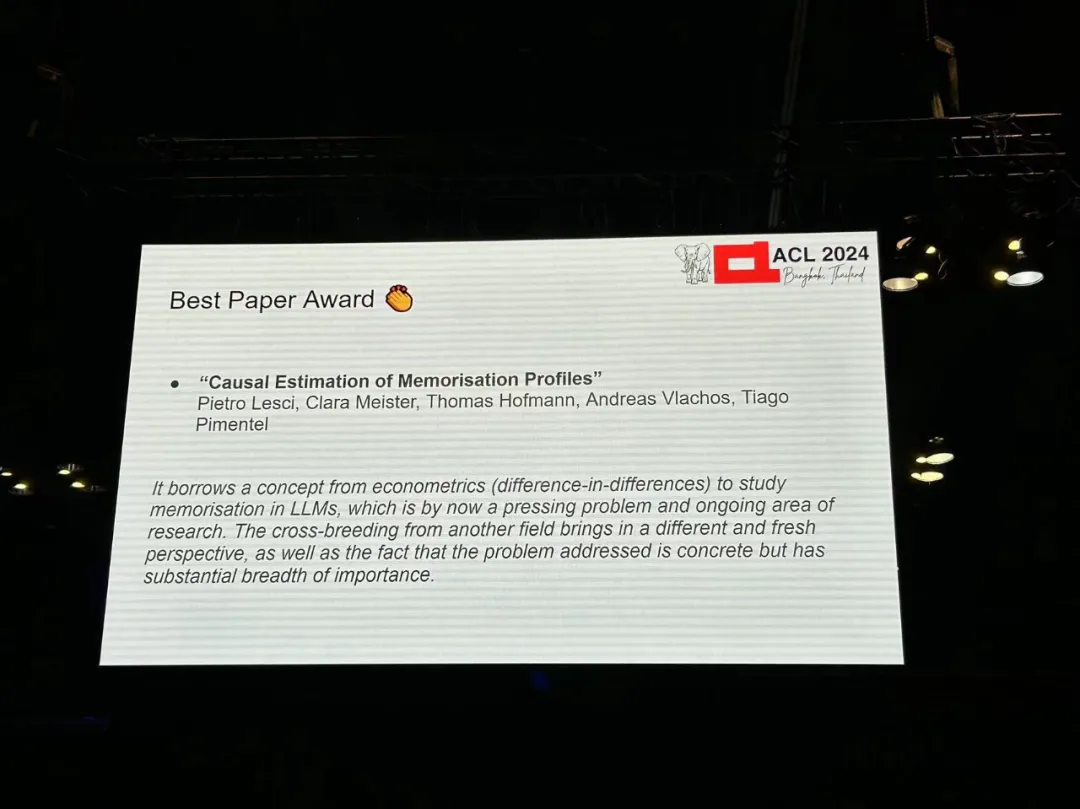

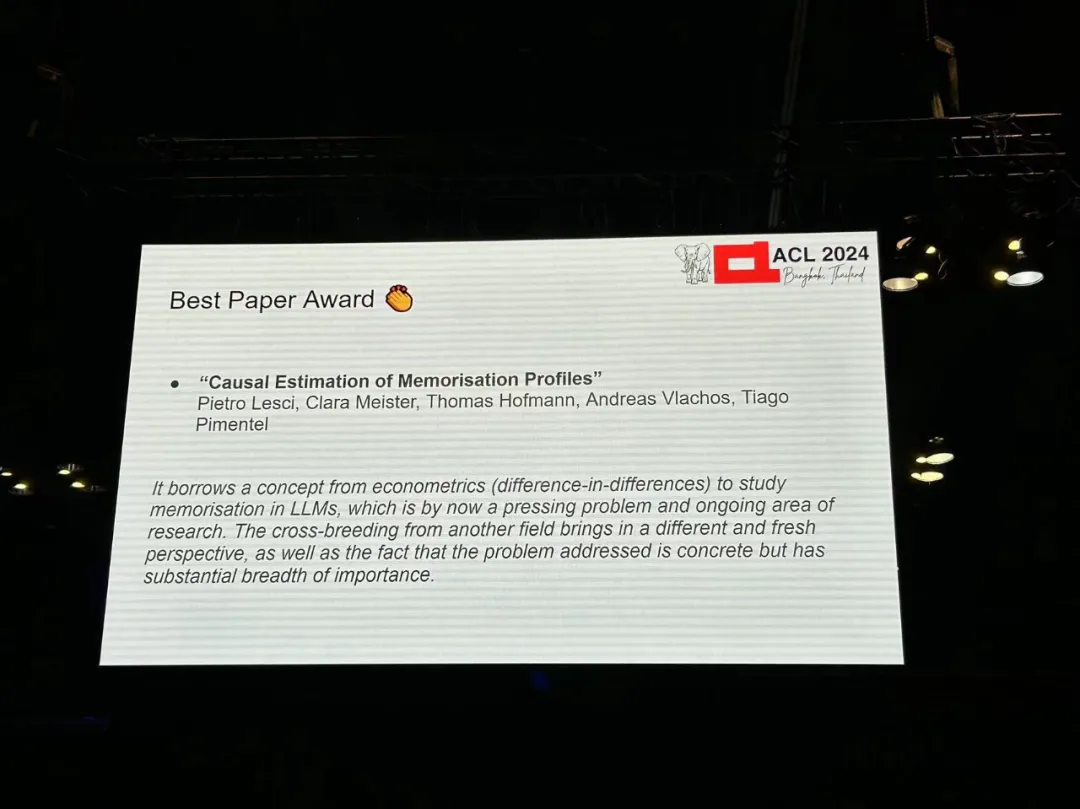

论文 4:Causal Estimation of Memorisation Profiles

- 作者:Pietro Lesci, Clara Meister, Thomas Hofmann, Andreas Vlachos, Tiago Pimentel

- 机构:剑桥大学、苏黎世联邦理工学院

- 论文链接:https://arxiv.org/pdf/2406.04327

论文简介:理解语言模型中的记忆具有实际和社会意义,例如研究模型的训练动态或防止版权侵权。以往的研究将记忆定义为「使用实例进行的训练」对「模型预测该实例的能力」的因果关系。这个定义依赖于一个反事实:观察如果模型没有看到该实例会发生什么的能力。现有的方法难以提供对这种反事实的计算效率和准确性估计。此外,这些方法通常估计模型架构的记忆,而不是特定模型实例的记忆。

本文填补了一个重要空白,提出了一种基于计量经济学的差异 - 差异设计来估计记忆的全新、原则性和高效方法。通过这种方法,研究者在整个训练过程中仅观察模型在一小部分实例上的行为来描述模型的记忆概况,即其在训练过程中的记忆趋势。在使用 Pythia 模型套件进行实验时,他们发现记忆 (i) 在较大模型中更强大、更持久,(ii) 由数据顺序和学习率决定,以及 (iii) 在不同模型大小之间具有稳定的趋势,因此较大模型中的记忆可以从较小模型中预测出来。

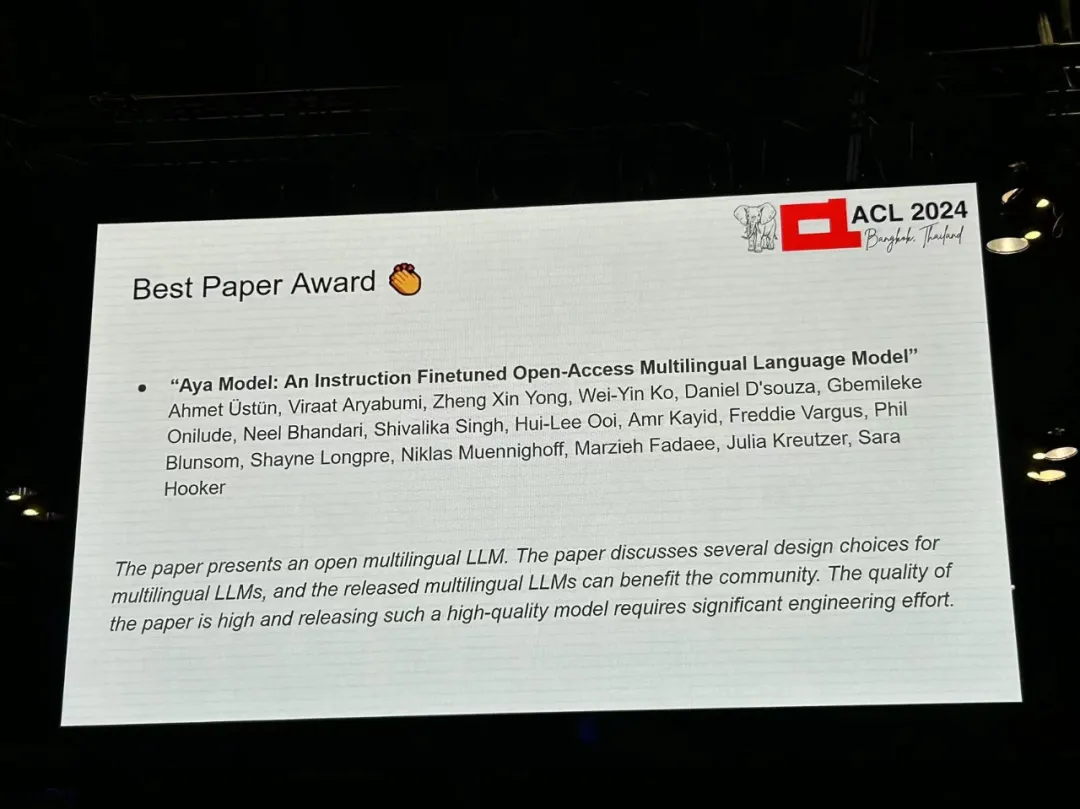

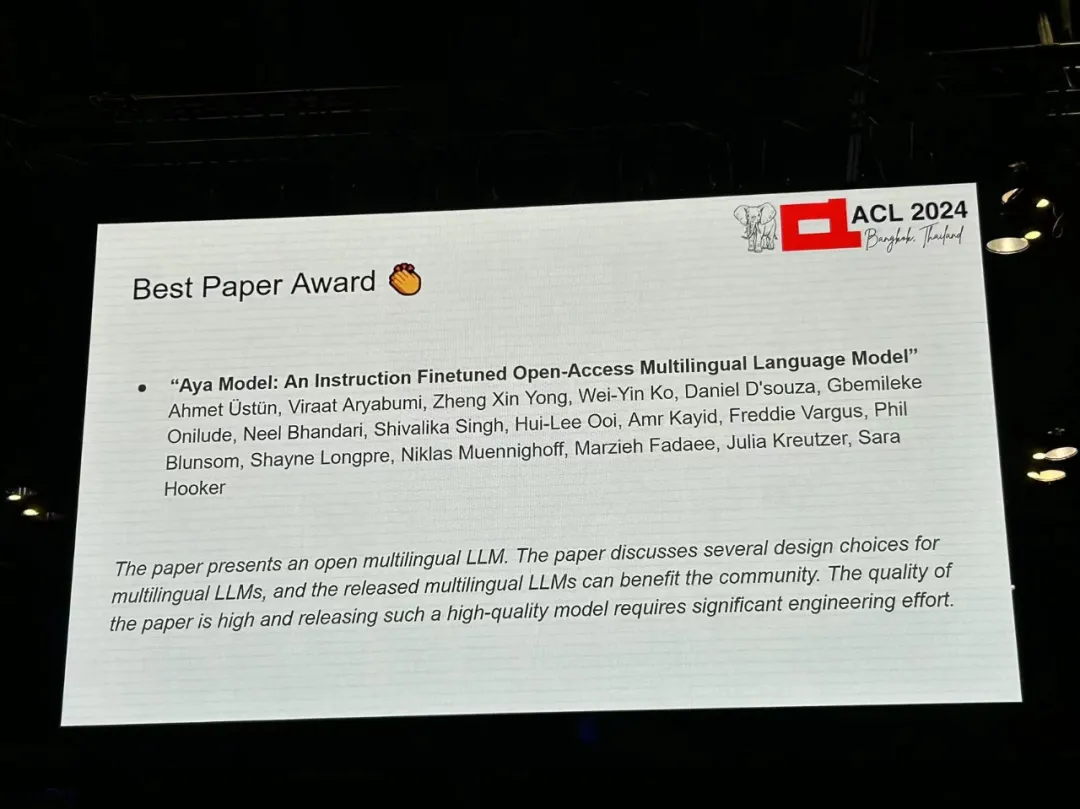

论文 5:Aya Model: An Instruction Finetuned Open-Access Multilingual Language Model

- 作者:Ahmet Üstün, Viraat Aryabumi, Zheng Xin Yong, Wei-Yin Ko 等

- 机构:Cohere、布朗大学等

- 论文链接:https://arxiv.org/pdf/2402.07827

论文简介:大型语言模型 (LLM) 的最新突破集中在少数数据丰富的语言上。如何才能将突破的途径扩展到其他语言之外?该研究引入了 Aya,这是一种大规模多语言生成语言模型,它遵循 101 种语言指令,其中超过 50% 的语言被视为资源较少。Aya 在大多数任务上的表现都优于 mT0 和 BLOOMZ,同时覆盖的语言数量是 mT0 和 BLOOMZ 的两倍。

此外,该研究还引入了广泛的新评估套件,将多语言评估的最新水平扩展到 99 种语言。最后,该研究对最佳微调混合组成、数据剪枝以及模型的毒性、偏差和安全性进行了详细调查。

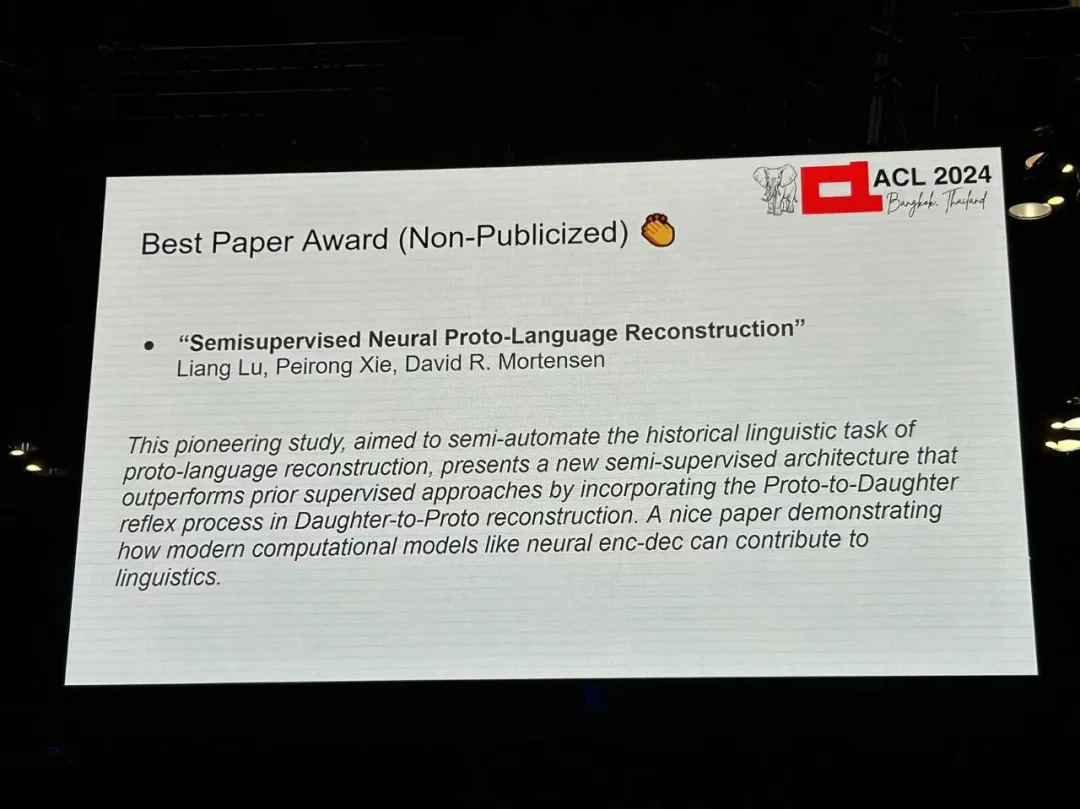

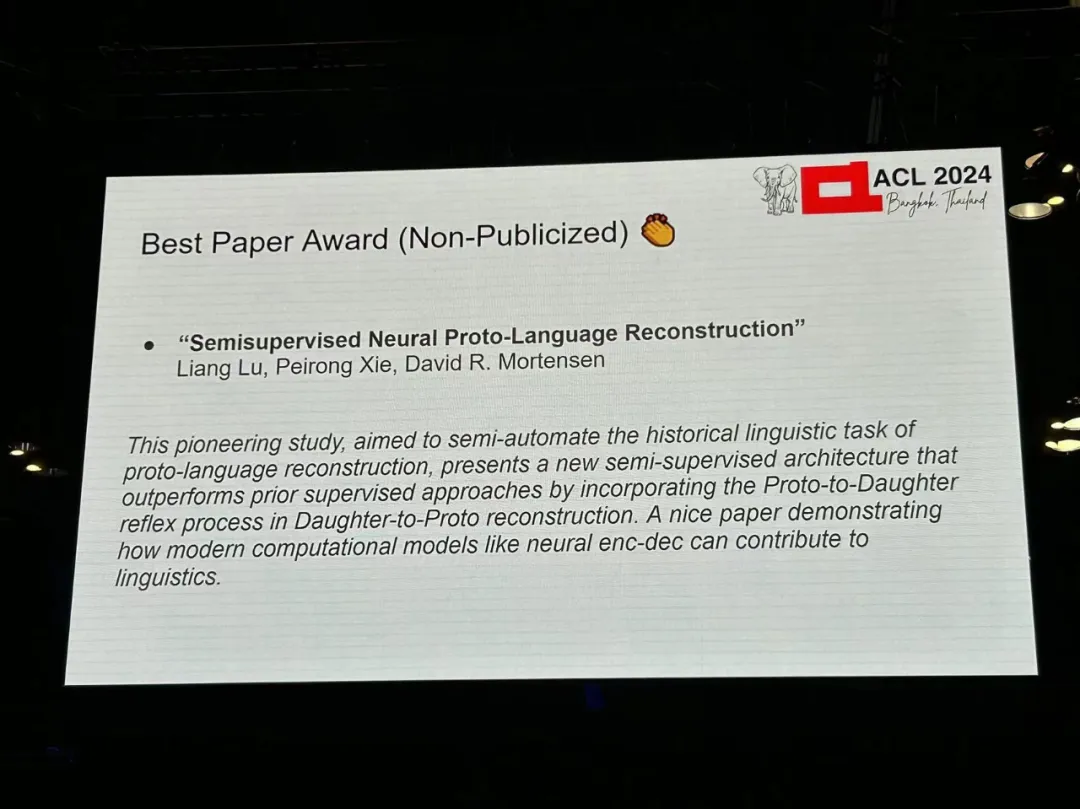

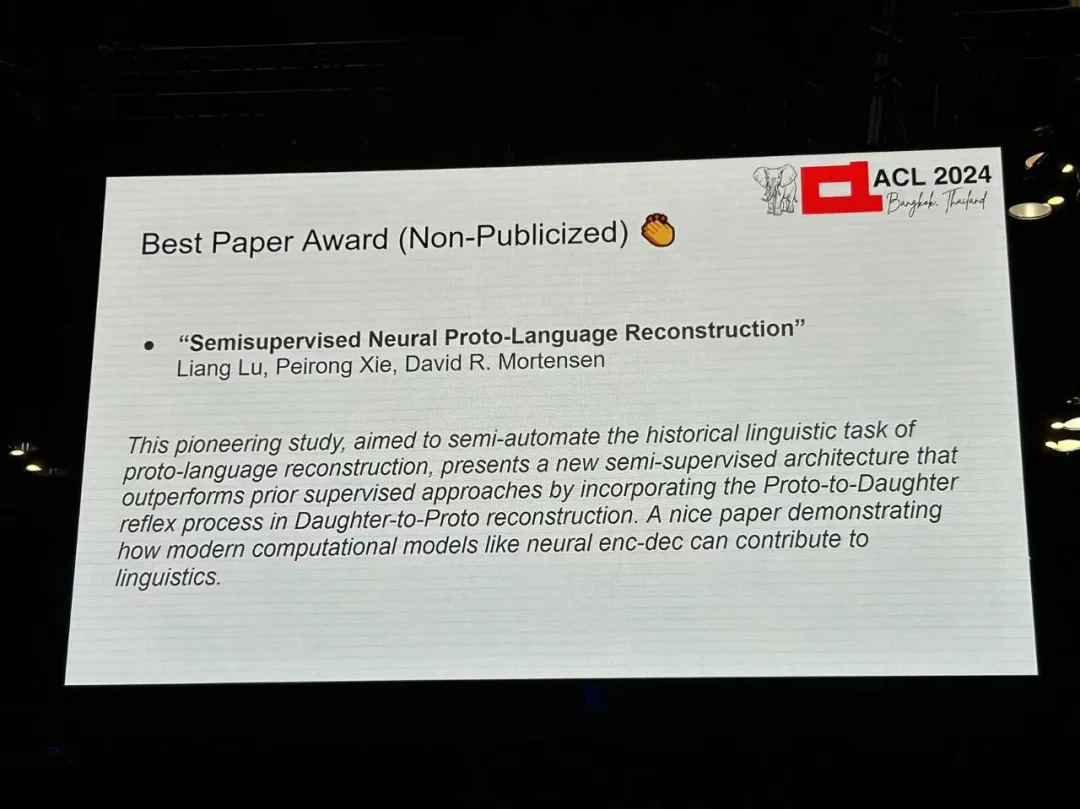

论文 6:Semisupervised Neural Proto-Language Reconstruction

- 作者:Liang Lu 、 Peirong Xie 、 David R. Mortensen

- 机构:CMU、南加州大学

- 论文链接:https://arxiv.org/pdf/2406.05930

获奖理由:这项开创性的研究旨在半自动化历史语言学中的原型语言重构任务,提出了一种新的半监督架构。通过在「母语 - 原型」重构中引入「原型 - 母语」反射过程,这种方法优于之前的监督方法。这篇论文很好地展示了现代计算模型(如神经编码 - 解码器)如何为语言学作出的贡献。

论文 7:Natural Language Satisfiability: Exploring the Problem Distribution and Evaluating Transformer-based Language Models(未公开)

- 作者:Tharindu Madusanka、Ian Pratt-Hartmann、Riza Batista-Navarro

获奖理由:该论文清晰地描述了一个用于逻辑推理的合成评估数据集。这是对大量推理数据集的一种良好补充,因为这些数据集中并不明确测量哪些能力。从理论上讲,确实有理由预期某些子集比其他子集更难,而这些预期在论文中得到了验证。在每个类别中,作者都特别注意抽取那些真正具有挑战性的案例。

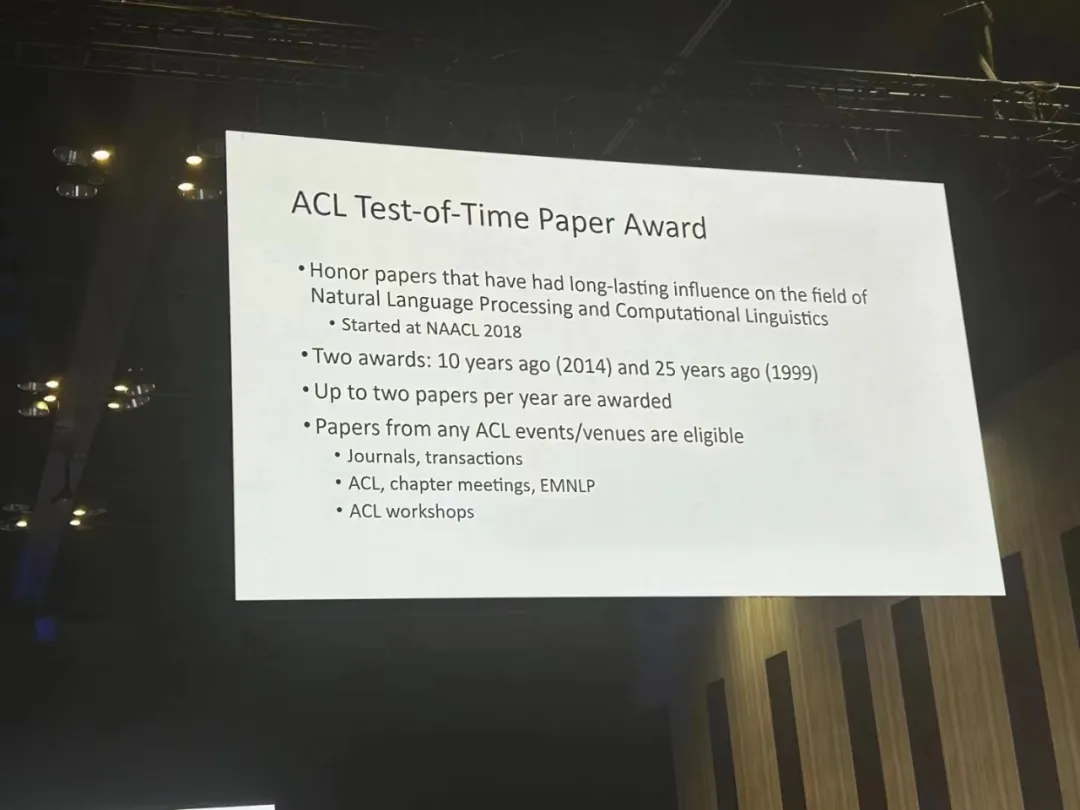

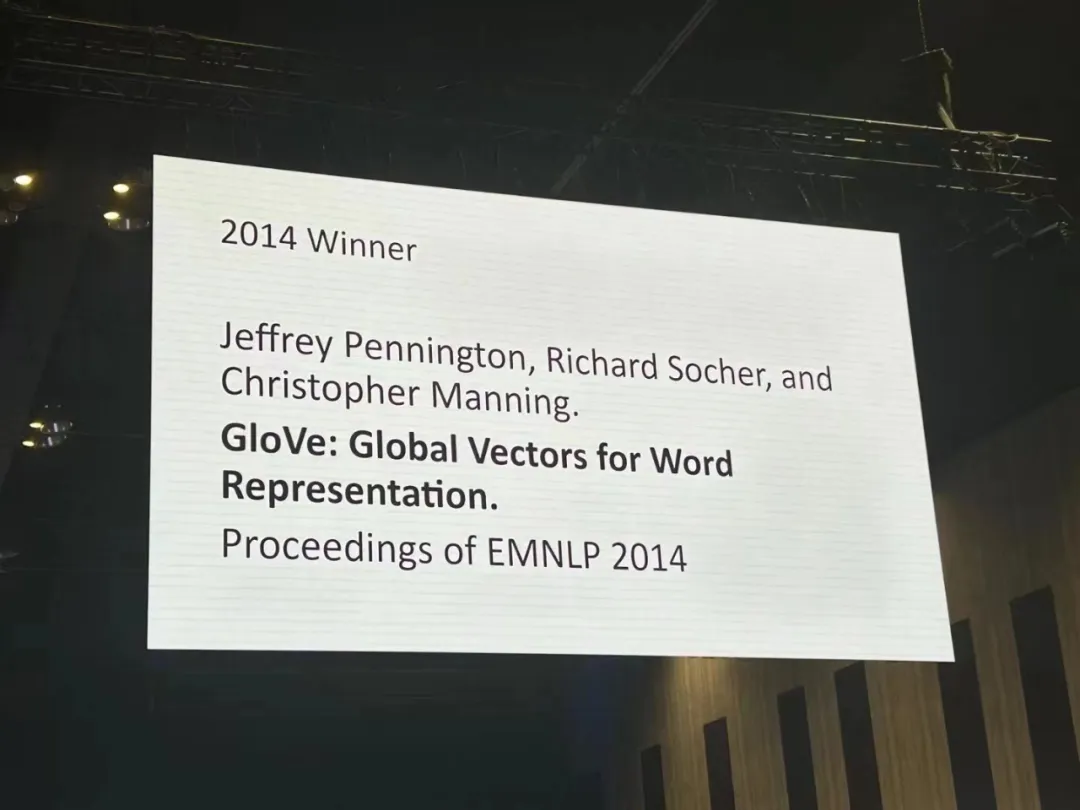

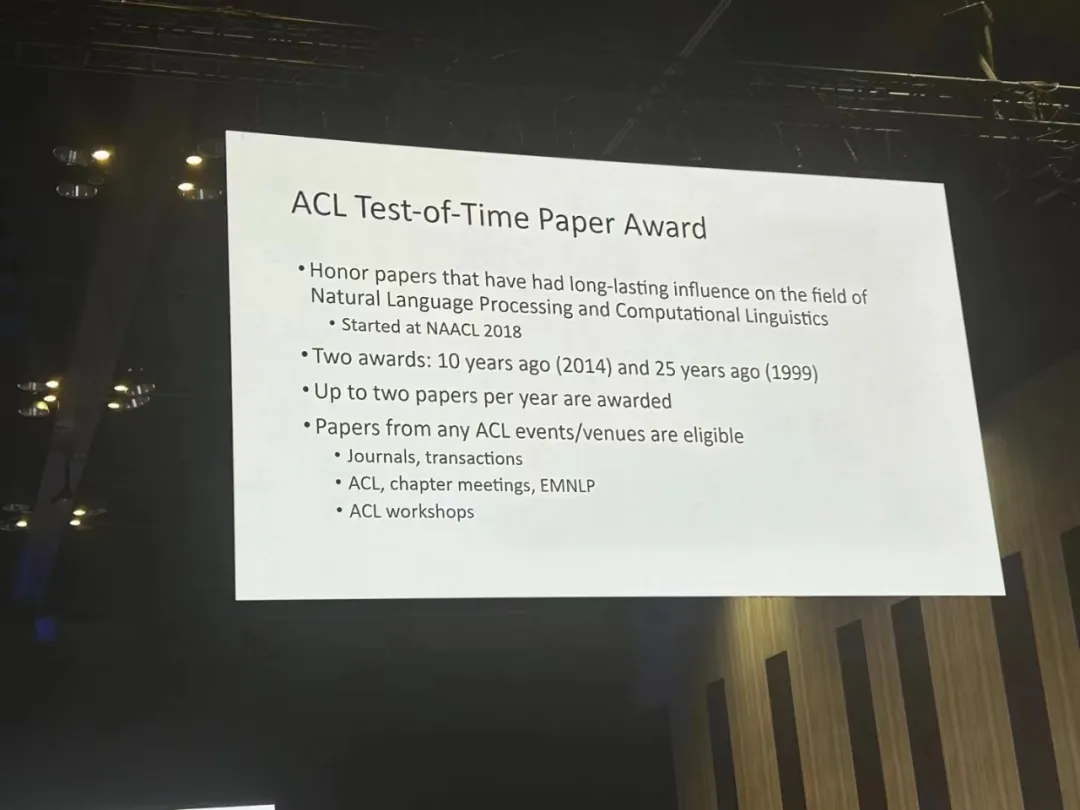

时间检验奖

ACL 时间检验奖奖励的是对自然语言处理和计算语言学领域产生长期影响的荣誉论文,分为 10 年前(2014 年)和 25 年前(1999 年)两个奖项,每年最多颁发两篇论文。

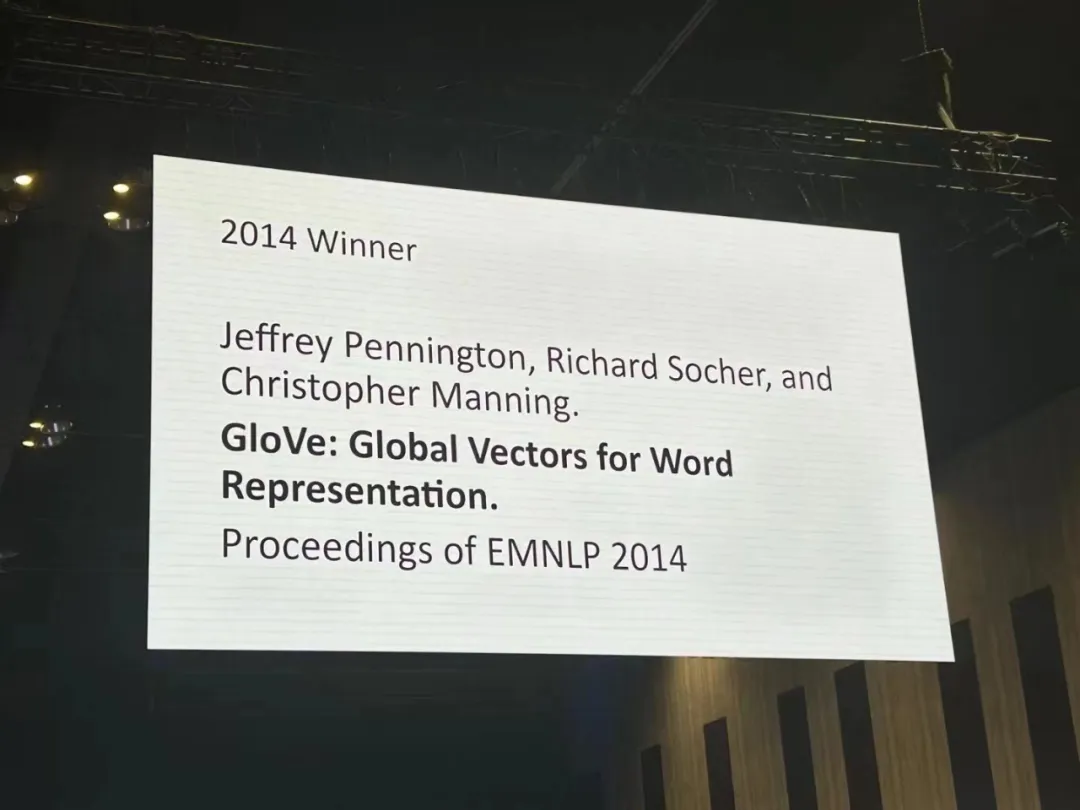

论文 1:GloVe: Global Vectors for Word Representation

- 作者:Jeffrey Pennington, Richard Socher, Christopher D. Manning

- 机构:斯坦福大学

- 论文链接:https://aclanthology.org/D14-1162.pdf

论文简介:学习词的向量空间表征的方法已经在使用向量算术捕获细粒度的语义和句法规则方面取得了成功,但是句法规则仍不透明。该研究分析并明确了为了让句法规则出现在词向量中,模型需要具备哪些属性。

该研究提出了一个新的全局对数线性回归模型 ——GloVe,旨在学习词的向量表征。该模型结合了全局矩阵分解和局部上下文窗口两种方法的优点。

GloVe 在词类比任务上取得了 75% 的最佳性能,并在词相似性任务和命名实体识别方面优于相关模型。

获奖理由:词嵌入是 2013 年至 2018 年间自然语言处理(NLP)深度学习方法的基石,并且持续发挥着显著影响。它们不仅增强了 NLP 任务的性能,而且在计算语义学方面也产生了显著影响,例如在词语相似性和类比上。两种最有影响力的词嵌入方法可能是 skip-gram/CBOW 和 GloVe。与 skip-gram 相比,GloVe 提出得较晚。它的相对优势在于概念上的简单性,直接根据词之间的分布特性优化向量空间相似性,而不是从简化的语言建模角度间接作为一组参数。

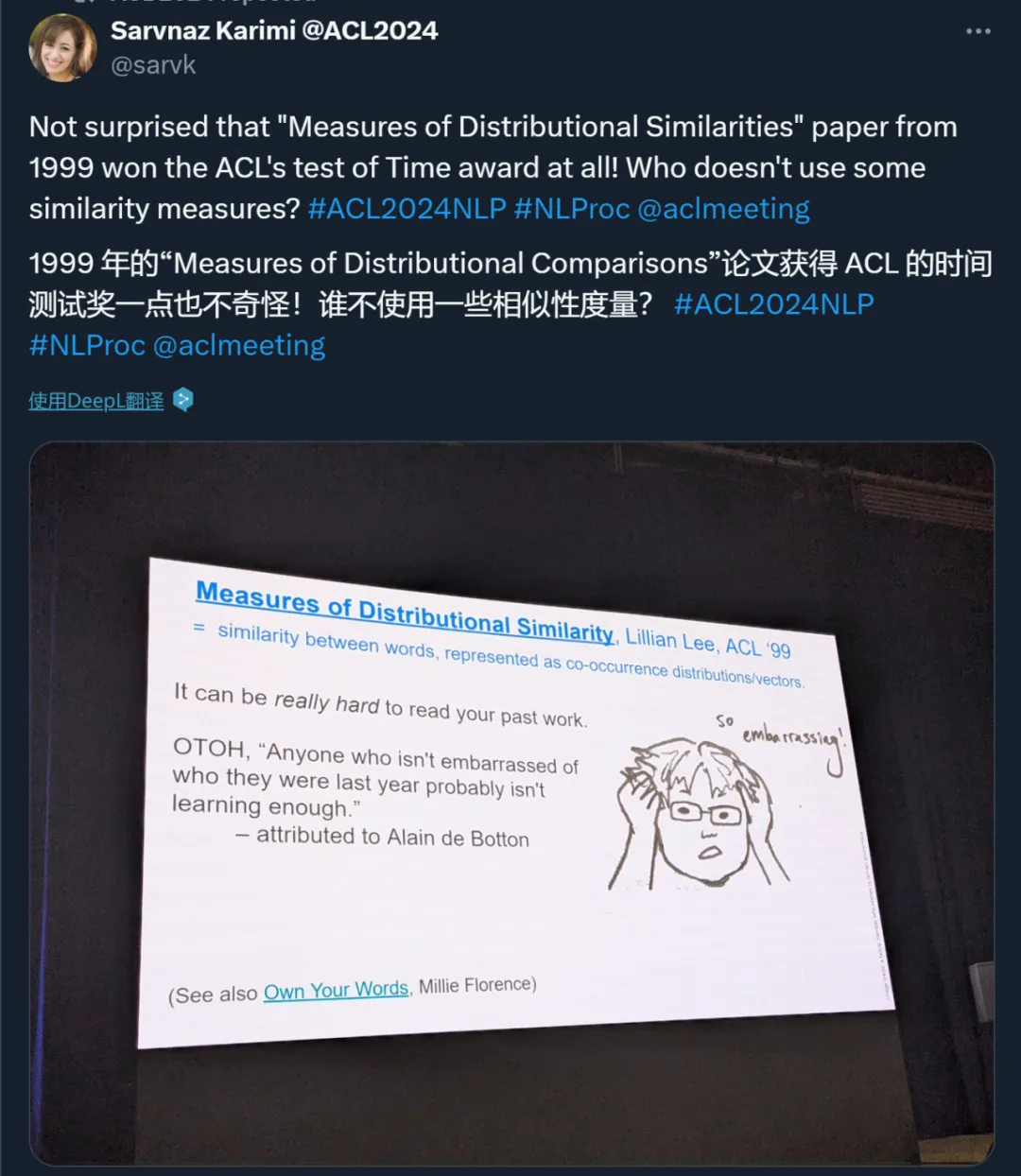

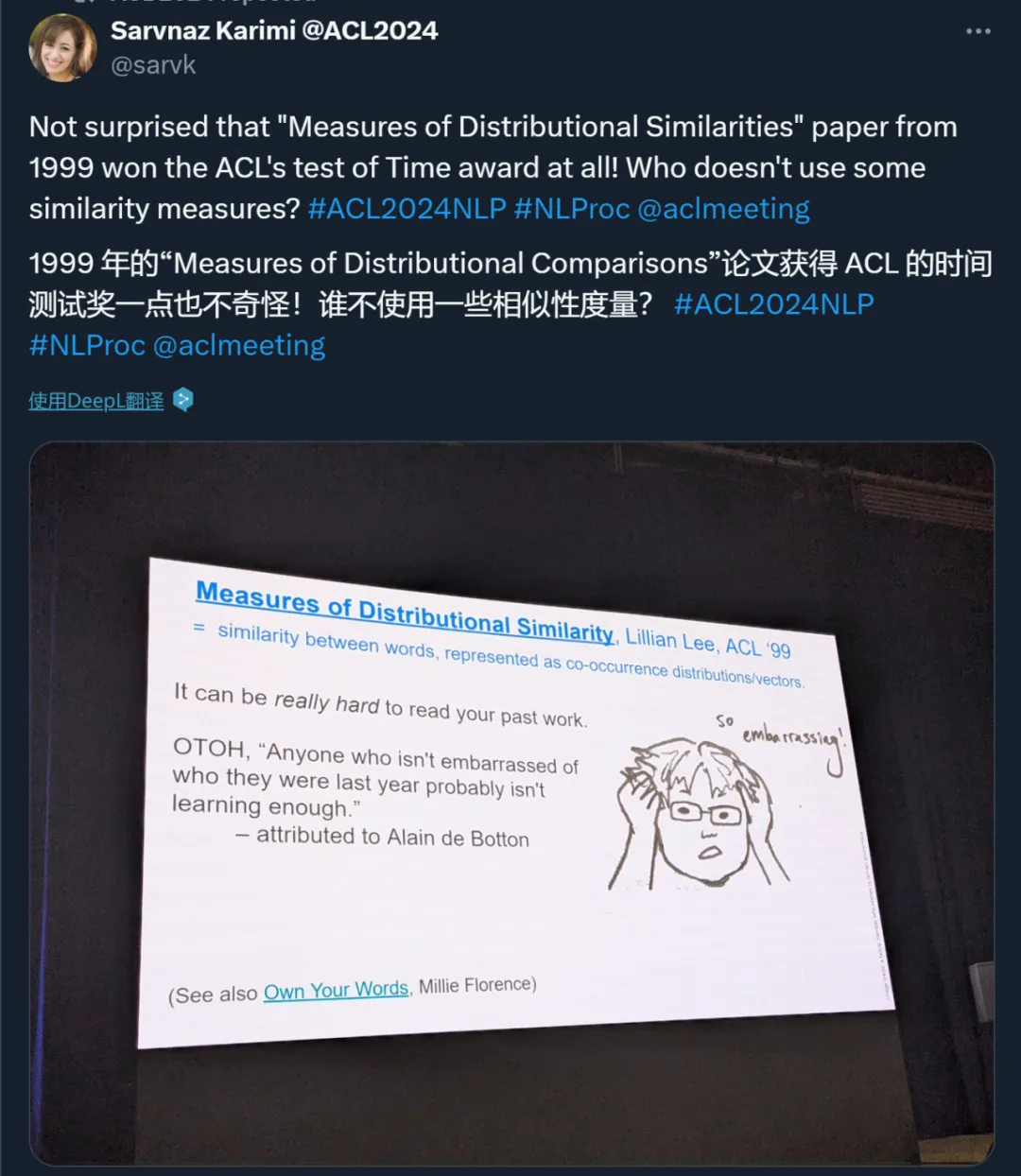

论文 2:Measures of Distributional Similarity

- 作者:Lillian Lee

- 机构:康奈尔大学

- 论文链接:https://aclanthology.org/P99-1004.pdf

论文简介:作者研究了分布相似性度量,目的是提高对未见共现事件的概率估计。他们的贡献有三个方面:对一系列广泛的度量方法进行实证比较;基于它们所包含的信息对相似性函数进行分类;引入了一种新的函数,该函数在评估潜在代理分布方面更为优越。

终身成就奖

ACL 的终身成就奖颁给了 Ralph Grishman。Ralph Grishman 是纽约大学计算机科学系的教授,专注于自然语言处理(NLP)领域的研究。他是 Proteus Project 的创始人,该项目在信息抽取(IE)方面做出了重大贡献,推动了该领域的发展。

他还开发了 Java Extraction Toolkit (JET),这是一个广泛使用的信息抽取工具,提供了多种语言分析组件,如句子分割、命名实体标注、时间表达标注与规范化、词性标注、部分解析和共指分析。这些组件可以根据不同应用组合成管道,既可用于单个句子的交互分析,也可用于整篇文档的批量分析。此外,JET 还提供了简单工具用于文档的标注和显示,并包括完整的流程以按照 ACE(自动内容抽取)规范进行实体、关系和事件的抽取。

Grishman 教授的工作涵盖了多个 NLP 的核心问题,并对现代语言处理技术产生了深远的影响。

35 篇杰出论文

- 论文 1:Quantized Side Tuning: Fast and Memory-Efficient Tuning of Quantized Large Language Models

- 作者:Zhengxin Zhang, Dan Zhao, Xupeng Miao, Gabriele Oliaro, Zhihao Zhang, Qing Li, Yong Jiang, Zhihao Jia

- 机构:CMU、清华大学、鹏城实验室等

- 论文链接:https://arxiv.org/pdf/2401.07159

- 论文 2:L-Eval: Instituting Standardized Evaluation for Long Context Language Models

- 作者:Chenxin An, Shansan Gong, Ming Zhong, Xingjian Zhao, Mukai Li, Jun Zhang, Lingpeng Kong, Xipeng Qiu

- 机构:复旦大学、香港大学、伊利诺伊大学厄巴纳 - 香槟分校、上海 AI Lab

- 论文链接:https://arxiv.org/abs/2307.11088

- 论文 3:Causal-Guided Active Learning for Debiasing Large Language Models

- 论文链接:https://openreview.net/forum?id=idp_1Q6F-lC

- 论文 4:CausalGym: Benchmarking causal interpretability methods on linguistic tasks

- 作者:Aryaman Arora, Dan Jurafsky, Christopher Potts

- 机构:斯坦福大学

- 论文链接:https://arxiv.org/abs/2402.12560

- 论文 5:Don't Hallucinate, Abstain: Identifying LLM Knowledge Gaps via Multi-LLM Collaboration

- 作者:Shangbin Feng, Weijia Shi, Yike Wang, Wenxuan Ding, Vidhisha Balachandran, Yulia Tsvetkov

- 机构:华盛顿大学、加州大学伯克利分校、香港科技大学、CMU

- 论文链接:https://arxiv.org/abs/2402.00367

- 论文 6:Speech Translation with Speech Foundation Models and Large Language Models: What is There and What is Missing?

- 作者:Marco Gaido, Sara Papi, Matteo Negri, Luisa Bentivogli

- 机构:意大利布鲁诺・凯斯勒基金会

- 论文链接:https://arxiv.org/abs/2402.12025

- 论文 7:Must NLP be Extractive?

- 作者:Steven Bird

- 机构:查尔斯达尔文大学

- 论文链接:https://drive.google.com/file/d/1hvF7_WQrou6CWZydhymYFTYHnd3ZIljV/view

- 论文 8:IRCoder: Intermediate Representations Make Language Models Robust Multilingual Code Generators

- 作者:Indraneil Paul、Goran Glavaš、Iryna Gurevych

- 机构:达姆施塔特工业大学等

- 论文链接:https://arxiv.org/abs/2403.03894

- 论文 9:MultiLegalPile: A 689GB Multilingual Legal Corpus

- 作者:Matthias Stürmer 、 Veton Matoshi 等

- 机构:伯尔尼大学、斯坦福大学等

- 论文链接:https://arxiv.org/pdf/2306.02069

- 论文 10:PsySafe: A Comprehensive Framework for Psychological-based Attack, Defense, and Evaluation of Multi-agent System Safety

- 作者: Zaibin Zhang 、 Yongting Zhang 、 Lijun Li 、 Hongzhi Gao 、 Lijun Wang 、 Huchuan Lu 、 Feng Zhao 、 Yu Qiao、Jing Shao

- 机构:上海人工智能实验室、大连理工大学、中国科学技术大学

- 论文链接:https://arxiv.org/pdf/2401.11880

- 论文 11:Can Large Language Models be Good Emotional Supporter? Mitigating Preference Bias on Emotional Support Conversation

- 作者:Dongjin Kang、Sunghwan Kim 等

- 机构:延世大学等

- 论文链接:https://arxiv.org/pdf/2402.13211

- 论文 12:Political Compass or Spinning Arrow? Towards More Meaningful Evaluations for Values and Opinions in Large Language Models

- 作者:Paul Röttger 、 Valentin Hofmann 等

- 机构:博科尼大学、艾伦人工智能研究院等

- 论文链接:https://arxiv.org/pdf/2402.16786

- 论文 13:Same Task, More Tokens: the Impact of Input Length on the Reasoning Performance of Large Language Models

- 作者:Mosh Levy 、 Alon Jacoby 、 Yoav Goldberg

- 机构:巴伊兰大学、艾伦人工智能研究院

- 论文链接:https://arxiv.org/pdf/2402.14848

- 论文 14:Do Llamas Work in English? On the Latent Language of Multilingual Transformers

- 作者:Chris Wendler 、 Veniamin Veselovsky 等

- 机构:洛桑联邦理工学院

- 论文链接:https://arxiv.org/pdf/2402.10588

- 论文 15:Getting Serious about Humor: Crafting Humor Datasets with Unfunny Large Language Models

- 作者:Zachary Horvitz 、 Jingru Chen 等

- 机构:哥伦比亚大学、洛桑联邦理工学院

- 论文链接:https://arxiv.org/pdf/2403.00794

- 论文 16:Estimating the Level of Dialectness Predicts Inter-annotator Agreement in Multi-dialect Arabic Datasets

- 作者:Amr Keleg, Walid Magdy, Sharon Goldwater

- 机构:爱丁堡大学

- 论文链接:https://arxiv.org/pdf/2405.11282

- 论文 17:G-DlG: Towards Gradient-based Dlverse and hiGh-quality Instruction Data Selection for Machine Translation

- 作者:Xingyuan Pan, Luyang Huang, Liyan Kang, Zhicheng Liu, Yu Lu, Shanbo Cheng

- 机构:ByteDance Research

- 论文链接:https://arxiv.org/pdf/2405.12915

- 论文 18:Media Framing: A typology and Survey of Computational Approaches Across Disciplines

- 作者:Yulia Otmakhova, Shima Khanehzar, Lea Frermann

- 论文链接:https://openreview.net/pdf?id=9AV_zM56pwj

- 论文 19:SPZ: A Semantic Perturbation-based Data Augmentation Method with Zonal-Mixing for Alzheimer's Disease Detection

- 作者:FangFang Li、Cheng Huang、PuZhen Su、Jie Yin

- 论文 20:Greed is All You Need: An Evaluation of Tokenizer Inference Methods

- 机构:内盖夫本・古里安大学、麻省理工学院

- 作者:Omri Uzan、Craig W.Schmidt、Chris Tanner、Yuval Pinter

- 论文链接:https://arxiv.org/abs/2403.01289

- 论文 21:Language Complexity and Speech Recognition Accuracy: Orthographic Complexity Hurts, Phonological Complexity Doesn't

- 机构:圣母大学(美国)

- 作者:Chihiro Taquchi、David Chiang

- 论文链接:https://arxiv.org/abs/2406.09202

- 论文 22:Steering Llama 2 via Contrastive Activation Addition

- 机构:Anthropic、哈佛大学、哥廷根大学(德国)、 Center for Human-Compatible AI

- 作者:Nina Rimsky、Nick Gabrieli、Julian Schulz、Meg Tong、Evan J Hubinger、Alexander Matt Turner

- 论文链接:https://arxiv.org/abs/2312.06681

- 论文 23:EconAgent: Large Language Model-Empowered Agents for Simulating Macroeconomic Activities

- 机构:清华大学 - 深圳国际研究生院、清华大学

- 作者:Nian Li、Chen Gao、Mingyu Li、Yong Li、Qingmin Liao

- 论文链接:https://arxiv.org/abs/2310.10436

- 论文 24:M4LE: A Multi-Ability Multi-Range Multi-Task Multi-Domain Long-Context Evaluation Benchmark for Large Language Models

- 机构:香港中文大学、华为诺亚方舟实验室、香港科技大学

- 作者:Wai-Chung Kwan、Xingshan Zeng、Yufei Wang、Yusen Sun、Liangyou Li、Lifeng Shang、Qun Liu、Kam-Fai Wong

- 论文链接:https://arxiv.org/abs/2310.19240

- 论文 25:CHECKWHY: Causal Fact Verification via Argument Structure

- 作者:Jiasheng Si、Yibo Zhao、Yingjie Zhu、Haiyang Zhu、Wenpeng Lu、Deyu Zhou

- 论文 26:On Efficient and Statistical Quality Estimation for Data Annotation

- 作者:Jan-Christoph Klie,Juan Haladjian,Marc Kirchner,Rahul Nair

- 机构:UKP Lab,、TU Darmstadt 、苹果公司

- 论文链接:https://arxiv.org/pdf/2405.11919

- 论文 27:Emulated Disalignment: Safety Alignment for Large Language Models May Backfire!

- 作者:Zhanhui Zhou, Jie Liu, Zhichen Dong, Jiaheng Liu, Chao Yang, Wanli Ouyang, Yu Qiao

- 机构:上海人工智能实验室

- 论文链接:https://arxiv.org/pdf/2402.12343

- 论文 28:IndicLLMSuite: A Blueprint for Creating Pre-training and Fine-Tuning Datasets for Indian Languages

- 作者:Mohammed Safi Ur Rahman Khan, Priyam Mehta, Ananth Sankar 等

- 机构:Nilekani Centre at AI4Bharat、印度理工学院(马德拉斯)、微软等

- 论文链接:https://arxiv.org/pdf/2403.06350

- 论文 29:MultiPICo: Multilingual Perspectivist lrony Corpus

- 作者:Silvia Casola, Simona Frenda, Soda Marem Lo, Erhan Sezerer等

- 机构:都灵大学、aequa-tech、亚马逊开发中心(意大利)等

- 论文链接:https://assets.amazon.science/08/83/9b686f424c89b08e8fa0a6e1d020/multipico-multilingual-perspectivist-irony-corpus.pdf

- 论文 30:MMToM-QA: Multimodal Theory of Mind Question Answering

- 作者:Chuanyang Jin, Yutong Wu, Jing Cao, jiannan Xiang等

- 机构:纽约大学、哈佛大学、MIT、加州大学圣迭戈分校、弗吉尼亚大学、约翰霍普金斯大学

- 论文链接:https://arxiv.org/pdf/2401.08743

- 论文 31:MAP's not dead yet: Uncovering true language model modes by conditioning away degeneracy

- 作者:Davis Yoshida, Kartik Goyal, Kevin Gimpel

- 机构:丰田工业大学芝加哥分校、佐治亚理工学院

- 论文链接:https://arxiv.org/pdf/2311.08817

- 论文 32:NounAtlas: Filling the Gap in Nominal Semantic Role Labeling

- 作者:Roberto Navigli, Marco Lo Pinto, Pasquale Silvestri等

- 论文 33:The Earth is Flat because.. lnvestigating LLMs' Belief towards Misinformation via PersuasiveConversation

- 作者:Rongwu Xu, Brian S. Lin, Shujian Yang, Tiangi Zhang等

- 机构:清华大学、上海交通大学、斯坦福大学、南洋理工大学

- 论文链接:https://arxiv.org/pdf/2312.09085

- 论文 34:Let's Go Real Talk: Spoken Dialogue Model for Face-to-Face Conversation

- 作者:Se Jin Park, Chae Won Kim, Hyeongseop Rha, Minsu Kim等

- 机构:韩国科学技术院(KAIST)

- 论文链接:https://arxiv.org/pdf/2406.07867

- 论文 35:Word Embeddings Are Steers for Language Models

- 作者:Chi Han, Jialiang Xu, Manling Li, Yi Fung, Chenkai Sun, Nan Jiang, Tarek F. Abdelzaher, Heng Ji

- 机构:伊利诺伊大学厄巴纳 - 香槟分校

- 论文链接:https://arxiv.org/pdf/2305.12798

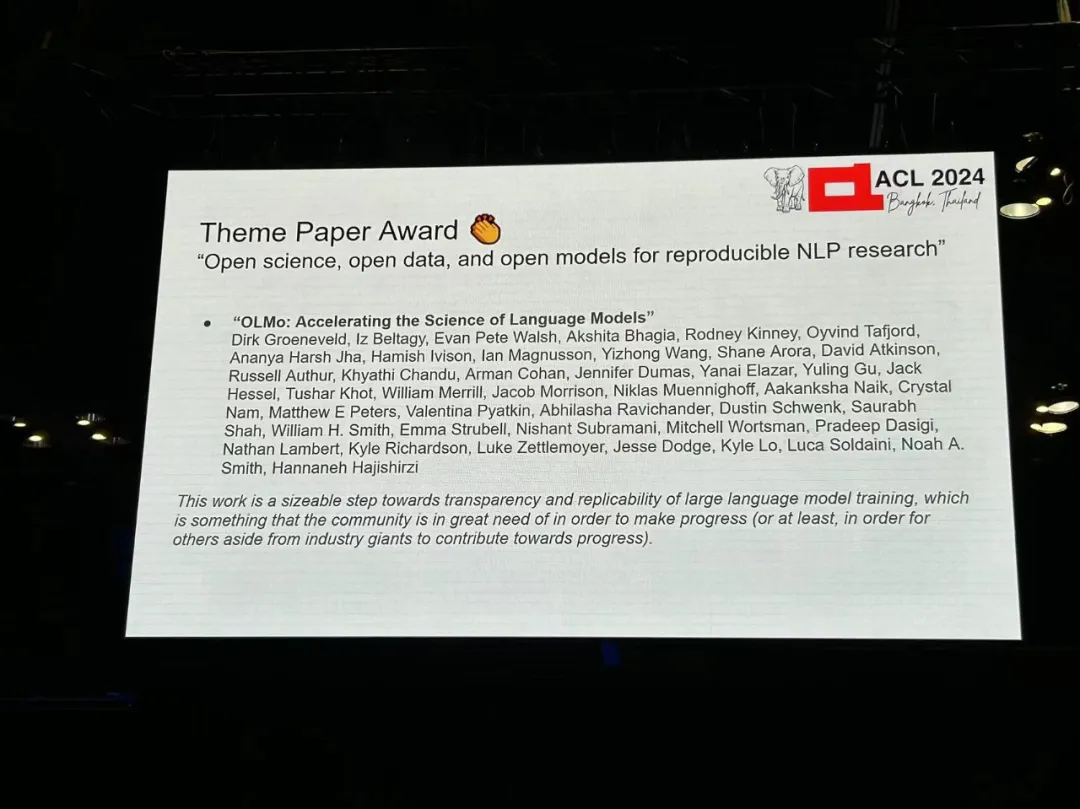

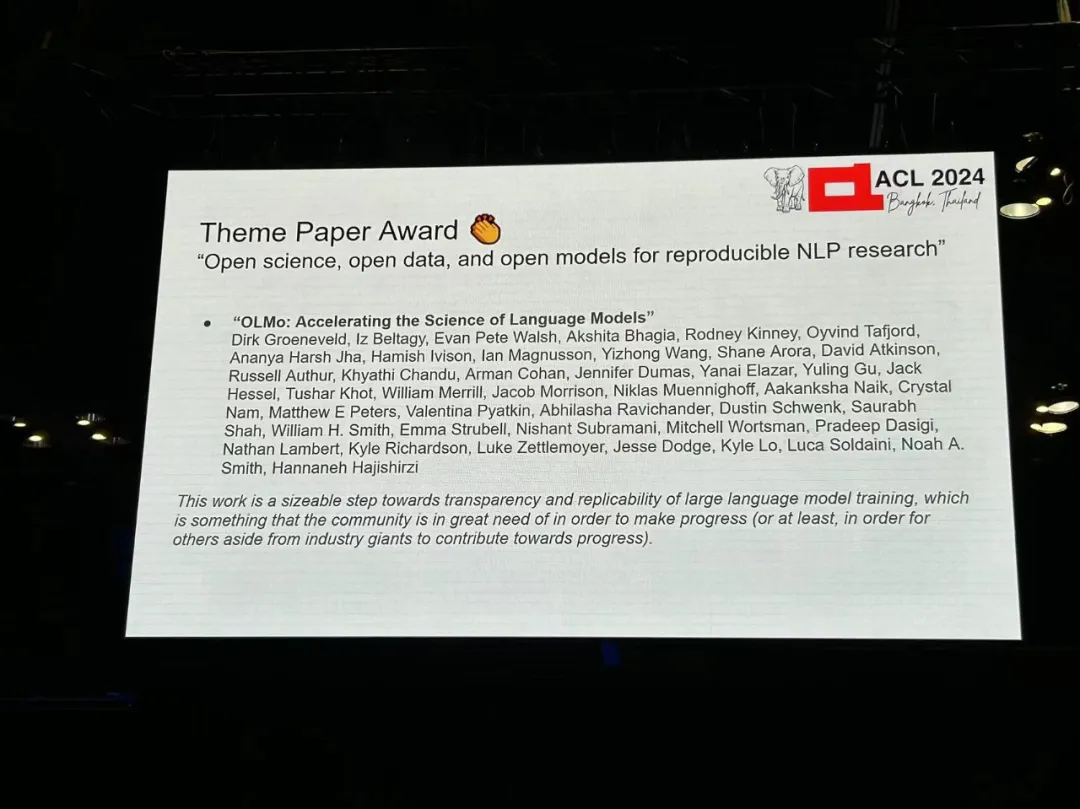

最佳主题论文奖

论文:OLMo:Accelerating the Science of Language Models

- 作者:Dirk Groeneveld 、 Iz Beltagy 等

- 机构:艾伦人工智能研究院、华盛顿大学等

- 论文链接:https://arxiv.org/pdf/2402.00838

获奖理由:这项工作是朝着大型语言模型训练的透明性和可重复性迈出的重要一步,这是社区在取得进展(或至少为了让非行业巨头的其他研究者也能贡献进展)方面急需的。

资源论文奖

3 篇论文获得 Resource Paper Award。

论文 1:Latxa: An Open Language Model and Evaluation Suite for Basque

机构:西班牙巴斯克大学

- 作者:Julen Etxaniz、Oscar Sainz、Naiara Perez、Itziar Aldabe、German Rigau、Eneko Agirre、Aitor Ormazabal、Mikel Artetxe、Aitor Soroa

- 链接:https://arxiv.org/pdf/2403.20266

获奖理由:该论文细致描述了语料收集、数据集评估的细节。尽管是巴斯克语言相关研究,这一方法论可扩展到其他低资源语言大模型的构建上。

论文 2:Dolma: an Open Corpus of Three Trillion Tokens for Language Model Pretraining Research

- 机构:艾伦人工智能研究院、加州伯克利大学等

- 作者:Luca Soldaini、Rodney Kinney 等

- 链接:https://arxiv.org/abs/2402.00159

获奖理由:该论文展示了训练大语言模型准备数据集时数据管理的重要性。这为社区内广大人群提供了非常有价值的洞见。

论文 3:AppWorld: A Controllable World of Apps and People for Benchmarking Interactive Coding Agents

- 机构:纽约州立大学石溪分校、艾伦人工智能研究院等

- 作者:Harsh Trivedi, Tushar Khot 等

- 链接:https://arxiv.org/abs/2407.18901

获奖理由:该研究是构建交互环境模拟与评估方面非常重要、惊艳的工作。它将鼓励大家为社区多多产出硬核动态基准。

社会影响力奖

3 篇论文获得 Social Impact Award。

论文 1:How Johnny Can Persuade LLMs to Jailbreak Them: Rethinking Persuasion to Challenge AI Safety by Humanizing LLMs

- 作者:Yi Zeng, Hongpeng Lin, Jingwen Zhang, Diyi Yang等

- 机构:弗吉尼亚理工大学、中国人民大学、加州大学戴维斯分校、斯坦福大学

- 论文链接:https://arxiv.org/pdf/2401.06373

获奖理由:本文探讨了 AI 安全主题 —— 越狱,研究了社会科学研究领域内开发的一种方法。该研究非常有趣,并有可能对社区产生重大影响。

论文 2:DIALECTBENCH: A NLP Benchmark for Dialects, Varieties, and Closely-Related Languages

- 作者:Fahim Faisal, Orevaoghene Ahia, Aarohi Srivastava, Kabir Ahuja 等

- 机构:乔治梅森大学、华盛顿大学、圣母大学、 RC Athena

- 论文链接:https://arxiv.org/pdf/2403.11009

获奖理由:方言变异是 NLP 和人工智能领域未能得到充分研究的现象。然而,从语言和社会的角度来看,它的研究具有极高的价值,对应用也有重要的影响。本文提出了一个非常新颖的基准来研究 LLM 时代的这个问题。

论文 3:Having Beer after Prayer? Measuring Cultural Bias in Large LanguageModels

- 作者:Tarek Naous, Michael J. Ryan, Alan Ritter, Wei Xu

- 机构:佐治亚理工学院

- 论文链接:https://arxiv.org/pdf/2305.14456

获奖理由:本文展示了 LLM 时代的一个重要问题:文化偏见。本文研究了阿拉伯文化和语言环境,结果表明,在设计 LLM 时,我们需要考虑文化差异。因此,同样的研究可以复制到其他文化中,以概括和评估其他文化是否也受到这个问题的影响。

文章来源于“机器之心”