神经元和网络的内部和外部复杂性。来源:《自然计算科学》(2024 年)。DOI:10.1038/s43588-024-00674-9

当前,人工智能(AI)的发展已取得巨大进展,特别是在深度学习领域,通过规模化方法不断提升模型能力。然而,随着模型规模的扩大,计算资源消耗和能源需求也在急剧增长,使这一路径的可持续性和实际应用面临挑战。为解决这些问题,我国科学家团队提出了一种基于大脑启发的新型网络模型,该模型通过引入“内部复杂性”的概念,为实现通用智能提供了全新的路径。

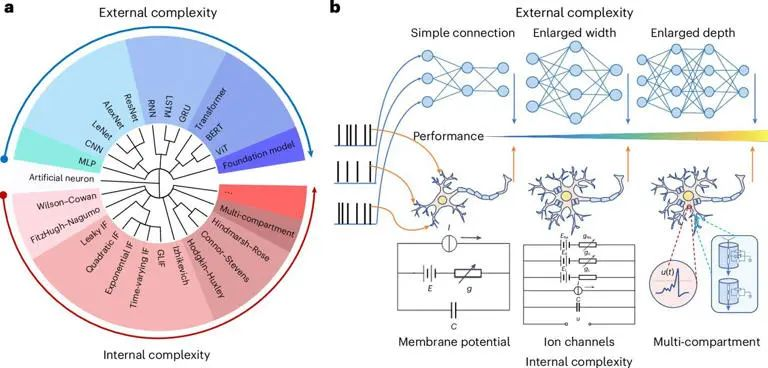

在现阶段的人工智能研究中,构建通用智能被认为是关键目标。大多数深度学习模型遵循“外部复杂性”的思路,即通过增加神经网络的层数、宽度和深度来提升模型的认知能力。这种方法在过去几年中取得了显著成就,但其局限性也逐渐显现出来。首先,随着模型规模的增长,计算资源需求与能耗的矛盾愈发突出。训练一个拥有数百亿参数的大型模型不仅需要庞大的计算资源,还伴随着高昂的能源成本。例如,训练一个类似GPT-4的大型语言模型可能产生数百吨的二氧化碳排放,相当于数百万辆汽车的年排放量。这使得大规模模型的可持续发展问题成为研究焦点。

其次,现有大规模模型在解释性和可控性方面存在显著不足。尽管这些模型在任务适应性方面表现出色,但其内部运行机制仍然是一个“黑箱”,难以解释其决策过程中的推理逻辑。这种缺乏透明性和解释性的特点在实际应用中可能导致不可预见的风险,尤其是在医疗、自动驾驶等需要高度可靠性的领域。

与基于外部复杂性的传统方法不同,最新研究试图从大脑的内部结构中汲取灵感。人脑由约1000亿个神经元和近1000万亿个突触连接组成,但其功耗却仅为20瓦左右,这与当前的大型AI模型形成了鲜明对比。科学家们发现,大脑神经元并不仅仅依靠数量庞大的连接来处理信息,其内部结构也具有高度复杂的动态特性,这种内部复杂性可能正是人类大脑高效处理多任务的关键。

基于这一启发,由自动化研究所、清华大学、北京大学等多家科研机构组成的研究团队提出了一种以“内部复杂性”为核心的类脑网络模型。该模型旨在通过模拟神经元的内部复杂性来实现更高效、更通用的智能处理。

研究团队在实验中验证了这一类脑网络模型的有效性与稳定性。他们设计了多个复杂任务来测试模型在不同情境下的表现,结果显示,基于内部复杂性的模型在处理多任务和动态环境时的表现显著优于传统基于外部复杂性的神经网络。这一发现不仅为将神经科学的动态特性引入人工智能提供了理论支持,也为提升AI模型的实际应用性能提供了全新思路。尤其在能源效率和资源利用方面,类脑网络模型展现出巨大的优势,有望缓解当前大模型所面临的能耗瓶颈问题。

此外,这一研究成果为人工智能的可解释性和透明性提供了潜在解决方案。由于模型的核心机制基于神经元内部的动态特性,其运行过程相对容易解释,从而在未来的实际应用中更具安全性和可控性。

这一研究为通用人工智能的发展指明了一条新路径,即通过大脑启发的内部复杂性来替代传统的规模化扩展。这一方法不仅在资源消耗和能效方面展现出优势,也为解决现有模型的可解释性难题提供了可能。未来,随着类脑网络模型的进一步优化和应用推广,人工智能有望在多任务处理、动态适应性及可持续发展等方面实现新的突破,为真正的通用智能打下坚实基础。

正如研究团队成员李国旗所说:“内部复杂性不仅为我们提供了一种新的智能实现途径,也为人类探索大脑奥秘和人工智能之间的联系开辟了更广阔的研究空间。”

文章来源于“ OpenSNN”,作者“ OpenSNN”