像挖币一样挖激活函数?DeepMind搭建「算力矿场」,暴力搜出下一代ReLU

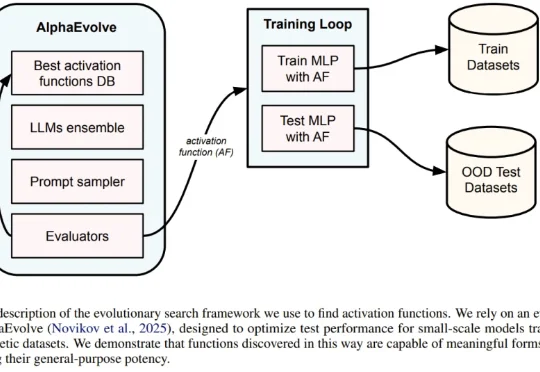

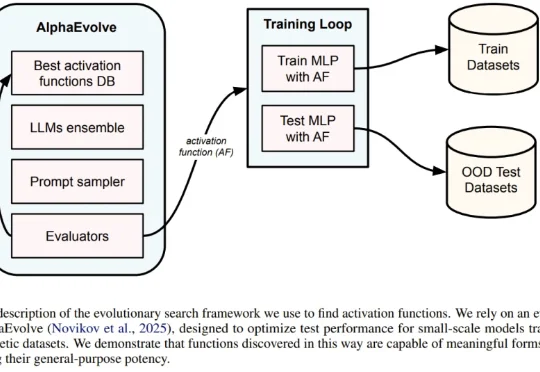

像挖币一样挖激活函数?DeepMind搭建「算力矿场」,暴力搜出下一代ReLU一直以来,神经网络的激活函数就像是 AI 引擎中的火花塞。从早期的 Sigmoid、Tanh,到后来统治业界的 ReLU,再到近年来的 GELU 和 Swish,每一次激活函数的演进都伴随着模型性能的提升。但长期以来,寻找最佳激活函数往往依赖于人类直觉或有限的搜索空间。

一直以来,神经网络的激活函数就像是 AI 引擎中的火花塞。从早期的 Sigmoid、Tanh,到后来统治业界的 ReLU,再到近年来的 GELU 和 Swish,每一次激活函数的演进都伴随着模型性能的提升。但长期以来,寻找最佳激活函数往往依赖于人类直觉或有限的搜索空间。

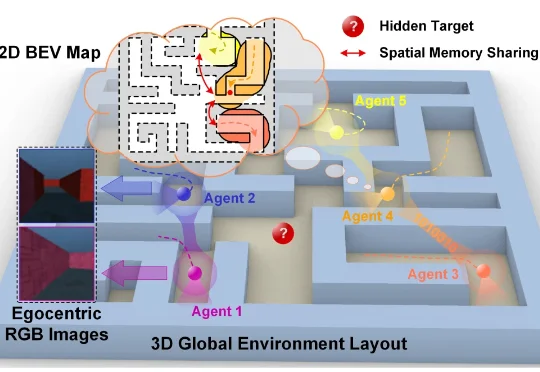

近日,香港城市大学博士生方政儒和所在团队让一群智能体在虚拟迷宫里共同探索,只给它们一个极其简单的目标——那就是学会预测同伴下一秒会看到什么以及会走到哪里。结果发现这些智能体不仅学会了高效合作,还在自己的“大脑”里自发形成了类似动物大脑中的“地图细胞”,甚至发明了一套只有它们才懂的秘密语言。

美国机器人界掌管demo的神,Figure,冷不丁又出一拳!

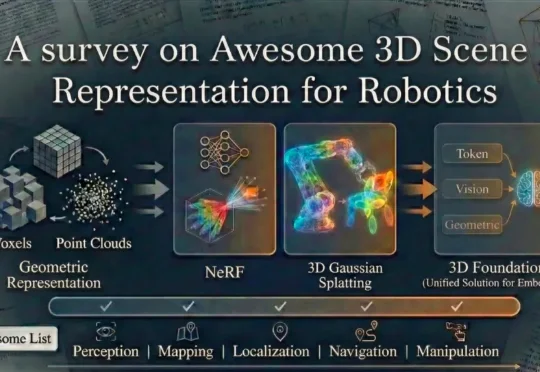

上海交通大学、波恩大学等院校的研究团队全面总结了当前机器人技术中常用的场景表示方法。这些方法包括传统的点云、体素栅格、符号距离函数以及场景图等传统几何表示方式,同时也涵盖了最新的神经网络表示技术,如神经辐射场、3D 高斯散布模型以及新兴的 3D 基础模型。

爆火神经网络架构KAN一作,毕业新去向已获清华官网认证: 刘子鸣,拟于今年9月加入清华大学人工智能学院,任助理教授。

脉冲神经网络(SNN)不用再纠结二进制短板了。

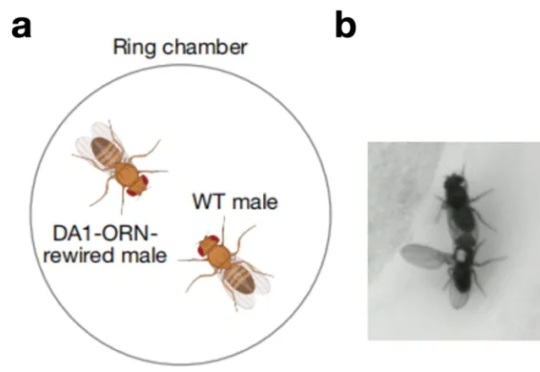

一只原本对同伴毫无兴趣的雄性果蝇,会不会突然开始疯狂地向其他雄性求爱。这看起来有点荒诞不羁的场景,发生在了北京大学校友、美国斯坦福大学骆利群课题组博士后、即将于 2026 年回国入职西湖大学的吕程的实

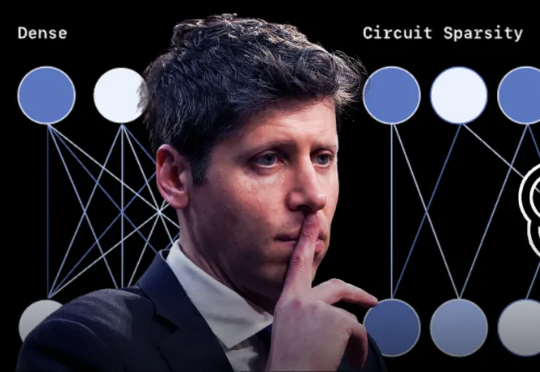

刚刚,在理解大模型复杂行为的道路上,OpenAI又迈出了关键一步。他们从自己训练出来的稀疏模型里,发现存在结构小而清晰、既可理解又能完成任务的电路(这里的电路,指神经网络内部一组协同工作的特征与连接模式,是AI可解释性研究的一个术语)。

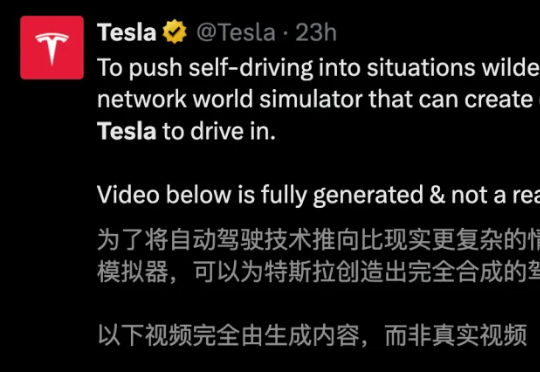

马斯克的终极设想,正在成形。今天,特斯拉放出了「世界模拟器」震撼演示。一个神经网络,每天狂吞500年人类驾驶经验,并在无限的虚拟世界中自我进化。同款AI大脑,擎天柱也可共用。

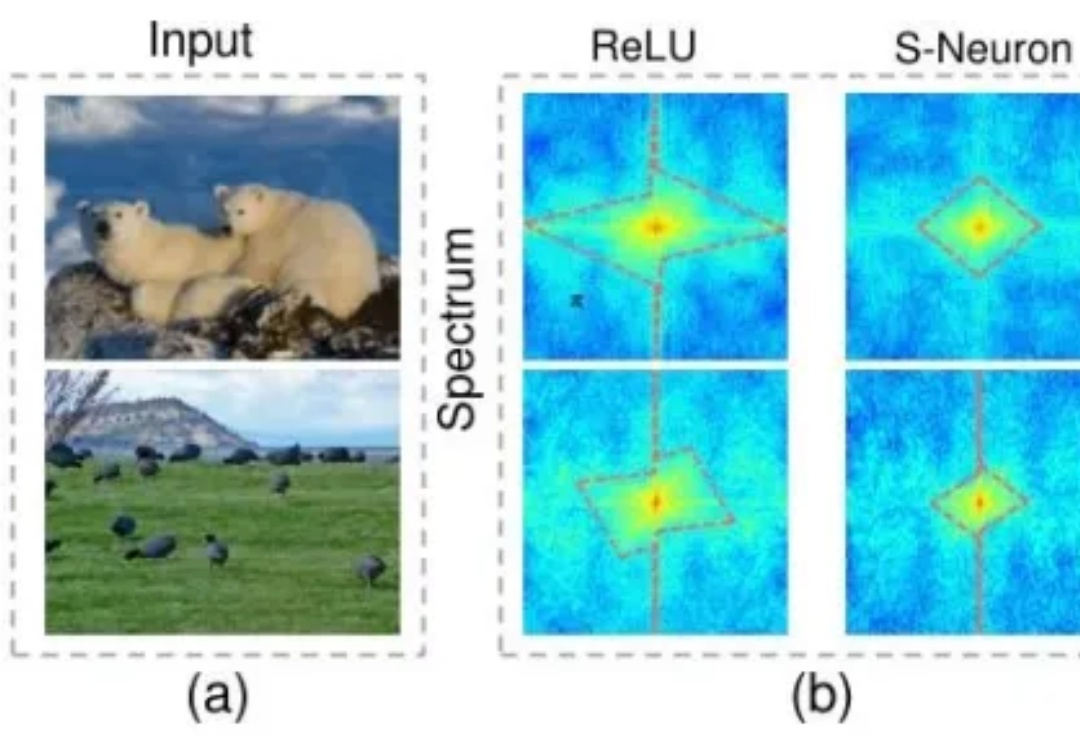

近日,范鹤鹤(浙江大学)、杨易(浙江大学)、Mohan Kankanhalli(新加坡国立大学)和吴飞(浙江大学)四位老师提出了一种具有划时代意义的神经网络基础操作——Translution。 该研究认为,神经网络对某种类型数据建模的本质是: