Karpathy泼冷水:AGI要等10年!根本没有「智能体元年」

Karpathy泼冷水:AGI要等10年!根本没有「智能体元年」在近日的一次访谈中,Andrej Karpathy深入探讨了AGI、智能体与AI未来十年的走向。他认为当前的「智能体」仍处早期阶段,强化学习虽不完美,却是目前的最优解。他预测未来10年的AI架构仍然可能是类似Transformer的巨大神经网络。

在近日的一次访谈中,Andrej Karpathy深入探讨了AGI、智能体与AI未来十年的走向。他认为当前的「智能体」仍处早期阶段,强化学习虽不完美,却是目前的最优解。他预测未来10年的AI架构仍然可能是类似Transformer的巨大神经网络。

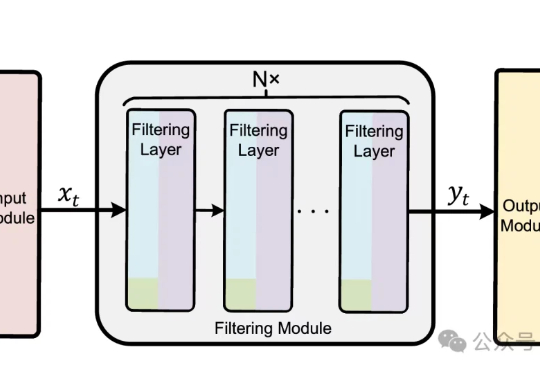

在机器人与自动驾驶领域,由强化学习训练的控制策略普遍存在控制动作不平滑的问题。这种高频的动作震荡不仅会加剧硬件磨损、导致系统过热,更会在真实世界的复杂扰动下引发系统失稳,是阻碍强化学习走向现实应用的关键挑战。

在通往AGI的道路上,人类欠缺的是一种合适的编程语言?华盛顿大学计算机学院教授Pedro Domingos在最新的独作论文中表示,当前AI领域使用的编程语言,无一例外全都存在缺陷。同时,Domingos还提出了一种新的统一语言,将AI逻辑统一成了张量表示。

吴恩达 (Andrew Ng) 执教的斯坦福 CS230 深度学习旗舰课程已更新至 2025 秋季版,首讲视频现已公开!课程采用翻转课堂模式,学生需提前观看 Coursera 上的 deeplearning.ai 专项课程视频(包括神经网络基础、超参数调优、结构化机器学习项目等模块),然后参加线下课程。

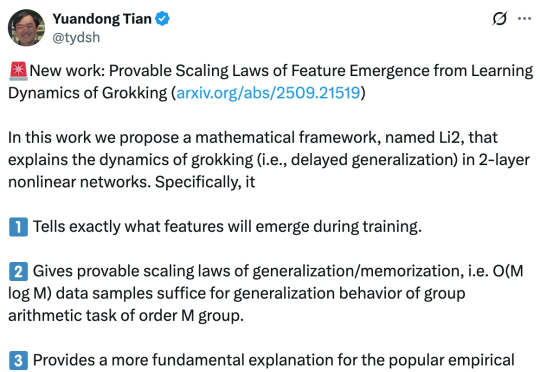

早在 2021 年,研究人员就已经发现了深度神经网络常常表现出一种令人困惑的现象,模型在早期训练阶段对训练数据的记忆能力较弱,但随着持续训练,在某一个时间点,会突然从记忆转向强泛化。

HTEC团队利用英飞凌的PSoC Edge处理器,研究探讨了如何使用深度神经网络 (DNN) 预测 DC-DC 转换器的最佳占空比,重点在于识别最相关的输入特征,以提高性能和可靠性。

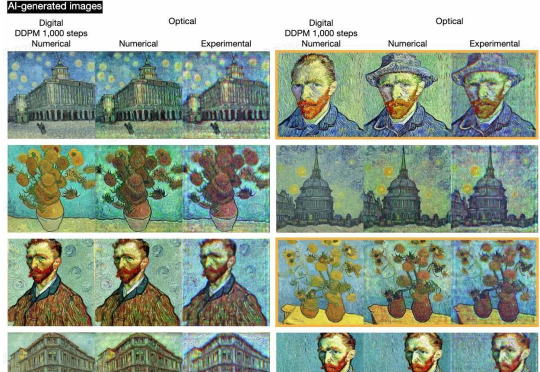

今天,AI 行业发展更进一步,将“光”引入 AIGC 领域,完全基于系统硬件物理定律,首次实现了具备特定特征的全新(未见过的)图像生成。来自加州大学洛杉矶分校的研究团队成功实现了手写数字、时尚产品、蝴蝶、人脸及艺术品(如梵高风格)的单色与多色图像光学生成,且整体性能媲美基于数字神经网络的生成式模型。

刚刚,AI界传奇Jeff Dean深度访谈重磅放出!作为谷歌大脑奠基人、TensorFlow与TPU背后的关键推手,他亲述了这场神经网络革命的非凡历程。

Yann LeCun的AI故事,纪录片回顾了这位深度学习先驱的四十年历程。从索邦大学的孤独探索,到贝尔实验室发明卷积神经网络、推动支票识别商用,再与Hinton、Bengio共创深度学习革命,他始终坚信机器应学会学习。

Figure人形机器人首秀,靠神经网络叠衣服! 在没有任何架构改变、仅增加了数据的情况下,就让原本在物流场景干活的它,轻松习得了新技能。