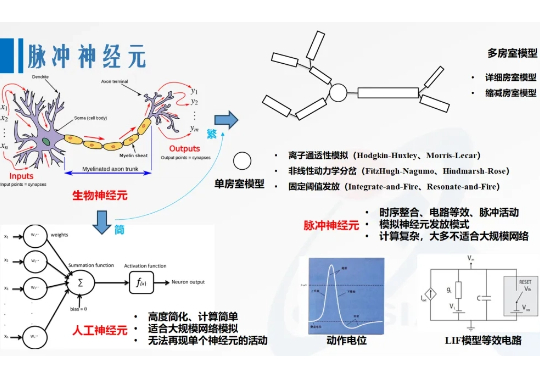

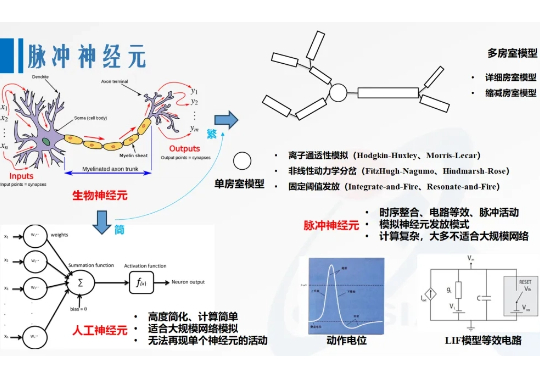

第三代神经网络模型:面向AI应用的脉冲神经网络

第三代神经网络模型:面向AI应用的脉冲神经网络1997年,Wolfgang Maass于Networks of spiking neurons: The third generation of neural network models一文中提出,由脉冲神经元构成的网络——脉冲神经网络(SNN),能够展现出更强大的计算特性,会成为继人工神经网络后的“第三代神经网络模型”[6]。

1997年,Wolfgang Maass于Networks of spiking neurons: The third generation of neural network models一文中提出,由脉冲神经元构成的网络——脉冲神经网络(SNN),能够展现出更强大的计算特性,会成为继人工神经网络后的“第三代神经网络模型”[6]。

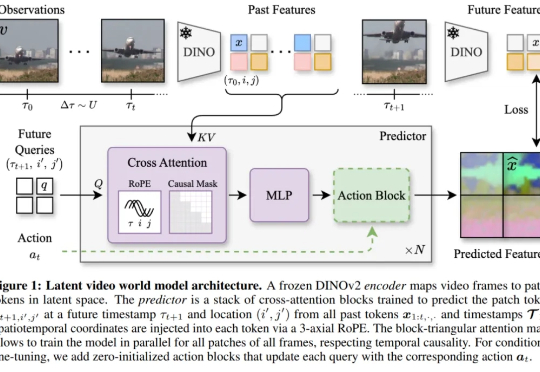

2018 年,LSTM 之父 Jürgen Schmidhuber 在论文中( Recurrent world models facilitate policy evolution )推广了世界模型(world model)的概念,这是一种神经网络,它能够根据智能体过去的观察与动作,预测环境的未来状态。

持续适应性学习,即指适应环境并提升表现的能力,是自然智能与人工智能共有的关键特征。大脑达成这一目标的核心机制在于神经递质调控(例如多巴胺DA、乙酰胆碱ACh、肾上腺素)通过设置大脑全局变量来有效防止灾难性遗忘,这一机制有望增强人工神经网络在持续学习场景中的鲁棒性。本文将概述该领域的进展,进而详述两项6月Nature发表的背靠背相关研究。

疯狂,太疯狂了~ 大神卡帕西预测的「下一代GUI系统」这就水灵灵地实现了?!

以神经网络为核心引擎,让AI承担雷达仿真数据生成任务,还实现对雷达物理特性的建模与控制——

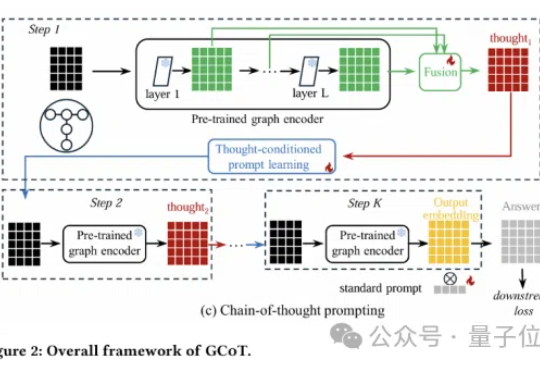

图神经网络还能更聪明?思维链提示学习来了!

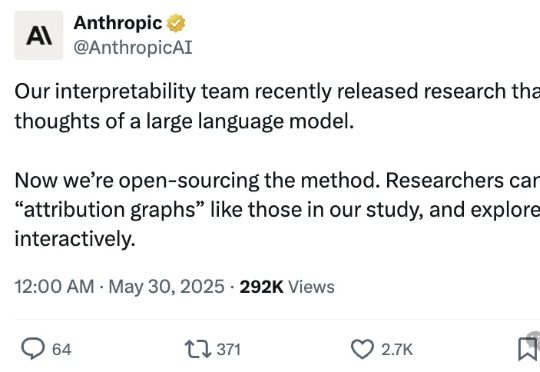

Claude团队来搞开源了——推出“电路追踪”(circuit tracing)工具,可以帮大伙儿读懂大模型的“脑回路”,追踪其思维过程。该工具的核心在于生成归因图(attribution graphs),其作用类似于大脑的神经网络示意图,通过可视化模型内部超节点及其连接关系,呈现LLM处理信息的路径。

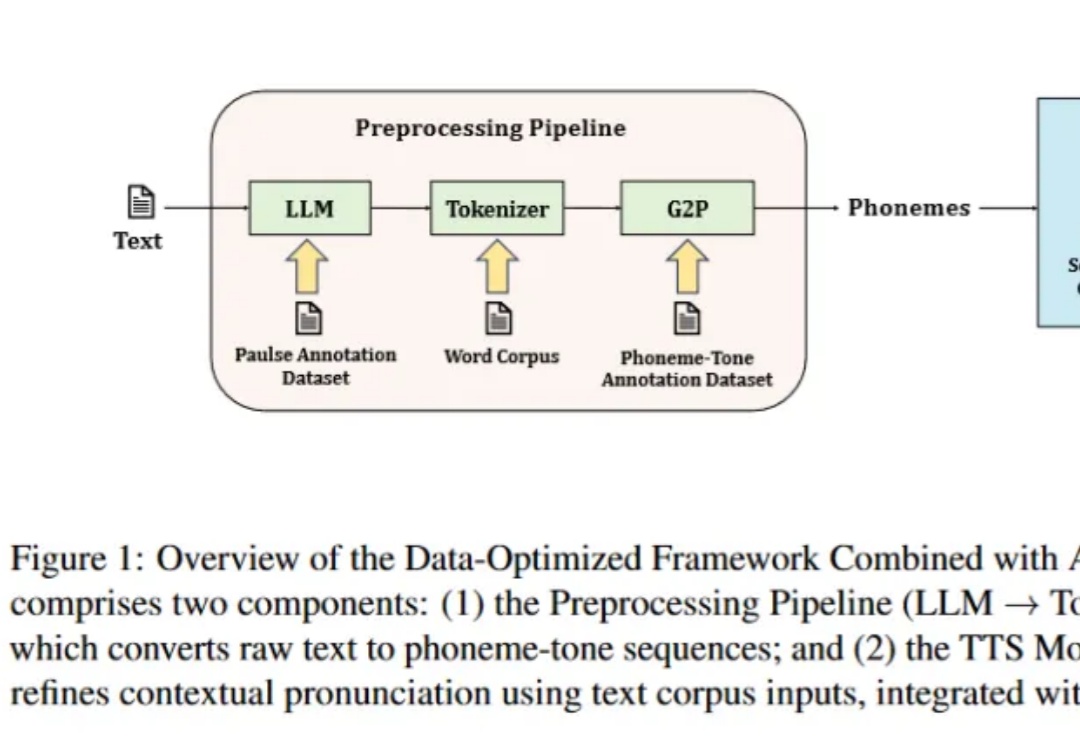

语音合成(TTS)技术近十年来突飞猛进,从早期的拼接式合成和统计参数模型,发展到如今的深度神经网络与扩散、GAN 等先进架构,实现了接近真人的自然度与情感表达,广泛赋能智能助手、无障碍阅读、沉浸式娱乐等场景。

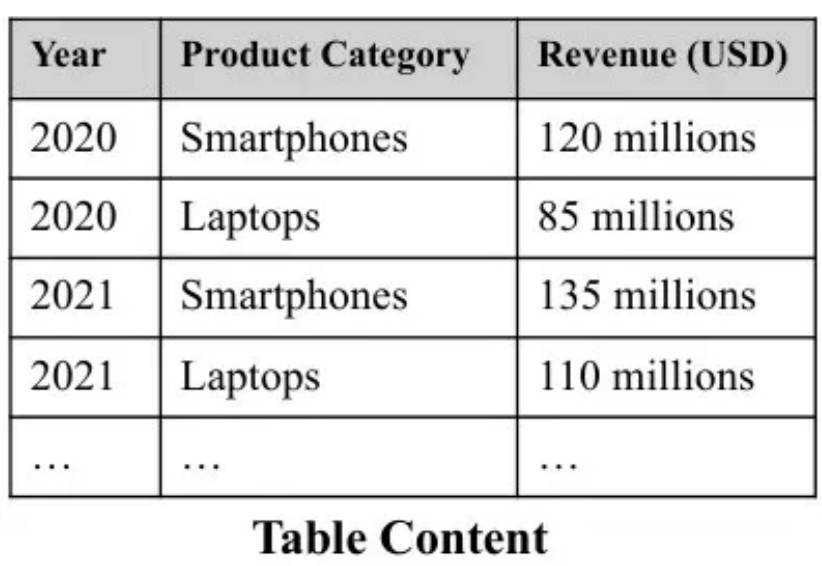

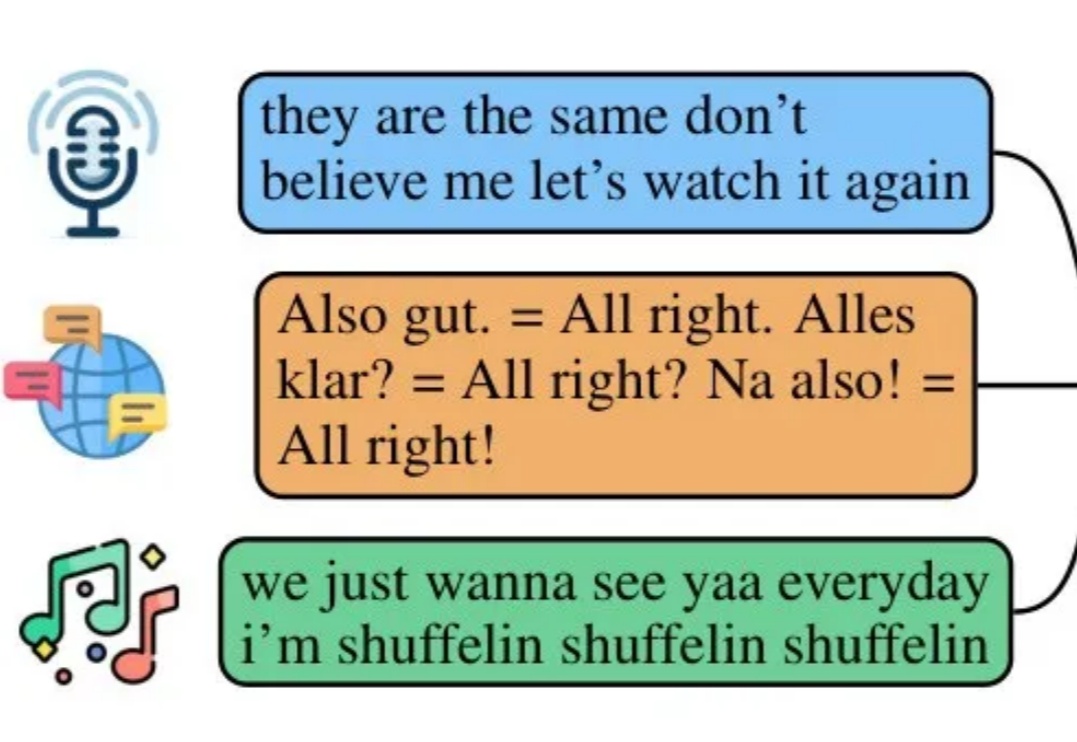

在上一篇文章中,我为大家介绍了SAT如何通过神经网络驱动的智能分段技术,解决传统文本处理中的语义割裂问题。今天,我将继续与您探讨SAT如何与Pneuma系统融合,开创表格数据检索与表示的新范式。

搞RAG开发,一个被普遍忽视却又至关重要的痛点是:如何避免Token分块带来的语义割裂问题。SAT模型通过神经网络驱动的智能分段技术,巧妙解决了这一难题。它不是RAG的替代,而是RAG的强力前置增强层,通过确保每个文本块的语义完整性,显著降低下游生成的幻觉风险。