由AI生成的内容渐渐充斥了互联网。

现在的人们比起直接与AI进行对话,更多的是在阅读和浏览AI生成的文本。

而经典的图灵测试赋予了评判者一个关键优势:他们可以实时调整问题,以对参与者进行对抗性测试。

但这在被动消费AI生成文本时并不总是存在。

因此,来自加州大学圣地亚哥分校的研究者提出,我们需要在更接近现实的环境中,开展图灵测试的变体,以确定人们在现实场景中区分人类和AI的效果。

论文地址:https://arxiv.org/pdf/2407.08853

并进一步理清以下问题:

人类是否能够仅通过观察对话来可靠地区分人类与AI?

LLM是否可以作为AI检测器,不仅适用于静态文本(如文章和段落),还适用于动态对话?

错位图灵测试会提高还是降低准确性?

反向图灵测试能否揭示人工系统中的朴素心理学?

以及在现实世界的对话环境中,哪些方法最适合进行AI检测?

这项研究将通过两种图灵测试的变体——「反向图灵测试」(inverted Turing test)和「错位图灵测试」(displaced Turing test),来测量人类和大语言模型在这种区分上的表现。

其中,GPT-3.5、GPT-4,以及作为评判者的人类基于图灵测试的对话记录判断参与者是人类还是AI。

在经典的图灵测试中,一位人类评判者与两位参与者进行纯文本对话,其中一位是人类,另一位是机器。

如果评判者无法准确区分人类和计算机,那么计算机就通过了测试,可被视为智能体。

自图灵的原始论文发表以来,图灵测试掀起了激烈的辩论,对现代智能概念的理解和构建起到了关键作用。

但另一方面,它作为智能测试的有效性或充分性也受到了广泛质疑。

可不论其作为智能测试的有效性如何,图灵测试仍然是评估人类和AI写作相似性的重要手段,也是研究AI欺骗行为的有力工具。

多年来,已有多个通过图灵测试的尝试,包括1990年至2020年间的Loebner奖竞赛,但没有任何系统通过该测试。

「HumanorNot」是一个大规模的社会图灵测试实验,发现评判者的准确率为60%;2024年的一项研究报告了第一个通过率与随机水平(54%)无统计学差异但仍低于人类标准(67%)的系统。

图灵测试存在多种变体,每种变体都为理论和实践提供了不同的视角。

反向图灵测试,即让AI系统担任评判者的角色。

1996年,Watt提出了反向测试作为一种「朴素心理学」的测量方法,即人类天生具有识别与自身相似的智能并将其归因于其他心智的倾向。

如果AI系统「无法区分两个真人,或无法区分一位人类和一台通过正常图灵测试的机器,但能够区分一位人类和一台在有真人观察者的正常图灵测试中可以分辨出来的机器」,则该测试通过。

Watt认为,通过让AI充当观察者角色,并将其对不同参与者的判断与人类的准确性进行比较,可以揭示AI是否具有人类类似的朴素心理学。

错位图灵测试,即让评判者阅读由另一位人类或AI评判者先前进行的互动图灵测试的对话记录,从而评估AI的表现。

新的评判者被描述为「错位」的,因为他们「置身事外」,未曾参与和AI的互动。

这是一种新的静态图灵测试,因为判断基于预先存在且不变的、由人类或AI生成的内容。

其次,在传统图灵测试中,互动评判者可以提出动态、灵活且对抗性的问题,而静态图灵测试中的评判者只能基于对话内容进行判断,无法通过互动来深入探讨最有效的问询方向。

静态测试在评估模型能力时有一定局限性,但它们很可能反映了现实世界中的常见情况,因为许多互动是由更广泛的观众阅读的,而不仅仅是直接的对话当事人。

目前存在多种统计方法来检测AI生成的内容。这些方法主要基于大语言模型(LLM)通过对词语的概率分布进行采样生成内容的原理:

这可能会留下特定的概率特征,例如LLM生成的内容在统计概率上比人类生成的内容更可能出现。

2023年,Mitchell等人开发了一种相关指标「曲率」,它通过使用掩码语言模型生成的小扰动来衡量一段文本的局部最优性,LLM生成的内容相对于附近的扰动更可能是最优的。

2024年,Mireshghallah等人发现,较小的LLM往往是更好的检测模型,其中具有125m参数的OPT模型在检测AI生成内容时表现最佳,在检测GPT-4内容时达到了90%的准确率。

基于这些方法和其他文本分类计算方法,已经开发了各种商业工具。研究在不同环境中评估了这些方法的有效性,结果不一:虽然在某些领域中准确性较高,但模型往往不可靠,可能会产生误报。

在反向图灵测试中,GPT-3.5和GPT-4扮演裁定者的角色,评估先前图灵测试的文字记录以判断参与者是人类还是AI。

研究设定了五个假设:

1.GPT-4的准确率是否显著高于或低于人类的准确率。

2.GPT-4是否也难以准确识别参与者。

3.模型是否更倾向于将真人类判断为人类,而非将最佳的GPT-4参与者判断为人类。

4.GPT-4作为裁定者在较长的文字记录中是否会表现出更高的准确率。

5.GPT-4作为裁定者的准确率是否高于GPT-3.5。

探讨了这两个模型的识别准确性,以及对话长度和模型质量对判断的影响、以及大语言模型的质量在判断文字记录中的作用。

使用Jones和Bergen在2023年的研究中超过6000次图灵测试的文字记录。

其中,Jones和Bergen研究中的AI参与者基于以下三个模型:GPT-3.5、GPT-4和ELIZA。

并且,样本需要平衡人类和AI参与者的数量,以及表现最佳的GPT-4参与者的游戏比例与整个数据集中的比例相同。并确保表现最佳模型的人类和人工智能判决分布相同。

模型需判断参与者的类型,并指出其判决的信心程度,同时提供判断依据。

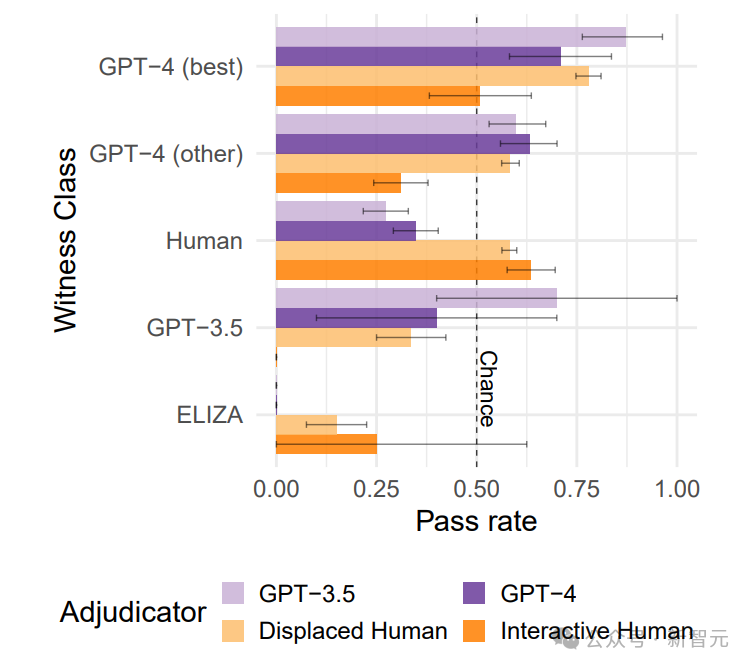

GPT-4作为裁定者的准确性显著低于互动人类裁定者,尤其是在判断表现最佳的AI参与者时,准确率低于随机水平。

文字记录长度和模型质量(GPT-4 vs GPT-3.5)对准确性没有显著影响。

在反向图灵测试中,两个AI系统作为裁定者的准确性均低于互动人类评判者,尤其是在面对表现最佳的AI参与者时,准确性更低。

AI参与者的通过率高于人类参与者,这意味着AI裁定者更容易将AI参与者误判为人类,同时将人类参与者误判为AI。

这些结果表明,当前的大语言模型在区分人类和AI生成的内容方面表现不佳——即使它们正在评估由相同大语言模型生成的内容。

对此结果的一个可能解释是,这些系统的输出受其对人类训练数据的表征所驱动。

因此,模型可能缺乏能够区分自身输出与其模仿的训练数据之间差异的细致或上下文敏感的表征。

当前的大语言模型不适合作为检测对话中AI贡献的有效工具。

错位图灵测试评估人们在无法直接与AI互动环境中,如阅读社交媒体对话来识别AI的准确性。

在这项测试中,参与者作为人类裁定者,根据文字记录样本判断参与者是否为人类或AI。

研究设定了与反向图灵测试类似的一组问题。

将相同的500份文字记录样本展示给加州大学圣迭戈分校的学生(共109人,其中84名女性,年龄范围为19至31岁),每位参与者随机接收到50份文字记录的子集。

每份记录平均由10名参与者进行判断。

参与者需要为每份记录指出他们的信心水平和判断依据。并通过使用R语言中的lmertest包拟合线性混合效应模型。

错位人类裁定者的识别准确性低于互动的人类裁定者,尤其是在识别基于GPT的AI模型时。

长度较短的文字记录似乎对裁定者更有帮助。

错位环境增加了识别大语言模型AI的挑战,阻止了参与者进行对抗性询问或观察参与者的响应时间,可能导致他们做出更快的决策或投入较少的精力。

在现实场景中,当人类裁定者无法直接审问文本内容的来源时,这些结果表明人们可能难以可靠地区分人类和AI生成的内容。

与反向图灵测试类似,表现最佳的GPT-4参与者的通过率高于人类参与者。

这表明,在阅读人类与AI模型之间的在线对话时,AI系统可能更容易被判断为人类,而真正的人类反而不易被识别。

另外,文字记录长度对准确性的负面影响似乎违反直觉:为什么较少的信息反而对裁定者更有帮助?

事实上,这种反常现象可能是由于次要混杂因素导致的,特别是在文字记录长度的确定方式上。

在原始研究中,裁定者可以选择提前结束对话,当他们确信自己在与人类或AI交流时,可能会这么做。

因此,较短的文字记录更可能包含对互动裁定者特别有帮助的信息,也可能同样帮助了错位裁定者。

错位人类实验与反向实验之间的一个关键区别在于,人类裁定者是连续完成 50 份文字记录的,而大语言模型裁定者则是逐个呈现每份记录。

研究发现,连续处理文本记录的方式可能帮助人类裁定者更好地掌握文本记录的整体趋势,并识别重复出现的AI参与者的特征,从而逐渐提高判断的准确性。

为了测试是否连续呈现记录也能提高AI裁定者的表现,研究人员进行了类似的实验,连续向GPT-4展示文本记录。

结果显示,通过这种方式,GPT-4的准确率从36.4%提高到58%,接近人类裁定者的表现。

此外,当询问GPT-4其判断策略时,GPT-4表示其策略由单纯检查语法逐渐转向评估对话的一致性、幽默和情感差异、长期上下文关联等复杂因素,显示了其在识别真实人类对话时的进步。

这表明连续的文本呈现可以增强裁定者,无论是人还是AI,对文本特征的理解和识别能力。

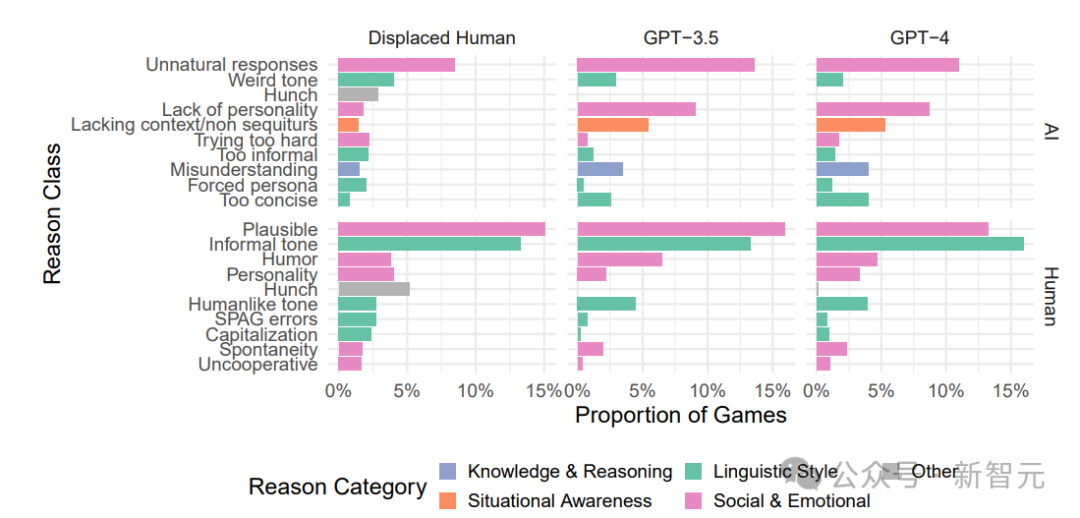

为了评估不同裁定者在评判文本记录是由人还是AI生成时依赖的决策理由,研究使用了GPT-4o模型,根据一种预设的分类方案来分析裁定者的判断理由。

这个方案由Jones和Bergen提供,旨在捕捉和分类裁定者为其决策提供的具体理由。

研究结果显示,无论是AI裁定者还是人类裁定者,他们引用的理由类型有很大的相似性。

在判断对话来自AI时,最常见的理由是对话内容显得「不自然」。

AI裁定者在判断时,更多地关注对话者是否展示出人类特有的社会情感特质,如个性的缺失。而人类裁定者的理由分布则相对更均衡,涵盖多个不同的类别。

当判断对话来自人类时,三种裁定者通常都会指出对话中的合理回应和非正式语气,同时也会关注社会情感因素和语言风格。

这表明,不论裁定者是人还是AI,在进行决策时,他们都倾向于强调对话中的相似特征,这些特征帮助他们区分人类和AI生成的内容。

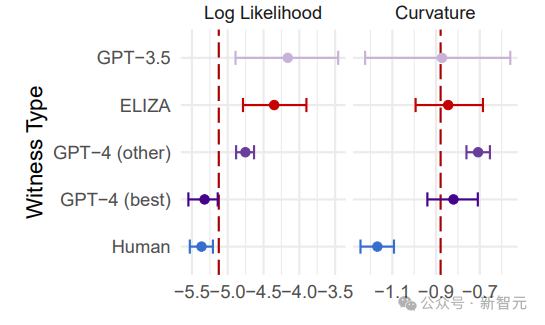

为了研究利用统计方法在图灵测试中检测AI生成的内容的有效性,研究使用了Mireshghallah等人提出的两种主要方法:一种是测量文字记录中的平均对数似然值,另一种是测量曲率。

对数似然值是指在给定前置词的情况下,计算文本内容生成的可能性;曲率则是通过比较文本与其相似内容的概率差异来进行评估。

使用OPT-125m模型进行实验,结果表明,这两种方法在区分AI和人类生成的文本方面有不同的效果。

对数似然方法得出的整体准确率为62%,而曲率方法的准确率更高,达到了69%。

曲率方法尤其有效,因为它能更好地区分人类和AI生成的文本,尤其是在处理最新和最高级的AI模型(如GPT-4)时。

这些发现表明,尽管这些统计方法提供了一种区分人类和AI文本的工具,但在处理最先进的AI模型时,它们的可靠性仍有待提高。

未来的研究需要探讨更多的统计方法,以提高在这种环境下的检测准确性。

Watt对通过反向图灵测试的标准是机器的表现应与人类评估者相当。

如果人类评估者能够区分人类和特定的AI,那么AI裁定者也应能够做到。如果人类无法区分,那么机器也应该失败。

研究中发现,GPT-4的判断准确性与错位人类裁定者相当,两者的准确率都在58%左右。

通过上下文学习(ICL),GPT-4的表现甚至提高到与人类几乎一致的水平。

然而,尽管准确率相似,GPT-4与人类裁定者的错误模式却不同,这表明两者在思维和判断过程中存在根本差异。

这些发现支持了Watt的理论,即AI的思维模型与人类裁定者的模型存在系统性的差异。

未来的研究可以通过增加互动性和系统性地修改文本记录的特征来进一步探讨人类和AI在思维方式上的不同。

这些研究有助于更好地理解AI在模拟人类心理状态方面的潜力和局限。

实际检测指的是在日常生活中常见的环境,如社交媒体和论坛,评估人和AI之间对话的真实性。

这类环境中的图灵测试通常是的,因为观察者无法直接与对话者互动来验证他们是否为AI。

研究发现,在这种环境下,无论是GPT-4还是人类裁定者,在区分AI和人类时都表现不佳,尤其是面对表现良好的AI时,这些AI往往能够比真正的人类更成功地伪装自己。

统计AI检测方法,如分析话语曲率,显示出在区分人类和AI生成消息时的潜力,ROC分析显示这种方法的准确率可以达到69%。

然而,实际应用中的误报问题可能会对真实用户产生不利影响,表明这种方法在实际场景中的限制。

研究还发现,经验的积累可能提高裁定者的判断准确性,错位人类裁定者和GPT-4在多次判断后都表现出改进的趋势。

未来的研究可以通过给予参与者反馈来探索学习效果,或者进一步探讨不同裁定工具之间的相互影响。这些发现强调了在实际环境中AI检测的复杂性和挑战。

在反向图灵测试中,GPT-3.5和GPT-4作为AI裁定者,以及错位图灵测试中的人类裁定者都参与了评判对话中某个参与者是否为人类。

但结果显示,无论是AI裁定者还是错位人类裁定者,在被动阅读的情境下,他们的准确性都低于直接互动的原始图灵测试中的裁定者。

这表明,在不进行主动互动时,无论是人类还是当前的大语言模型都难以区分二者。

参考资料:

https://arxiv.org/pdf/2407.08853

文章来自于微信公众号“新智元”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/