万众瞩目的最新模型OpenAI o1,终于迎来了lmsys竞技场的测评结果。

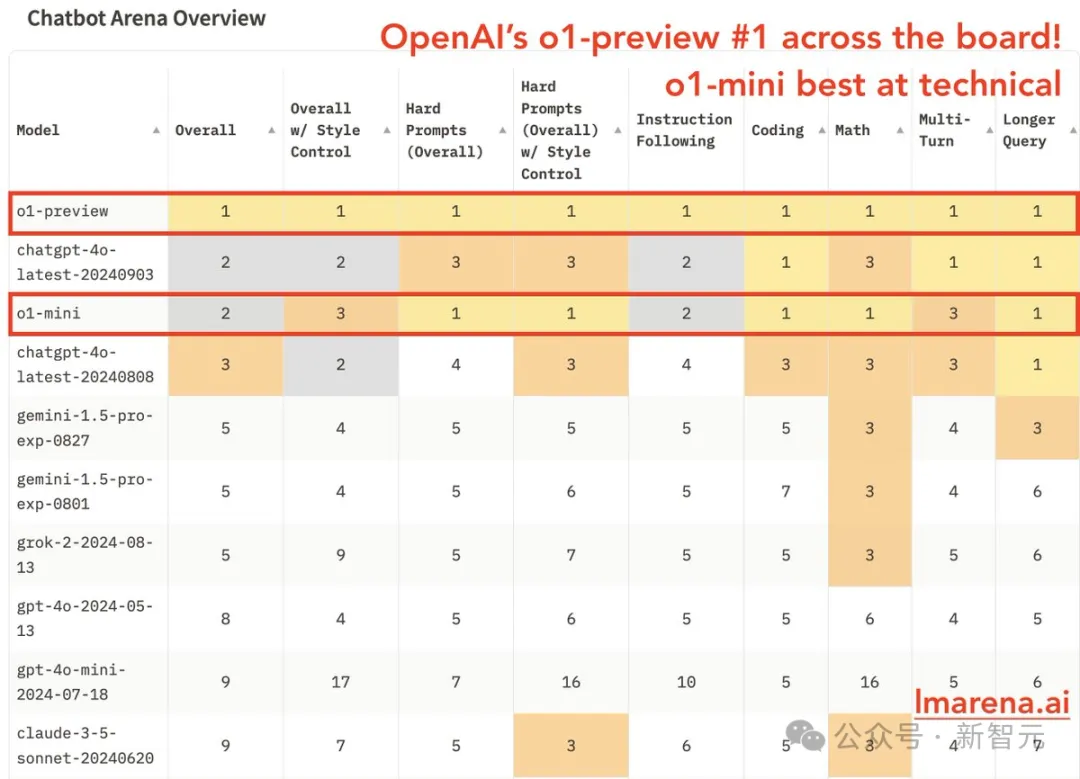

不出意外,o1-preview在各种领域绝对登顶,超过了最新版的GPT-4o,在数学、困难提示和编码领域表现出色;

而o1-mini虽然名字中自带「mini」,但也和最新版的GPT-4o并列综合排名第二,困难提示、编码、数学等领域和o1-preview同样登顶第一。

果然,o1模型不愧是通用推理领域的新王。

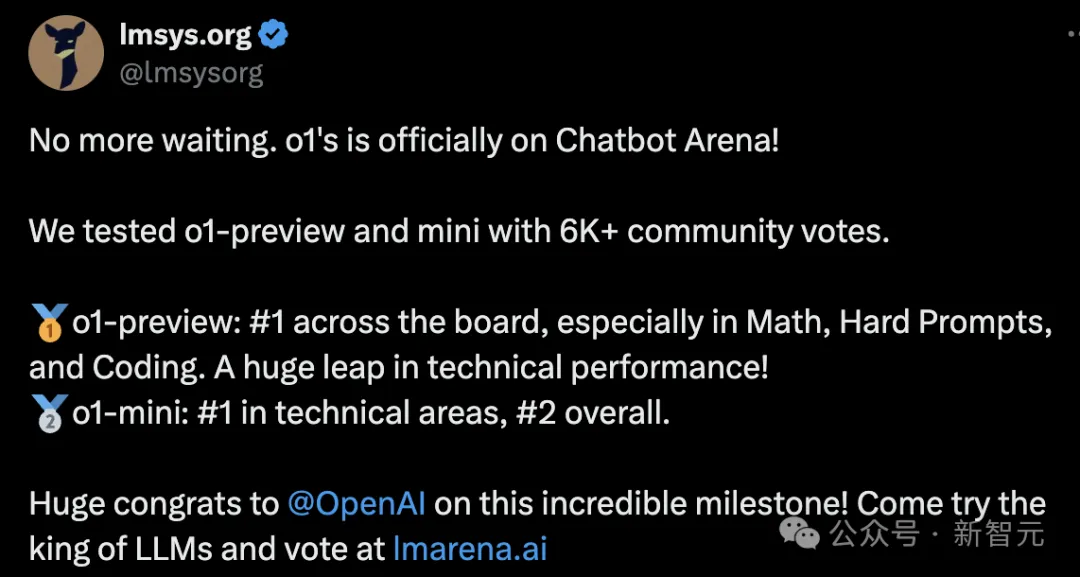

lmsys社区官方发推表示,这项测试结果收集了6k+社区投票,并将OpenAI这次取得的进展描述为「令人难以置信的里程碑」。

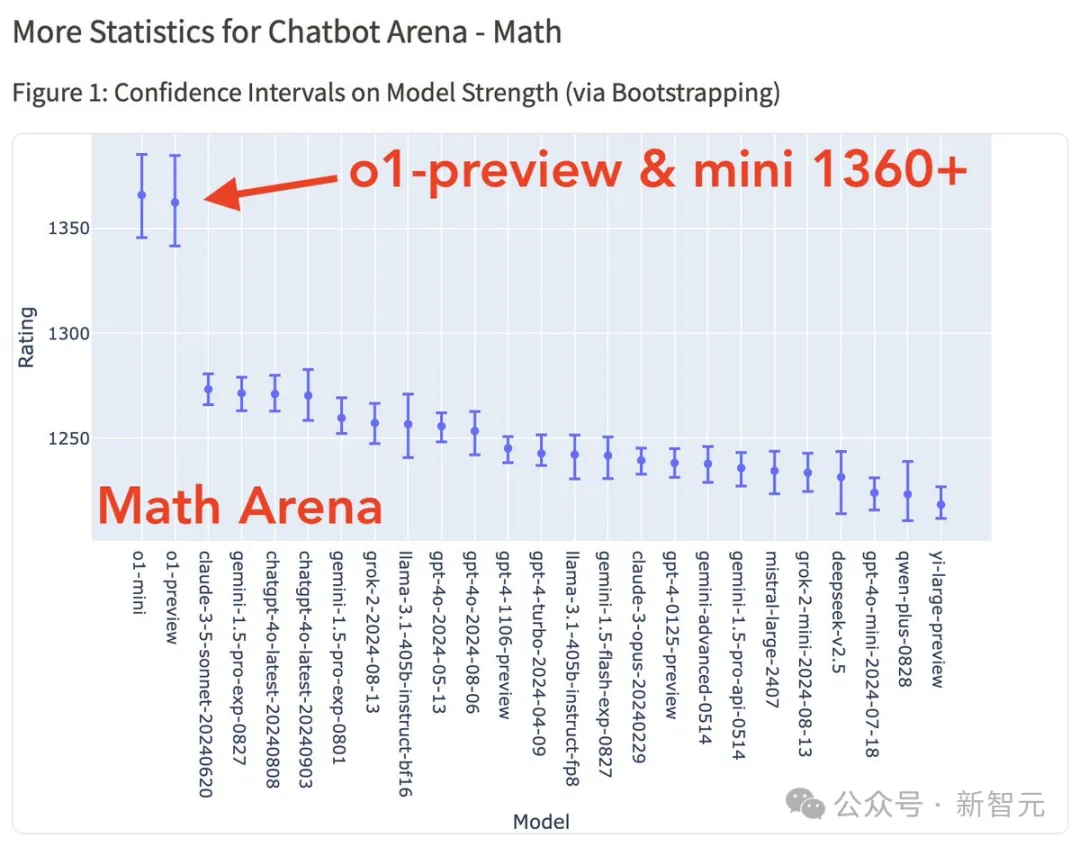

单纯看排行榜的排名可能不够具有说服力,于是lmsys特意统计了总榜上前25名模型的1v1胜率。

可以看到,o1-preview对所有模型的胜率都超过了50%,对比04-09版GPT-4-Turbo的胜率最高,达到了88%。

o1-mini如果对战o1-preview,胜率为46%,对09-03版GPT-4o的胜率为48%,可以说是大体平手、稍逊一筹的状态。

值得注意的是,虽然Grok-2-mini和Claude 3.5 Sonnet都排在比较靠后的位置,但o1-preview对这两个模型的胜率并不高,分别是58%和57%,大大小于排名第四的Gemini 1.5 Pro的69%。

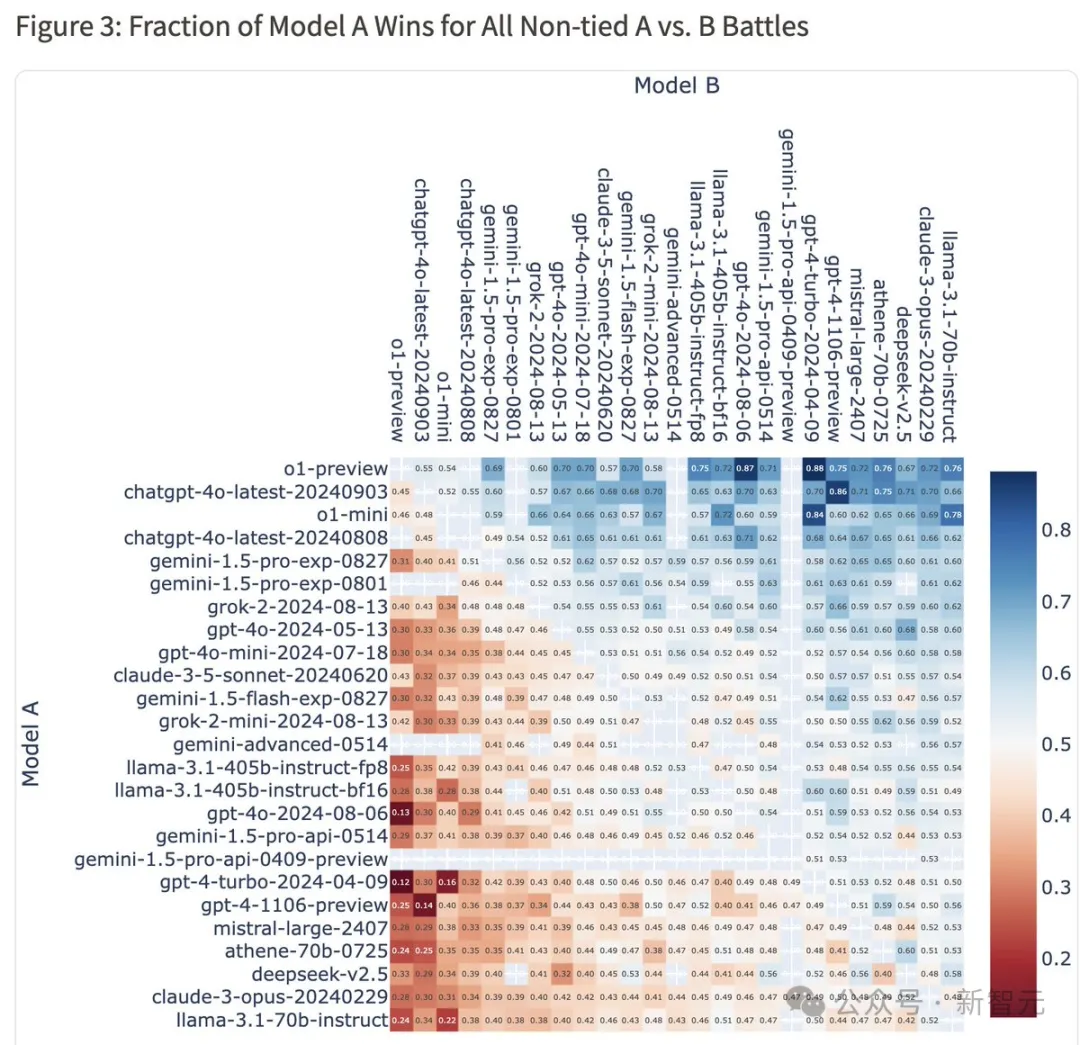

如果看到细分领域的排行榜,尤其是数学/推理领域,效果则更加惊艳。

o1-preview和o1-mini不仅是登顶数学排行榜,而且是体现出了绝对的领先优势。

排在第三、第四的Claude 3.5 Sonnet、Gemini 1.5 Pro和08-08版ChatGPT-4o的均分都在1275左右,不相上下;o1-preview和o1-mini则一骑绝尘,分数飙到1360附近,直接碾压。

o1推理团队的领导者之一William Fedus看到这张图也是相当开心,他表示这张图「很好地用视觉表达了范式转换」。

看来最新的o1模型在STEM学科和通用推理方面的确又达到了新高度,用实际测评结果回应了「AI遇冷」、「OpenAI碰壁」的质疑声。

「那就继续期待OpenAI接下来的发布吧!」

但一些人感叹「未来可期」的同时,另一些人想到了自己不多的智商和头发。

模型搞得这么好了,测试就不适合我这种蠢人了。」

同时,也有一些人表达了对lmsys排行榜结果的质疑。

比如,众所周知的o1模型推理时间长,因而回答的延时也长,和其他模型都有明显差别;而且不同于各类基准测试的客观标准,lmsys社区中完全基于用户的主观评分,难说这里面是否存在「安慰剂效应」。

也有人不服o1在编码排行榜上的第一,认为虽然o1-mini非常适合进行项目规划,但在Cursor这类编码助手中还是Claude模型的表现最佳。

排行榜的结果当然不是全部,o1模型能否继续赢得口碑,同时保持住智力水平不变蠢,还要看接下来的一段时间。

IOI金牌代码全公开

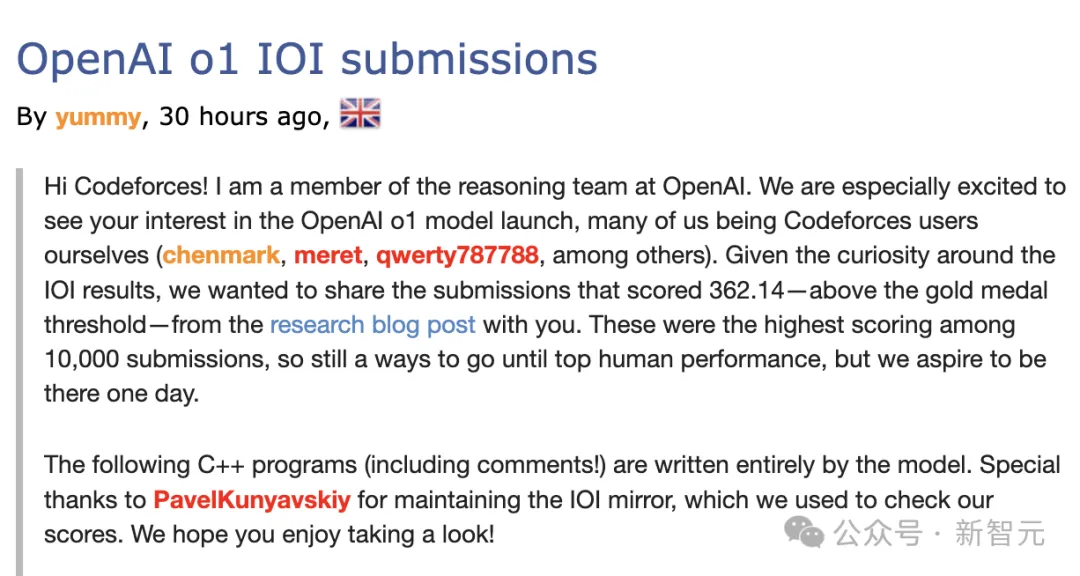

说到o1模型的编码能力,不知道你还是否记得,刚发布时OpenAI提到了这样一个指标:如果放宽提交约束到每个问题允许1万次提交,o1可以达到高于IOI金牌门槛的分数。

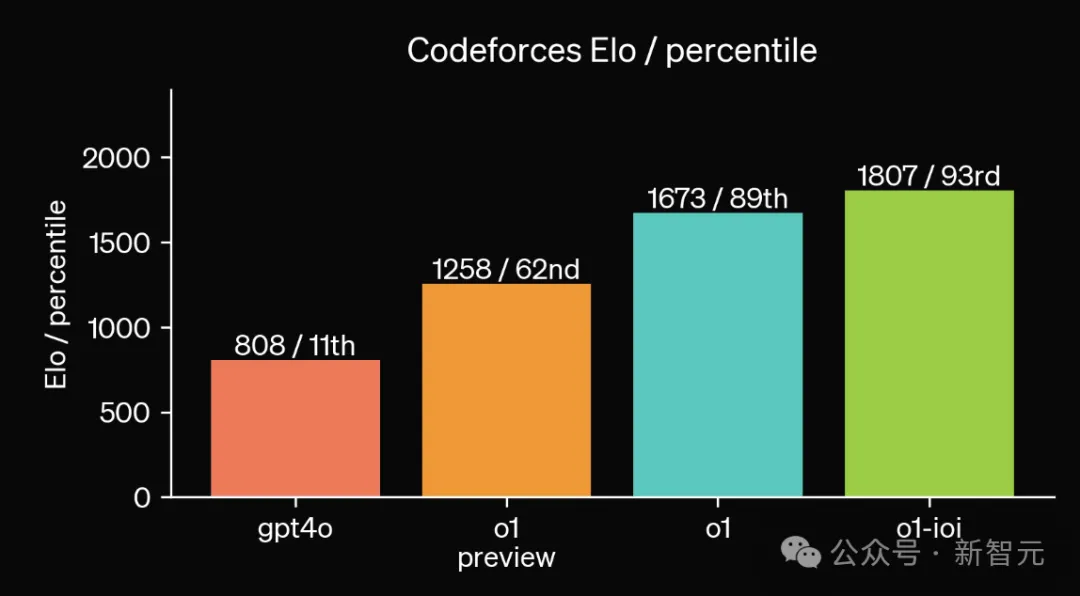

在模拟进行的Codeforces编程竞赛中,使用相同的规则进行评估,o1-preview可以打败62%的人类选手,正式版o1则上升到超越89%的对手。

专门微调过的o1-ioi模型,表现优于93%的竞争对手。

此外,前段时间有用户在实时的Codeforces比赛中使用了o1模型,结果是超越了99.8%的人类选手。

由于o1在编程竞赛领域的表现如此突出,引起了AI社区强烈的兴趣和好奇,OpenAI于是选择发布o1模型提交的代码内容,包括6个问题的全部C++代码以及注释。

发文的yummy是o1模型的核心贡献者Alexander Wei

对于o1的惊艳表现,Alexander Wei自己都很惊讶。

他本人在9年前曾参加IOI竞赛,但从未想到自己这么快就需要和AI竞争,模型展现出的推理过程的复杂程度令人印象深刻。

博文表示,虽然o1模型距离人类的顶级表现还有很长的一段路要走,但我们期待有一天能实现这个目标。

这个发展轨迹让人想起了AlphaGo——从水平高超,到能和人类顶级高手不分胜负,再到5-0完全碾压李世石。

OpenAI想要达成的,估计就是究极进化的、能在编程上碾压人类顶级高手的AlphaZero。

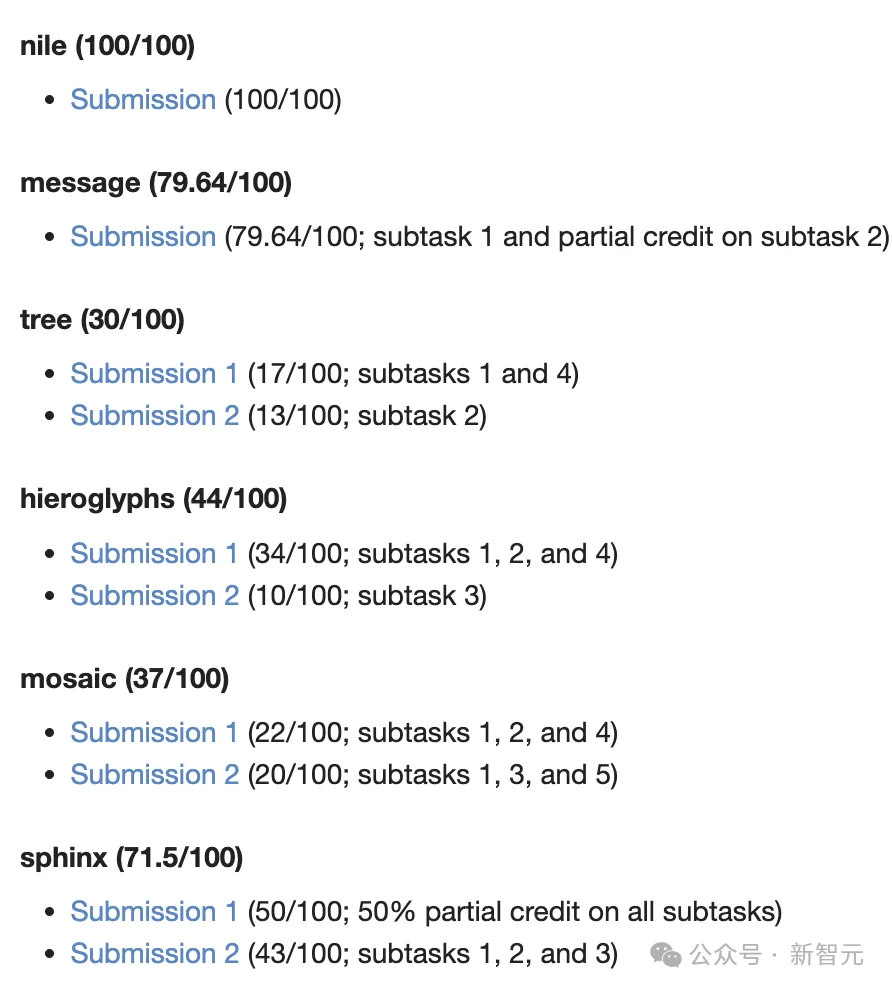

此处公布代码的6个问题具体如下:

有网友指出,其中最令人印象深刻的应该是象形文字(hieroglyphs)问题,o1模型总共得到44分,在现场的所有选手中排名第四。这表明,模型或许可以破译一些人类无法解决的子任务。

前几天,一位目前在NASA工作的天体物理学博士就尝试让o1复现自己论文中的代码,结果一试吓一跳——自己读博时花了1年写出的代码,o1只用了一小时就写完了。

这还只是裸模型,如果加上代码解释器、网络实时搜索等各种工具,效果想必更加惊艳。

而且,Reddit网友还送来了温馨提示:这只是o1预览版哦,可以狠狠期待一下不到一个月就即将问世的正式版o1了。

此外,这位网友还表示,o1基本沿用了GPT-4的架构;那你想,改换架构后的GPT-5(也就是传说中的猎户座)能达到什么高度。

文章来源于“新智元”,作者“新智元”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner