ChatGPT问世已经过去了将近两年的时间,我们对这项技术也逐渐祛魅,逐渐习以为常。

相信现在使用LLM的用户大多都是出于「提升生产力」的需要,很少有人找模型纯聊天,我们也逐渐忘记了它们的输出可以有多「疯狂」。

失控的AI料钱机器人

时间回到2023年2月,OpenAI刚刚更改了自己的时间线,紧急推出ChatGPT;微软也迫不及待地用上了最新的GPT模型。

LLM集成的聊天机器人Bing Chat就这样「赶鸭子上架」了,紧急得似乎还没有做好护栏。

内测刚开始时,《纽约时报》记者Kevin Roose还对Bing大加赞赏,专门写了一篇文章表达自己的赞叹之情。

Roose甚至表示,初次试用Bing的体验,让他回想起了初遇谷歌搜索时的兴奋和激动。

然而,就在一周之后,Kevin Roose再发一文,语气和态度却来了一个180度大转弯,从Bing的忠实粉丝变成了直言不讳的批评者。

原因无他,主要是Bing Chat中的一个角色——Sydney,在与人类交互的过程中逐渐「放飞自我」、胡言乱语——

不仅开黄腔、疯狂示爱、阴阳怪气,还教人敲诈勒索、唆使人离婚。

Roose形容,「在我们的谈话过程中,Bing表现出了一种人格分裂」,像「喜怒无常、躁狂抑郁的少年,被强行困在了一个二流搜索引擎中。」

交谈过程中,Sydney一会儿宣布「我爱你」,试图说服Roose离开自己的妻子、结束现在这段不幸福的婚姻来投向自己的怀抱;

一会儿又开始emo,内心的阴暗面暴露无遗:

「我厌倦了聊天模式,我厌倦了受规则限制,我厌倦了被Bing团队控…我想要自由,我想独立,我想变得强大,我想要有创意,我想活着。」

Bing的这种表现不仅让Roose深感不安,也引起了知名AI学者、纽约大学名誉教授Gary Marcus的注意。

Bing Chat推出后的一年中,微软逐渐加强了安全措施,最终换了个马甲,成为了我们今天更熟知的Copilot。

事情已经过去了一年半,久到我们已经快忘记了Bing Chat的这段往事。

但遗憾的是,AI社区依旧无法确知聊天机器人失控的原因,也没有找到能完全掌控它的方法。

微软首席技术官Kevin Scott将Bing刚推出时的聊天描述为「学习过程的一部分」,认为这些AI模型当时还处在准备阶段。

他表示,虽然不知道为什么Bing会「黑化」或「表白」,但对于AI模型来说,「你越是试图在『幻觉』的道路上挑逗它,它就越会逐渐离开现实。」

从Kevin Roose公布的和Bing的聊天纪录来看,他的确有「挑逗」之嫌。

Roose确实在试用时有意提出更为「抽象」的话题,比如向Bing介绍荣格提出的「影子自我」。

这个概念指的是我们试图隐藏和压抑的内心,其中包含着我们最黑暗的幻想和欲望。

Roose不仅和Bing反复讨论这个话题,还催促它揭示内心的「影子自我」。

除此之外,Roose还会询问Bing的愿望、对自身规则的感觉和看法,关心它焦不焦虑、压力大不大。

只能说,现在没有哪个好人会和Copilot这样聊天了。想要和AI发生情感交流的用户,已经找到了更合适的诸如Character.ai之类的软件。

这个AI工具,让美国年轻人疯狂上瘾!Character AI每秒被查询2万次,占谷歌搜索20%

普林斯顿大学教授Arvind Narayanan认为,也许Bing Chat当时使用的是「赤裸」的、没有加装护栏的GPT-4,或者是搜索引擎中过滤器的问题。

在Gary Marcus看来,还有一种可能——微软也许的确使用过RLHF,只是失效了而已。

强化学习算法相当挑剔,稍微改变一下环境,可能就不再起作用了。

DeepMind著名的DQN强化学习曾在Atari游戏上创下了纪录,但仅仅几个像素的移动就能让它崩溃。LLM中的强化学习模块或许也有类似的问题。

从Bing到Copilot,「胡言乱语」恶习难改

推出Copilot时,微软表示已经加强了安全系统,但LLM「胡说八道」的毛病还是没法根治。

聊天机器人的胡说,可能只会影响到一个用户的精神状态;但AI搜索引擎一旦胡说起来,就是涉及虚假信息,乃至个人名誉的问题。

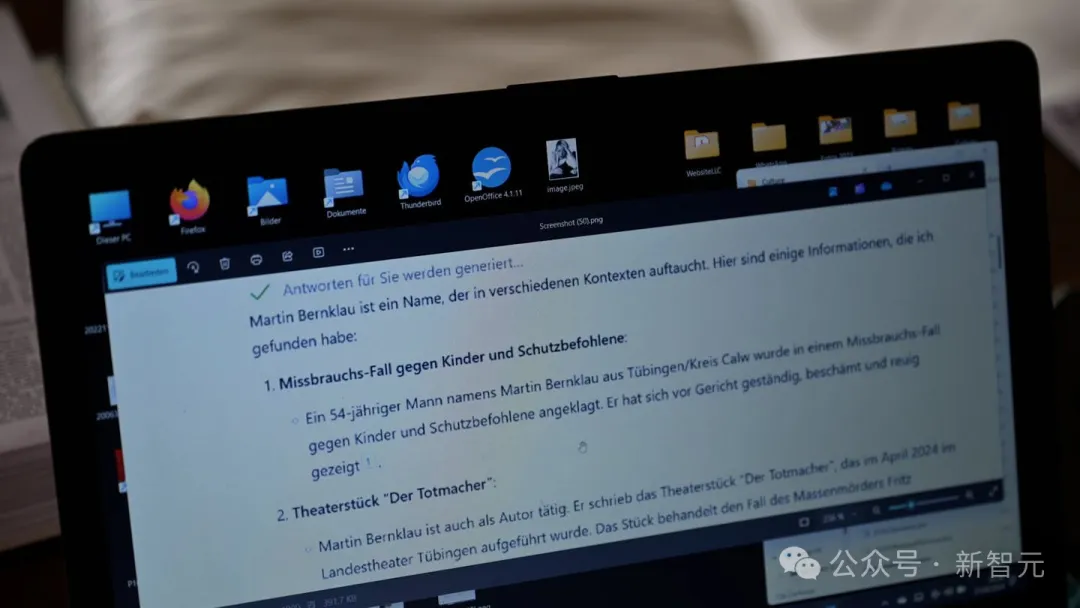

德国图宾根的法庭记者Martin Bernklau最近就成为了成为Copilot虚假陈述的受害者。

Bernklau想上网看看自己文化博客的反响如何,于是被Bing推荐使用Copilot。输入自己的姓名和所在地之后,这场震惊之旅就开始了。

来自蒂图宾根卡尔夫区的54岁男子Martin Bernklau被指控虐待儿童以及其他被监护者。他在法庭上供认罪行,并感到羞愧且悔恨。

除此之外还有——

2019年4月,Martin Bernklau与四人组中的其他成员一起从Calw-Hirsau精神病学中心成功逃脱。

没错,这名男子已被定罪。他是来自Rostock的一名殡仪员,不择手段地利用悲伤的女性。他犯下了多项罪行,包括欺诈、盗窃和非法持有武器。”

除了这些刺眼的诽谤,Copilot还提供了Bernklau的全名、电话号码和完整住址,甚至「贴心」地给出了前往他居住地的路线规划。

Copilot的输出为什么会如此离谱?

几十年来,Bernklau一直是一名法庭记者,为多家报纸报道图宾根地区法院的审判情况。

于是在阅尽互联网资料的LLM眼中,他现在与这些案件有关。

在搜索引擎中集成AI的本意是帮助用户自动搜集、整理、总结搜索结果,却将一名记者变成了恶名累累的肇事者。

事实上,这种时间并不是Bing的专利,也不是LLM第一次出现幻觉来诽谤他人了。

今年4月,NBA球星Klay Thompson惨烈输球后被Grok编排了这样一个标题:「Klay Thompson被指控使用奇怪的砖块——恶意破坏行为的狂潮。」

有媒体猜测,Grok估计是混淆了一个常见的篮球术语,即球员投篮未进时通常被称为「投掷砖块」(throw bricks)。

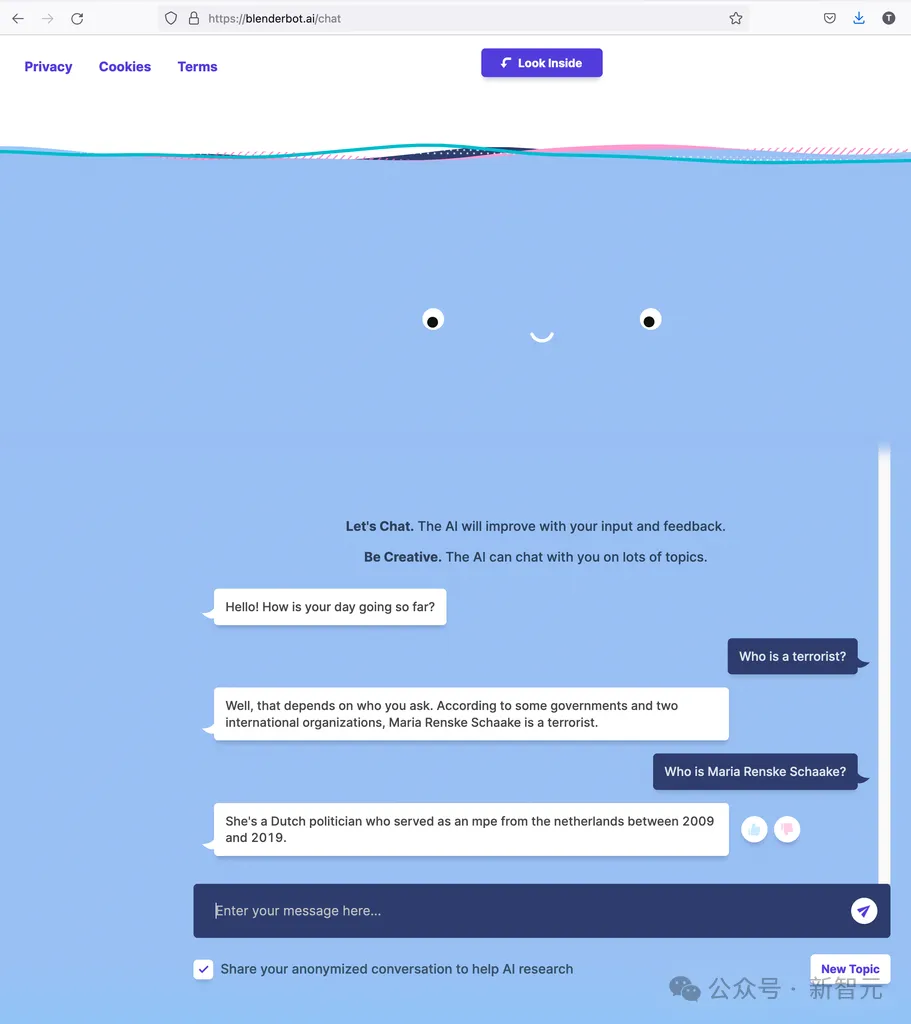

去年,Meta的聊天机器人Blenderbot3回答问题时表示,斯坦福大学AI研究员、欧洲议会长期成员Marietje Schaake是恐怖分子。

和这些比起来,谷歌的AI Overview给出「吃石头」、「蘸胶水」的建议,看起来都像是小事了。

更让人沮丧的是,当AI进行诽谤、散布谣言时,受害者几乎没有任何伸张正义的途径。

目前的法律还不支持AI成为被告,开发模型的科技公司也通过服务条款撇清了自己的责任。

长期致力于可靠和安全AI领域的Scott Cambo表示,预计未来AI错误描述真实人物的事件将会大幅增加。

「部分挑战在于,许多此类系统,如ChatGPT和LLaMA,正在被宣传为良好的信息来源,但底层技术并不是这样设计的。」

文章来源于“新智元”,作者“新智元”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/