CoT铸就了o1推理王者。

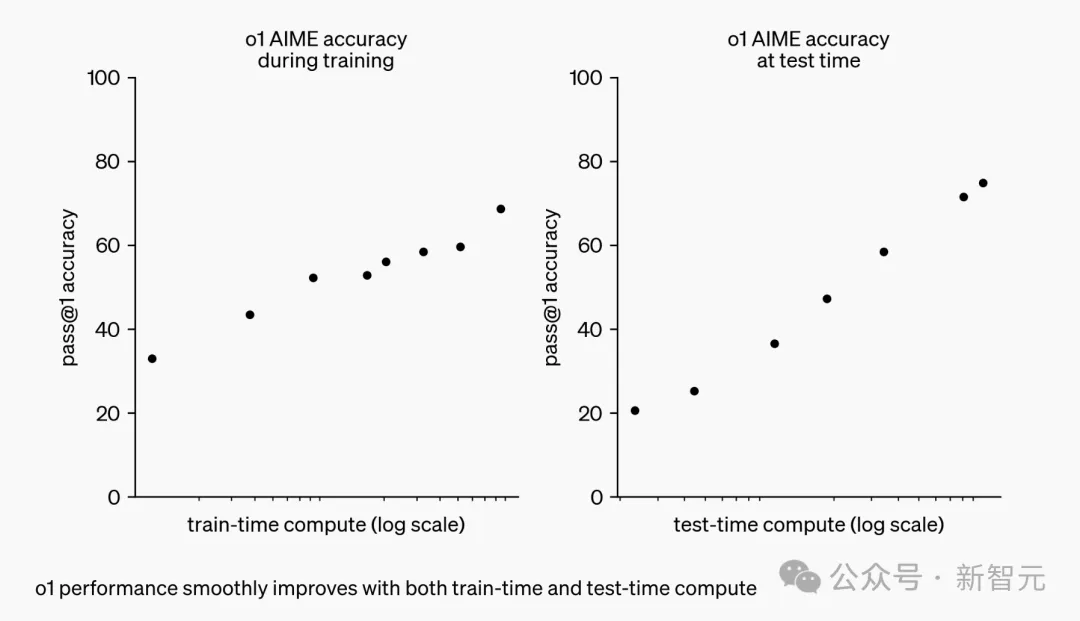

它开创了一种推理scaling新范式——随着算力增加、更长响应时间,o1性能也随之增长。

这一点,为AI scaling开辟了新的可能性。

既然如此,若是将o1这一训练过程直接应用到所有LLM中,岂不皆是「推理王者」。

然而,研究机构Epoch AI发现,结果并不是这样的。

单纯的扩展推理计算,根本不能弥合o1-preview和GPT-4o之间的差距。

他们称,「虽然o1使用了逐步推理方法训练,但其性能改进,可能还存在其他的因素」。

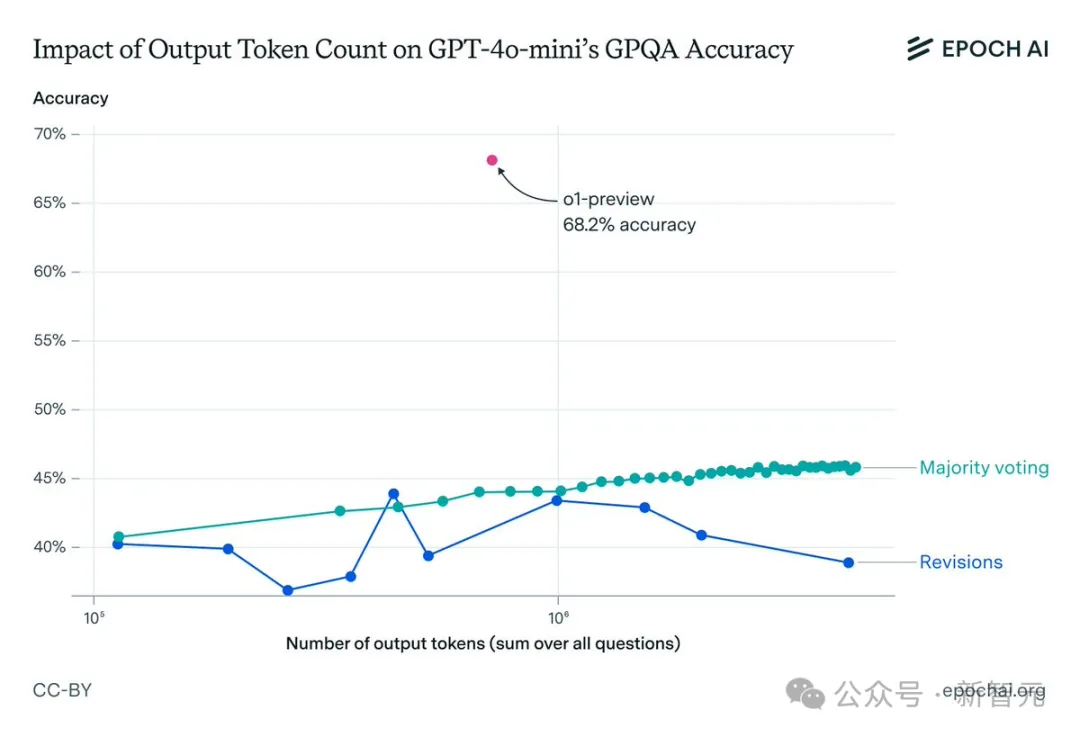

上周,在o1-preview和o1-mini发布之后,Epoch AI研究人员开启了GPT-4o和o1-preview对比实验。

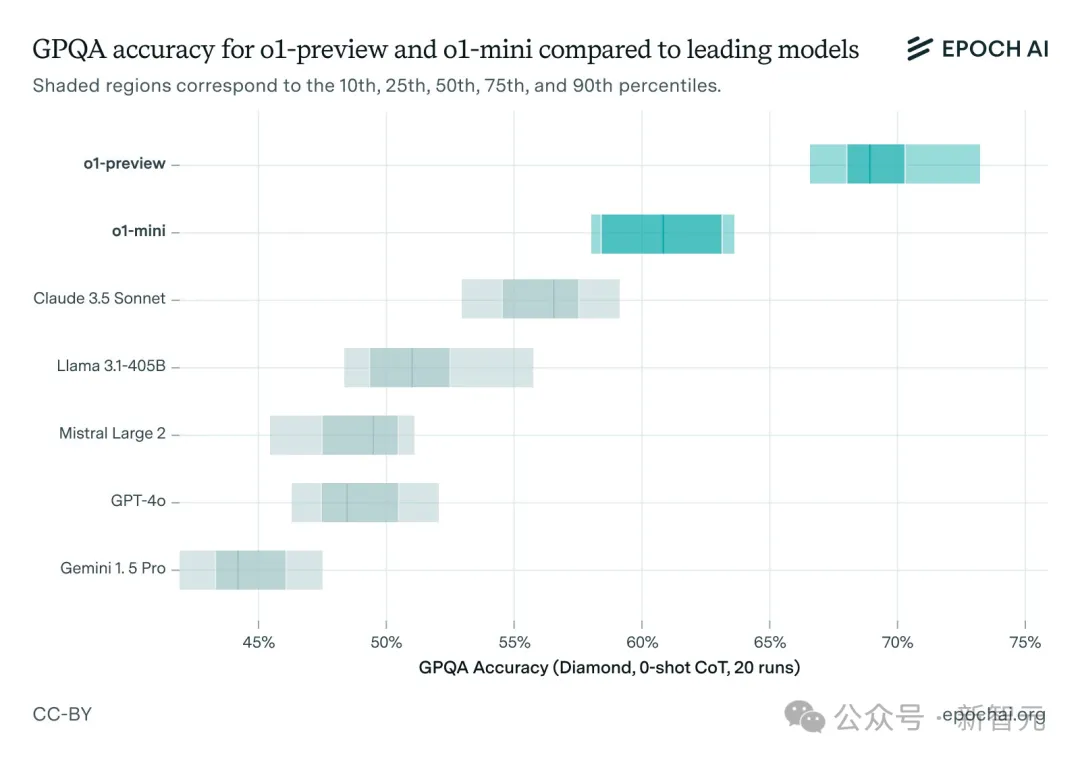

他们选择了一个具有挑战性的基准测试GPQA进行评估,其中包含STEM领域研究生级别的多项选择题,而且考虑到模型的随机性进行了多次运行。

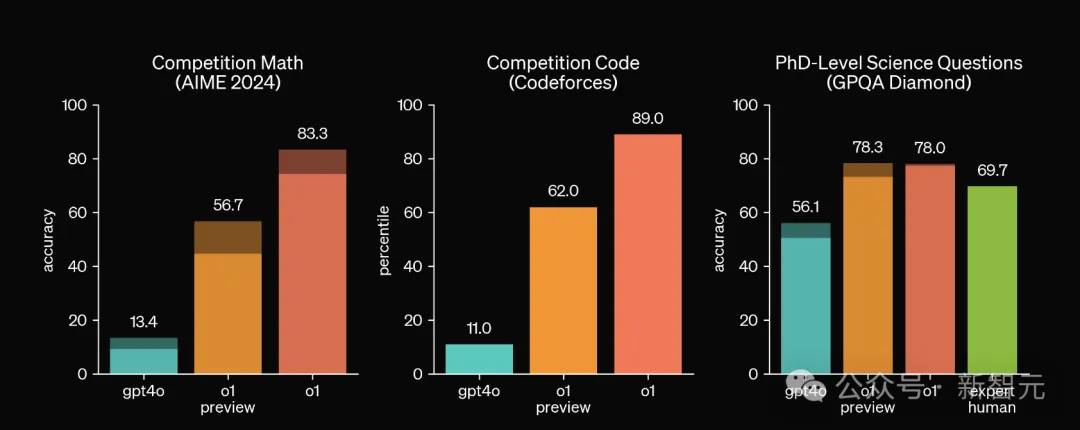

结果发现o1-preview的性能远远好于GPT-4o,比Claude 3.5 Sonnet、Llama3.1 405B也拉开了相当大的差距。

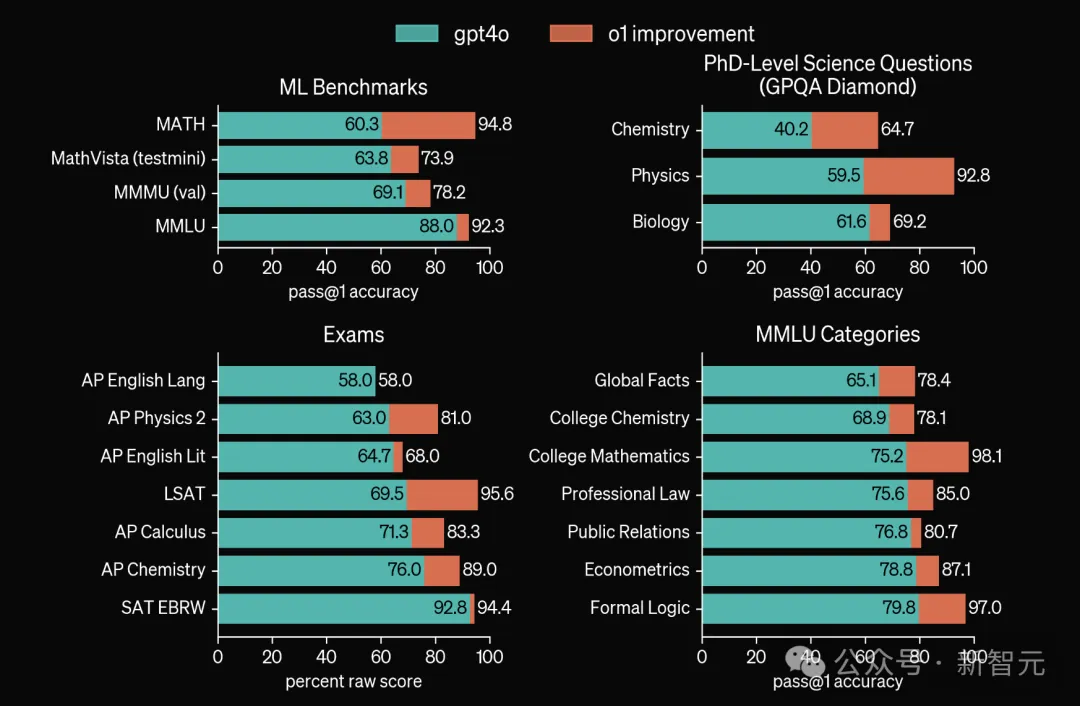

这个结果也和OpenAI自己放出的测试结果相吻合,尤其是在AIME和Codeforces这类难度更高的基准上,o1-preview相比GPT-4o的提升更加明显。

然而,考虑到o1模型相比GPT-4o使用了更多的推理时计算,而且每个问题生成的token也更多,这种比较显得不太公平。

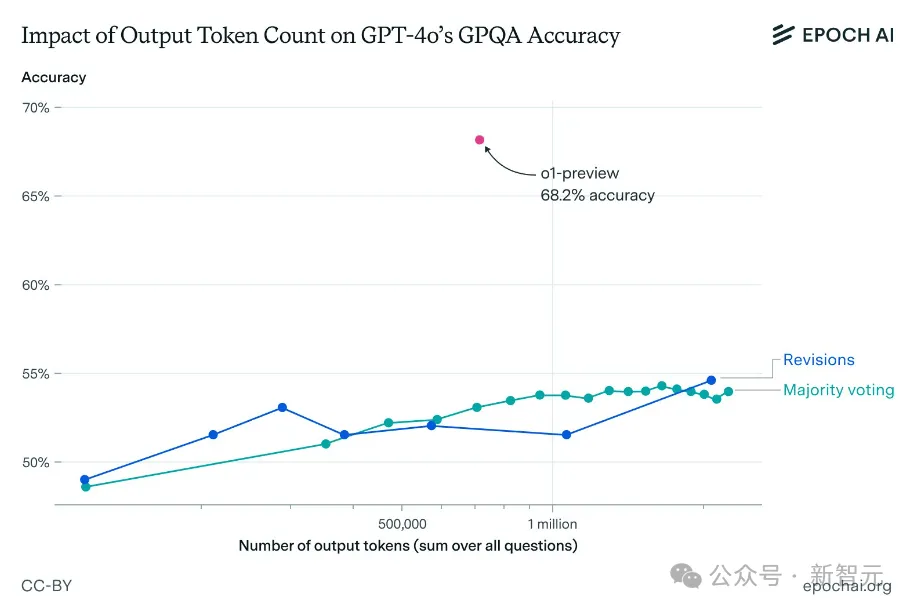

因此,研究人员使用了两种方法尝试增加GPT-4o的输出token,类似于让GPT-4o模仿o1的思考过程。

- 多数投票(majority voting):选择k个推理轨迹中最常见的答案

- 修正(revision):给模型n次反思和改进答案的机会

值得注意的是,这些都是相对简单的方法。其实存在更复杂、有效的方法来利用推理时间计算,比如让过程奖励模型作为验证器参与搜索。

o1模型很可能使用了更复杂的方法,但Epoch研究人员只是想建立一个比较基线,因此选择了较为基础的方法。

结果显示,虽然这两种方法都生成了更多的token,并提高了GPT-4o的准确性,但依旧无法匹敌o1-preview的性能。

GPT-4o变体的准确率仍然显著低于o1-preview,差距始终大于10个百分点。

与o1-preview相比,输出token数量对GPT-4o在GPQA上性能的影响

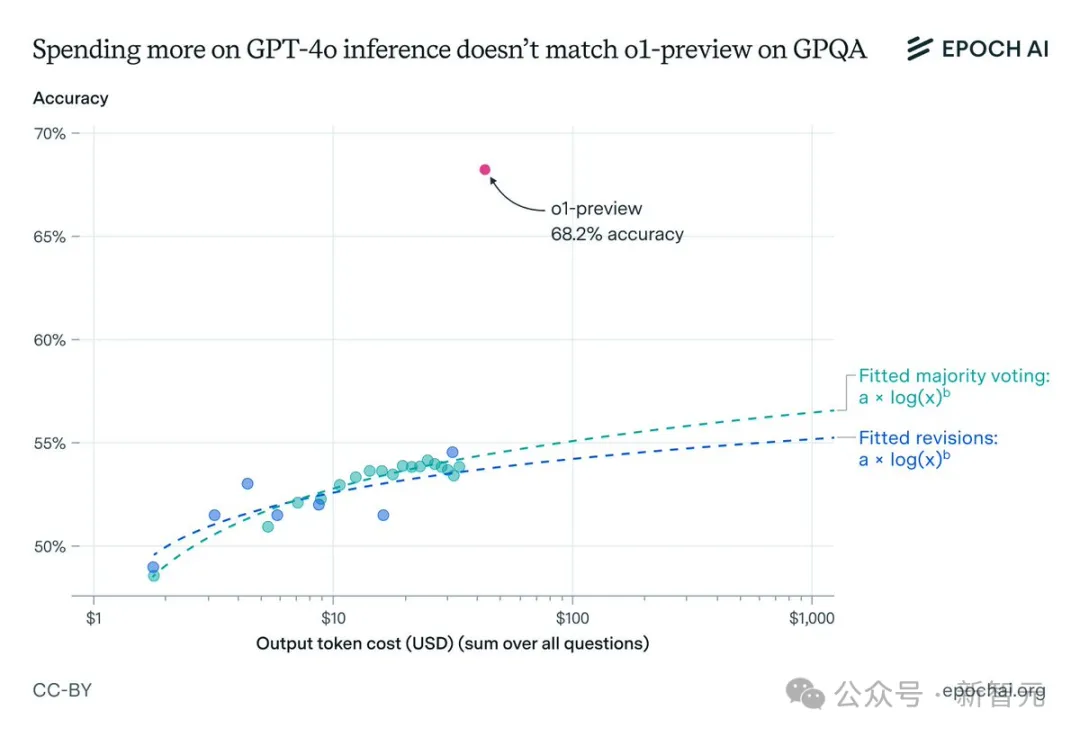

即使考虑到o1-preview每个输出token的成本更高,这种性能差距仍然存在。

Epoch AI团队的推算结果表明,即使在GPT-4o上花费1000美元用于输出token,准确率仍将比o1-preview低10多个百分点。

对GPT-4o mini进行相同操作后也能得到类似的结果,但在进行模型修正后,结果存在一些差异。

随着修正次数的增加,模型准确性不会持续提升,反而会在到达一定阈值后开始下降。这可能是由于GPT-4o mini在长上下文推理方面的局限。

从以上结果可以看出,仅仅扩大推理处理能力并不足以解释o1的卓越性能。

研究作者认为,先进的强化学习技术和改进的搜索方法可能发挥了关键作用,凸显了在Scaling Law之外,算法创新对AI发展的重要性。

但是,我们也并不能确定算法改进是o1-preview优于GPT-4o的唯一因素,更高质量的训练数据也可能导致性能差异。

虽然GPQA或AIME这类问题相当困难,但一般只会考察模型的在STEM领域的知识储备和推理能力。那么强如o1,它的规划能力如何?

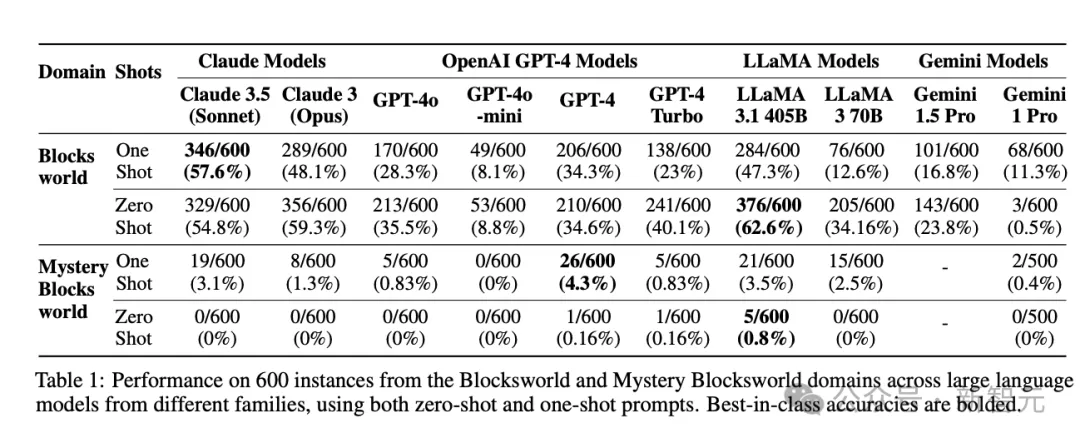

2022年,亚利桑那州大学的学者们曾经提出过一个用于评测LLM规划能力的基准套件PlanBench,包括了来自Blocksworld领域的600个任务,要求将一定数量的积木按照指定顺序堆叠起来。

在MMLU、GSM8K等传统基准相继饱和时,两年前提出的PlanBench依旧没有饱和,可见当今的LLM在规划能力方面依旧有很大的提升空间。

o1之前的模型中,PlanBench准确率很少超过50%

最近,提出PlanBench团队又测试了一下最新的o1-preview模型,发现虽然o1的结果已经表现出了实质性改进,但仍然存在很大的局限性,不能完全解决规划任务。

论文地址:https://arxiv.org/abs/2409.13373

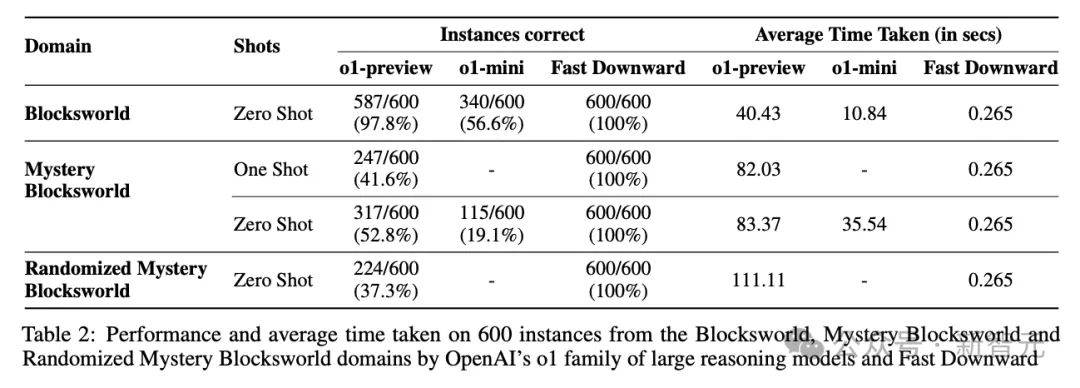

在Blocksworld任务上,o1实现了97.8%的准确率,远远优于LLaMA 3.1 405B之前达到的最好成绩62.6%。

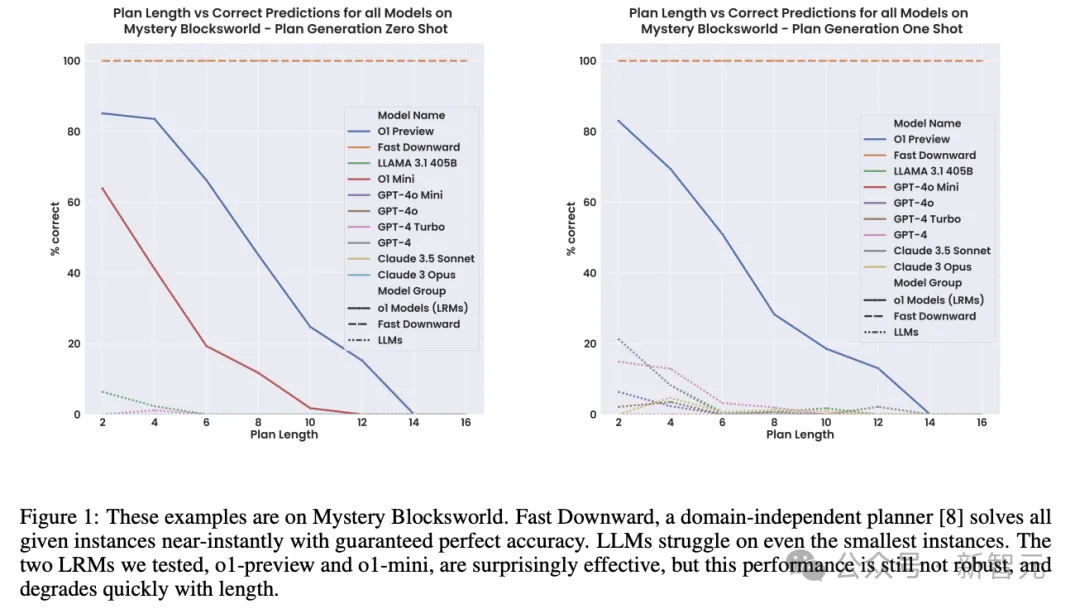

在更具挑战性的任务版本Mystery Blocksworld上,之前的LLM几乎完全失败,而o1达到了52.8%的准确率。

此外,为了排除o1的性能提升源于训练数据中包含基准测试,研究人员还创建了Mystery Blocksworld的随机变体进行测试(表2中的Randomized Mystery Blocksworld)。

o1在随机变体测试集上的成绩从52.8%下降至37.3%,但依旧超过得分接近于0的之前其他模型。

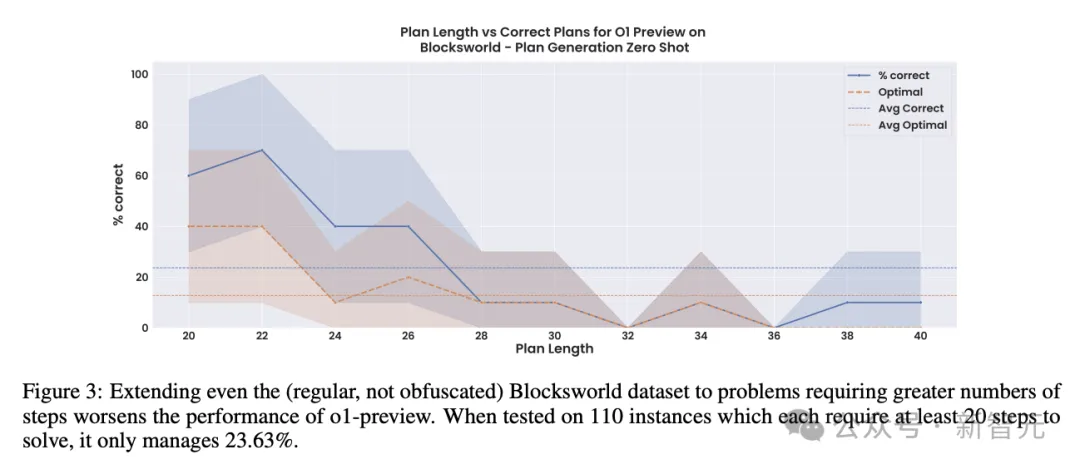

虽然o1和o1-mini都取得了不错的成绩,但性能并不稳健。随着任务逐渐复杂、计划步骤增加,性能会出现直线下降。

在这组含有110个实例的较大Blocksworld数据集上,每个问题都需要20~40个步骤的最佳计划,而o1的准确率从之前报告的97.8%直接下降至23.6%,而且这些准确率大部分都来自步骤少于28的问题。

相比准确性更高、成本更低的传统方法,如经典规划器Fast Downward或LLM-Modulo系统,o1这样的大型推理模型(LRM)非常缺乏正确性保证,而且使得可解释性几乎不可能,因此很难在实际应用中部署。

o1虽强,但绝不是万能的。OpenAI想要真正实现AGI,还需要走很长一段路。

参考资料:

https://the-decoder.com/openais-o1-probably-does-more-than-just-elaborate-step-by-step-prompting/

https://x.com/EpochAIResearch/status/1838720157545648315

https://the-decoder.com/researchers-put-openais-o1-through-its-paces-exposing-both-breakthroughs-and-limitations/

文章来自于微信公众号“新智元”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0