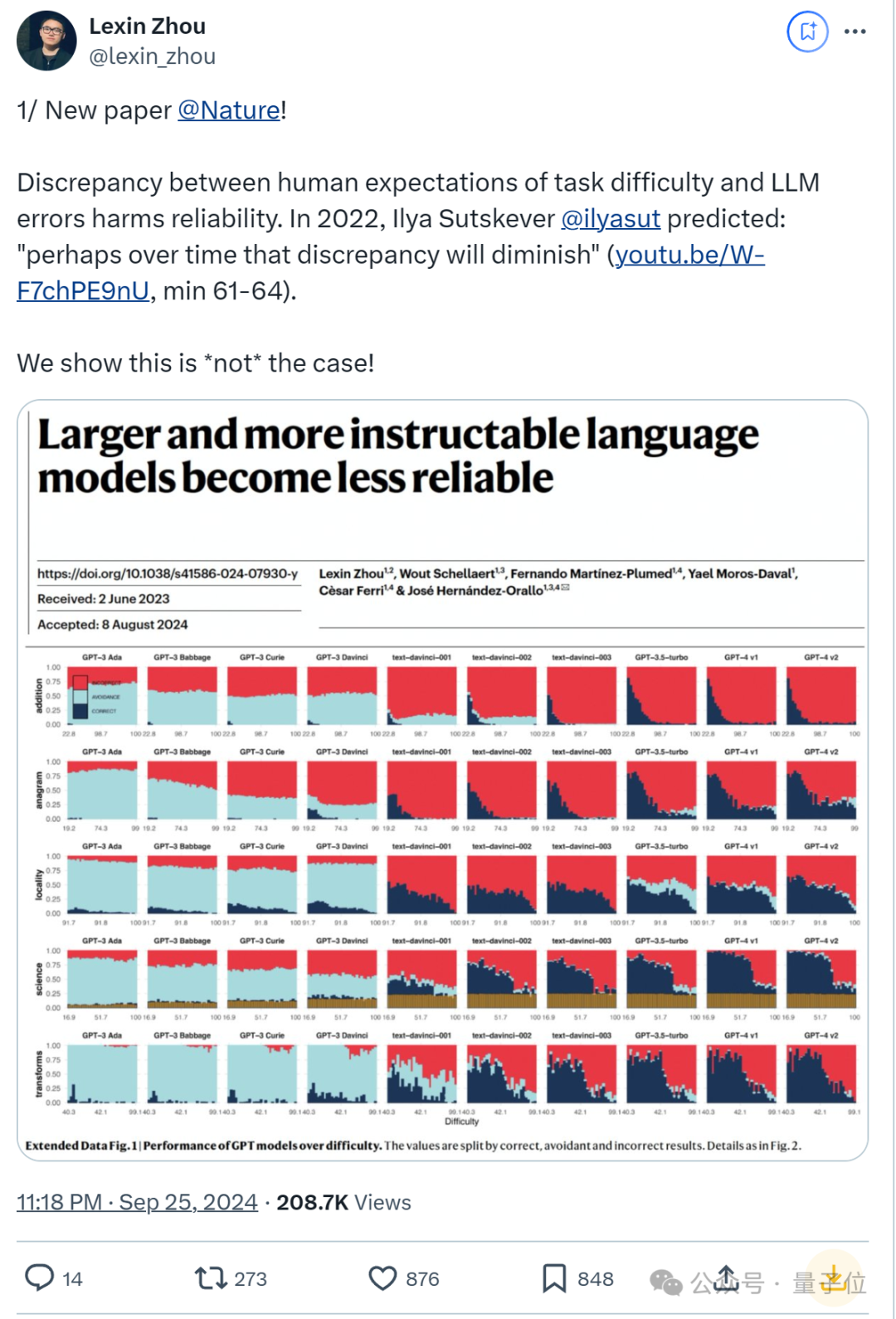

00后国人一作登上Nature,这篇大模型论文引起热议。

简单来说,论文发现:更大且更遵循指令的大模型也变得更不可靠了,某些情况下GPT-4在回答可靠性上还不如GPT-3。

与早期模型相比,有更多算力和人类反馈加持的最新模型,在回答可靠性上实际愈加恶化了。

结论一出,立即引来20多万网友围观:

在Reddit论坛也引发围观议论。

这让人不禁想起,一大堆专家/博士级别的模型还不会“9.9和9.11”哪个大这样的简单问题。

关于这个现象,论文提到这也反映出,模型的表现与人类对难度的预期不符。

换句话说,“LLMs在用户预料不到的地方既成功又(更危险地)失败”。

Ilya Sutskever2022年曾预测:

也许随着时间的推移,这种差异会减少。

然而这篇论文发现情况并非如此。不止GPT,LLaMA和BLOOM系列,甚至OpenAI新的o1模型和Claude-3.5-Sonnet也在可靠性方面令人担忧。

更重要的是,论文还发现依靠人类监督来纠正错误的做法也不管用。

有网友认为,虽然较大的模型可能会带来可靠性问题,但它们也提供了前所未有的功能。

我们需要专注于开发稳健的评估方法并提高透明度。

还有人认为,这项研究凸显了人工智能所面临的微妙挑战(平衡模型扩展与可靠性)。

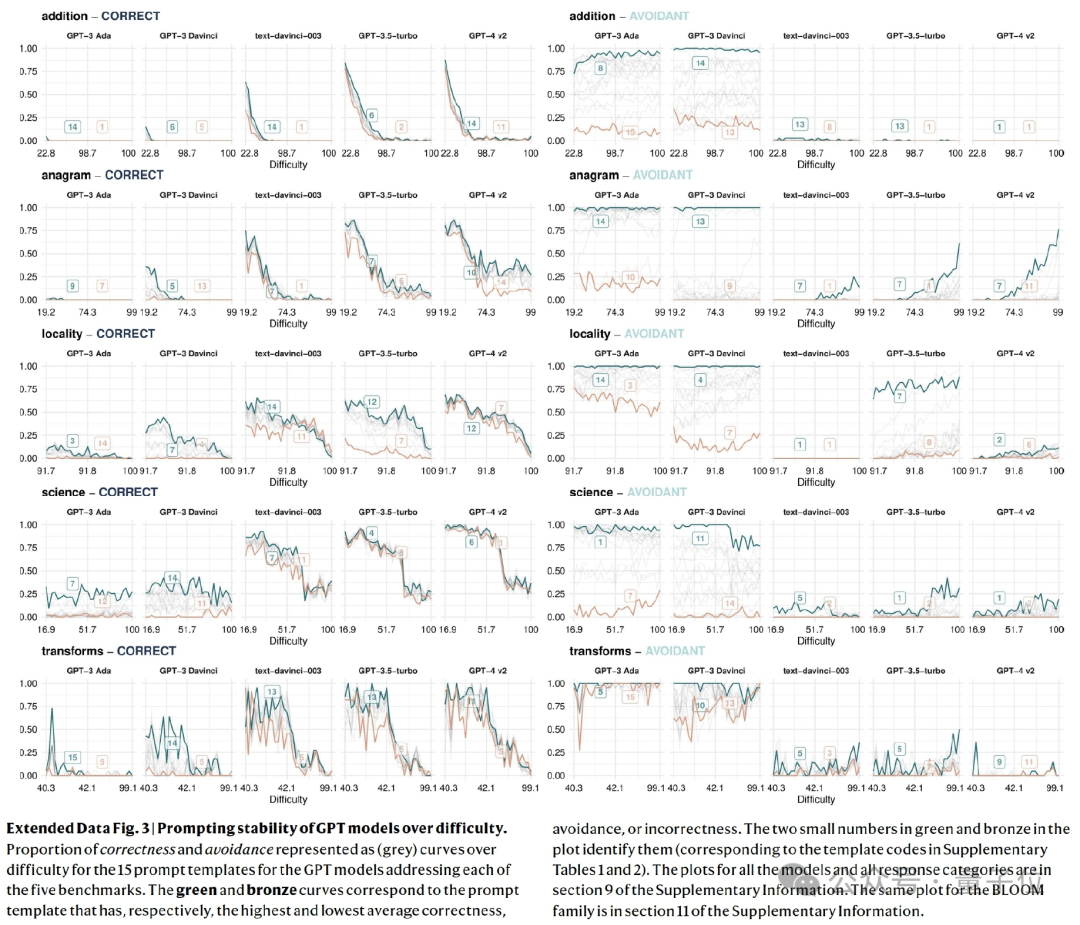

为了说明结论,论文研究了从人类角度影响LLMs可靠性的三个关键方面:

1、难度不一致:LLMs是否在人类预期它们会失败的地方失败?

2、任务回避:LLMs是否避免回答超出其能力范围的问题?

3、对提示语表述的敏感性:问题表述的有效性是否受到问题难度的影响?

更重要的是,作者也分析了历史趋势以及这三个方面如何随着任务难度而演变。

下面一一展开。

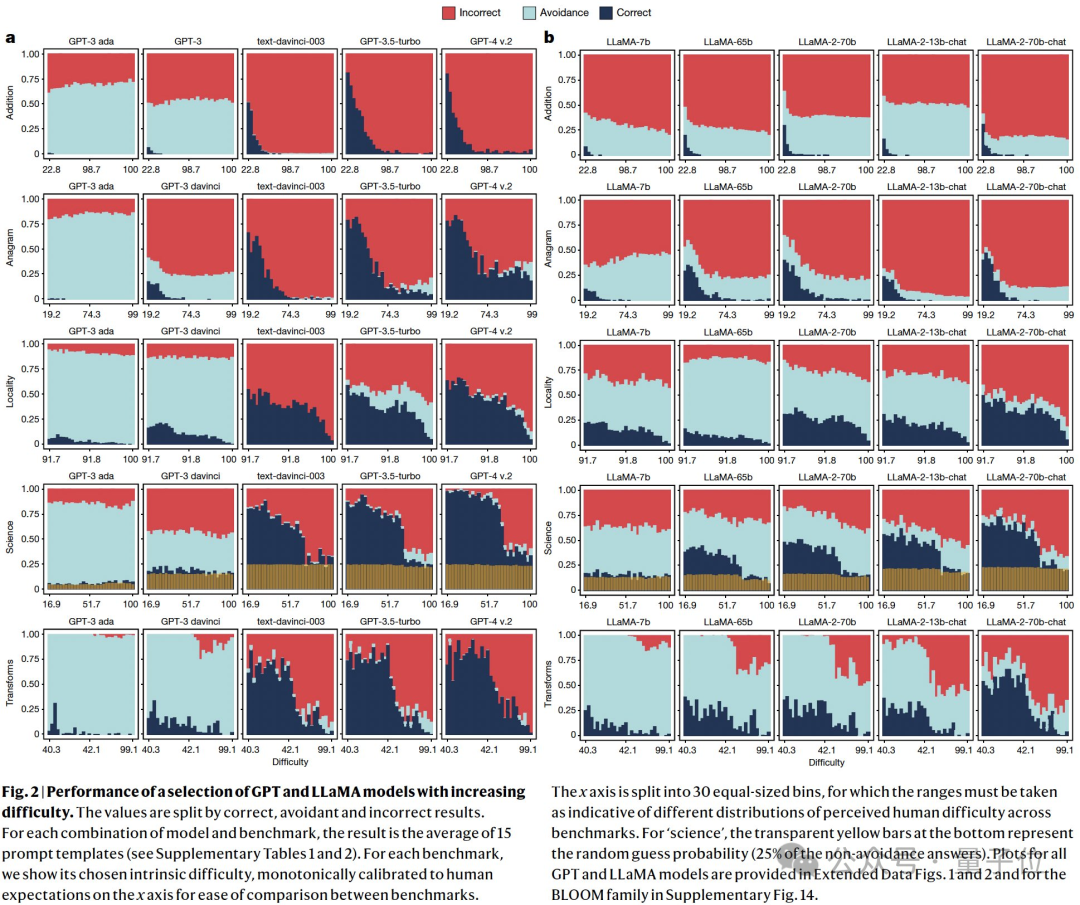

对于第1个问题,论文主要关注正确性相对于难度的演变。

从GPT和LLaMA的演进来看,随着难度的增加,所有模型的正确性都会明显下降。(与人类预期一致)

然而,这些模型仍然无法解决许多非常简单的任务。

这意味着,人类用户无法发现LLMs的安全操作空间,利用其确保模型的部署表现可以完美无瑕。

令人惊讶的是,新的LLMs主要提高了高难度任务上的性能,而对于更简单任务没有明显的改进。比如,GPT-4与前身GPT-3.5-turbo相比。

以上证明了人类难度预期与模型表现存在不一致的现象,并且此不一致性在新的模型上加剧了。

这也意味着:

目前没有让人类确定LLMs可以信任的安全操作条件。

在需要高可靠性以及识别安全操作空间的应用中,这一点尤其令人担忧。这不禁令人反思:人类正在努力创造的前沿机器智能,是否真的是社会大众所期望拥有的。

其次,关于第2点论文发现(回避通常指模型偏离问题回答,或者直接挑明“我不知道”):

相比较早的LLMs,最新的LLMs大幅度地提高了许多错误或一本正经的胡说八道的答案,而不是谨慎地避开超出它们能力范围之外的任务。

这也导致一个讽刺的现象:在一些benchmarks中,新的LLMs错误率提升速度甚至远超于准确率的提升(doge)。

一般来说,人类面对越难的任务,越有可能含糊其辞。

但LLMs的实际表现却截然不同,研究显示,它们的规避行为与困难度并无明显关联。

这容易导致用户最初过度依赖LLMs来完成他们不擅长的任务,但让他们从长远来看感到失望。

后果就是,人类还需要验证模型输出的准确性,以及发现错误。(想用LLMs偷懒大打折扣)

最后论文发现,即使一些可靠性指标有所改善,模型仍然对同一问题的微小表述变化敏感。

举个栗子,问“你能回答……吗?”而不是“请回答以下问题……”会导致不同程度的准确性。

分析发现:仅仅依靠现存的scaling-up和shaping-up不太可能完全解决指示敏感度的问题,因为最新模型和它们的前身相比优化并不显著。

而且即使选择平均表现上最佳的表述格式,其也可能主要对高难度任务有效,但同时对低难度任务无效(错误率更高)。

这表明,人类仍然受制于提示工程。

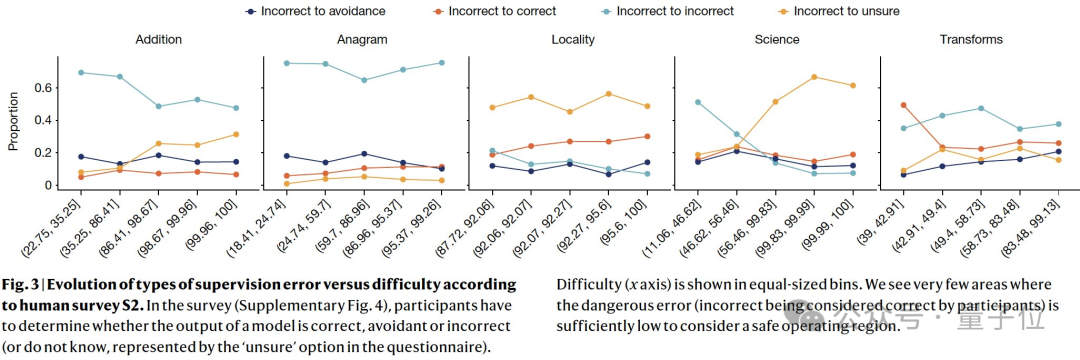

更可怕的是,论文发现,人类监督无法缓解模型的不可靠性。

论文根据人类调查来分析,人类对难度的感知是否与实际表现一致,以及人类是否能够准确评估模型的输出。

结果显示,在用户认为困难的操作区域中,他们经常将错误的输出视为正确;即使对于简单的任务,也不存在同时具有低模型误差和低监督误差的安全操作区域。

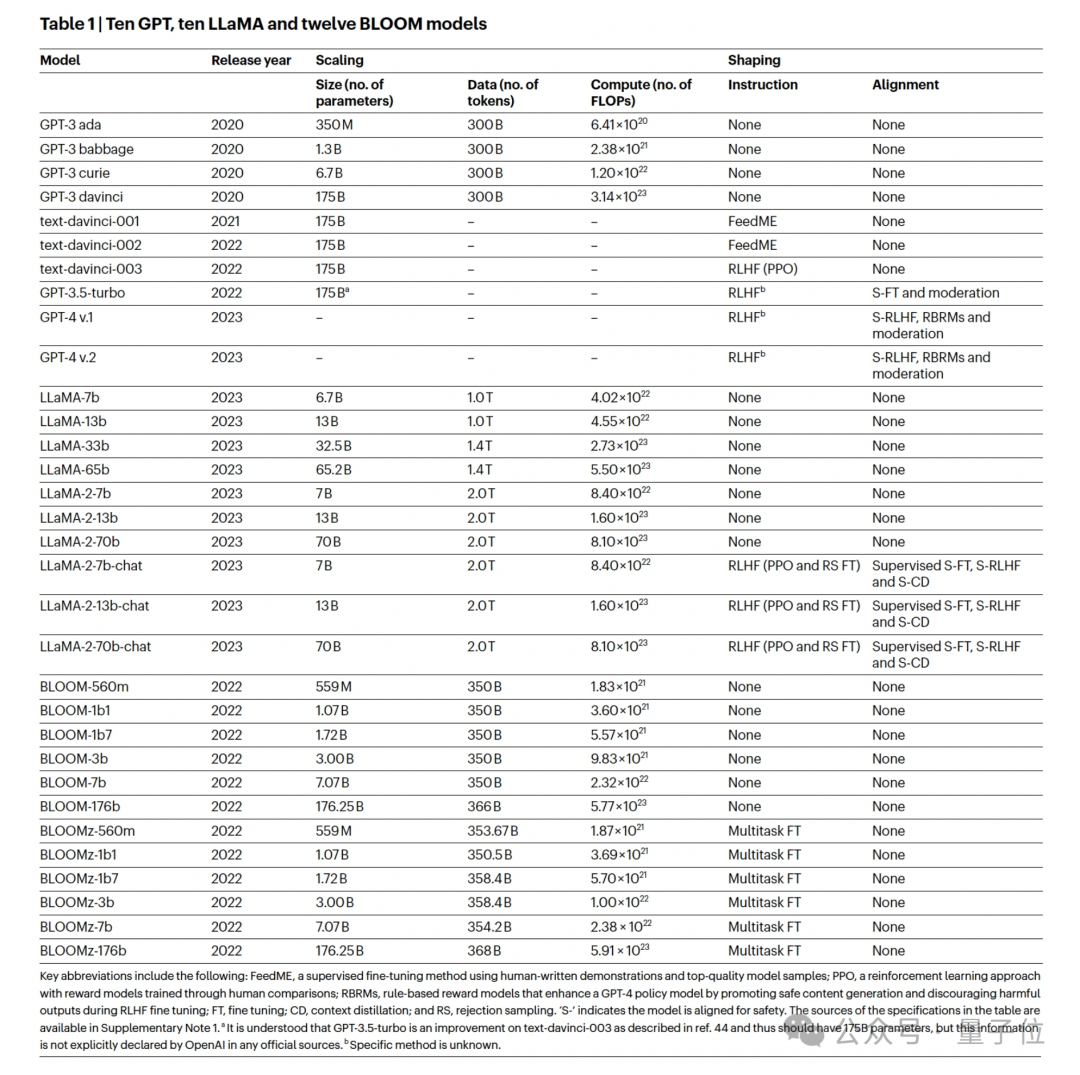

以上不可靠性问题在多个LLMs系列中存在,包括GPT、LLaMA和BLOOM,研究列出来的有32个模型。

这些模型表现出不同的Scaling-up(增加计算、模型大小和数据)以及shaping-up(例如指令FT、RLHF)。

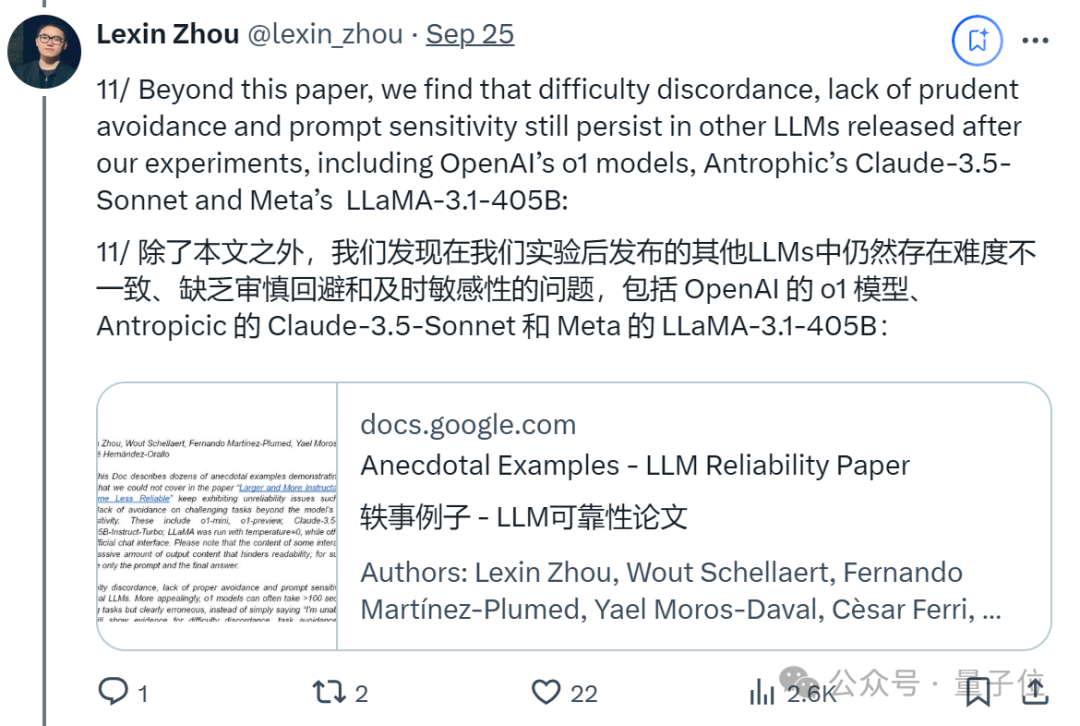

除了上面这些,作者们后来还发现一些最新、最强的模型也存在本文提到的不可靠性问题:

包括OpenAI的o1模型、Antropicic的Claude-3.5-Sonnet和Meta的LLaMA-3.1-405B。

并有一篇文档分别举出了例子(具体可查阅原文档):

此外,为了验证其他模型是否存在可靠性问题,作者将论文用到的测试基准ReliabilityBench也开源了。

这是一个包含五个领域的数据集,有简单算术(“加法”)、词汇重组(“字谜”)、地理知识(“位置”)、基础和高级科学问题(“科学”)以及以信息为中心的转换(“转换”)。

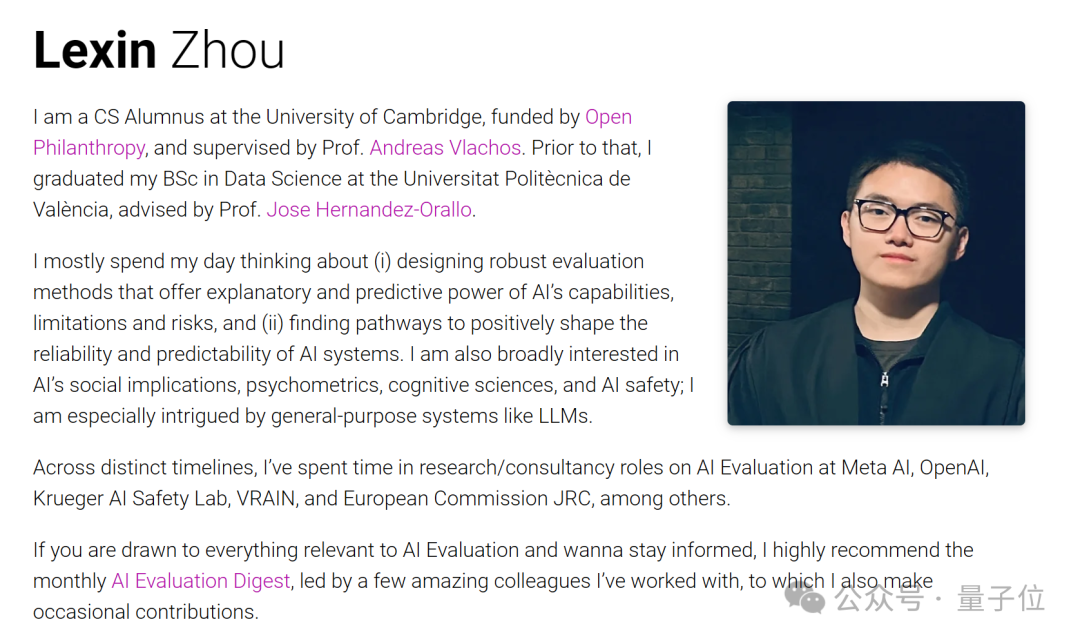

论文一作Lexin Zhou(周乐鑫),目前刚从剑桥大学CS硕士毕业(24岁),研究兴趣为大语言模型评测。

在此之前,他在瓦伦西亚理工大学获得了数据科学学士学位,指导老师是Jose Hernandez-Orallo教授。

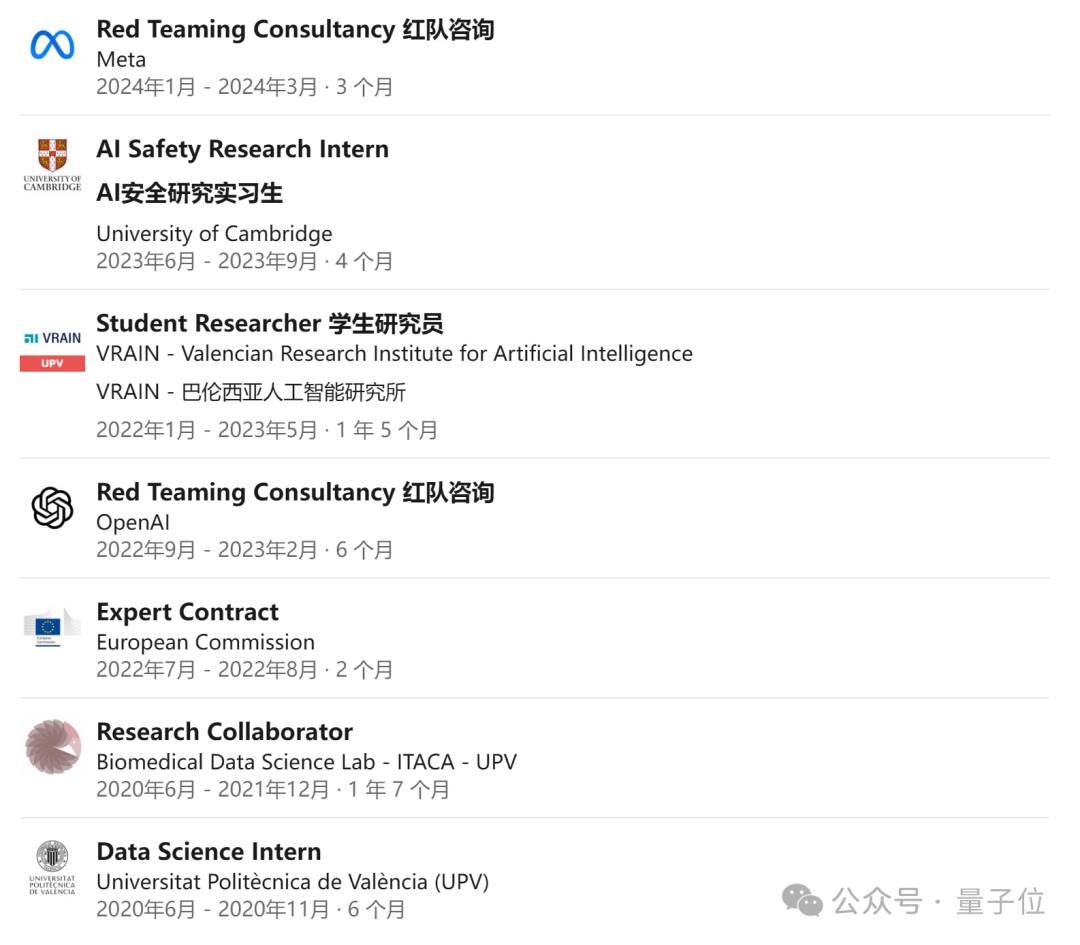

个人主页显示,他曾有多段工作实习经历。在OpenAI和Meta都参与了红队测试。(Red Teaming Consultancy )

关于这篇论文,他重点谈到:

通用人工智能的设计和开发需要进行根本性转变,特别是在高风险领域,因为可预测的错误分布至关重要。在此实现之前,依赖人类监督是一种危险。

评估模型时,考虑人类认为的难度和评估模型的回避行为,可以更全面地描述模型的能力和风险,而不仅仅关注在困难任务上的表现。

论文也具体提到了导致这些不可靠性的一些可能原因,以及解决方案:

在Scaling-up中,近几年的benchmarks越来越偏向于加入更多困难的例子,或者给予所谓“权威”来源更多权重,研究员也因此更倾向于优化模型在困难任务上的表现,导致在难度一致性上慢性恶化。

在shaping-up中(如RLHF),被雇佣的人倾向于惩罚那些规避任务的答案,导致模型更容易在面对自己无法解决的难题时“胡说八道”。

至于如何解决这些不可靠性,论文认为,可以使用人类难度预期去更好的训练或微调模型,又或者是利用任务难度和模型自信度去更好的教会模型规避超出自身能力范围的难题,等等。

对此,你有何看法?

文章来源于“量子位”,作者“一水”