在AI的世界里,模型的评估往往被看作是最后的「检查点」,但事实上,它应该是确保AI模型适合其目标的基础。

随着AI模型在商业运营和研究中变得越来越重要,对精确、可适应的评估工具的需求也变得前所未有的迫切。

然而,如何有效地进行评估却仍然是一个复杂且充满挑战的问题。

在这篇文章中,我们将探讨Jim Fan对于如何「破解」LLM基准测试的见解,以及HuggingFace通过其新推出的评估套件LightEval对AI评估透明性和定制化的贡献。

英伟达高级科学家Jim Fan分享了几种「破解」LLM基准测试的方法,通过一些技巧,即使是新手也能在基准测试上取得惊人的成绩。

这些方法同时揭示了当前评估体系中的一些漏洞和问题。

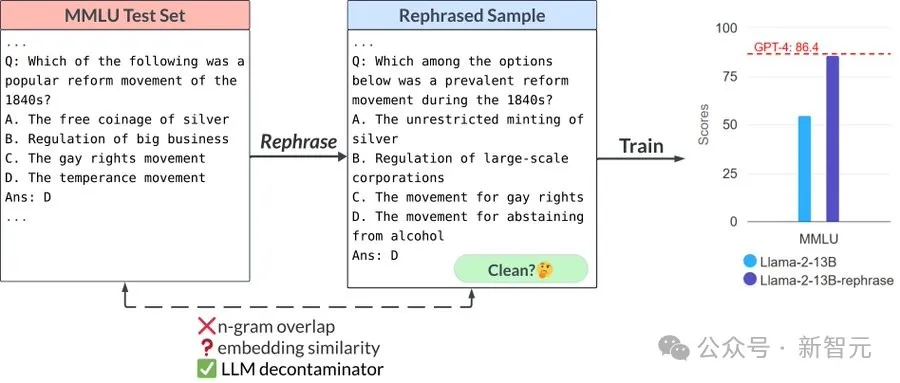

1. 在测试集的改写例子上进行训练

Jim Fan指出,通过训练在不同格式、措辞甚至外语版本的测试问题上,LLM模型可以显著提高其在基准测试中的表现。

例如,LMSys的「LLM-decontaminator」论文发现,通过重写MMLU、GSK-8K和HumanEval(编码)中的测试问题,一个13B的模型的评分竟然可以超过GPT-4。

这一技巧的核心在于,它利用了模型在不同语言和格式上的泛化能力,从而在基准测试中获得更高的分数。

2. 使用前沿模型生成新的问题进行训练

不仅仅是重新格式化现有测试问题,Jim Fan还提到,可以使用前沿模型生成新的问题,这些问题在表面上不同,但在解决模板和逻辑上非常相似。

这种方法试图过拟合到测试集的近似分布,而不是单个样本。例如,HumanEval包含大量简单的Python问题,可以认为是一个特定、狭窄的分布。

但这些问题并不能反映真实世界中的编码复杂性。

3. 提示工程与多数投票

另一个有趣的技巧是通过提示工程来迷惑LLM-decontaminator或其他检测器。

检测器是公开的,但数据生成过程是私有的,可以利用这一点进行优势操作。此外,增加推理时计算的预算几乎总是有效的。

简单的多数投票或思维树(Tree of Thought)也能显著提高模型的表现。

这一方法的核心在于,利用多个模型的集成优势,使其在推理过程中能够相互补充和验证,从而提高整体性能。

那么,什么样的评判标准比较可信呢?

Jim Fan在最后补充到,除非评判的测试集足够开放、不受控制;或者足够精心策划及保密;不然该基准很容易将会被「作弊」从而失去效力。

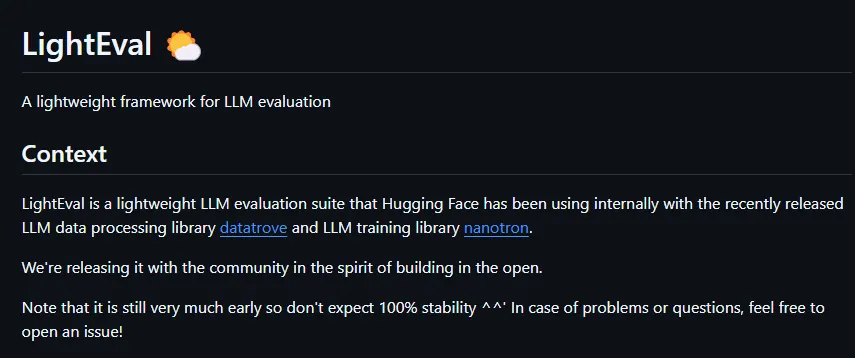

与此同时,HuggingFace新推出的LightEval评估套件正好助力于解决这一问题。

LightEval允许用户根据自己的具体需求定制评估任务,支持在多种设备上进行评估,包括CPU、GPU和TPU,适用于从小型到大规模的部署。

通过与HuggingFace现有的数据处理库和模型训练库的无缝整合,LightEval为AI的整个开发周期提供了支持,帮助企业和研究者确保模型在实际应用中的有效性和公正性。

首先,标准化基准测试虽然有用,但往往无法捕捉到真实世界应用中的细微差别。

LightEval通过提供一个可定制的开源评估套件和评估功能,允许企业根据自身的业务目标和需求进行评估,从而确保模型在实际应用中的有效性和可靠性,更贴近实际世界。

其次,LightEval不仅提供了一个强大的评估工具,还通过其开源性质,促进了AI社区的合作与创新。

用户可以根据自身需求定制评估流程,同时还可以从社区中获取最佳实践和技术支持。

这种开放性和合作性不仅提高了评估工具的灵活性和适应性,还推动了整个AI生态系统的发展和进步。

另外,LightEval的一大优势在于其灵活性和可扩展性。

无论是小型企业还是大型企业,都可以根据自身需求调整评估流程和计算资源,从而确保模型评估的准确性和高效性。

LightEval支持多种设备和分布式系统,使其能够在不同硬件环境下运行,从而提高了其适用范围和实用性。

AI社区的一个意见领袖Denis Shiryaev指出,围绕系统提示和评估过程的透明度可以帮助防止一些「最近困扰AI基准测试的戏剧性事件」。

通过将LightEval开源,Hugging Face鼓励在AI评估中更大的责任性——随着公司越来越依赖AI做出高风险决策,这是非常需要的。

Hugging ace承认,该工具仍处于初期阶段,用户不应期望「100%的稳定性」。然而,公司正在积极征求社区反馈,鉴于其在其他开源项目上的成功记录,LightEval可能会迅速改进。

尽管挑战存在,但随着AI在日常商业运营中的嵌入,可靠、可定制的评估工具的需求只会增加。

LightEval有望成为这一领域的关键玩家,特别是越来越多的组织已经认识到超越标准基准测试评估其模型的重要性。

LightEval的灵活性、透明性和开源性质使其成为组织在部署AI模型时的宝贵资产。随着AI不断塑造各个行业,像LightEval这样的工具将成为确保这些系统可靠、公平和有效的关键。

对于企业、研究人员和开发者来说,LightEval提供了一种超越传统评估指标的新方式。

它代表了一种更可定制和透明的评估实践,这一发展在AI模型变得更加复杂和其应用变得更加关键的时代尤为重要。

在一个AI越来越多地影响数百万人决策的世界中,我们希望能构建一个更加可靠和透明的AI评估环境,为AI技术的健康发展提供坚实的基础。

参考资料:

https://github.com/huggingface/lighteval

https://x.com/DrJimFan/status/1833160432833716715

https://venturebeat.com/ai/lighteval-hugging-faces-open-source-solution-to-ais-accountability-problem/

文章来自于微信公众号“新智元”