图片来源:Goodfire

Z Highlights

AI模型的黑盒特性一直是人工智能领域长期存在的一个挑战。尽管AI在处理大量数据方面表现出色,能够从复杂的数据集中学习并做出预测,但它们的内部工作机制对于大多数人来说仍然是一个谜。这种缺乏透明度的状态导致了对AI模型可靠性和安全性的普遍担忧。因为如果人们无法完全理解这些模型是如何学习和做出决策的,就很难确保模型的决策是公正、无偏见的,也难以在模型出错时进行有效的调试和修正。

为了解决这个问题,很多研究人员正在探索如何提高AI模型的可解释性,使AI系统的决策过程更加透明,让人们能够理解模型的工作原理和决策依据。目前可解释性AI的实现方式包括但不限于:通过使用决策树、逻辑回归等简单直观的模型,或者采用局部可解释性方法如LIME(Local Interpretable Model-agnostic Explanations),这些方式可以帮助理解模型对特定实例的决策过程,不仅有助于增强用户对AI系统的信任,还能够在模型出现错误时提供排查错误的途径。

然而,提高AI模型的可解释性依然存在巨大的挑战。一方面,随着模型的复杂性增加,如深度学习模型,其内部的决策过程可能涉及非常大量的参数和多层次的计算,这使得解释模型的决策变得更加困难。另一方面,即使是可解释性模型,也可能在特定情况下无法提供足够的信息来完全理解模型的行为。

为了应对这些挑战,研究人员正在开发更先进的技术,Goodfire也致力于研发相关产品,寻求问题的最优解。Goodfire正在构建关键基础设施,使开发人员能够大规模理解、编辑和调试人工智能模型,确保创建更安全、更可靠的系统。

图片来源:X

Goodfire开发的产品是第一个将可解释性研究应用于AI模型行为的实际理解和编辑的产品。Goodfire产品的洞察力和控制可能会减少对昂贵的再训练或提示工程的需求,使AI开发更加高效和可预测。他们的产品具有多个特性:

1.可解释性工具:Goodfire的产品通过使用基于可解释性的工具来理解和编辑AI模型的行为。这些工具提供了一个人类可解释的界面,解释模型输出背后的内部决策过程,使开发人员可以直接访问模型的内部机制,并改变不同概念对修改模型决策过程的重要性。

2.编辑模型行为:Goodfire的工具允许开发者直接访问模型的内部机制,并改变模型决策过程中不同概念的重要性,从而修改模型的行为。

3.精确控制:Goodfire的联合创始人兼CEO Eric Ho将这一过程比作对AI模型进行“脑部手术”,包括三个关键步骤:

Goodfire正在为AI生态系统构建关键基础设施,并有机会开创AI堆栈的新篇章,以一种可访问的方式为在关键任务环境中部署AI的组织生产这些工具。

图片来源:Goodfire

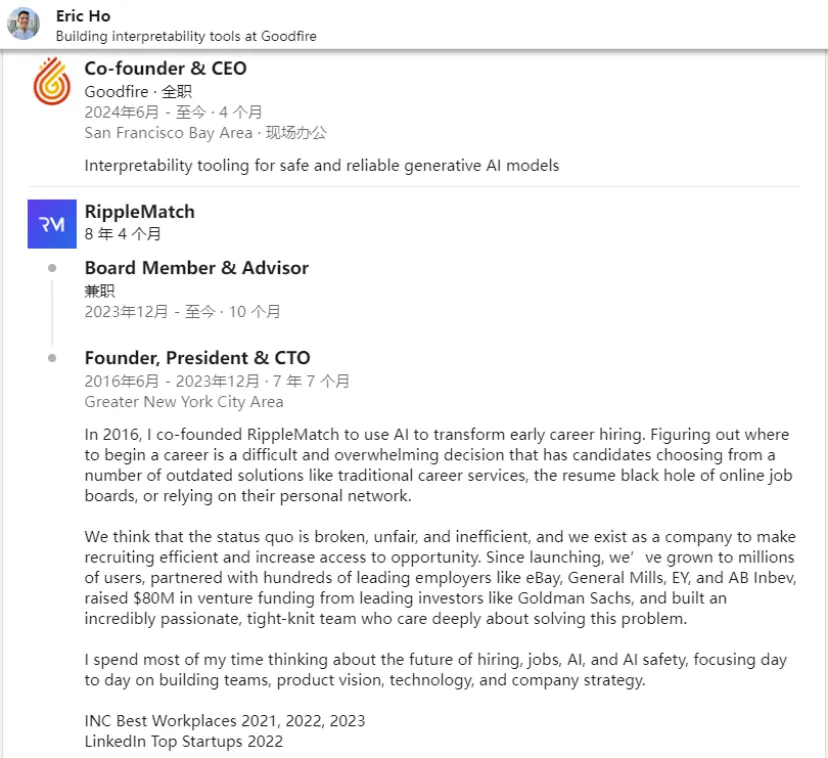

Goodfire的创始团队在AI领域有多年的工作和研究经历。Eric Ho曾表示:“我们的使命是从根本上促进人类对先进AI系统的理解,这使我们走到了一起。”

Eric Ho是Goodfire的联合创始人兼CEO。2016年,Eric与Andrew Myers联合创立了由高盛支持的AI招聘的初创公司RippleMatch,希望通过利用AI来改变早期的职业招聘,在此期间,Eric花了时间思考招聘、工作、人工智能和人工智能安全的未来,专注于组建团队、产品愿景、技术和公司战略。Eric Ho本科毕业于耶鲁大学的计算机科学专业。

图片来源:Linkedln

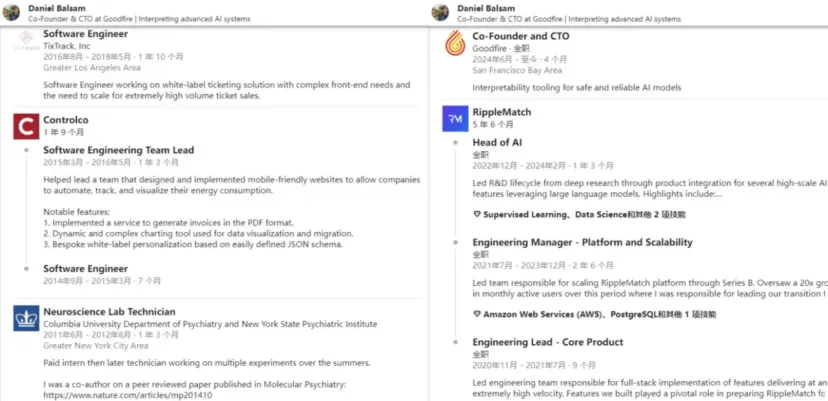

Daniel Balsam是Goodfire的联合创始人及CTO。Daniel在纽约大学本科毕业后,曾在Controlco担任软件工程师,并领导团队设计、实施移动友好型网站,使公司能够自动化、跟踪和可视化其能源消耗。2016年Daniel选择离开Controlco,而在TixTrack担任软件工程师,致力于白标票务解决方案。在离开TixTrack后,Daniel曾担任RippleMatch的软件工程师,与Eric Ho密切合作,领导了RippleMatch的核心平台和机器学习团队,并将产品扩展到数百万活跃用户。

图片来源:Linkedln

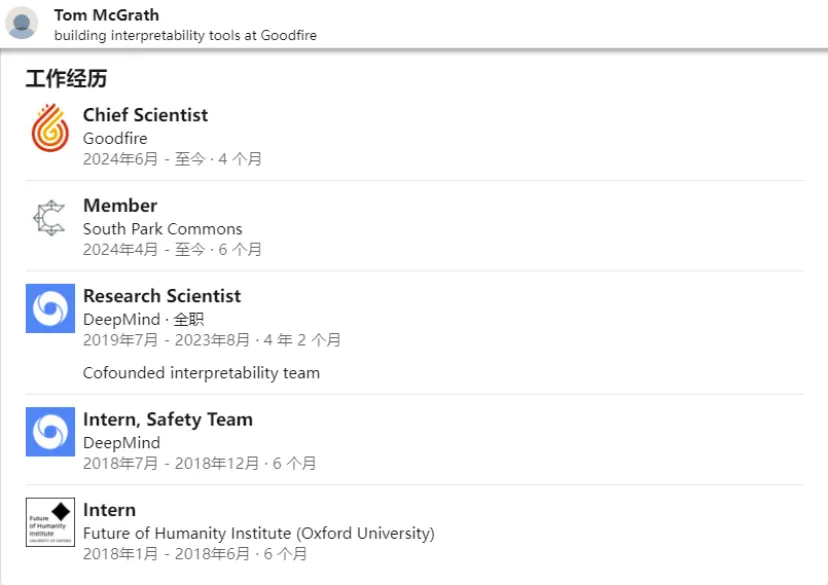

Tom McGrath则在取得帝国理工大学的博士学位后,加入谷歌DeepMind做研究科学家,创立了可解释性团队,主要负责研究AI模型如何推理和做出决策,以及如何使这些模型的内部工作机制更加透明和可理解,在2023年,Tom选择离开DeepMind。在2024年,Tom选择与Dan Balsam、Eric Ho创办Goodfire,并担任首席科学家。

图片来源:Linkedln

Goodfire宣布完成了700万美元的种子轮融资,试图揭开生成式AI模型的“黑匣子”。这轮融资由Lightspeed Venture Partners领投,Menlo Ventures、South Park Commons、Work-Bench、Juniper Ventures、Mythos Ventures、Bluebirds Capital等参与,这将加速Goodfire开发突破性的工具来理解、编辑和调试AI模型。

“Goodfire正在构建软件2.0的IDE,解锁探索、调试和编辑大型语言模型的能力,使我们更接近安全可靠的人工智能。”公司本轮领投方Lightspeed Venture Partners在文章中写到,“Goodfire正在为AI生态系统构建关键基础设施——能解释其他模型的AI模型以及能从这些模型中解锁价值的接口。Goodfire有机会在AI技术栈中开创一个新的领域,以便于非研究人员和在关键任务环境中部署AI的企业使用这些工具。”

Goodfire描述了一个非常诱人的前景——我们可以像今天编写代码那样原子化、可解释地“操纵”AI模型。然而,也留了一个巨大的问号:在众多模型厂商都还未能解决模型黑盒问题的今天,Goodfire作为第三方如何能够解决这个问题,并且能够对多个不同的模型都有效?

Goodfire的官网显示,产品目前尚不可用,用户需要申请加入waitlist。

References:

https://goodfire.ai/

https://lsvp.com/stories/goodfire-building-interpretable-ai/

https://venturebeat.com/ai/goodfire-raises-7m-for-its-brain-surgery-like-ai-observability-platform/

https://siliconangle.com/2024/08/15/goodfire-ai-raises-7m-try-demystify-ai-systems-using-mechanistic-interpretability-techniques/

文章来自于微信公众号“ Z Potentials”,作者“ Z Potentials”