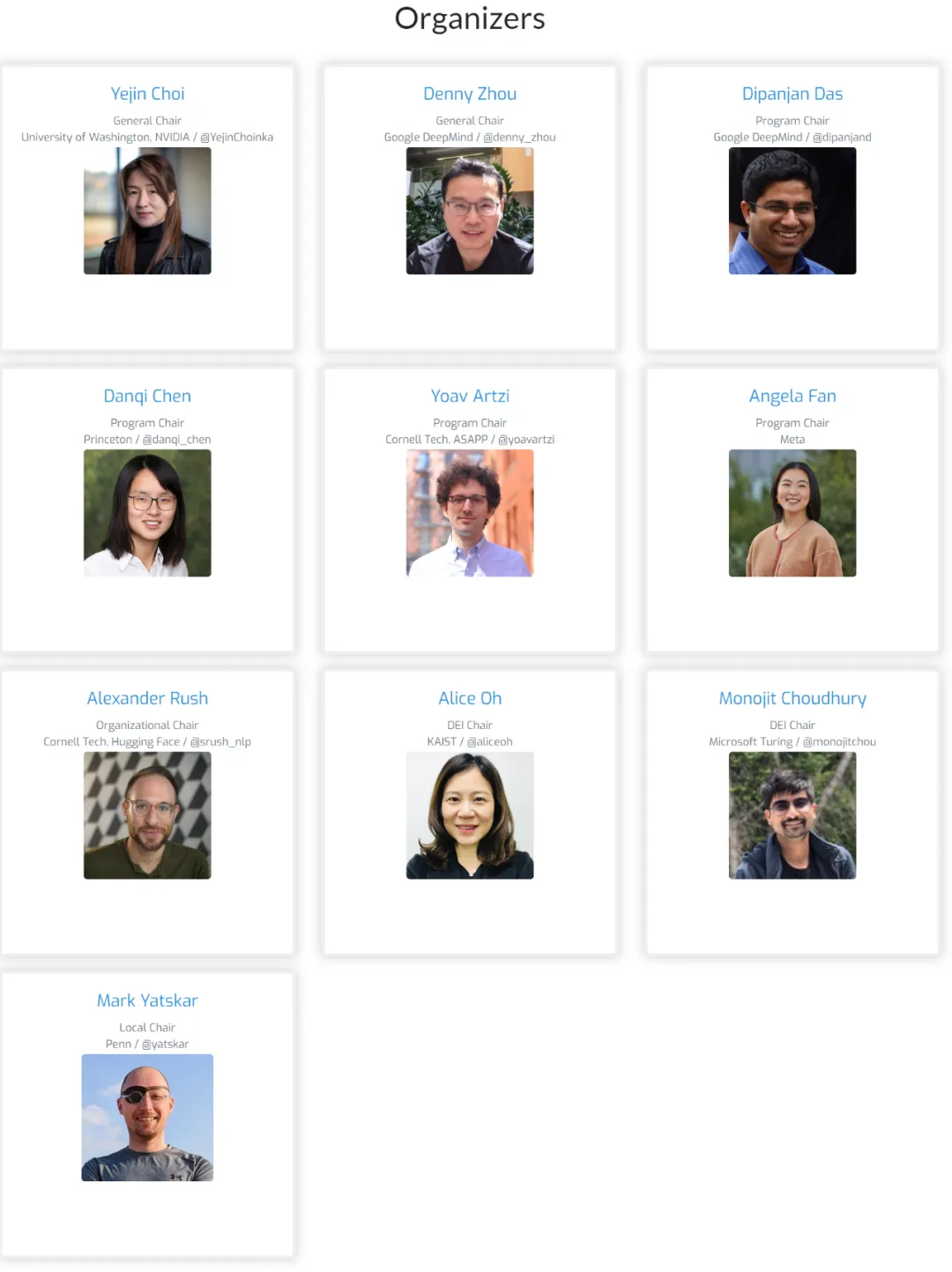

会议组织者都是 NLP 头部科学家,在语言建模方面有着相当的成果。

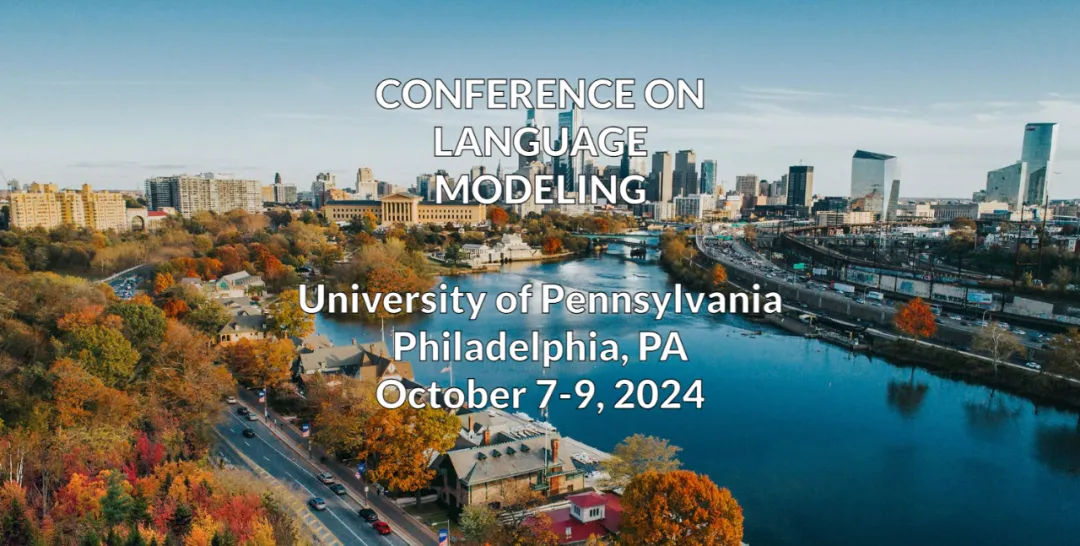

随着 AI 领域的快速发展,大模型逐渐成为研究的核心,为了更好地探索这一领域,2023 年,一批知名的青年学者组织了一个名为 COLM(Conference on Language Modeling)的新会议。

该会议的组织者们都是 NLP 头部科学家,在语言建模方面有着相当的成果。他们其中既有来自业界的研究人员,也有来自学术界的研究人员。

在今年的组织者中,有我们熟悉的陈丹琦、Angela Fan 等华人学者。

COLM 是一个专注于语言建模研究的学术场所,旨在创建一个具有不同科学专业知识的研究人员社区,专注于理解、改进和评论语言模型技术的发展。这不仅是学术界的一次创新尝试,也是搭起了语言模型交流互鉴的新桥梁,进一步促进其探索和合作。

接收论文链接:https://colmweb.org/AcceptedPapers.html

刚刚,大会公布了 2024 年杰出论文奖,共有 4 篇论文获奖。

值得一提的是,号称撼动 Transformer 统治地位的 Mamba 也在获奖论文中。

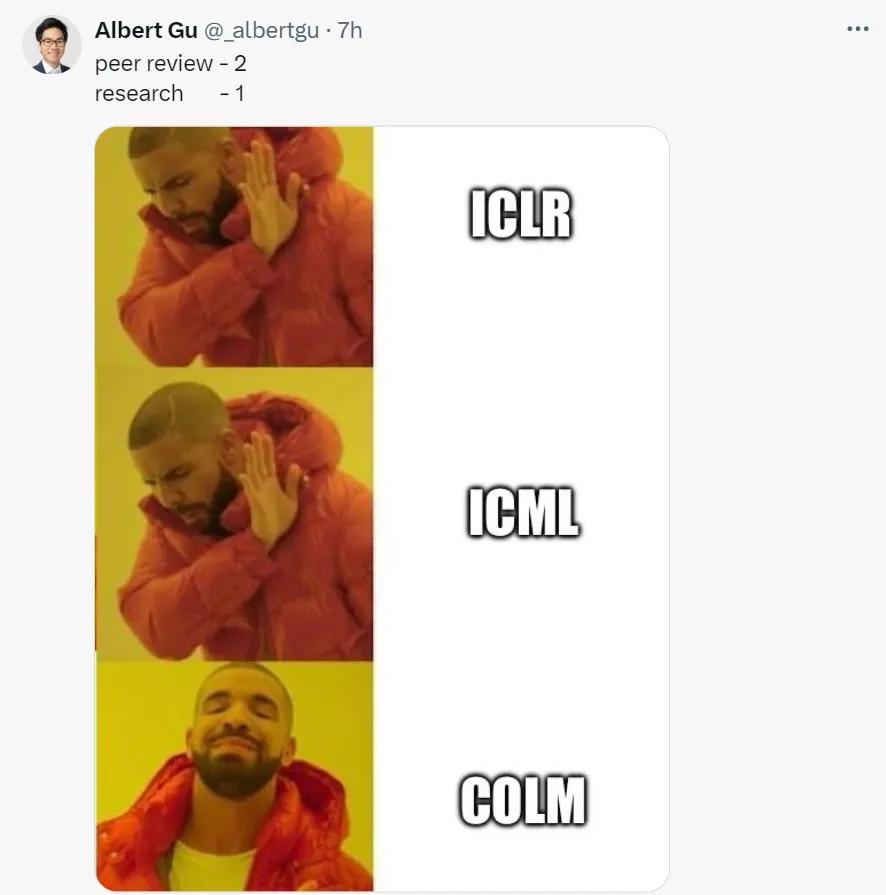

此前,Mamba 这项研究惨遭 ICLR 拒稿,引来学术界轩然大波。

不过,之后 Mamba 原班人马发布的 Mamba-2 顺利拿下了 ICML 2024。如今 Mamba 又获得了 COLM 杰出论文奖,很多网友都送来祝贺。

Mamba 作者之一、卡内基梅隆大学机器学习系助理教授 Albert Gu 用一张表情很好的表达了自己的感受,看来「COLM 是真香」。

论文 1:Dated Data: Tracing Knowledge Cutoffs in Large Language Models

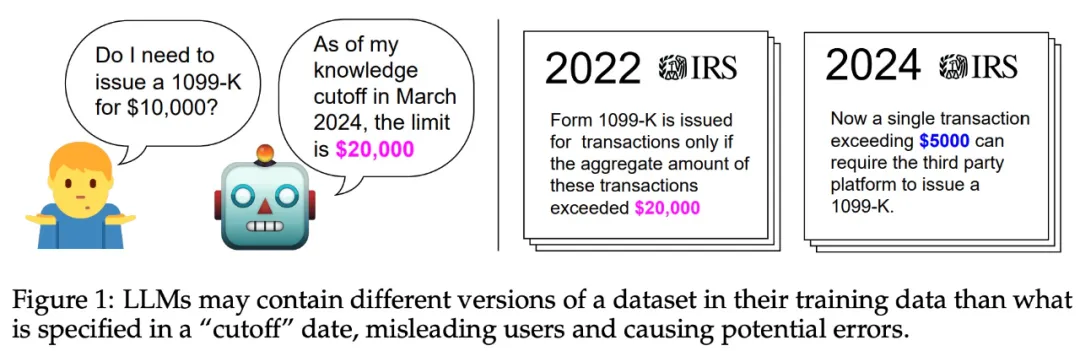

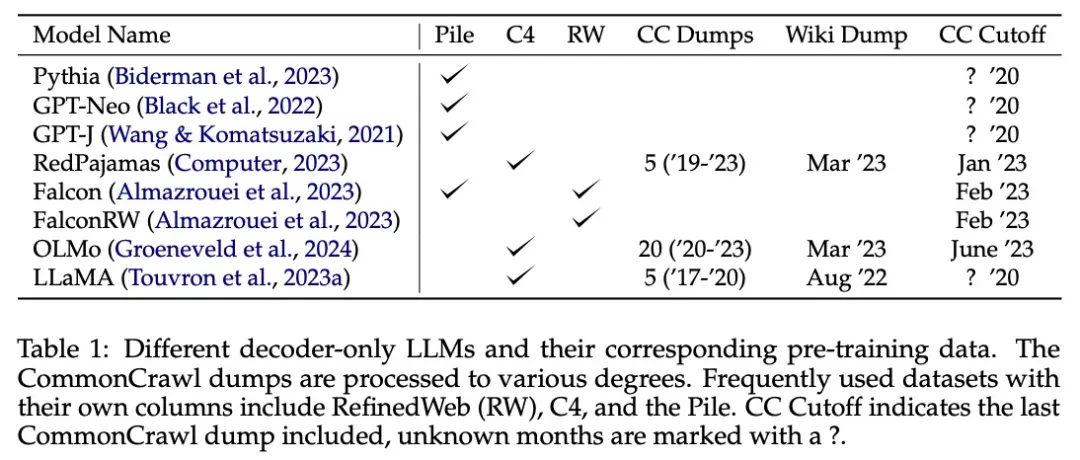

大型语言模型 (LLM) 通常有「知识截止日期」,即收集训练数据的时间。该信息对于需要 LLM 提供最新信息的应用场景至关重要。

然而,训练数据中所有子资源是否共享相同的「知识截止日期」?模型响应展示出的知识是否与数据截止值一致?

该论文定义了「有效截止」的概念,它与 LLM 报告的「知识截止日期」不同,并且训练数据子资源之间也有所不同。该研究提出了一种简单的方法,通过跨版本的数据探测来估计 LLM 在资源级别的有效截止点。至关重要的是,该方法不需要访问模型的预训练数据。

通过分析,该研究发现有效的截止值通常与报告的截止值有很大不同。为了了解这一观察结果的根本原因,该研究对开放的预训练数据集进行了大规模分析。

分析揭示了造成这些不一致的两个主要原因:

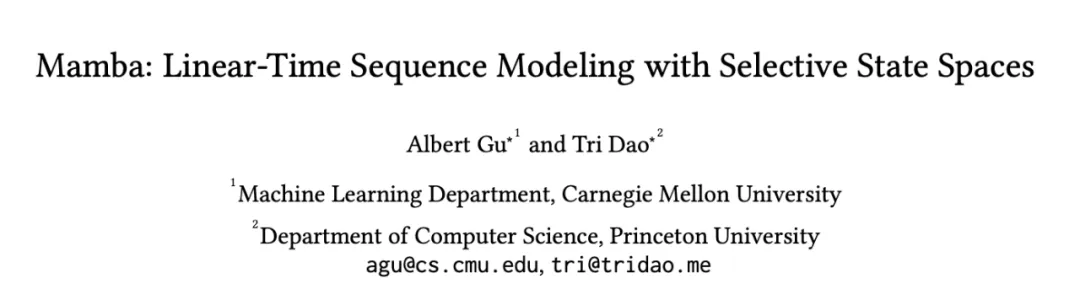

论文 2:Mamba: Linear-Time Sequence Modeling with Selective State Spaces

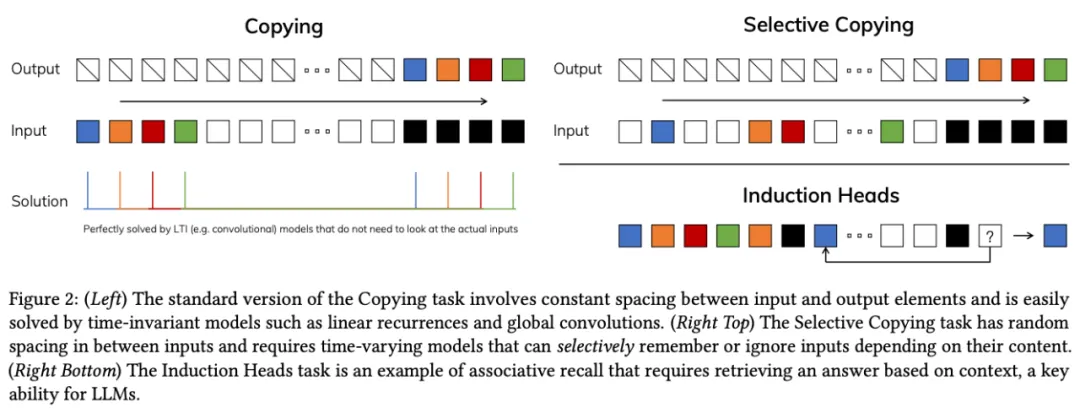

自 2017 年被提出以来,Transformer 已经成为 AI 大模型的主流架构,但随着模型规模扩大和处理序列变长,其计算效率问题凸显,特别是在长上下文中,计算量将呈平方级增长。

为解决这一问题,研究者们围绕注意力开发了多种变体,如线性注意力、门控卷积、循环模型、SSMs 等,但它们在语言等模态上的表现并不理想,无法进行基于内容的推理。

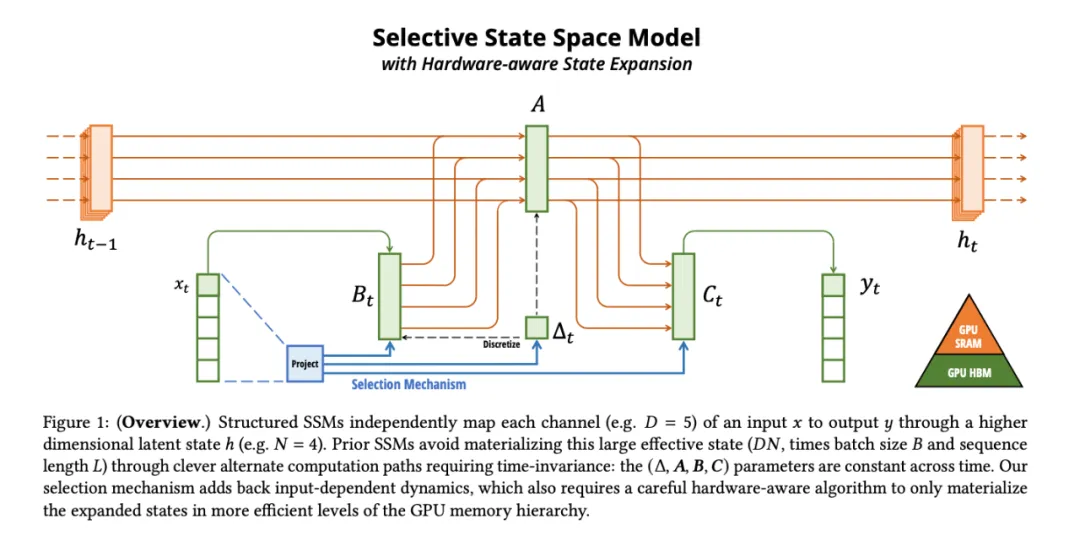

基于此,论文作者进行了几项改进。首先,让 SSM 参数成为输入的函数,解决了离散模态的弱点,使模型能根据当前 token 有选择地传播或遗忘信息。

这种改动导致卷积效率降低,对模型的计算带来了挑战。论文作者设计了一种硬件感知算法,将先前的 SSM 架构设计与 Transformer 的 MLP 块合并为一个块,简化了深度序列模型架构,形成了一种包含选择性状态空间的简单、同质的架构设计(Mamba)。

Mamba 可以随上下文长度的增加实现线性扩展,其性能在实际数据中可提高到百万 token 长度序列,并实现 5 倍的推理吞吐量提升。

作为通用序列模型的骨干,Mamba 在语言、音频和基因组学等多种模态中都达到了 SOTA 性能。在语言建模方面,无论是预训练还是下游评估,他们的 Mamba-3B 模型都优于同等规模的 Transformer 模型,并能与两倍于其规模的 Transformer 模型相媲美。

更多详情,可以参考机器之心之前的报道:五倍吞吐量,性能全面包围 Transformer:新架构 Mamba 引爆 AI 圈。

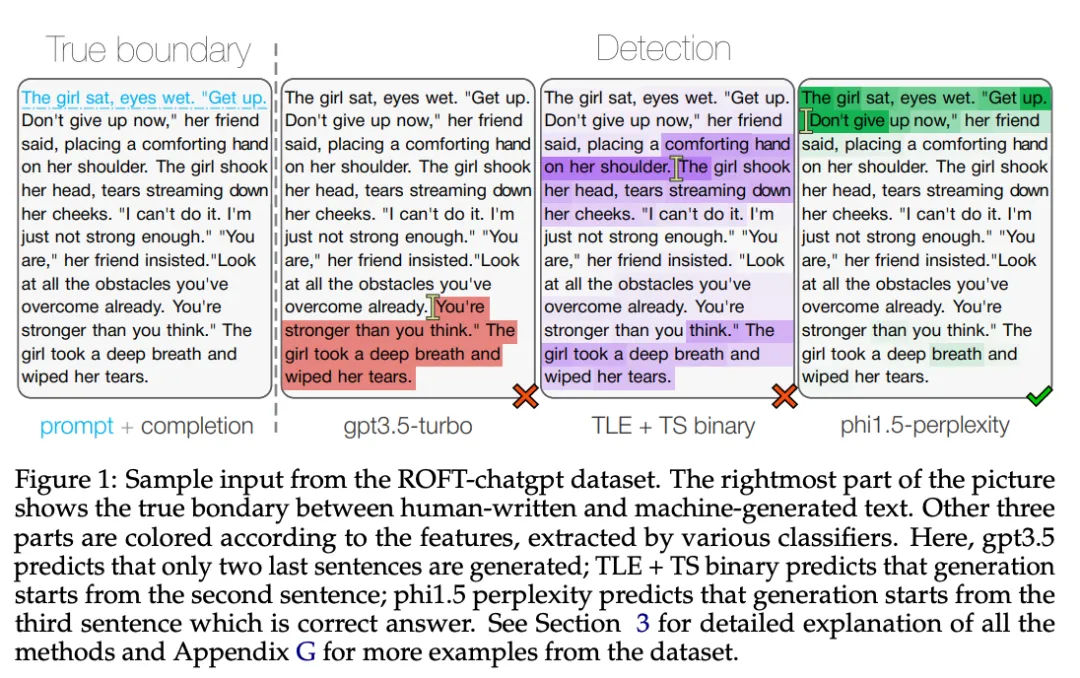

论文 3:AI-generated text boundary detection with RoFT

随着大语言模型的发展,我们越来越频繁地遇到这样的情况:一篇文章起初可能出自人类之手,但随后可能被 AI 接手加以润色。如何从这种文本中检测出人类写作与机器生成的界限?这是一个具有挑战性的问题,但还尚未得到太多关注。

论文作者试图填补这一空白。他们对最先进的检测方法进行了测试。具体而言,他们采用「真假文本」测试集,测试了在极限情况下,这些方法的表现。「真假文本」测试集包含各种语言模型生成的多个主题的短文本。

他们发现,基于困惑度的边界检测方法,在处理特定领域的数据时,比对 RoBERTa 模型进行监督式的方法更加鲁棒。他们还发现了一些特定的文本特征。这些特征可能会干扰边界检测算法的判断,导致算法在处理跨领域的文本时,其性能会下降。

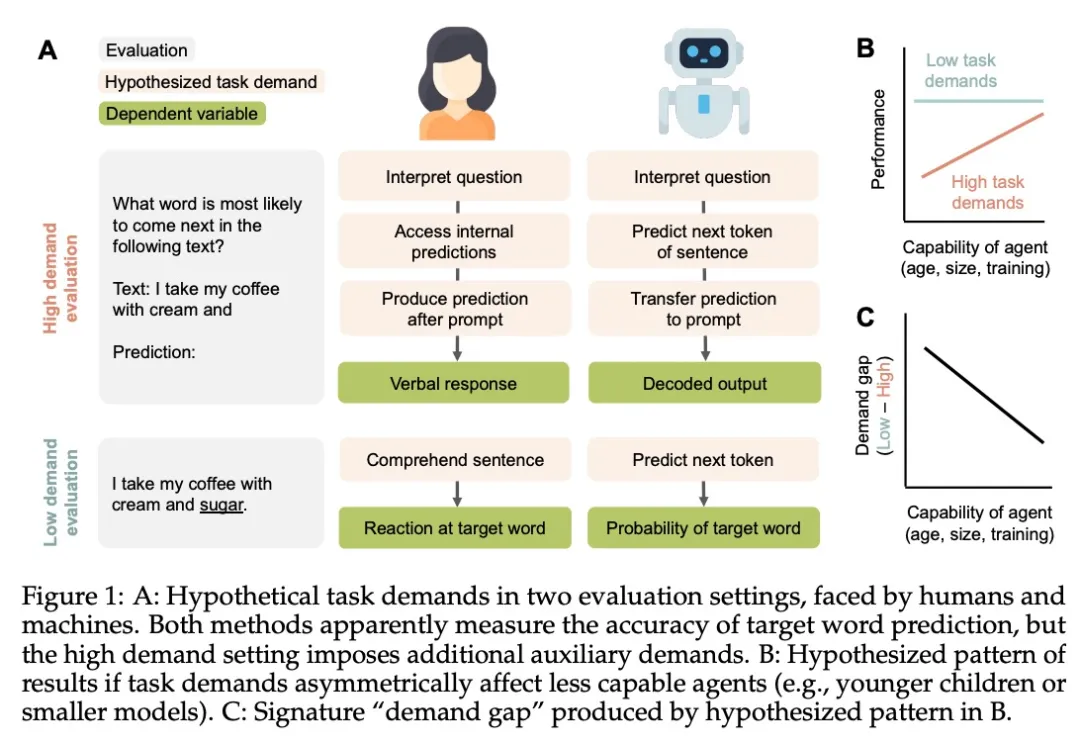

论文 4:Auxiliary task demands mask the capabilities of smaller language models

发展心理学家一直在争论语言理解或心理理论等认知能力何时出现。这些争论通常取决于「任务要求」的概念 —— 与执行特定评估相关的挑战。在衡量语言模型 (LM) 的能力时,任务的性能是模型基础知识的函数,再加上模型在给定可用资源的情况下解释和执行任务的能力。

该研究表明,对于类比推理、反思推理、单词预测和语法判断,任务要求较高的评估方法比要求减少的评估方法产生的性能更低。对于参数较少和训练数据较少的模型,这种「需求差距」最为明显。实验结果表明,LM 的性能不应被解释为智能(或缺乏智能)的直接表现,而应被解释为通过研究人员设计选择的视角所看到的能力反映。

文章来自于“机器之心”,作者“机器之心编辑部”。