国庆节过后,人工智能领域似乎多了几分冷色调。不知道是因为大语言模型(Large Language Model,LLM)的幻觉,还是因为寒露时节的到来。

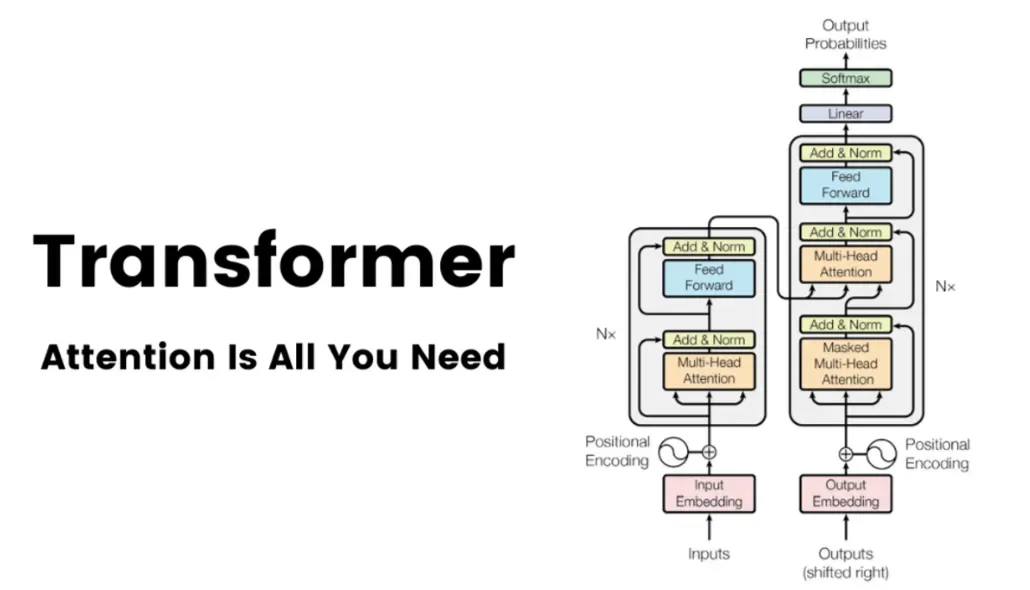

或许人工智能还无法感受到时下的寒意,即便是带有气象传感器的具身智能和端侧Agent。因为这份寒意更多来自于经济圈层和精神层面,现实世界的复杂程度远不是一个采用Transformer及其变体架构的大语言模型所能体会的。

技术上,这一轮人工智能的热潮源自于Transformer架构。而这个让OpenAI最新融资额度达到1570亿美元估值的技术架构,在一些人看来却并不咋地。

不看好并质疑Transformer架构的种种观点,大体可以总结为:

连带着,生成式AI(Generative AI,GenAI)也开始被批判。当然这些批判之声并非只因Transformer架构的技术缺陷,更在于生成式AI爆发以来出现的各种版权、安全等问题与当前经济、社会乃至政治层面的各种冲突。

唱衰大语言模型的声音,也得到了一些投资机构的支持。在国外,高盛就认为生成式AI投入很高而收益太少。Mighty Capital过去两年没有进行AI领域的投资,认为当前的创业项目都被高估了。Next Round Capital Partners的言论更加偏激,预测85%的AI初创公司将在三年内因资金耗尽或者被收购而倒闭。

最近甚至有声音认为OpenAI或者Anthropic最终会以被收购收场,即便OpenAI有很大的可能性能够实现主导上市。

国外关于AI泡沫的声音,从去年开始就没有间断过。

在国内,曾主导滴滴与快的合并的传奇投资人朱啸虎也认为,五年以后可能不会再有独立的大模型公司存在。言外之意明显,大模型公司可能都会被收购,毕竟二、三线大模型创业项目已经在卖身了。

而最近的几个似是而非的传闻,似乎也透露了一些问题。传闻中的国产大模型“六小虎”目前的情况好像都不是很好,在裁员、静默、迷茫中惶惶度日。

国外的大语言模型公司也没有好多少。作为大语言模型领域的风向标,虽然OpenAI估值正在向2000亿美元狂奔,却难掩其骨干离职、持续烧钱、难于赢利、越发向虚的尴尬境地,人们对OpenAI的关注度正在逐渐下降。而Anthropic也越发表现平平,何时赢利仍是个问题。

现在来看,从技术到资本再到商业,没有彰显出大语言模型应有的奋勇直上的姿态,反而是透露了一种难以为继的疲态,要知道LLM的爆发至今仅有短短的2年。为什么很多人都在说LLM不是通往AGI的桥梁?资本市场和应用市场如何看待生成式AI?如何看待“AI六小虎”传闻?LLM真的不能长久吗?

本文,王吉伟频道结合近期的行业动向,跟大家聊聊这些。

2023年3月下旬,ChatGPT如日中天LLM Based AI Agent崭露头角之时,未来生命研究所(Future of Life Institute,FLI)发布了一则公开信,呼吁所有人工智能实验室立即暂停训练比GPT-4更强大的人工智能系统至少6个月。

信中写道,广泛的研究表明,具有与人类智能竞争的人工智能系统可能对社会和人类构成深远的风险这封信得到了包括马斯克等在内的1000多科技领袖和研究人员的签名。

有意思的是,这封信发出后或许没让多少人重视AI的安全,反而坚定了更多人相信LLM能够实现AGI的信心。

但一些人也认为,LLM与AGI的距离就像人类在火星上定居一样遥远。甚至有人认为,OpenAI将AGI的进展倒退了5到10年。因为现在所有人都在做LLM,使得其他研究和出版越发缓慢。

Meta首席人工智能科学家杨立昆(Yann LeCun)认为,在某种程度上,AI 模型的“智能”程度取决于它所训练的数据,像 ChatGPT、Google的Gemini或Meta的 Llama这样的LLM永远不会达到人类的智能水平。

在通往人类水平智能的道路上,LLM基本上是一种"off-ramp"(岔路)、"distraction"(干扰)和"dead end"(死胡同)。这意味着LLM并不能有效推动我们实现人类水平的人工智能,反而可能会分散我们的注意力,让我们误入歧途。

甚至连OpenAI的CEO Sam Altman也曾表示,他不认为仅仅通过扩大LLM的规模就能实现AGI,对当前LLM在实现AGI方面的潜力持保留态度。所以也有观点认为,未来GPT-5会不会继续采用Transformer架构尚未可知。

目前主流的AI模型和产品,比如ChatGPT、Sora、Bard、Claude、Midjourney、ChatGLM、Baichuan、Kimi 等都基于Transformer架构。

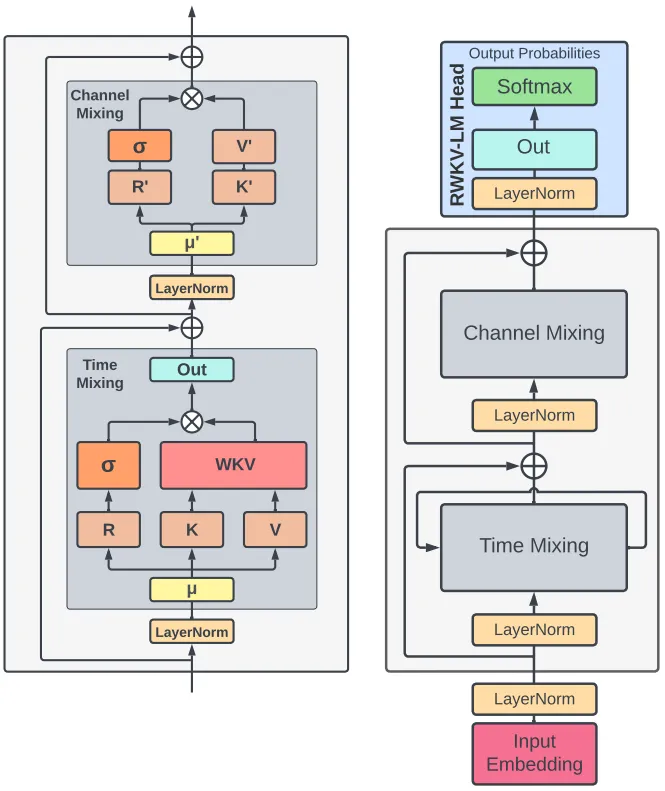

在RWKV(Receptance Weighted Key Value,一种结合了递归神经网络和Transformer模型优点的新型架构)论文作者彭博看来,现实世界不是基于Transformer逻辑去做推理来运转的其运转规律是基于类似RNN 结构的。这个世界的下一秒,不会跟你过去所有的时间、所有的信息相关联,只会跟你的上一秒相关联。但Transformer 要辨认所有的 token,这是不合理的。

RWKV架构图

之所以说基于Transformer架构的LLM不是通往AGI的桥梁,综合各路大神的观点与看法,主要原因归结于LLM的技术局限性,表现为以下几点:

人类智能的核心在于持续的实时学习,这得益于大脑的可塑性和神经连接的动态形成。相比之下,LLM在训练后被冻结,以批处理方式进行学习,缺乏实时反馈和动态适应的能力。

数学上,这种限制源于它们在固定向量空间中的映射关系,无法随着新数据的发展而调整。为实现实时学习,需要将Sobolev空间中的动态映射引入。

大脑的记忆系统是复杂而动态的,能够根据上下文和情感不断调整。然而,LLM的记忆是静态的,仅以固定权重存储知识,缺乏动态整合能力。

虽然有一些内存增强技术(如RAG和神经图灵机)试图引入外部记忆,但它们的计算成本高,且无法实现实时学习和适应性召回。这种离散的记忆机制,使得LLM无法实现真正的上下文感知和联想学习。

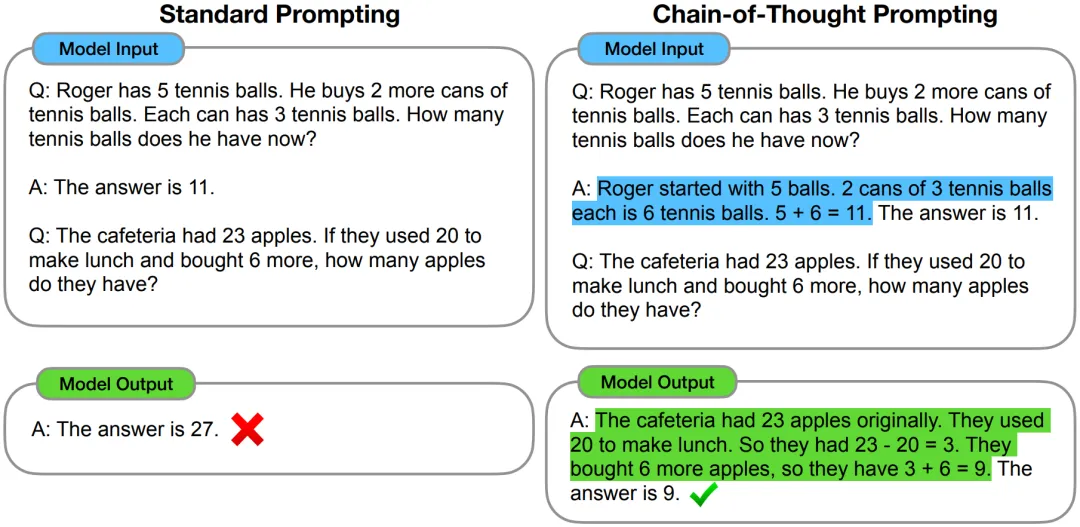

尽管思维链(CoT)推理、上下文学习和元学习(如MAML)被认为是改善LLM性能的潜在解决方案,但它们仍未达到真正的通用智能(AGI)所需的流动智能。

这些方法提高了特定任务的表现,但模型依然依赖于固定的训练模式,无法进行实时动态调整。大脑能够通过每次体验重构其突触网络,而LLM则需要繁琐的微调过程。

人脑以极高的能源效率运作,能在仅20瓦的功耗下执行1 exaflop的计算。相比之下,LLM的训练和推理过程能源密集,消耗数兆瓦的能量。

尽管有可能通过事件驱动架构和脉冲神经网络(SNN)来提高能效,但当前的LLM仍未能达到大脑的能效水平。

大脑的可塑性使其能够根据新信息和环境变化重组神经连接,支持持续学习。相对而言,LLM的参数在训练后固定,缺乏根据新信息自我重组的能力。

这种可塑性的缺失限制了LLM在新挑战下的适应能力,真正的AGI需要具备动态重新配置内部结构的能力,以降低运营成本并提高效率。

这些局限性,也就是不看好LLM者常说的:Transformer 效率不高,天花板易窥见,计算成本高昂且占用内存,资源浪费严重。

并且LLM的这些局限性,很难或者无法从根本上改变,这也决定了LLM不会把人工智能带向AGI。从局限性角度解读LLM不能带来AGI的文章,大家还可以参考下面几篇:

Why LLMs Will Never Lead to AGI:https://medium.com/autonomous-agents/why-llms-will-never-lead-to-agi-aa7bcff9805d

Why Large Language Models are not the route to AGI:https://www.linkedin.com/pulse/why-large-language-models-route-agi-sandeep-reddy/

Why LLMs Will Never Be AGI:https://chrisfrewin.medium.com/why-llms-will-never-be-agi-70335d452bd7

鉴于Transformer的局限性,便出现了许多非Transformer架构,其中比较有影响力的包括中国的RWKV、Meta 的Mega、微软亚研的Retnet和Mamba、DeepMind团队的Hawk和Griffin等,这些架构都是在Transformer大模型火爆之后提出的。

可以看到,在这个名单里除了RWKV架构是创业项目,其他架构都是科技巨头推出的,其中似乎也映射了他们对Transformer无法实现AGI的看法。

需要说明的是,作为国产开源的首个非Transformer架构大语言模型,目前RWKV已经迭代至第六代RWKV-6。

有意思的是,跟OpenAI深度绑定的微软已在Windows系统集成了RWKV,数据显示在9月份win10+win11的装机量已经达到15亿,验证了该架构的实用性。

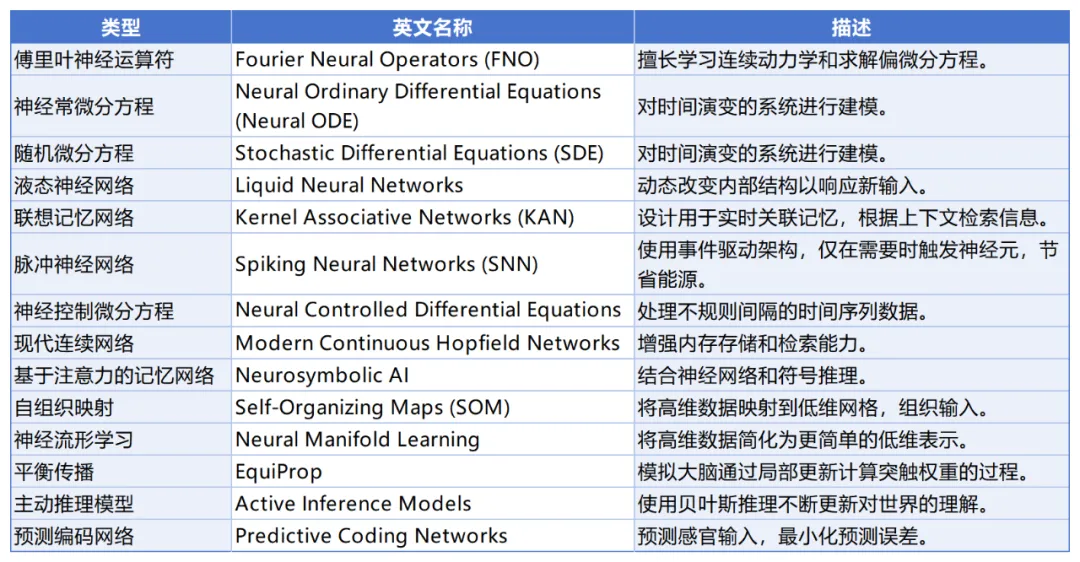

出现问题,就要解决问题。为了克服LLM的限制性,研究者们也正在探索新的数学框架和AI架构,以模拟大脑的自适应、上下文感知和节能特性。一些比较有发展潜力的(初步)方向,如下图:

从各种研究方向以及LLM当前面临的问题来看,未来AGI的实现定然不会只依赖于一种模型,而是需要多种模型的组合和协作。LLM只是诸多模型中率先实现突破并且卓有成效的,使得今天的技术、生态、商业乃至资本都在重度往这个领域倾斜。

Transformer已经形成垄断地位,无论资源还是生态,非Transformer研究都差了很多。目前研究非Transformer新架构的团队要么在学术界,要么是体量很小的创业团队,很少有大公司投入一个大的团队来研究新架构。

目前行业的整体方向,如同在一个不太正确的方向上压重注,导致更多的资源投放到Transformer技术的研究上而忽略其他方向,压缩了非Transformer的生存空间,这也是一些人斥责LLM会把AGI的实现时间缩短5-10年的主要原因。

除了技术领域频频吐槽基于Transformer的LLM,一些投资机构也对生成式AI颇有看法,乃至于非常看衰GenAI,认为这波炒作所带来的AI泡沫即将破裂。

以OpenAI为例,在今年早些时间募资时,很多投资机构都认为其1000亿美元的估值太高。其新一轮融资最终以1570亿美元的估值,但苹果放弃了这一轮融资,于2021年投资OpenAI的红杉资本没有跟投。

还有一些投资机构对投资AI非常慎重,比如风险投资机构Mighty Capital过去两年都没有进行AI领域投资,认为价格被高估了。专注AI领域的投资机构Thrive Capital在与一些LP、主权财富基金和大型机构投资者沟通中发现,一些机构面临收入回报压力,已拒绝让VC投资风险高的项目。

高盛在《GEN AI: TOO MUCH SPEND, TOO LITTLE BENEFIT?》报告中对于AI的投资回报做出了质疑:尽管预计未来几年科技巨头和各类企业将在AI相关领域投入约1万亿美元,但截至目前这些投资似乎并未带来显著成果。

在报告中,麻省理工学院教授Daron Acemoglu也对AI的前景持保留态度,预测未来十年内,只有大约四分之一的AI任务能够实现成本效益的自动化,AI可能只会使美国的生产力增加0.5%,GDP增长累计增加0.9%

高盛策略师Ryan Hammond团队报告称,科技巨头在AI领域的大量投资尚未产生相应的收入和利润,可能导致估值贬值。高盛全球股票研究主管Jim Covello更为谨慎,认为AI必须解决复杂问题才能实现合理回报。

当然,高盛内部目前对AI的看法并不一致。一些分析师认为,即使AI技术的基本叙事最终无法在资本市场站住脚跟,AI泡沫也可能需要更长时间才会破裂。另一些分析师则持怀疑态度,认为AI自动化任务不到5%,且AI技术的成本高昂,且并非为解决复杂问题而生

红杉资本合伙人认为,按照当前的投资成本,要保证50%的利润,需要赚到6000亿美元。这个数字是基于当前GPU和云服务投资的预测。福布斯则认为红杉的估算是乐观的,实际回报可能更低,除非生成式AI出现杀手级应用。

但越来越多的华尔街分析师对AI的热情也在减退,认为AI技术尚未达到实用水平,投资过度可能导致不良后果。

在国内市场,金沙江创投合伙人朱啸虎在“创投十年”高峰论坛上的分享中,关于大模型创业提到了两点:

一是如果到年底不能推出GPT-5,OpenAI和英伟达的股价可能都要狂跌;二是五年以后可能不会再有独立的大模型公司存在,要么只有AI应用公司,要么就是云服务。

虽然他不看好大模型创业但看好生成式AI应用,这一点我们在后文还会提及。

除了资本市场,在应用市场一些研究机构对GenAI的看法也不是很乐观。

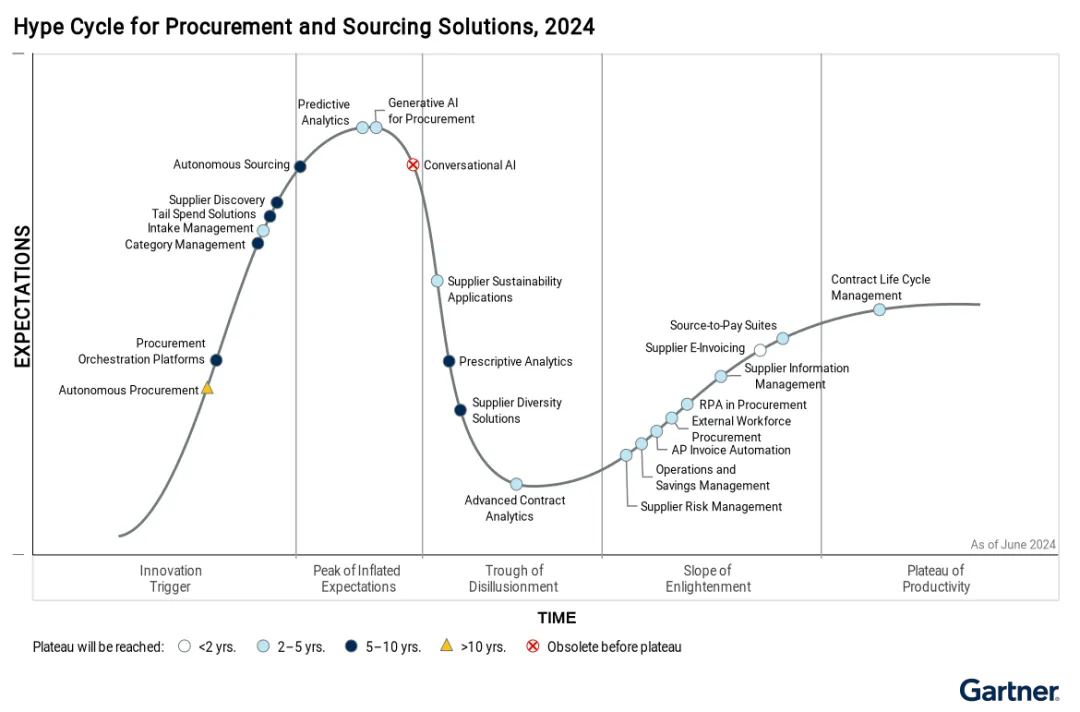

根据Gartner 7月发布的最新炒作周期报告,用于采购的GenAI已经达到了“高估期望的峰值”。这个阶段之后是“幻灭的低谷”,一个“由于实验和实施未能实现”的兴趣减弱的时期。

▲ 2024 采购和寻源解决方案技术成熟度曲线,点击看大图

虽然GenAI可能会从现在开始迅速成熟,在2到5年内达到“生产力平台”,但达到这一点的道路可能不会一帆风顺。Gartner估计,到2025年底,至少有30%的GenAI项目将在概念验证后被放弃。

参考链接:https://www.gartner.com/en/newsroom/press-releases/2024-07-29-gartner-predicts-30-percent-of-generative-ai-projects-will-be-abandoned-after-proof-of-concept-by-end-of-2025

市场研究开始证实这一点。软件公司Asana对1200多名IT专业人士进行了调查,发现四分之一的受访者后悔如此迅速地投资了AI。Boston Consulting Group发现,三分之二的高管对其组织在AI方面的进展持矛盾态度或不满意。

SaaS公司WalkMe 表示,自从开始使用这些技术以来,一半的美国办公室工作人员的工作没有得到改善。

参考链接:https://ir.walkme.com/news-releases/news-release-details/walkme-discovers-workplace-ai-sos-we-need-help-along-way

今年4月,麻省理工学院经济学家Daron Acemoglu的一篇论文引起了轰动,该论文预测了AI“非平凡但适度”的经济利益。与高盛和麦肯锡相反,阿西莫格鲁预计未来10年的GDP增长不会超过1.16%,而生产率增长仅略高于半个百分点。

《经济学人》7月份的一篇文章则更为犀利,指出“到现在为止这项技术几乎没有对经济产生任何影响”。

Daron Acemoglu论文:https://economics.mit.edu/sites/default/files/2024-04/The%20Simple%20Macroeconomics%20of%20AI.pdf

在Daron Acemoglu看来,每个人都在疯狂地冲刺,想用AI做一些事情,却不知道自己在做什么。这些技术还不够成熟,将导致大量中断和不必要的自动化,并且可能会降低公司提供的产品和服务的有效性。

在具体应用层面,Gartner研究主管Pieter J. den Hamer表示,市场内部对GenAI的失望感正在加大。特别是对于在ChatGPT病毒式传播后开始投资GenAI的公司来说,他们越发意识到GenAI并不是灵丹妙药。GenAI是一项非常强大的技术,但像任何其他技术一样,它需要仔细分析研究后才能有效使用。

他指出,许多CIO投资于AI是为了提高生产力。当他们努力量化这些收益时,挑战就会进一步出现。在Gartner 最近的一项调查中,近一半的IT领导者表示,他们在确定AI的商业价值时遇到了问题。

参考链接:https://www.gartner.com/en/newsroom/press-releases/2024-05-07-gartner-survey-finds-generative-ai-is-now-the-most-frequently-deployed-ai-solution-in-organizations

den Hamer表示其看到的目前最成功的应用是将AI 应用于客户服务。以呼叫中心座席可以处理的电话数量来衡量,平均生产力大概提高10%,但前提是员工技能得到提升并能够有效使用AI。在营销领域也是一样,需要适当培训员工并让他们适应新的工作方式,否则成效就会小很多。

事实上,Gartner调查发现,目前只有9%的企业被归类为“AI成熟”。他们与众不同的是可扩展的AI运营模型、对AI工程的关注、对提高员工技能的投资以及更好的风险管理能力。

网络安全咨询公司SkySiege的首席工程师Andrew Southall认为,风险管理能力很关键。他与许多客户合作,这些客户对他们的GenAI投资感到后悔,不仅因为商业价值被误解和高拥有成本,还因为“数据中毒”等安全问题。

从技术供应而言,目前像微软这样的生产力和商业软件领域的领头羊,也没有真正找到愿意为此付费的客户。

The Information 称,微软365套件的客户对 AI 驱动的“Copilot”产品几乎没有太多兴趣。在 4.4 亿个用户中,只有 0.1% 到 1% 的用户愿意为这些 AI 功能付费。

一家测试了这些 AI 功能的公司表示,“大多数人目前并不认为它具有太大价值”,还有人说,“许多企业没有看到在生产力和其他方面的显著改进”,他们“不确定何时才能看到”。

要体验这些功能,需要每人每月额外收取 30 美元。对于所谓的“Copilots for Sales”,则每月额外收取 50 美元。如果按年支付,这也将是一笔不小的费用,因此很多企业对此并不太感冒。

对于这种技术与市场脱节的情况, 公共关系公司EZPR首席执行官Edward Zitron在名为《The Subprime AI Crisis》的博文中写道:

整个行业对生成式 AI 的大规模投入,结果却只是出现了四、五个几乎相同的大语言模型、世界上最不盈利的初创企业,还有数千个价格昂贵且令人失望的集成产品。

他认为目前我们正在面对一种共同的幻觉:一种死胡同一样的技术,它依赖版权盗窃、需要持续的资本注入,同时它所提供的服务在最好的情况下也是非必需的,它被包装成一种尚未实现的自动化,耗费了数十亿美元,而且可能会永远如此。生成式AI不单单靠金钱在运行,还有信仰,问题是信仰是一种有限的资源。

参考链接:https://www.wheresyoured.at/subprimeai/

这么犀利的笔锋,透露了Edward对AI行业的极度担心。

9月初,几则关于大模型公司现状的传闻,似乎在印证资本市场及应用市场目前不太认可大语言模型的情况。

一则来自于橘子汽水铺,整体提到了大模型创业公司的现状。

一则来自于AI暴躁吐槽君,介绍了几个创业公司的运营情况。

经过一个多月的发酵,已经有更多人看到了这些传闻。而在36氪最新的报道中,“AI六小虎”(智谱、零一万物、MiniMax、百川智能、月之暗面、阶跃星辰)中已经有两家逐步放弃预训练模型,缩减了预训练算法团队人数,业务重心转向AI应用。

参考链接:https://36kr.com/p/2985143610892032

在王吉伟频道看来,重点发力AI应用也没什么不好,光守着大模型不能变现没啥用,毕竟更好地活着才更有希望。

但这则报道,也让之前的传闻越发真实起来。

针对传闻及报道中“某些公司放弃预训练”的说法,李开复已经发朋友圈辟谣,称零一万物一直在做预训练。

其实传闻就是如此,你不管它别人也就是猜猜罢了。但若是认真,则有可能坚定别人的看法。

既然是传闻,大多可能会是捕风捉影。但无风不起浪,真实情况可能不会像传闻中说的那么严重,但还是为国内AI圈披上了一层悲观色彩。

即便没有这些传闻,还有朱啸虎的预测。其“未来5年不会有独立大模型公司”的说法,几乎是预判了大模型创业公司的命运,比这些传闻还要严重的多。

假设这些大模型创业项目的生命周期只有五年,现在出现这样的情况也就再正常不过了。

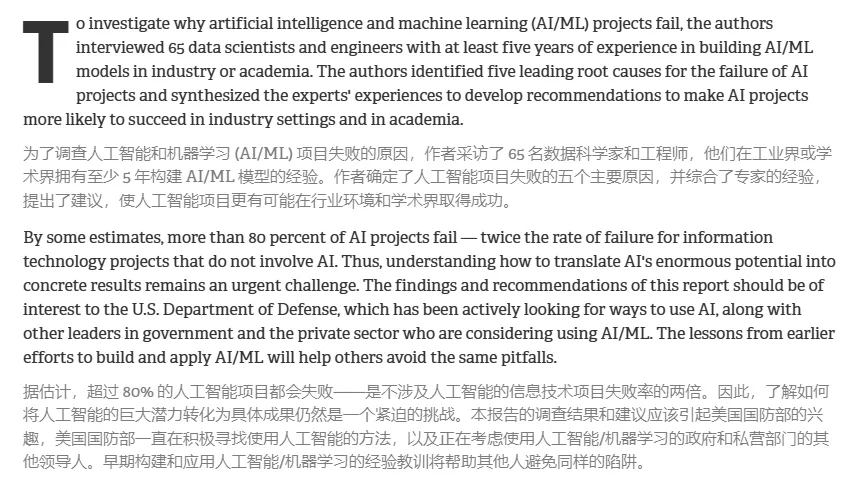

即使没有朱啸虎的预测,也还有最近兰德公司(RAND Corporation)的研报。其所发布的报告《The Root Causes of Failure for Artificial Intelligence Projects and How They Can Succeed Avoiding the Anti-Patterns of AI》超过80%的AI项目失败了,是不涉及AI的信息技术项目的失败率的两倍,浪费了数十亿美元的资本和资源。

报告指出了项目失败的几个原因:利益相关者之间目标不一致、过度关注并应用AI而不考虑其价值、缺乏正确准备的数据集、基础设施不足以及AI与手头问题不兼容。它还指出,这些问题不仅限于私营部门:即使是学术界也对 AI 项目存在问题,其中许多项目只专注于发布AI研究,而不是查看现实世界的成果应用。

报告的观点,与李彦宏之前的看法不谋而合。他也曾表示,中国有太多的大型语言模型,浪费了大量资源,因为这些模型通常几乎没有实际的实际应用。

这大概也是很多投资机构,不敢再贸然投资大模型项目的重要原因之一了。

其实不只在中国,全球大模型项目面临的情况都是一样的。

虽然OpenAI估值已达1570亿美元,但仍需应对高达数十亿美元的年度亏损,以及未来几年巨额的运营成本。根据公司的财务文件预测,OpenAI在2026年将亏损140亿美元,并且这一预计并不包含股票薪酬,这是OpenAI最大的支出之一。

OpenAI公司预测,未来几年模型训练的计算成本将大幅上升,到2026年将高达每年95亿美元,其中不包括大模型研究的前期训练成本。预计到2030年将花费超过2000亿美元,其中60%至80%将用于训练和运行模型。

至于赢利,OpenAI预计,在2023年至2028年期间公司的总亏损将达到440亿美元,直到2029年才能实现140亿美元的利润。

Anthropic首席执行官也表示,当前AI模型训练成本是10亿美元,未来三年这个数字可能会上升到100亿美元甚至1000亿美元。

这意味着,这两个代表性大模型项目,在赢利之前都将继续边烧钱边融资。而全球大模型创业项目,基本都在向这两个项目看齐。

当前AI行业仅是训练成本,就已经超过5000亿美元,收入却是寥寥。如果未来全球大模型项目都是这样的投入和产出,大部分资本投入都不会转化为收益。面对5年之后才有可能实现盈利的局面,又有多少公司和投资机构能够坚持下来?

所以,才会有那么多人担忧AI会成为泡沫,并可能在被戳破之后导致新的经济危机。

大语言模型不像微软Windows这样的系统,成为企业业务数字化运行的软件必需,也不像iPhone一样成为人们工作、学习、生活的硬件必需。它的推出并没有以终端产品的形态让大家随手可用,而是需要一定的学习门槛才能更好地使用。

同时技术提供的方式让它跟其他技术供应商没有什么区别,服务各个企业与平台的方式给产业链上下游带来的好处,但也让其利润进一步摊薄。虽然创造了GPT Store这样的商业模式,但想要打造出APP Store一样的完善生态系统需要一定的时间,这足以出现更多的商业竞争对手。

而想要进一步弥补大语言模型的技术局限与能力不足以高效应用于生产,又需要更多厂商和用户投入更多资源与精力。想要能力更加出众,就需要投入更多资源烧更多的钱。此外技术突进与安全管理的矛盾,也一直是各个厂商的重头戏。

大语言模型属于大力出奇迹,但是大力的背后是持续烧钱。

当然,并不是说大模型以后就没有希望了。

OpenAI虽然烧钱严重,但其发布的模型一直都是行业领先的,并且得到了一些大客户的器重。保持足够的优势,拿到投资的可能性也就更大。如果两年内能够转型成为盈利性企业并完成上市,届时可以获得更多投资。

当然OpenAI的营收能力也在不断提高,2026年的亏损高峰后,2027年、2028年亏损幅度或将大幅收窄。

所以现在的OpenAI一切向钱看无可厚非之,毕竟活着才有更多可能。

对比OpenAI,国内一众大模型项目如果能够做到某垂直领域领先,能够为某些用户群体提供稳定、高效应用服务,在业务精进且逐步盈利的情况下进一步获得融资的可能性也会更大。

此外,在更加“省钱、省力”的非Transformer架构模型上做点文章,用小体量模型做一些大模型的事,也是一个值得考虑的方向。

今年以来,国内大模型项目基本都已拿到新一轮融资。7月份百川智能完成50亿元A2轮融资;8月份零一万物、月之暗面已完成新一轮融资,月之暗面估值已达到33亿美元;9月智谱再次拿到继中东财团之后的新一轮融资,已在两年内完成6轮融资。

相关数据统计,截至8月份,国内大模型公司融资金额在亿元级别的有20起。“新AI六小龙”(零一万物、MimiMax、百川智能、智谱AI、阶跃星辰、月之暗面)中有五家公司今年已获得亿元级融资,另外一家也传出正在融资的消息。

其中,月之暗面在8月完成新一轮腾讯投资的3亿美元融资后估值已达33亿美元,9月份智谱再次拿到继中东财团之后的新一轮融资,实现两年内完成6轮融资。

国有资本和大型科技公司的不断注资,不但为这些大模型项目提供了源源不断动力,也在助力这些项目更好的完善生态以及更多的行业资源。

在技术上国产大模型相对滞后一些,但这并不妨碍大模型在一些领域的落地与应用。只要能够推出适合国内企业的技术、产品与解决方案,这片土壤养活几个大模型厂商绰绰有余。

虽然基于Transformer架构的LLM不是连接AGI的最终桥梁,但它注定会在这个阶段发光发热,且它的发展空间远未触顶,在这个进程中将会创造足够的商业及社会价值。

而那些大模型项目,不管最后是卖身还是独立发展,它们的努力和创新都能为国产大模型的进程贡献一份应有的力量。

高盛的报告在担心AI投入过多收益太少的同时,也预测未来数年内将有约1万亿美元的投资用于生成式AI及相关基础设施,只是目前这些投资似乎并未带来显著成果。

摩根士丹利认为市场对微软在AI货币化方面的担忧导致其股价承压,但对微软AI业务的商业回报增长持信心。

朱啸虎认为生成式AI可能是像PC互联网和移动互联网一样以十年为单位的长周期的机会,并认为大模型迭代速度放缓应用创新的机会就会增多,今年开始在AIGC应用端可能会出现大量机会。

最近跟一位年轻的朋友交流工作时,他说经常用Kimi搜索和查找相关资料。而我周围的几个长辈,手机上竟也装着豆包。

这,就是大模型应用不错的开始。

文章来自于“王吉伟”,作者“王吉伟”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner