2024 年诺贝尔化学奖颁发给了在计算蛋白质设计和蛋白质结构预测领域做出突出贡献的三位科学家,凸显了人工智能和计算方法在解析生物语言中的关键作用,也预示着 AI 技术在生物医药领域更为广阔的应用前景。

然而,药物研发作为一个漫长而艰难的过程,10 年、10 亿美元、10% 成功率的「魔咒」仍然困扰着整个行业。尽管人工智能已经在多个环节展现出巨大潜力,业内专家普遍认为,距离 AI 药物研发发展成熟甚至带来颠覆性改变还需要很长一段时间。大模型的出现,为加速这一进程提供了新的契机。

本期机器之心《智者访谈》邀请到清华大学聂再清教授,探讨他在将先进的自然语言处理技术应用于生物医药数据分析的创新实践。聂教授及其团队正致力于构建生物医药领域的基座大模型,通过对不同尺度和不同模态的数据进行建模及整合,建立起生物语言与自然语言之间的桥梁。

团队的目标不仅仅是实现自然语言与生物语言之间的翻译,而是打造一个能够调用各种工具的智能助手。这个助手有望成为生物医药行业应用的重要入口,整合领域内的各种数据、知识和工具,并且使用自然语言与人类专家交互,通过人机协作提升药物研发的效率与成功率。在当前的技术背景下,相较于单纯研发更好的 AI 药物模型,这种模式具有更高的商业可行性。

基于大模型的对话式药物研发助手 ChatDD 界面,用户通过自然语言进行智能搜索、工具调用和指令输入,包括对生物语言(如蛋白质结构)进行优化。例如,专家可以输入自然语言要求「优化这个分子以减少毒性」,模型随后会提供相应的建议和方案。来源:水木分子

如果说数学是描述物理学的完美语言,那么人工智能则被认为是破译生物学复杂机理的关键。在访谈中,聂教授将分享其团队在自然语言与生物数据融合方面的前沿研究成果,探讨基于多模态大模型的对话式智能助手在药物研发中的实际应用与商业潜力,为我们揭示人工智能赋能药物研发的全新可能。

时间戳

01:15 药物研发痛点:干湿实验不结合

02:28 做基于大模型的对话式药物研发助手

06:30 构建生物医药领域的基座大模型

10:03 多尺度建模与融合:统一到原子

17:45 药物研发助手 ChatDD

21:16 商业模式:最终目标是成为行业入口

25:38 哪些行业适合研发垂直大模型?

28:37 药物研发的未来

机器之心:聂再清教授好,非常高兴您做客机器之心的《智者访谈》。我们知道您在自然语言处理和语音识别等方面有着深入的研究和实践,目前在清华大学智能产业研究院(AIR),主要从事生物医药相关的研究工作,并且在 AlR 孵化的公司水木分子担任首席科学家,很高兴能与您就 AI 赋能药物研发进行探讨。

您之前讲过在药物研发领域,一个核心的矛盾就是干湿实验无法结合,比如说干实验预测出来的结果在湿实验上面可能并不成功。

聂再清:因为干实验一个最大的问题是,其结果是基于某一个数据集的,而那个数据集跟现实生活中的真实场景并不一定完全一致,所以基于这个数据集训练出的模型,用在真实场景时,有可能效果就差别很大,很难说一个精度 80%、90% 的模型在湿实验的结果里能具体代表什么。当然,我们可以去建一个非常通用的数据集,用以去提升模型的通用性,但现在的问题是数据集的制定和现实制药场景的制定,可能还没有那么好的一致性。在具体任务上,最终效果还是得通过湿实验检验,模型效果到底怎么样,是否可用,湿实验的效果是非常重要的。

机器之心:您在水木分子带领团队研发基于大模型的对话式药物研发助手,这是一个非常新颖而独特的赛道,因为说到药物研发,我们首先想到是预测结构、生成新的分子、设计全新的抗体等等,您为什么会选择解决这样一个问题?

聂再清:我一直从事自然语言理解这部分的工作,我发现 ChatGPT 或者大模型确实是一个很大的技术进步,也让大家看到很大的机会,有可能在通用 AI 能力上取得较大进展。选择在这个时期加入大模型相关的工作,因为我看到未来大模型在每个行业里面都会产生非常重要的作用。

那为什么选生物医药?首先生物医药这个领域,有很多可以拿来做自监督学习的数据,比如我们已经积累了超过 20 亿的蛋白质氨基酸序列数据。我认为这个领域现在应该可能处于自然语言的 GPT-2 时期,模型的能力尚不能够在生物数据这个模态上涌现智能,也就是说不是每一款干实验模型预测的药物,都能超过专家。

在这种情况下,我们希望能够把专家的经验和直觉与大模型目前对生物这一部分的理解能力融合在一起,所以就提出了一个对话式助手的想法,一方面把专家的经验跟直觉用对话的形式告诉大模型,去帮助大模型,另一方面又把大模型设计的结果用自然语言解释给专家听。这样让人和大模型有效融合,去弥补现在生物模态本身还没有完全实现涌现智能的不足。

如果我只做生物模态,就像很多公司那样,一个最大的问题是我们推荐的分子或者说抗体,可能并不能够在湿实验上一做就有效果,临床完就通过了,因为它现在还没那么有效。很多时候,在干实验上做得很好的结果,比如我拿排名第一的或排名前十的结果去做湿实验,可能没有一个成功。

至于专家,尽管专家有制药的经验与直觉,但他没有办法跟模型有效沟通,模型并没有向专家解释到底为什么预测出这样的结果。

机器之心:因为设计模型的人并不是药物研发专家。

聂再清:对,药物研发专家也没有时间天天去写模型,那专家能做的是什么呢?在小模型时代,专家可能做的就是去构建一个训练数据集,用于训练模型,但这件事也要花很多时间,而且做了之后到底能不能大幅提升这个小模型的性能,也是一个问题,如果没有提升,专家的信心就受挫了,就不去写训练数据了。

从怎么有效地把专家跟人工智能算法结合起来的角度,我觉得需要两个模型的融合,这是在交互的层面,在知识融合这个层面,其实也需要两个模态模型的融合,我们现在已经有大量用自然语言写下来的知识,比如发现了一个靶点,也就是发现了一个蛋白质和疾病的关联,那么这一部分知识如何与生物模态的知识融合在一起,也是一个亟待打通的问题。所以基于这样的考虑,我们决定做基于大模型的对话式药物研发助手。

机器之心:水木分子团队研发了一个叫做 ChatDD-FM 的大模型,您能给我们介绍一下这个模型吗?

聂再清:我们希望 ChatDD-FM 成为这个行业的基座模型。要成为基座模型,它首先就得能够表示这个行业里面用到的所有数据,当然也能够去完成这个行业里的任务,同时还要能够与生物医药行业里面的专家去进行对话,能够调用这个行业里面所有的工具去解决专家们的问题。

所以在这里面天然就存在两类模态数据的表示,一类是文本模态,还有一类是生物模态。那文本模态除了自然语言,还有结构化的知识(比如知识库)和非结构化的表示。生物模态里面则有蛋白质分子、氨基酸序列、单细胞、活性小分子,等等。这里面的每一种生物数据,我们都会去打造一个编码器,比如我们会有一个蛋白质的编码器,也可以叫做蛋白质语言大模型,也有小分子的大模型,单细胞的大模型……对于这每一个大模型,我们也希望专家能够用自然语言去理解、去沟通,因为专家看到一个蛋白质,或者看到一个小分子,对于这个结构本身,对于它的生物学功能,比如这个小分子基团放在这里可能会带来什么样的功能等等,这样一些生物模态语义的信息,其实专家是希望能够去与系统交互的。

所以我们构建了一个多模态的生物医药大模型,能够在自然语言和生物语言之间进行翻译,专家可以用自然语言去提问,他甚至可以用自然语言去说,「帮我再优化一下这个分子,减少一下毒性」,然后模型反馈一些不同的建议。

机器之心:比如说我可以直接输入一句话,「给我设计一个感冒药」,然后它就输出一个感冒药?

聂再清:对,理论上是可以的,但从实践角度讲,基于现在这个大模型的能力,这样做可能不是最优的,现在最优的方法可能是给它一个小分子或者一个骨架,专家用自然语言说「如果更换这个骨架,或者提升某一个性能,需要做什么,给我一些建议」。甚至最好也不是从头生成一个分子,因为从头生成分子涉及到很多复杂的过程和反应,我们需要了解其中的具体细节,比如这个分子它是怎么合成的等等。因此,可能最好还是通过虚拟筛选的方法,或者说在生成一个分子的时候,然后找到一个跟这个分子相似的的可合成的药物,在此基础上再接着优化。当然,在实践中这个过程可能会有所不同,但一定是可以用自然语言去跟大模型沟通的,让大模型可以朝语义方向去优化。

03、多尺度建模及融合:统一到原子

机器之心:在生物模态里既有细胞,又有蛋白质、组织等等,如何在一个模型里面把这些不同尺度、不同模态的数据都统一到一起,并且去表达它们之间的这些复杂关系呢?

聂再清:这个是一个很好的问题。人体有很多组织,每个组织都有不同的功能,在肝脏就是排毒的,在眼球就是看东西的,因此存在很强的语义(Semantic meaning)。同时,眼球本身又具有空间结构,它里面有很多细胞,细胞之间要产生相互作用,在每个细胞里面又有蛋白质,蛋白质和药物如果要相互作用,可能要与小分子结合,那么化学小分子里的原子去产生作用,与蛋白里的氨基酸结合本身就是一个不同的尺度。

我们的自然语言也是一样,我们可能有图书馆,可能是分类别的图书馆,有不同功能的图书馆,图书馆里面又有一本本的书,书里面又有章节(Section),里面又有段落(Paragraph),最后到词,对吧?所以我们觉得人体、生物语言,可能跟自然语言类似,这里面也可以找到一个最基本的 Token,那就是原子。所以,我们认为基于原子有可能打造一个非常好的生物模态的基础模型,能够表达包含小分子和蛋白等不同尺度的相互作用,并且未来可能有更多的生物语义发展起来,所以我们觉得这是一个解决多尺度建模问题的重要方法。

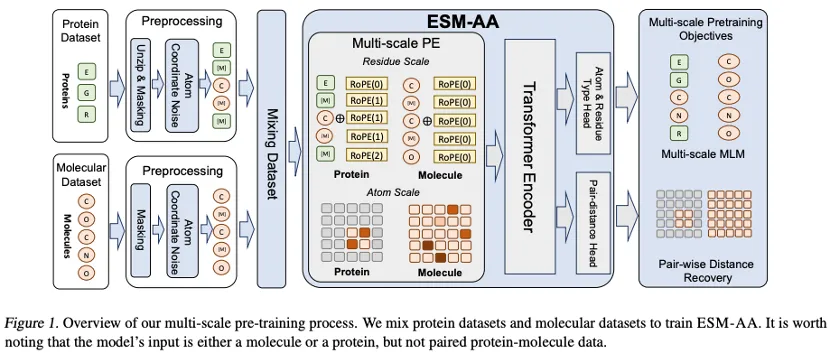

最近我们有合作提出一个工作,起了个名字叫 ESM All-Atom(ESM-AA)。这个模型通过将蛋白质的一部分氨基酸展开(Unzip),把它整合成对应的原子,通过混合蛋白数据与分子数据进行预训练,这样模型就同时具备了处理不同尺度生物结构的能力。训练的时候,不光有蛋白质,我们还把分子、小分子数据也放在模型里面。为了帮助模型更好地学习和优化原子尺度的信息,我们还利用原子尺度的分子结构数据进行训练。通过引入多尺度位置编码的机制,模型可以很好地对不同尺度的信息进行区分,确保模型能够精准理解残基层面和原子层面的位置和结构的信息。

ESM-AA 模型多尺度预训练过程概览。核心是多尺度位置编码(Multi-scale PE)模块,分别处理蛋白质和分子的不同尺度信息。模型的输入是单独的蛋白质或分子,而不是蛋白质-分子对,这种设计使得模型能够学习更通用的表示,适用于各种蛋白质-分子相互作用任务。来源:Zheng et al., arXiv:2403.12995, 2024

机器之心:在您看来,如果我们要把所有的生物模态都统一到一个框架下面来表示,还有哪些难点需要去克服?

聂再清:如果要实现一个统一的框架来表示生物模态信息,首先要有很多的数据,把人体的组织、细胞、蛋白以及小分子药物之间的关系,通过高通量测序等技术进行数字化,这样就能产生大量的数据。

未来有了数据之后,怎么打磨一个模型?这个模型能够既考虑宏观又考虑细节,我觉得有可能像视觉识别里面的物体检测(Object Detection),每个区域都有语义,例如里面有一辆车、车上有轮子、轮子还有很多更细的 Object,当然最后它们都由最基本单元——像素(Pixel)组成。计算机视觉有很多跨尺度研究的工作,与我们最近研究的空间转录组单细胞表示学习工作有些类似。

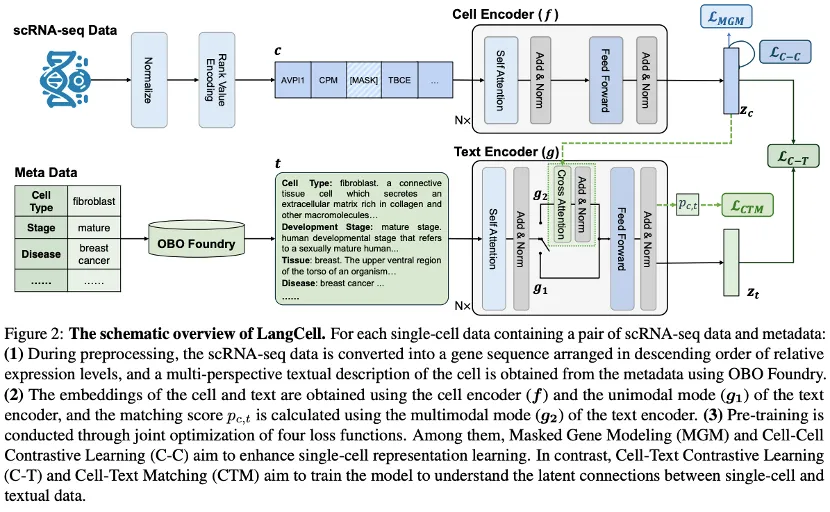

团队提出了单细胞与文本跨模态大模型 LangCell,将单细胞 RNA测序(scRNA-seq)数据和相关的元数据(如细胞类型、发育阶段和疾病状态)整合到一个统一的框架中,实现对单细胞数据的全面理解和多模态表示。来源:S. Zhao et al., LangCell: Language-Cell Pre-training for Cell Identity Understanding, ICML 2024

但是,在融合单细胞、蛋白质和小分子这些跨尺度的生物数据上,在算法上又需要有大量的创新。不同尺度之间存在复杂的相互影响和依赖关系,如何在模型中准确捕捉和保持这些关系是一个重大挑战。对此,可以设计跨尺度的注意力机制,确保不同尺度的信息能够有效地互相影响和补充,帮助模型有效整合不同尺度的信息,从而提升模型的准确性和鲁棒性。

不同模态的数据在结构、尺寸和特征分布上存在显著差异,如何有效整合这些异质数据是另一个关键挑战。未来我们计划将更多生物模态的数据都映射到原子表示空间,实现数据的兼容和互操作,确保不同尺度和模态的数据都在一个共享的表示空间中进行映射和交互,实现信息的无缝融合。

在模型训练过程中,可以结合多任务学习,比如蛋白质折叠、Co-folding、蛋白质-小分子相互作用预测、药物毒性预测、分子编辑等等,提升模型的泛化能力。利用大规模的生物数据进行预训练,捕捉丰富的生物知识和多尺度信息,为下游任务提供一个强大的生物数据 Foundation Model。

机器之心:那现在水木分子在数据这方面有什么投入,或者是说重点投入在哪里?

聂再清:我们现在大量的数据还是基于公开数据,就是已经做了实验也被公开出来的数据。除了这种实验数据以外,我们还有很多文本数据,其中可能有几千万的论文、专利,还有很多结构化的知识库数据,那么,这些数据如何去跟生物模态的数据对齐,这部分的工作很有挑战,也是我们数据工作的重点。

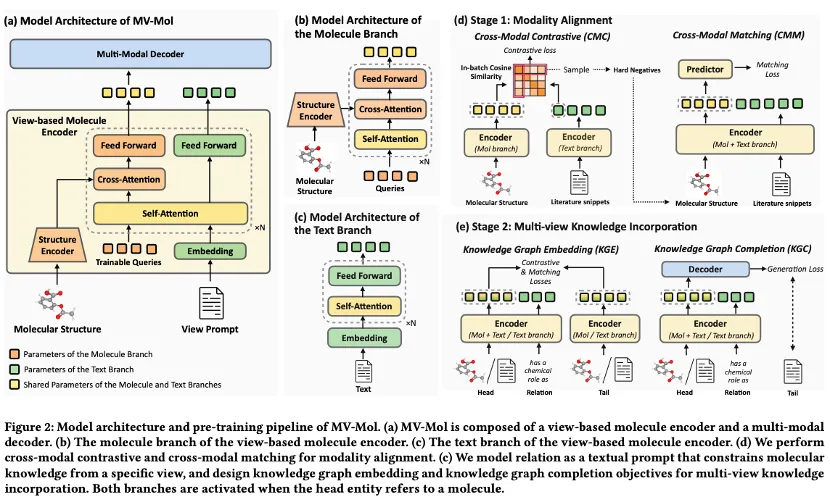

假设你要去找到一个小分子跟文本的对齐的 Pair,那这个文本不仅要能描述这个小分子,还应该方方面面都讲到,从不同的角度去描述,我们叫做多视角(Multiview representation),比如关于小分子的描述,可以是关于小分子的基团,每个基团起什么作用,也可以是小分子在宏观上的性质,还可能是这个小分子在某些结构上某些功能的描述,这样才有利于大模型学习。不光是在数据处理上,在模型的研发上最好都能考虑到这些。

团队提出的分子表示学习模型 MV-Mol,将化学结构的专业知识和生物医学文本中的非结构化知识以及知识图谱中的结构化知识融合到一起,利用文本提示来模拟视图信息,并设计了一个融合架构来提取基于视图的分子表示,实现了对分子特性的更准确预测以及在分子结构和文本的多模态理解方面的性能提升。来源:Y. Luo et la., Learning Multi-view Molecular Representations with Structured and Unstructured Knowledge, KDD 2024

我们要做这个行业的助手,就得把知识搞准确,我刚才讲的是用来训练模型的数据,还有一部分数据是在用户在提问的时候,我们也要把最准确的知识回答给用户,为了具备这样的能力,那对于这部分能力,我们正在建一个水木分子的知识库。

我在微软做了很多实体挖掘、实体搜索的工作,其实在很早以前我做过一个叫做「人立方」的项目,把各个人的各个信息,不管是结构化的、非结构化的都集合起来,然后用一个搜索,一搜就能够搜到关于这个人的各种各样的信息,那个工作在知识图谱那个年代还是比较有引领作用的,对于我们正在构建的水木分子知识库,也有很多的借鉴意义。我们正在做一个叫 EntityChat 的技术,希望对一个实体的问题,可以利用它的结构化知识、非结构化的知识和生物模态的知识去回答。

机器之心:水木分子现在是已经推出了产品级的应用 ChatDD,您能够结合具体的使用场景给我们介绍一下吗?

聂再清:我们希望 ChatDD 成为这个行业的助手,所以希望它能够解决药物研发各个环节中的问题。我们现在主要集中在三大类场景:立项、临床前药物研发,以及临床试验。在每个领域我们都希望找一个灯塔客户去合作,看一看他们的真实需求是什么,我们模型和数据的能力要怎么才能够去解决他们最核心的痛点,所以每个场景都不大容易。以立项为例,我们也在与一个比较头部的公司在合作。

如果药厂要开展一个项目,首先需要找到足够的证据提交给这个公司的立项委员会,假设每个公司都有一个立项委员会,它肯定要去做一个规划方案,提供足够的材料证明这是一个好项目,能为公司带来巨大的前景,或者说风险有限,或者我们必须去做等等。

当然,药物研发的项目有多种,可能是创新药项目,也叫 First-in-class,也可能是 Best-in-class,就是这个药人家已经有了,那我们做得更好;还有一个就是仿制药,别人专利过期了,我们把它给做出来,只要能赚钱也可以。不同的立项,用到的数据和模型的能力可能也不大一样。

但不管你做创新药还是做 Best-in-class 或是仿制药,都要去考虑市场和行业竞争对手。其他的药发展怎么样,这个疾病的人群怎么样,这种药现在有没有专利,专利是不是要到期,这样海量信息的融合、查找以及预测,如果让人去做,是非常 Time consuming 的,那用大模型就能够很好地解决这一部分的工作。

然后还要与专家密切沟通,专家还得要用提示词(Prompt),不断地去利用经验和直觉,与大模型互动,最终还是得让专家做出判断。大模型则是能够给专家提供足够的证据或者建议,说发现了这个通路,或者发现了这个东西可能是个通路,或者说前人已经在这个方面提出过这么一个观点,正好能融合上……通过 ChatDD 这种不断的交互,我们希望让这个项目的带头人,他和他的团队最后能够找到一个非常好的市场空间,去助力他给公司提供立项证明。

机器之心:ChatDD 已经能够在立项这个环节起到非常大的帮助了?

聂再清:对,我们的客户反应还是非常好的。

机器之心:那您公司的产品是模型还是服务或是其他呢?

聂再清:我是觉得我们的盈利模式还是比较多种的,一种就是大模型,客户可以进行账号订阅,也可以进行云部署或私有化部署。在刚开始阶段这是一个比较好的盈利模式。

我们现在正在启动的一个模式,是提供一些服务。我们公司可能有些顾问,有些生物专家,用 ChatDD 帮客户立项,或者去做临床前的药物发现,或者做临床,这个模式对我们打造产品也很有好处,能够提升我们模型的能力,同时端到端地解决客户问题。做到一定程度以后,如果我们成为这个行业里靠前的提供商,大量的生物医药任务都是由 ChatDD 在帮忙解决,我们可能还有一个模式,那就是应用商店。

因为 ChatDD 要解决问题,并不是完全靠自己的大模型,它还要去查阅行业内最好的数据,去调用行业内别的好用的工具。通过这样的一个助手,把行业里所有工具整合起来的应用商店模式,我觉得在未来会是一个非常重要的盈利模式,不仅仅是 ChatDD,我觉得未来 ChatGPT,或者说 Llama,就是 Facebook(Meta)可能也会采用这样的模式,因为它开源之后大家都在用,就有很多整合的空间。那这样的话这个模式可能就变成了,如果我们 ChatDD 使用了第三方的工具,我们付费给第三方,但抽一部分成。同时也可以开展广告,比如告诉客户说有个新的工具,你要不要试一试。

助手一旦真正在用户心智中占了主要的地位,在赋能这个行业的生态上面其实有非常大的空间。最终,我觉得在生活上可能会有一个应用商店,在工作上每个行业又会有一个行业的应用商店。

机器之心:经过您刚才的介绍,彻底打开了我对于药物研发助手的理解,最开始的时候我还局限在如何去研发更好的药,如果真正成了一个入口级别的助手,将来的想象力是非常大的。

聂再清:这样一个(人机交互)入口模式,其实也不只是在大模型火之后才有的,之前我不是在做天猫精灵吗,那时候很多大厂都在做语音助手。那个助手跟现在这个助手一样,都是希望成为交互入口,为什么大家都投那么多钱去做?就是担心一旦有的助手成了(新的)入口,以前的商业模式就不在了,所以大家都花了重金去做这件事。当时我们做的也是不错的,就是在封闭域,也就是在经过训练的领域,能够做得非常不错。

举个例子,我们在播放助手上就做得不错,这就是一个封闭域,你可以播放音乐、播放电视,在语音助手出现之前,用户需要使用遥控器输入文字来搜索内容,操作繁琐。现在直接就用语音,就很简单,而且最后它还要推荐,比如推荐某首歌,就很难拒绝,每次都问你不听这首歌吗?这很难的。在封闭领域,我们上一代的技术就已经非常好了,准确度很高,对用户也已经产生了价值。

机器之心:因为它是基于用户的爱好学习过的。

聂再清:对的,所以 ChatGPT,包括我们现在的 ChatDD,最大的技术进步就是在开放域上,也就是没有经过训练的领域,它也能够触类旁通,为什么说它是通用人工智能的曙光?你在 n 个任务上用自然语言提示作为训练,在第 n+1 个没训练的任务上它也提升了,那离这个助手的愿景就更近了。

机器之心:在生物医药行业里面,对这样的一个全新的助手,接受程度怎么样呢?

聂再清:最近我们也在跟很多客户聊,我觉得前景是非常好的。这样一个助手它有几个阶段,第一个阶段可能提供很多工具的调用以及翻译的能力,就是把生物语言与自然语言进行翻译,这是马上就能帮到的。但是在生物模态上直接帮助进行药物的设计,不管是小分子还是大分子设计,虽然现在也能帮,但效果可能在湿实验上还不能完全超越人类专家,所以我们得人机协作。如果有一天模型能够自行设计出每一个分子,人类基本上都只能仰视的时候,那我感觉我们生物医药的「ChatGPT 时刻」就到来了。

机器之心:现在关于通用大模型和垂直大模型有一个争议,是从头训练一个自己行业的大模型,还是拿一个开源的基座,用自己的数据来微调,这两者之间的差异如何判断?

聂再清:我个人觉得可能不需要从头训练一个文本的大模型,因为文本这个自然语言的语法,通用大模型都学到了,因为它(数据)多,多的话就学得更准,理解得更清楚。但是在垂直行业里面,可能有很多自己的数据,这些数据不是自然语言,它有自己的语法,那这个时候你用通用大模型也学不了,对吧?

那所以这个行业是否需要一个垂直大模型,关键是它有没有自己独特语法的数据,这个数据非常影响它下游任务的性能,如果是,这就是一个需要垂直大模型的行业。当然,是不是只做这个行业模态的大模型就行了呢?也不行,为什么呢?因为每个行业里都有人,都积累了很多行业内部的知识,这些知识是用自然语言构成的,那人也希望用自然语言跟这个大模型进行交互。

为了让人能够更好地交互,更好地去了解这个行业的数据,我们还需要一个多模态大模型,将自然语言和这个行业数据对齐,进行翻译。

机器之心:尤其是生物医药这样的行业,包括化学、新材料。

聂再清:自动驾驶。

机器之心:那比如说法律大模型,其实就没有必要自己从头训练一个,就用基座大模型,然后用专有的数据微调就好了?

聂再清:对,做持续训练(Continue train)和做 SFT 就比较足够。

机器之心:那这个非自然语言模态的行业大模型,要实现智能涌现,或者是说足够智能能够帮助人或者是与人协作,它的规模有一个阈值吗?

聂再清:规模的来讲我觉得肯定也不能太小,一般都说至少 10B 以上。如果有这样的数据,我们需要去找到训练这个多模态大模型的 Pair 数据,也就是文本和这个行业模态数据的对齐的 Pair,找到很多这样的 Pair,这是需要领域知识才能够去找全、找准。如果不全不准,那可能不行。所以一个做行业大模型的公司,肯定也需要跟这个行业的专家一起构建行业大模型。

机器之心:您之前提到未来一定是人机协作式的药物研发,您能描述一下您理想中的人机协作式药物研发具体是什么样子的吗?

聂再清:人机协作的药物研发最好的方式就是把人的长处和机器的长处都用上。人的长处在我看来是什么呢?更多的是这个人的经验和直觉。那机器的长处是什么呢?如今大模型能够帮我们处理海量的数据,调用各种各样的工具,然后自动化地、高效率地去计算,所以把这两个长处利用好,是我觉得人机协作最重要的一件事情。

具体来讲,像 ChatDD,我们就希望制药的那些「老法师」,能够把他们的经验和直觉用一段话,用文字总结,也可以画一张图,或者说做成某个文件,总的来讲就是把人的经验和直觉,能够数字化下来,变成大模型的输入,ChatDD 会根据这些输入,迅速在模型学习过的海量数据、文献或水木分子知识库中找到相关的结构化、非结构化和生物模态数据,并给出解答。这个解答过程可以看作是机器对人的一种提示(Prompt)。同样,专家的提问也是对机器的一种提示。通过这种人机之间的不断交互和相互提示,我们可以逐步缩小解空间,最终找到正确的解决方案。

ChatDD 的目标是成为医药行业内所有人都离不开的智能助手,大幅提升药物研发全流程的效率。ChatDD 不光会利用大模型自己学到的知识,也会调用医药行业内各种最好的专业工具(比方说最受欢迎的可视化 Docking 工具或者 SOTA 药物属性预测算法),同时也会实时查询第三方的专业知识库。

我们也在和医药行业的专家紧密合作,将医药行业的日常工作任务和推理方式自动化。将类似 OpenAI o1 的更强大的推理能力引入生物医药大模型,让推理过程更接近专家的推理过程。希望更多科研人员和生态合作伙伴和我们一起,构建最有效的生物医药多模态大模型,共同迎接生物医药的「ChatGPT 时刻」,实现生物语言模型的智能涌现。

聂再清博士,现任清华大学国强教授和 AIR 首席研究员、水木分子首席科学家。从事大数据与人工智能的前沿创新,以及健康医疗领域的产业应用,是十四五国家重点研发计划「新药研发大模型」课题负责人。带领团队研发并且开源了全球首个多模态生物医药大模型 BioMedGPT 和 OpenBioMed 工具包,赋能生物医药行业科研和创新。提出并牵头研发了全球首个车路协同自动驾驶数据集 DAIR-V2X,解决了自动驾驶产业以往缺乏真实场景车路协同数据集的痛点;团队提出的贡献感知联邦学习框架获得 AAAI-IAAI 2022 人工智能创新应用奖,并在智慧医疗健康的产业应用中得到验证。

聂再清博士 2004 年获得美国亚利桑那州立大学博士学位,师从美国人工智能学会前主席 Subbarao Kambhampati 教授,本科和硕士毕业于清华大学计算机科学与技术系。2017 年加入阿里巴巴,任达摩院人工智能实验室北京负责人。此前就职于微软亚洲研究院,任首席研究员,是微软学术搜索和人立方的发起人和负责人,也是微软自然语言理解平台 LUIS 的技术负责人。发明的知识图谱相关技术、对象级别的信息搜索技术、语音语义一体化理解技术等,被广泛应用于互联网搜索引擎、聊天机器人以及智能助手等领域。引领了业内大数据驱动的知识图谱挖掘和应用相关技术的创新,在微软期间被授予 Microsoft Golden Star 奖。在阿里巴巴期间,作为天猫精灵首席科学家,带领团队从无到有实现天猫精灵的算法研发和创新工作,把人工智能最前沿技术真正落地到千家万户。2019 年他所带领的团队获得吴文俊人工智能科技进步奖。

文章来自于微信公众号“ 机器之心”,作者“ 闻菲”

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0