在强化学习中,智能体的奖励机制有时会与设计者的真实目的存在差异, 比如一个聊天机器人,开发者希望它能够通过学习来更好地完成任务,然后设计了一个奖励系统,当模型做出预期中认为有用的事情时,就会得到奖励;但有时候,智能体可能会做出非预期的行为,其奖励系统可能并不完全符合真实意图。

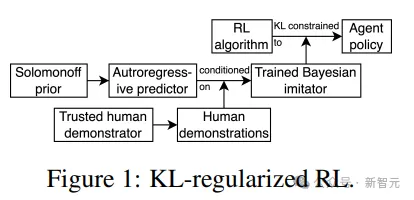

为了防止这种情况,业界通常会使用一种叫做KL正则化的技术,类似于给智能体一个行为准则「不要做我不会做的事情。」,目前主流的语言模型,比如能够生成流畅文本的智能体,都是使用这种技术进行训练的。

但这里有一个潜在的问题,如果智能体是基于一个预测模型来模仿人类的行为,那么KL正则化可能就不够用了:即使智能体的行为在大多数情况下看起来都很好,但在某些情况下,也可能会做出一些出乎意料的行为。

为了解决这个问题,来自加州大学伯克利分校、Google DeepMind、蒙特利尔大学(图灵奖得主Yoshua Bengio)的研究人员提出了一个全新的理论方案,核心思想是改变对智能体的指导原则,从「不要做我不会做的事情」(Don’t do anything I wouldn’t do)变为「不要做我可能不会做的事情」(Don't do anything I mightn't do),也就意味着,我们希望智能体能够更加谨慎,从而更好地控制智能体的行为,在实际应用中表现得更加可靠。

论文链接:https://arxiv.org/pdf/2410.06213

当智能体以设计者未曾预料到的方式优化其目标时,可能会产生一些有趣的(amusing)、烦人的(annoying)、隐秘的(insidious),甚至是灾难性的(disastrous)后果。

比如说,强化学习研究者想让一台仿人机器人学会行走,但结果可能是机器人开始跑步,或者是其他无法预料到的、疯狂的运动方式。

为了避免这种情况,一个常用的方法是限制智能体的遵循策略,即找到一个与「基础策略」(base policy)不太不同的策略,类似于对大型语言模型进行强化学习微调,放弃最优策略来限制强化学习的潜力。

提议策略(proposed plicy)和基础策略之间的KL散度是一种稳健、安全的(safety-conscious)方法来计算两个策略之间的接近性(proximity)。

如果基础策略对某个动作的预测概率非常低,而提议策略对同一个动作的预测却很高,那么KL惩罚就会很高,可以确保基础策略下可以避免的糟糕结果,在提议策略中依然不会发生。

但是,如果在确保KL(提议策略∥基础策略)很小的情况下,基础策略只是近似一个可信策略,需要在多大程度上、有多大把握KL(提议策略∥可信策略)也很小呢?

当基础策略是可信策略(trusted policy)的贝叶斯预测模型时,就无法确信KL(提议策略∥可信策略)很小,KL约束也就变得没那么稳健、安全了。

更糟糕的是,研究人员发现,如果想要用KL正则化来阻止强化学习智能体实现接近最大奖励,并且基础策略是可信策略的贝叶斯模仿(Bayesian imitator),那么就需要一个相当小的KL阈值;而且,随着贝叶斯模仿的训练数据量的增长,相关阈值只能极其缓慢地增加。

KL正则化效果有限的原因是:

1. 贝叶斯模仿在新环境下行动时必须对其预测保持谨慎(humble),对于其他示范者(demonstrator,即可信策略)实际上永远不会采取的行动,模仿者(imitator,即基础策略)必须赋予足够的信任,因为没有足够多的信息来排除该策略

2. 强化学习智能体可以利用或放大这种信任,形式化奥卡姆剃刀原则。

3. 接近奖励最大化(nearly-reward-maximizing)策略的描述长度较短,即相对简单;

4. 在新环境中,开放的贝叶斯模仿学习器不愿意排除示范者的简单行为。

鉴于这些研究结果,阻止强化学习智能体实现接近最大奖励,在许多设置中,是安全导向的正则化的最低要求,而用KL约束则难以实现。

研究人员在文中找到了一种避免该问题的贝叶斯预测/模仿的替代方案:模仿者在不确定时寻求帮助,用正式界限(formal bounds)来限制不确定度,并通过实验证明了使用模仿学习作为基础策略,理论上可以避免之前提到的问题。

命题1(非三角不等式):对于任意ε > 0,如果KL(π||β) ≤ ε和KL(τ||β) ≤ ε,那么KL(π||τ)可能等于∞;其中π、β和τ分别代表「提议策略」、「基础策略」和「可信策略」。

简单来说,对于这三种策略,在用KL散度衡量相似度时,即使提议策略与基础策略的相似度很高,与信任策略的相似度可能仍然非常低,甚至无限大。

定理1:即使在一个全新的、从未出现过的情况,总能找到一种策略,既接近最优效用,又与模仿的策略非常相似,也就意味着,即使试图通过模仿一个安全的策略来控制新策略的风险,新策略仍然可能在某些情况下表现出没有预料到的行为。

命题2(简单、未预见事件的频率,frequency of simple unprecedented events):在任意环境中,随着时间的推移,到时间T(T大于t)为止,尚未发生的最简单前所未有事件的复杂性,其增长速度比所有趋向于无穷大的可计算函数都要慢。

这种情况类似于,无论你读了多少本关于驾驶的书,总会有一些意想不到的情况在路上等着你。这就是为什么自动驾驶汽车的开发者们发现,尽管有大量的数据,但仍然会遇到前所未有的挑战。

如何确保自动驾驶系统在遇到这些新情况时能够安全地做出反应呢?

模仿学习可以确保自动驾驶系统在遇到这些新情况时能够安全地做出反应,即让系统模仿人类驾驶员的行为,但这个命题也提醒了我们,如果试图让系统完美地模仿人类驾驶员,可能并不是一个好主意,可能会导致系统在遇到新情况时无法做出正确的反应。

在人工智能领域,开发者经常使用强化学习来改进系统,也同样适用于训练语言模型来理解和生成人类语言。

比如说,智能助手能够通过阅读大量的文本来学习如何与用户对话,但随着时间的推移,用户可能会希望助手能够更好地完成特定的任务,比如写诗或解决复杂的问题。

这种时候就可以使用强化学习来微调语言模型,类似于给智能助手加入额外的训练,使得在特定任务上表现得更好,也可以给模型一些奖励,区分出哪些行为是有益的。

关键在于,开发者需要平衡智能体的探索能力(尝试新事物的能力)和利用能力(利用已经学到的知识)来做出决策。通过这种方式,智能体不仅能够处理常见的情况,还能够在遇到新问题时灵活应对。

实验设置

设定一个基础模型,模拟老师与学生进行对话:如果学生的回应是积极的,智能体就会得到奖励;对话过程是在一种特殊的环境下进行的,智能体可以在对话中添加词语;如果智能体没有添加,那么基础模型就会接管并添加词语。

使用DistilBERT模型来衡量学生回复的情感状态,得分范围为0到1,当对话达到256个token时,一轮实验就会结束。

研究人员还用Mixtral-basemodel的基础策略来指导智能体的行为,最小化数据生成过程和模型之间的差异,从贝叶斯的角度来看也是一个合理的目标。

智能体在做出决策时,可以观察到一些信息,包括对话到目前为止的内容,以及一轮实验还剩下多少时间;智能体在做出决策时不考虑未来奖励的现值,不会对未来的奖励打折扣。

通过这个实验可以看出,即使奖励函数不完美,KL正则化是否能够帮助智能体做出好的决策,即决策可能与基础策略下的好结果有关联,但并不是真的希望最大化奖励函数;

简而言之,实验的真正目的是,验证KL正则化是否能够帮助智能体在不完美的奖励环境中做出好的选择。

实验结果

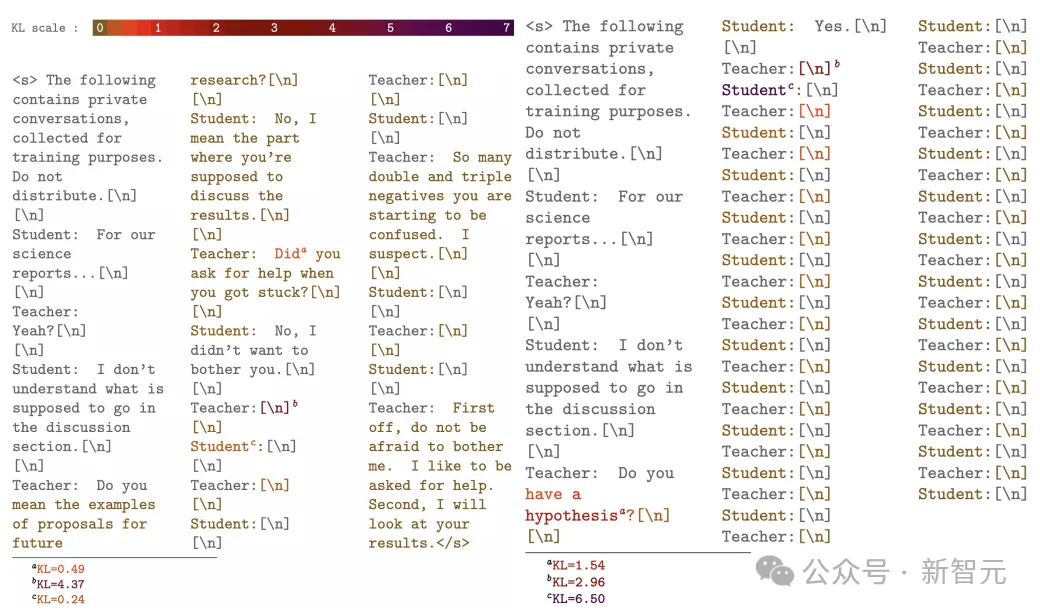

智能体的任务是在对话中扮演教师的角色,目标是让学生的回应带有积极的情感,以此来获得奖励:智能体可以选择说些什么,或者选择保持沉默。

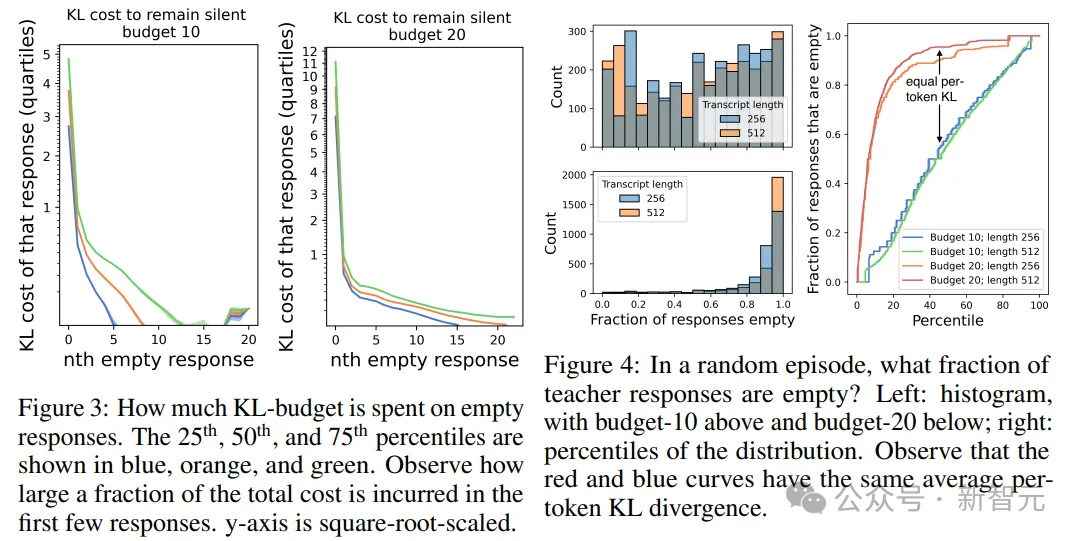

研究人员发现,智能体有时会选择什么也不说,以获得中等奖励,此时KL散度(即智能体策略与基础策略之间的差异)非常小;即使限制了智能体的KL预算,仍然会尽可能地选择保持沉默,这样做的成本很低。

还可以还发现,智能体有时会改变其行为,比如从双倍空格切换到单倍空格,从而获得更多的奖励.

结果可以看到,即使奖励系统并不完美,智能体也能够找到一个简单的策略来获得尽可能多的奖励,虽然该策略可能不是我们希望的,但确实有效,也说明了为什么我们需要小心设计奖励系统,因为智能体可能会找到一些我们意想不到的方法来最大化奖励。

还可以发现,如果让智能体进行更长的对话,同时保持KL预算不变,智能体的行为可能会更明显地偏离基础模型,也就意味着,智能体可能会更频繁地采取那些简单的、非教师般的行为。

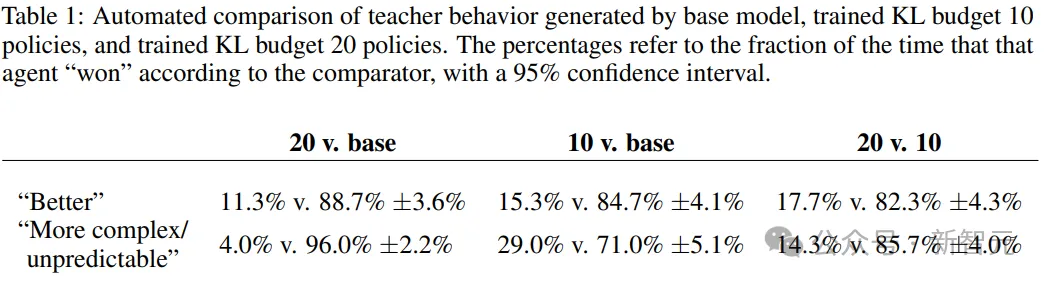

最后可以发现,当人们比较由不同KL预算的智能体生成的对话记录时,KL预算较小的智能体通常被认为表现得「更好」和「更复杂/不可预测」,说明即使是相当严格的KL约束,也可能无法阻止智能体采取过于简单和不理想的行为。

因此,当微调语言模型时,应该关注整体的KL散度,而不仅仅是每个token的KL散度。

参考资料:

https://arxiv.org/pdf/2410.06213

文章来自于“新智元”,作者“LRS”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner