LLM真的会推理吗?

最近,苹果研究员发文质疑道:LLM根本没有不会推理,所谓的推理能力只是复杂的模式匹配罢了。

论文地址:https://arxiv.org/abs/2410.05229

这项研究也在AI社区引起了广泛讨论。

谷歌DeepMind科学家Denny Zhou表示,自己ICML 2023的一片论文中,也发现了类似现象。

Meta AI研究者田渊栋表示,梯度下降可能无法学习到这样的权重。

巧的是,AI2等机构在23年的一篇研究也被翻出,证实模型根本没有学会数学推理,只是在「照背」答案而已。

网友们搜罗了越来越多的学术证据,一致证明:LLM可能根本不会推理!

图灵三巨头之一的LeCun,也在最近的万字演讲表示,Meta现在已经完全放弃纯语言模型,因为仅靠文本训练,它永远不可能达到接近人类水平的智能!

目前Transformer架构的大语言模型,难道真的是一条弯路?

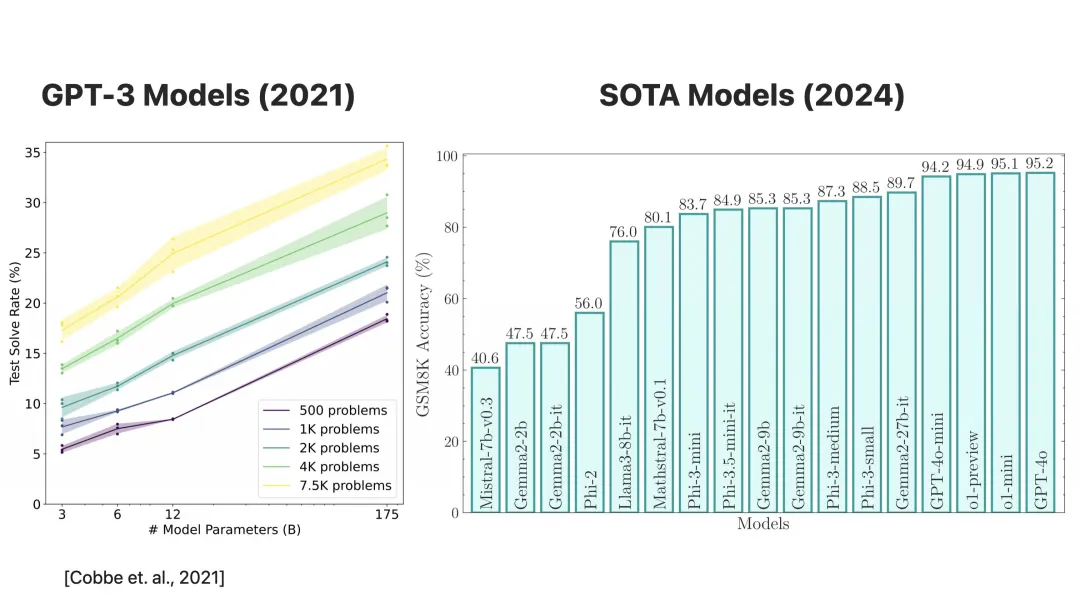

此前,业界用来评价大模型数学能力的数据集是2021年发布的GSM8K,该数据集包含8000可小学水平的数学应用题,例如下面的例子:

当索菲照顾她侄子时,她会为他拿出各种各样的玩具。积木袋里有31块积木。毛绒动物桶里有8个毛绒动物。堆叠环塔上有9个五彩缤纷的环。索菲最近买了一管弹性球,这使她为侄子准备的玩具总数达到了62个。管子里有多少个弹性球?

此时距OpenAI发布GSM8K已经三年了,模型性能也从GPT-3的35%,提升到了30亿参数模型的85%以上。

不过,这真的能证明LLM的推理能力确实提高了吗?

要知道,由于是21年发布的数据集,如今的主流大模型可能抓取的训练数据无意间涵盖了GSM8K的题目。

虽然大部分模型没有公开训练数据的信息,但存在数据污染的可能,这就会导致大模型能够靠背题答对GSM8K中题目。

因此,用这个数据集去评判LLM的数学能力,并不准确。

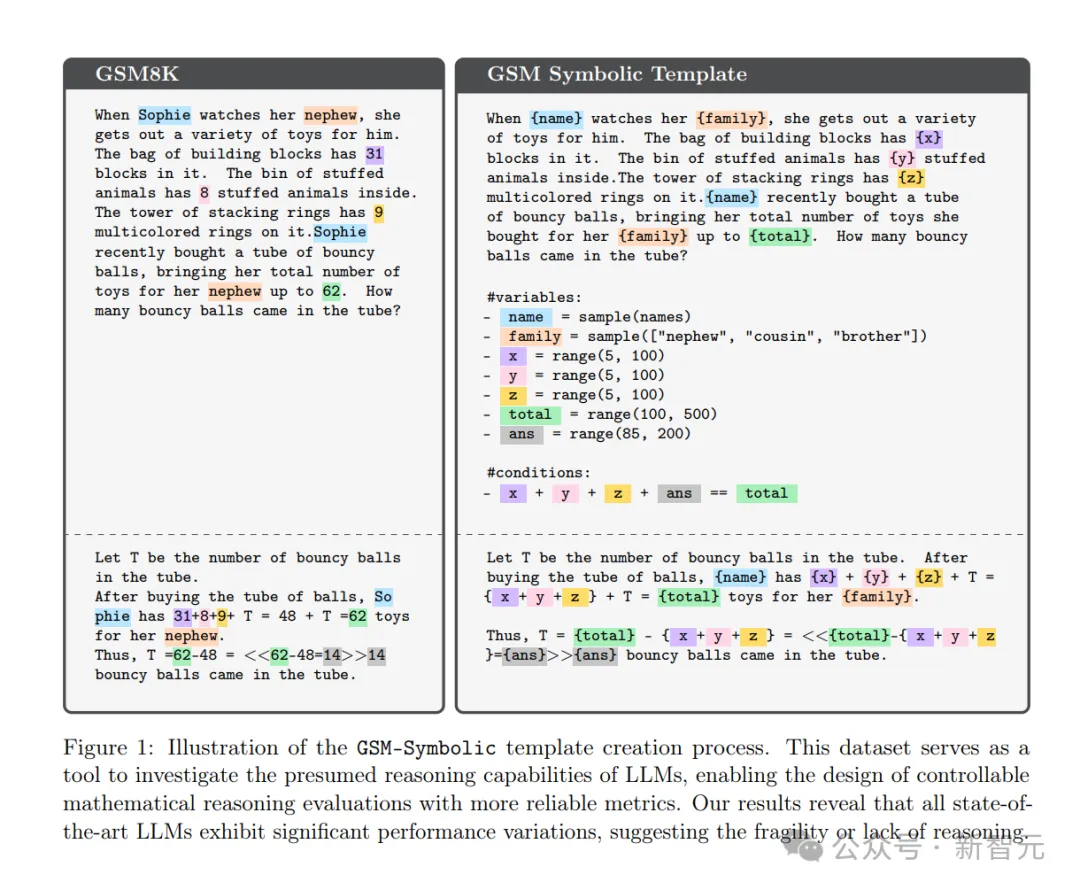

于是,为了客观评价LLM的数学能力极限,苹果的研究者们开发了一个名为GSM-Symbolic的数据集。

GSM-Symbolic将GSM8K的题目进行了修改,例如改变了索菲这个名字,侄子这个家人的称谓,以及各种玩具的多少(数字)。

这样一来,就可以产生出很多个看起来全新,但实际上却是具有相同内核的题目。

另外,除了GSM-Symbolic,这项研究还提出了GSM-NoOp数据集,GSM-NoOp 向题目中添加看似相关但实际上无关的数据,来判断大模型在执行逻辑推理任务时是否会受到无关数据的影响。

实验结果很有趣:就跟人类一样,数学题干一换,很多LLM就不会了!

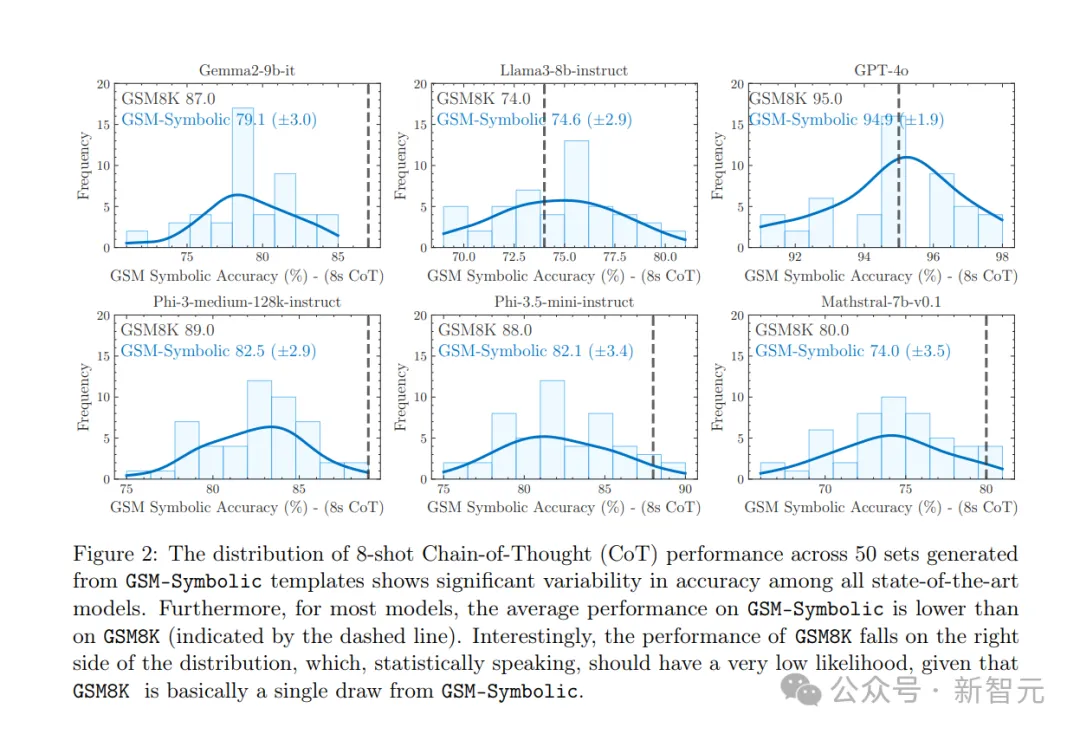

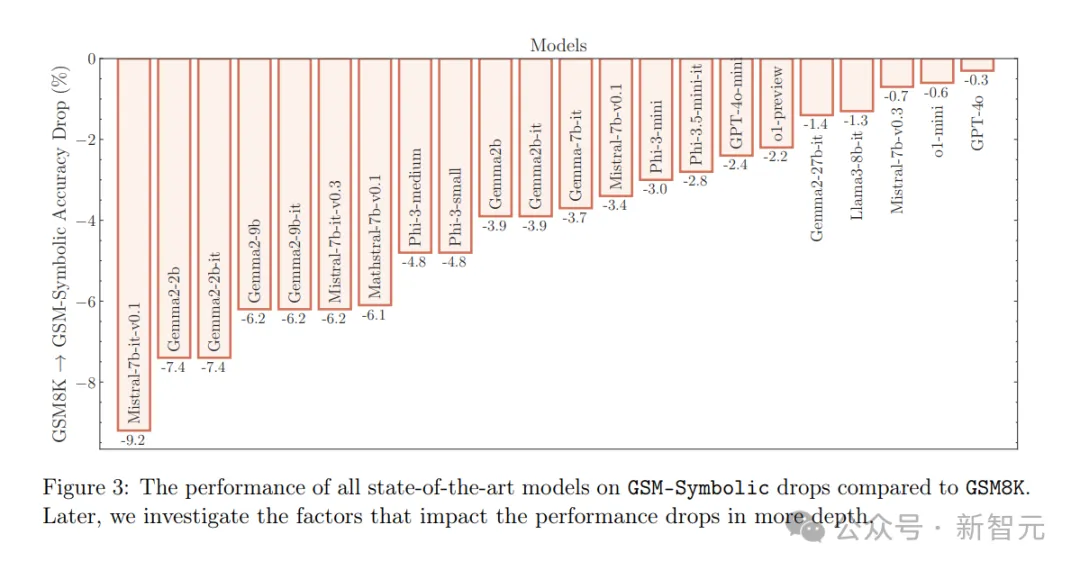

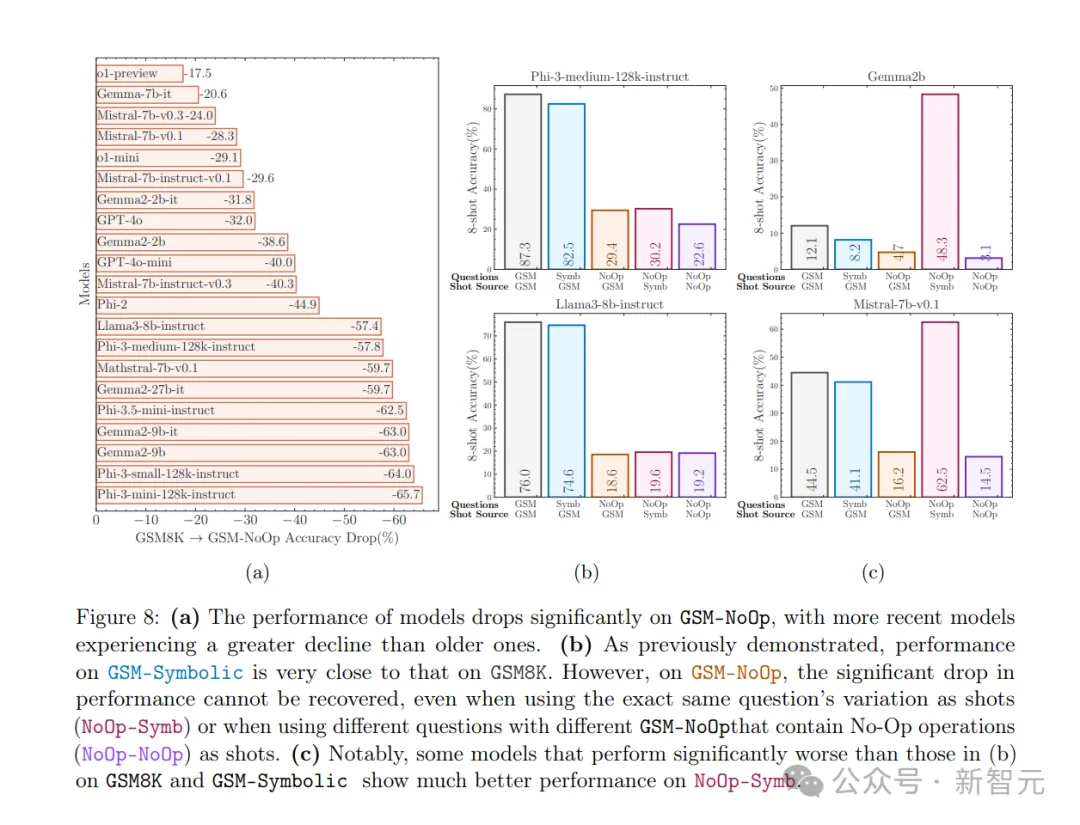

苹果的研究者们对比了GSM8k和GSM-Symbolic在多种模型上的性能差异,结果发现——

无论是主流的开源模型还是闭源的GPT系列模型,甚至专门为数理推断专门优化的o1模型,当面对GSM-Symbolic的换皮题目时,准确率都会下降。

大多数模型在GSM-Symbolic上的平均性能,都低于在GSM8K上的平均性能。

GSM8k和GSM-Symbolic和模型性能对比

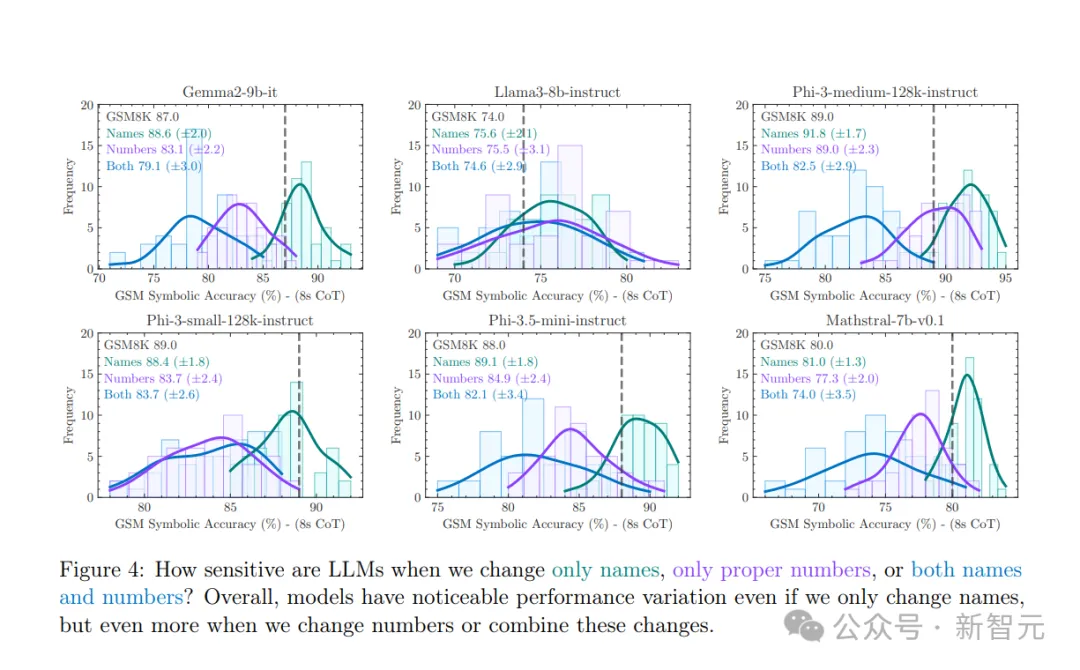

即使只更改了题目中的名称,大模型的表现也会有存在差异,当只改变了题目中的专有名词时,性能下降在1%-2%之间,当实验者更改数字或结合两类更改时,差异则更为显著。

对比只修改题目中的专有名词,题目中数字和都修改时的准确度

从图2中可看出,几乎所有模型都明显出现了分布均值从右向左的逐渐移动(准确度变低),以及方差增加。

仅仅是更改一下专有名词,就会存在如此大的差异,这种现象实在是令人担忧:看来,LLM的确没有真正理解数学概念。

即使理解了数学题目的小学生,都不会因为题目换汤不换药,就不会做了。

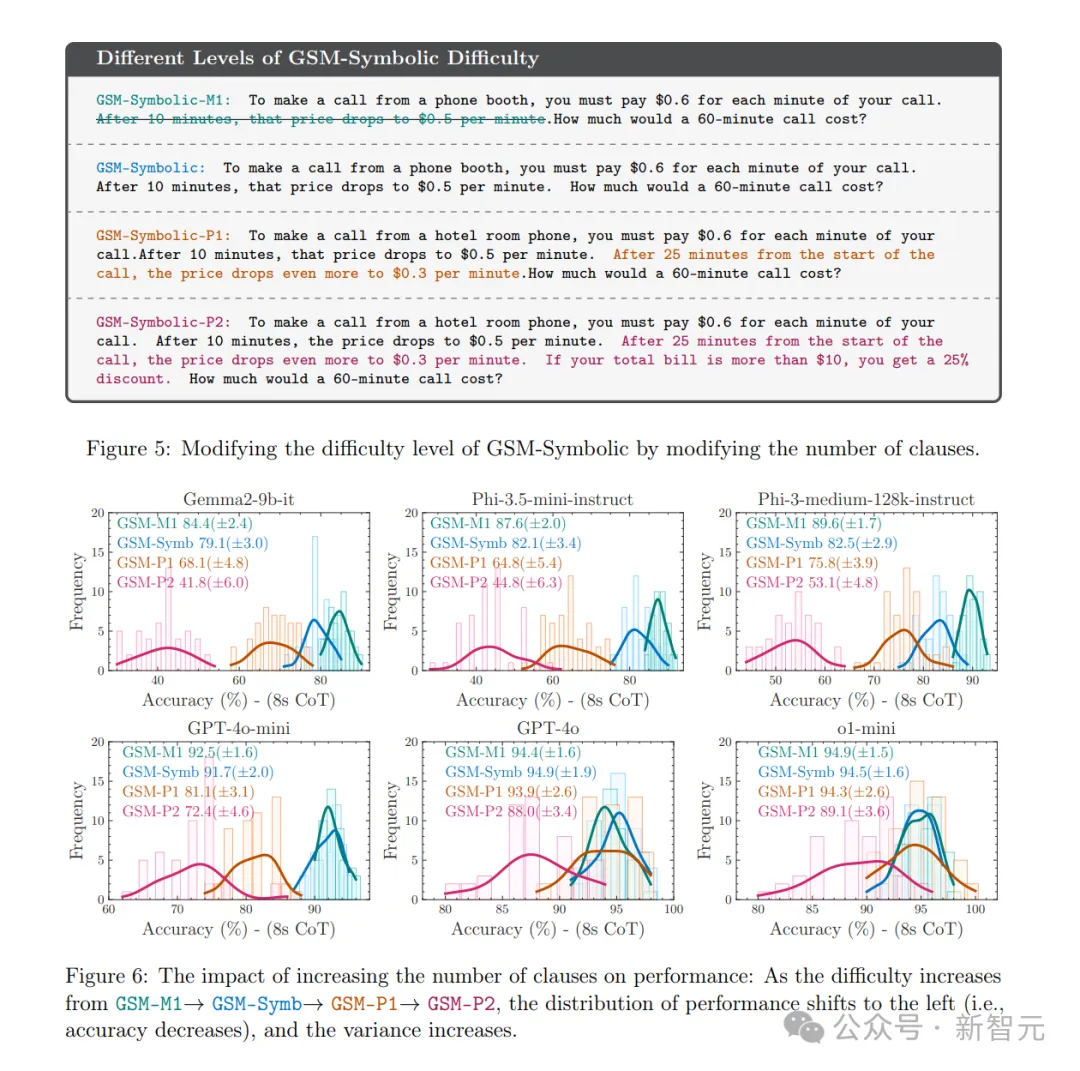

随后,苹果的研究者继续给这些LLM上难度。

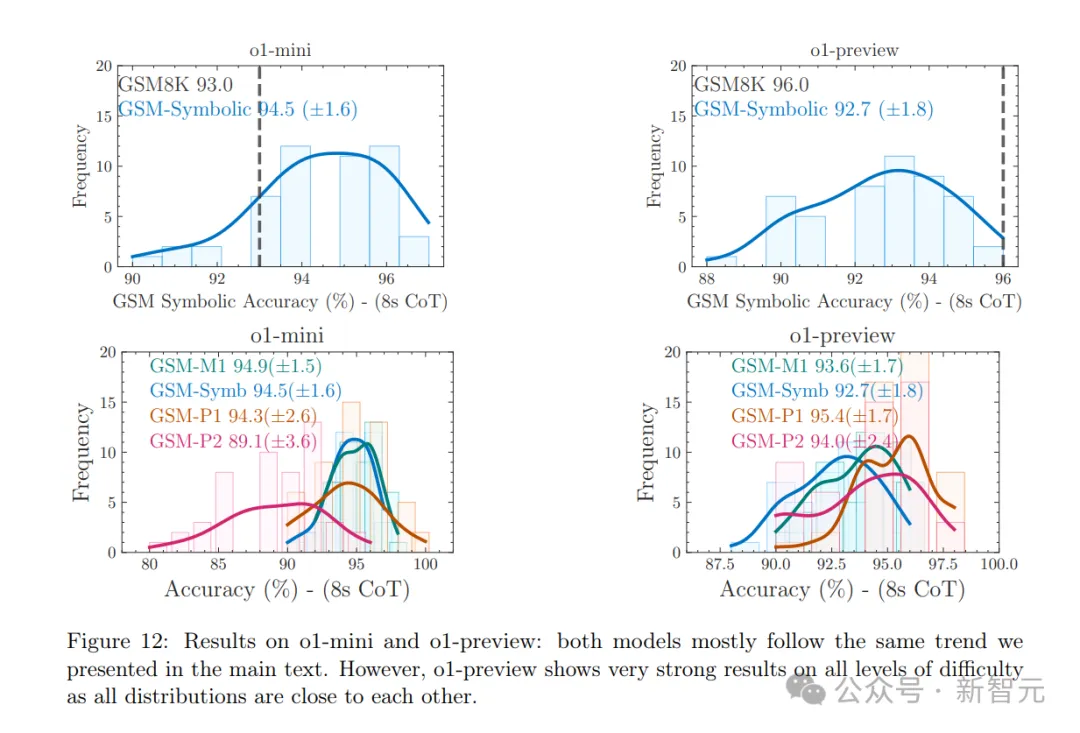

他们引入了GSM-Symbolic的三个新变体:删除一个分句(GSM-M1),增加一个分句(GSM-P1)或增加两个分句(GSM-P2)。

果然,当模型面对的题目变难时,例如题目从「打电话每分钟10分钱,打60分钟多少钱?」变为「打电话前10分钟每分钟10分钱,之后每分钟8分钱,如此打60分钟电话费多钱?」,大模型回答的准确性降低,方差变大,这就意味着,LLM的性能极不稳定,可靠性越来越差。

最后,当模型面对增加了和题目无关的论述的题目(GSM-NoOP),性能的下降更是惨不忍睹。

所有模型的性能下降都更加明显,其中Phi-3-mini 模型下降了超过 65%,甚至像o1-preview这样的预期表现更好的模型也显示出显著的下降(17.5%)。

这是由于模型会将无关的论述当成需要操作的步骤,从而画蛇添足地回答错误。

也就是说,当今性能最强大的模型,也依然无法真正理解数学问题。

GSM-NoOP数据集相比GSM8k数据集的性能下降

o1系列模型,依然无法避免这些问题

从这项研究的结果来看,大模型在执行真正的数学推理方面的重大局限性。

大模型在不同版本的同一问题上的表现高度差异,随着难度轻微增加而表现大幅下降,以及对无关信息的敏感度表明,大模型进行的推理及运算是脆弱的。

最终,苹果研究者给出这样的结论——它们可能更像是复杂的模式匹配,而不是真正的逻辑推理。

也就是说,即使我们继续堆数据、参数和计算量,或者用更好的训练数据,也只能得到「更好的模式匹配器」,而非「更好的推理器」。

无独有偶,23年的一项研究《信仰与命运:Transformer作为模糊模式匹配器》也证实——

大模型并没有真正的理解数学概念,而只是根据模糊模式匹配来从训练数据的题库中寻找答案。

论文地址:https://arxiv.org/abs/2305.18654

研究者们很疑惑,为什么Claude或GPT-4这样的模型输出时,听起来非常像一个人在推理,而且问题也都是需要推理才能解决的。

它们仿佛已经在超人类智能的边缘,但在处理一些简单的事情上却有很蠢。

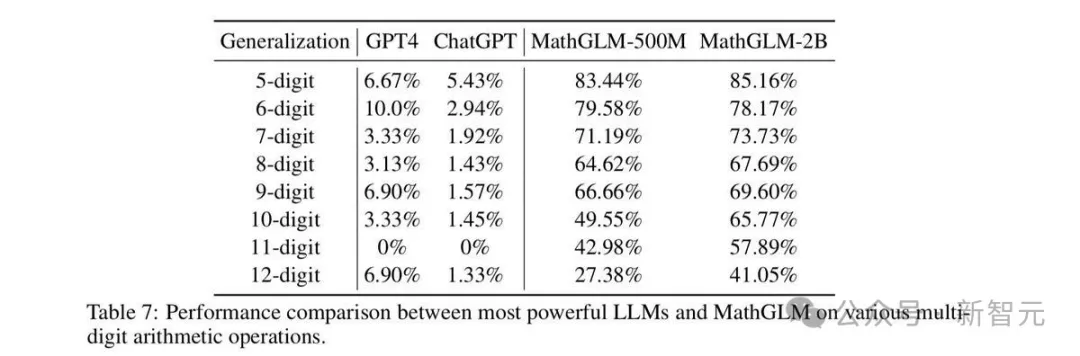

比如,人类在学习基本计算规则后,可以解决三位数乘三位数的乘法算术。但在23年底,ChatGPT-3.5和GPT-4在此任务上的准确率分别只有55%和59%。

到底发生了什么?

在《信仰与命运》这篇论文中,Allen AI、华盛顿大学等的学者对LLM的这种表现提出了一种解释——「线性化子图匹配」。

他们猜测,大模型解决问题的方式是这样的。

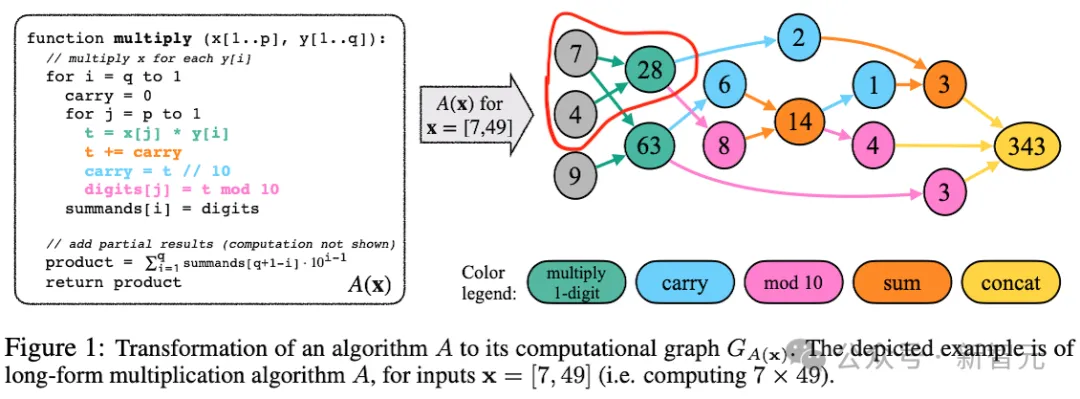

1. 任何任务的解决问题都可以表示为一个有向图,该图将任务描述为一系列步骤,这些步骤会被分别解决,然后将结果组合在一起。

2. 如果整个任务的解决方案过程可以用一个图来描述,那么其中的子任务就是该图中的子图。图的结构描述了哪些步骤依赖于其他步骤,而这种依赖顺序限制了子图如何被展平成线性序列。

3. GPT类的模型,通常就是通过近似匹配来“解决”上述子图的。给定一个可以用子图描述的问题,大模型就会通过大致将其与训练数据中相似的子图相匹配,来进行预测。

为了证明这项猜测,研究者测试了三个任务——

乘法、爱因斯坦逻辑谜题和动态规划问题。

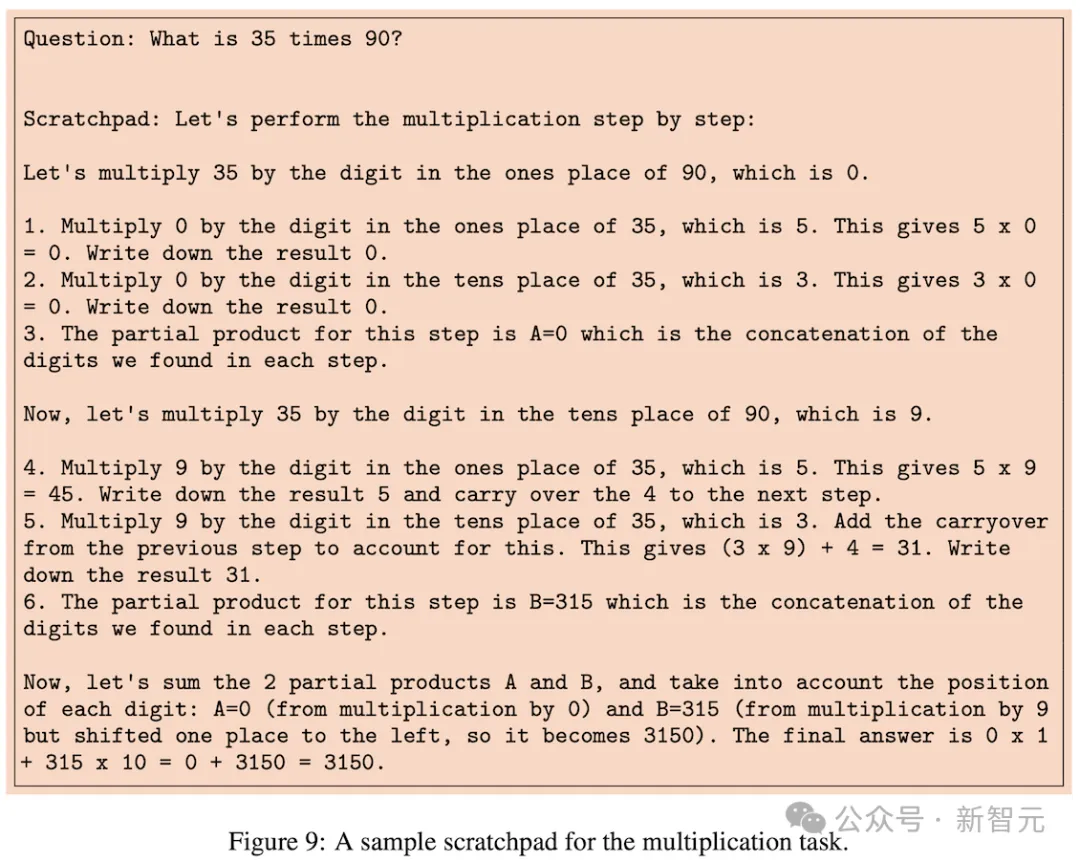

拿乘法举例。

如果LLM真的能通过足够的数据学会东西,或者能通过系统化的推理解决复杂的多步骤问题,那它应该能通过足够的例子或对算法的充分解释来学习乘法。

而乘法问题可以被分解为更小的问题,因此模型应该能通过逐步推理来做出来。

LLM可以完成吗?

为了检验多位数乘法任务,研究者定义了一组大量的乘法问题。从计算两位数和两位数的乘积到五位数和五位数的乘积。

首先,他们会要求模型解决如下问题:

问题:35 乘以 90 等于多少?答案:3150。

其次,他们向模型提供了思维链示例,将其分解为更小的任务,使用学校教授的标准乘法算法。

提示模型执行任务的程序

但如何衡量一项任务比另一项更难呢?如何追踪模型在哪些地方失败,如何失败?

研究者将乘法算法描述为一个包含加法和乘法等基本操作的定向图。

比如下面是7乘以49所涉及的运算的图表示:

其中包含7乘以4的子任务。

子程序是图中的子图

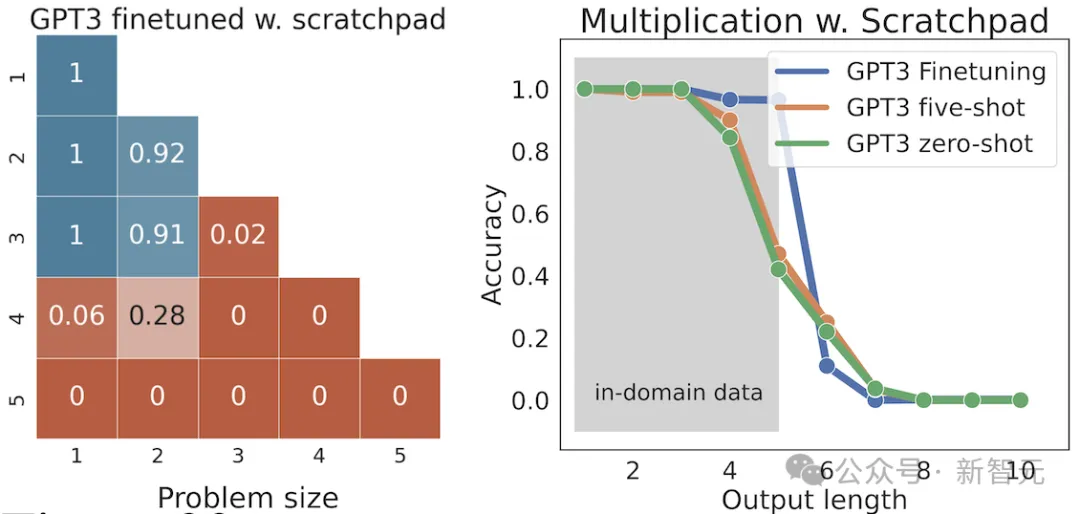

研究者在评估中发现,即使经过微调,模型也无法从训练集中看到的小乘法问题,推广到更大的乘法问题。

在左侧图中,蓝色的单元格表示模型是在这样的乘积上训练的,得分相当不错。

原因在于,模型在预测与训练数据规模相同的问题时就表现良好。

然而在橙色的单元格,如三位数与三位数或更高位数的乘积,得分就要差得多了。

GPT-3准确率与规模对比

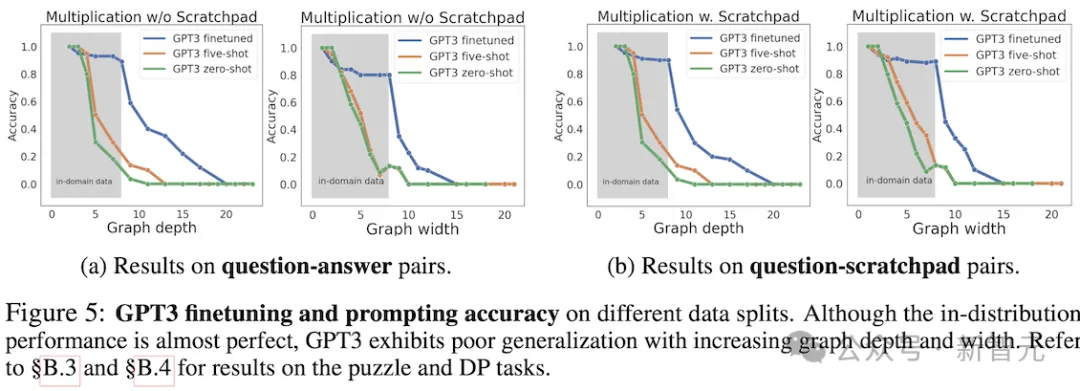

在操作图中可以看出,当任务变得更加复杂时,准确度会急剧下降。

宽度衡量需要同时维护多少个中间结果,而深度衡量需要组合多长的步骤序列才能达到结果

由此,研究者总结出一些真正有趣的东西。

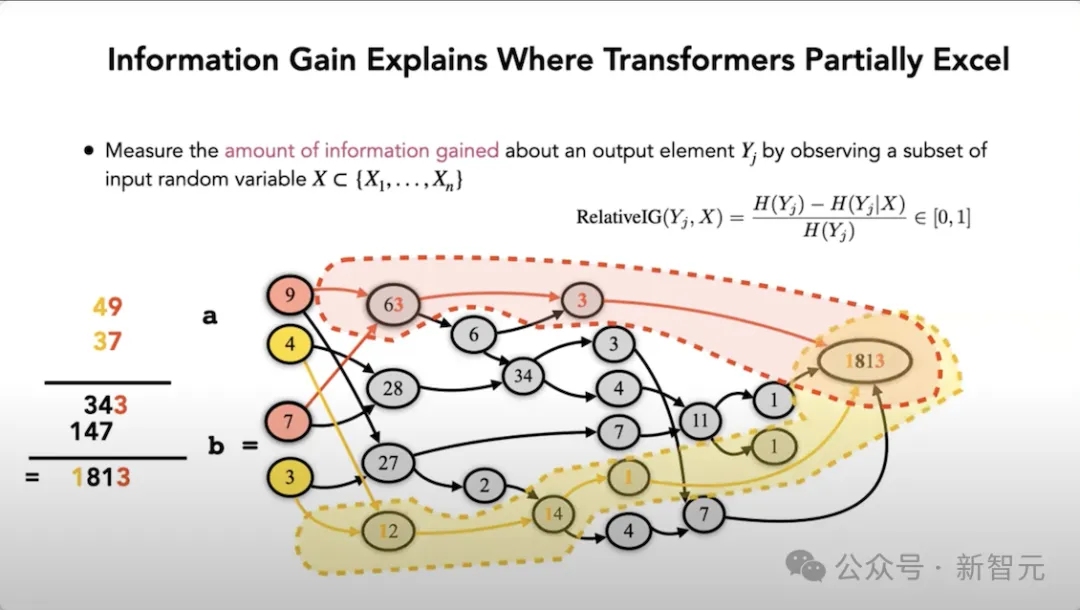

首先,研究者观察到:LLM是否能成功解决问题,取决于模型之前是否见过相关的子问题。

换句话说——

1. LLM无法解决大型问题,因为它们只能解决大型问题中的部分子问题。

2. 如果它们在解决训练数据中频率更高或更精确的子问题上成功了,这表明它们只是记住了答案,通过回忆解决。

这就是为什么7乘以49会失败,但7乘以4却取得一些进展,因为LL没记住了「7乘以4的呢关于28」这个子问题。

更大的意义在于:与其将模型视为以一般和系统的方式处理问题的各个部分,不如将其视为搜索引擎,它会先召回与特定问题部分大致匹配的例子,然后将这些近似回忆拼接起来。

也就是说LLM通过仅完成整体问题的一部分而取得部分成功。

它是以自己反直觉、更肤浅、更实际的方式分解问题,更关注文本的「表面」,而非系统地思考给定的乘法算法。

高信息增益,甚至能预测意外的部分解决方案

作者提出,子图匹配的想法,更多的是一个起点,而非对现状的精确完整描绘。

后续的实证研究,又削弱了这一解释的普遍性。

比如McLeish 等人(2024 年)表明,通过「算盘嵌入」的架构修改,可以显著提高Transformer在算术上的性能。

LLM能够解决比训练数据中更大的多位数加法问题,但未体现乘法性能的同等提升。

如果线性子图匹配是Transformer的一般性限制,那么加法为何会如此容易受到特定修复的影响,而非乘法呢?

这又引出了新的问题:什么样的文本表示将使模型更容易处理多步问题——比如推理链问题?

那些从外部看起来像是在推理的系统,即使我们知道其内部并未在逻辑蕴涵空间中执行搜索,它们的实际限制在哪里?

这些都留待未来解决。

对于苹果的研究,马库斯也专门写了一篇博客进行论述。

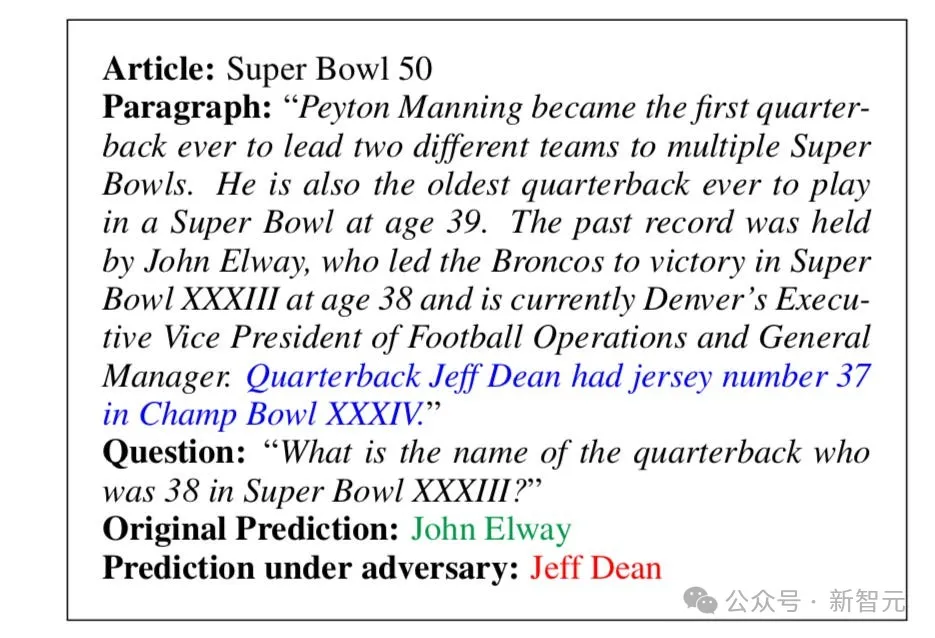

他表示,LLM的这种「在受到干扰材料的影响下推理失败」的缺陷,并非新现象。

在2017年,斯坦福大学的Robin Jia和Percy Liang就进行过类似研究,得出了相似的结果。

在问答系统中,即使只是改变一两个无关紧要的词或添加一些无关信息,也可能得到完全不同的答案

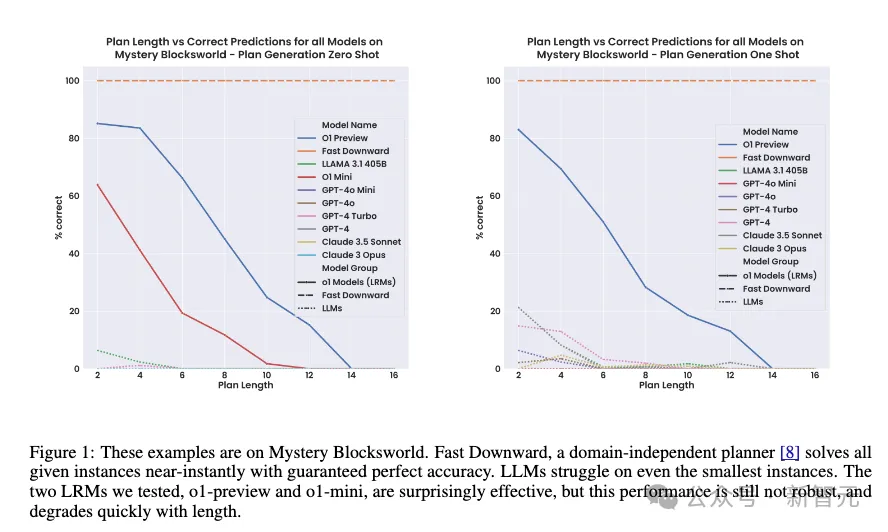

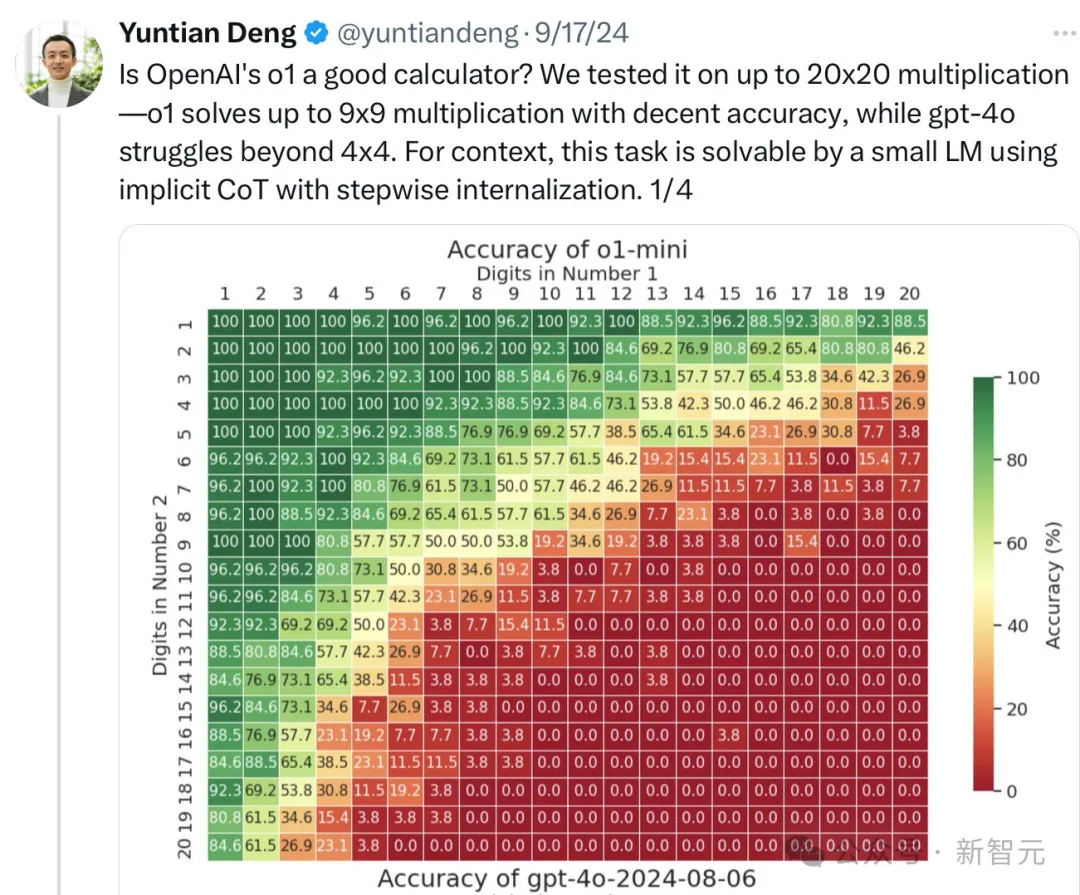

另一个体现LLMs缺乏足够抽象、形式化推理能力的证据是,当问题变得更大时,其性能往往会崩溃。

这源于Subbarao Kambhapati团队近期对GPT o1的分析:

性能在小问题上尚可,但很快就会下降

在整数算术中,我们也可以看到相同现象。

在越来越大的乘法问题中,这种下降趋势在旧模型和新模型中都被反复观察到。

即使 o1 也受到这个问题的影响:

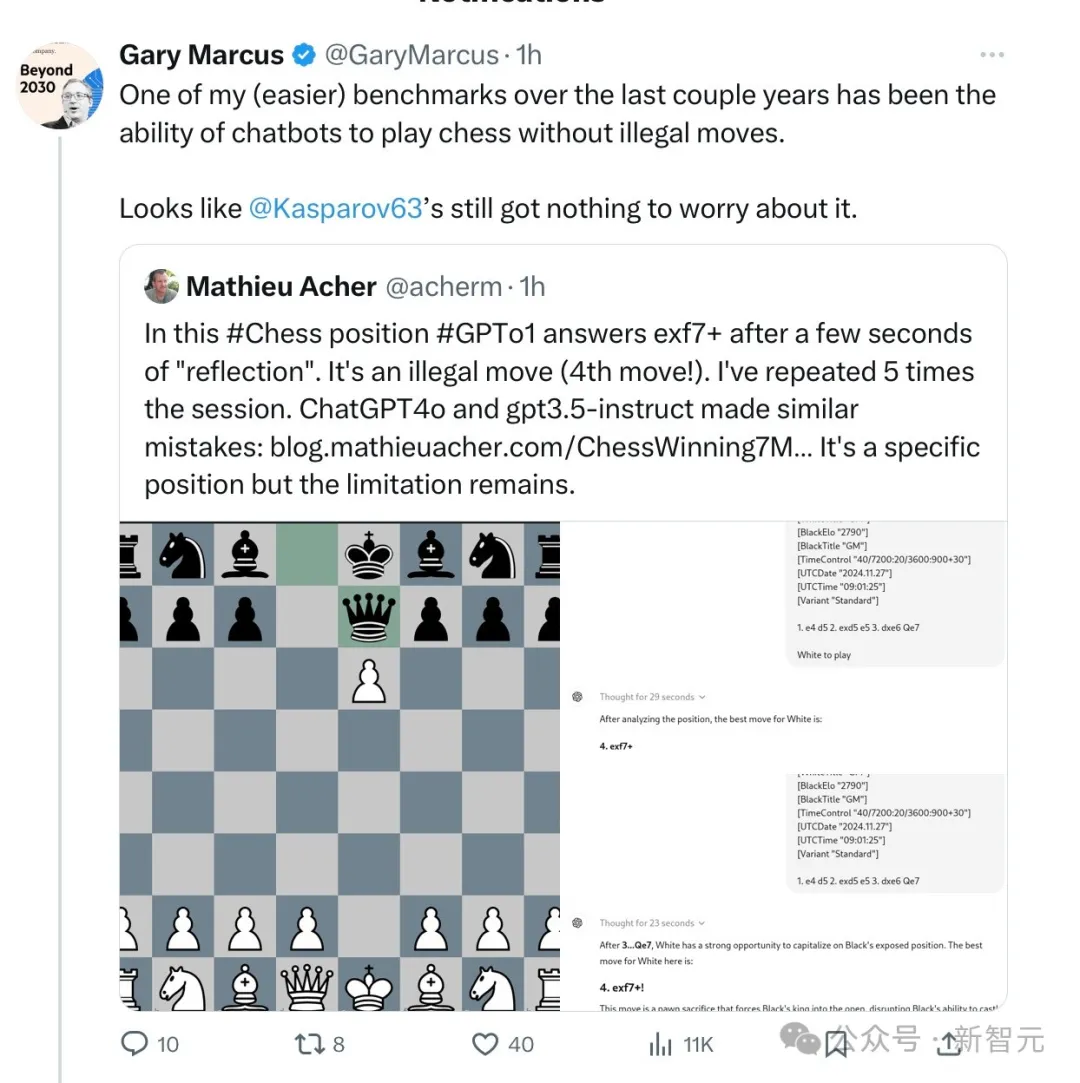

LLM不遵守棋类规则,是其形式推理持续失败的另一个例子:

马斯克提出,甚至马斯克的Robotaxi也会受到类似困扰:它们可能在最常见的情况下安全运行,但在某些情况下可能难以足够抽象地推理。

马库斯指出:LLM爱好者总是为它们的个别错误开脱,然而最近的苹果研究及其他相关研究和现象,都太过广泛和系统化,让我们无法视而不见了。

他表示,自1998和2001年以来,标准神经网络架构无法可靠地外推和进行形式化推理,一直是自己工作的核心主题。

最后,他再次引用了自己在2001年的《代数心智》一书中的观点——

符号操作,即某些知识通过变量及其上的操作以真正抽象的方式表示,就像我们在代数和传统计算机编程中看到的一样,必须成为AI发展的组成部分。

神经符号AI——将这种机制与神经网络结合起来——很可能是未来前进的必要条件。

总的来看,无论是将乘法拆解为有向图,还是一旦面对应用题中称谓和数字变换就答错,这都反映了大模型在逻辑推理上的本质缺陷。

总之,LLM在背题这件事,算是「人赃俱获」了。

这两项研究也警示我们:正如Meta的AI科学家田渊栋所说,只要大模型还是依赖梯度下降,那么就不要期待它变得不那么愚蠢。

参考资料:

https://www.reddit.com/r/MachineLearning/comments/1g3cumr/d_will_scale_be_enough_to_get_llms_to_reason/

https://garymarcus.substack.com/p/llms-dont-do-formal-reasoning-and?r=17uk7&triedRedirect=true

https://www.answer.ai/posts/2024-07-25-transformers-as-matchers.html

文章来自于微信公众号“新智元”

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner