GPU租用市场越来越玄幻了,价格被打下来的原因,居然可以是天命人闲置的4090被循环利用了?

最近,一种新型的GPU租赁方式开始兴起。

它能让手上有闲置计算卡的人,把资源租给需要的人。

举个例子,为了打黑神话买了4090的天命人,可以把卡租给炼丹侠们。自己能挂机“躺着”赚钱,炼丹侠还能以更划算的价格租算力(4090只需每小时1块钱那种)。

距离大范围算力荒才过去仅仅1年,算力租赁市场已经是一番新气象了。

不仅如此,老牌租赁平台们也纷纷主动降价。海外,H100价格被卷到每小时2美元。

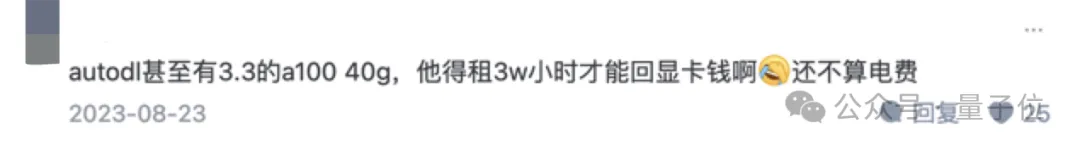

国内情况亦是如此,A100(80GB)租用价低至6.68元/小时,40GB为3.28元/时,A800则是5.98元/小时。

按理说,现在正是AI算力需求旺盛的时刻。大型云厂商打价格战为了跑马圈地还可理解,算力租赁平台价格没有水涨船高,反而开始降价……

这背后,到底发生了啥啊?

先一句话总结,相较于ChatGPT元年,AI算力告急问题总体得到缓解,但是依旧面临挑战。

如上变化由算力供需侧共同影响而来。

首先在算力供给上,大模型趋势进一步推动AI底层硬件以及基础设施发展。

国际方面,英伟达这两年不仅扩大了AI计算产品线,更在产能上大幅提升,以满足暴增的市场需求。

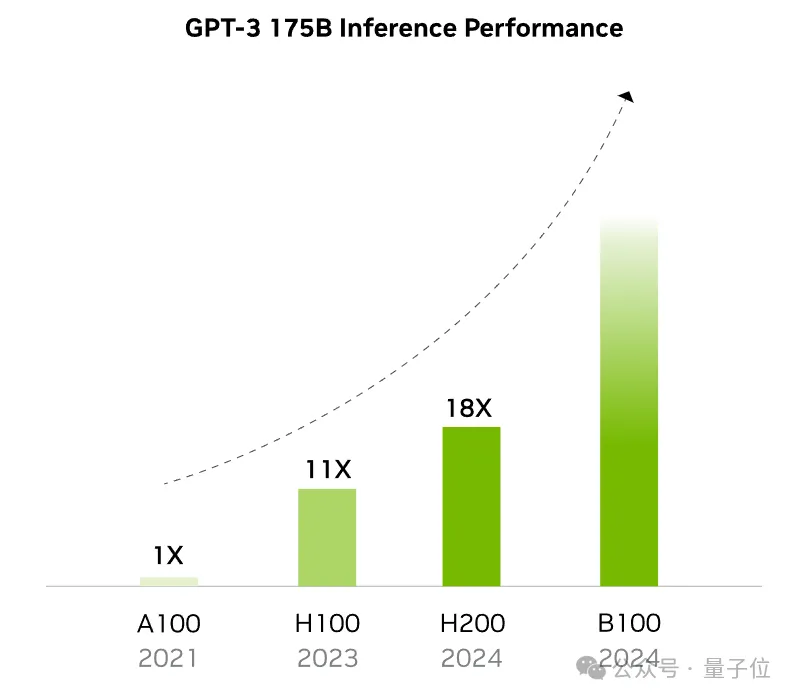

Hopper架构和Blackwell架构均包含Transformer引擎,分别推出了2款产品供市场选择,且不同架构之间的代际升级非常明显。B200的晶体管数量已达到2080亿,分别是H100的2.6倍、A100的3.8倍,后两者则发布于大模型浪潮之前。

两个B200 GPU与Grace CPU结合就成为GB200超级芯片。在标准1750亿参数GPT-3基准测试中,GB200的性能是H100的7倍,提供的训练算力是H100的4倍。

眼下首批工程版B200已经送到OpenAI投入使用。据天风国际分析师郭明錤透露,英伟达Blackwell GB200四季度的出货量将在15万块至20万块,明年第一季度出货量将显著增长200%-250%,达到50-55万块。

这同时带动了全行业的产品迭代升级节奏,AMD、英特尔等为保持竞争力,近两年也纷纷推出更先进AI计算产品。

更具规模的变化体现在算力基建方面。据中国信息通信研究院测算,截至2023年底,全球算力基础设施总规模达到910EFLOPS,同比增长40%。

美国、中国算力基础设施规模位列前两名,算力全球占比分别为32%、26%。

另一方面,算力需求也在近一年内发生变化。

随着开源模型性能达到GPT-4水平(如405B Llama 3、DeepSeek-v2等),以及中小模型(7B-70B规模)应用更加成熟,中小企业/开发者陆续入场,以及近期趋势推理Scaling law成为新方向。黄仁勋预测,随着推理链的出现,推理的规模预计将迎来千万乃至十亿倍的增长。

种种原因都导致市场的微调推理需求大幅增加,训练需求的增长趋势开始放缓。

相较于训练,推理阶段对硬件的要求没有那么高。在实际场景中,往往是用最先进设备进行训练,上一代产品进行推理。

因此可以看到,大型厂商依旧追捧H100、B200等高端GPU,但是中小企业/开发者不再趋之若鹜,转而关注更具性价比的选择。

但问题是,算力供需不平衡问题依旧棘手。

宏观上,《人工智能算力高质量发展评估体系报告》中表示,我国算力市场还面临供给不足、算力智能水平较低、能源考验、供应链完备性不足等问题。

微观上,以学术圈为例,“算力荒”还是普遍现象。

今年5月,李飞飞在采访中透露,斯坦福NLP实验室只有64块A100。相比于产业界,这个数字不值一提,但在高校圈里已经是相当富有了。

更普遍的现象是,许多高校实验室都只有消费级显卡,大家还需要排队使用。实验经费有限导致租赁算力也将面临更多制约。

在这些矛盾下,算力市场开始更加主动、自发提出新型应对措施。

最明显的迹象莫过于——经典算力平台主动降价+新兴算力租用模式浮现。

今年算力市场最热门的话题莫过于“价格战”,这并不局限于卖大模型服务的云厂商,提供算力租赁的各大平台也是主角。

不同类型的平台降价方式也有所差距。

目前算力租赁平台主要有两种类型:

前者好比京东,其所有的GPU服务器是自营资源,通常在提供算力的同时也保障一系列配套服务,能让用户更低门槛、更便利调用算力。该模式下,定价权在运营方自己手里,今年以来多家平台都在主动降价。

后者好比淘宝,为机主和用户提供平台,供双方进行服务交易。这种模式较为新兴,可以让有闲置计算资源的机主将GPU出租,“挂机赚钱”。它天生就能提供更具性价比的租赁价格。

不过需要注意,对于算力租赁,价格低只是考量因素之一,用户同时关注平台提供的服务能力。

对于前者,用户更关心平台提供的算力是否足够划算、使用是否足够友好;对于后者,机主和用户则更在意平台是否靠谱。

更具体的模式分析,来看行业典型案例。

经典算力云平台中,论谁打价格战最凶猛,AutoDL必是其一。

有资历的炼丹侠们对这个平台应该都不陌生。就是它当年把3090的租用价格从4.5元/小时打到了1.32元/小时,在用户这儿是有口皆碑了。

它在2021年上线,专注于提供弹性、好用、省钱的GPU算力服务。

GPU总规模在国内同类型平台中位列前茅,提供丰富的GPU选择,包括A100、A800、V100、4090、3090等。

它的主要目标用户包含了高校科研人群以及企业用户,所以在极具性价比的同时也主要入门友好。

平台支持各种深度学习框架,如TensorFlow和PyTorch,并提供相应的CUDA环境,用户可根据需求选择合适的镜像。

具体能力上,兼顾科研、企业需求。主要包括:

付费方面更符合“羊毛党”需求,主要提供按秒计费、包卡计费两种模式。

按量计费模式下,实例开机开始计费,关机结束计费,时长可精确到秒,最低计费0.01元。关机所有数据会保留(15天),支持镜像保存、文件存储等。

包年包月为预留GPU模式,支持按日按周按月等租用,价格比按量计费更便宜,长期使用更划算。

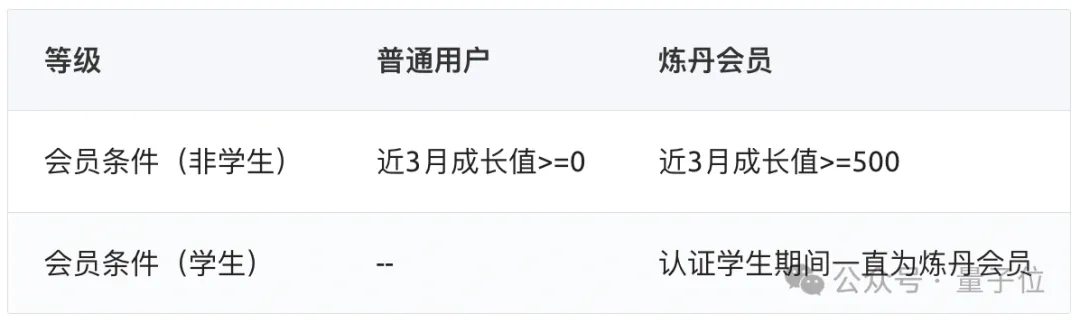

而且只要注册,平台就送一个月炼丹会员,认证学生直接升级炼丹会员,认证期间内将一直有效。会员将享有价格优惠。

另一方面,大模型趋势兴起后,C2C(用户对用户)模式变得火热。

硅谷的代表为San Francisco Compute,从寂寂无名到成为黑马,它仅仅用了半年时间。还拿下了山姆·奥特曼弟弟领投的1200万美元种子轮融资,估值达到7000万美元。

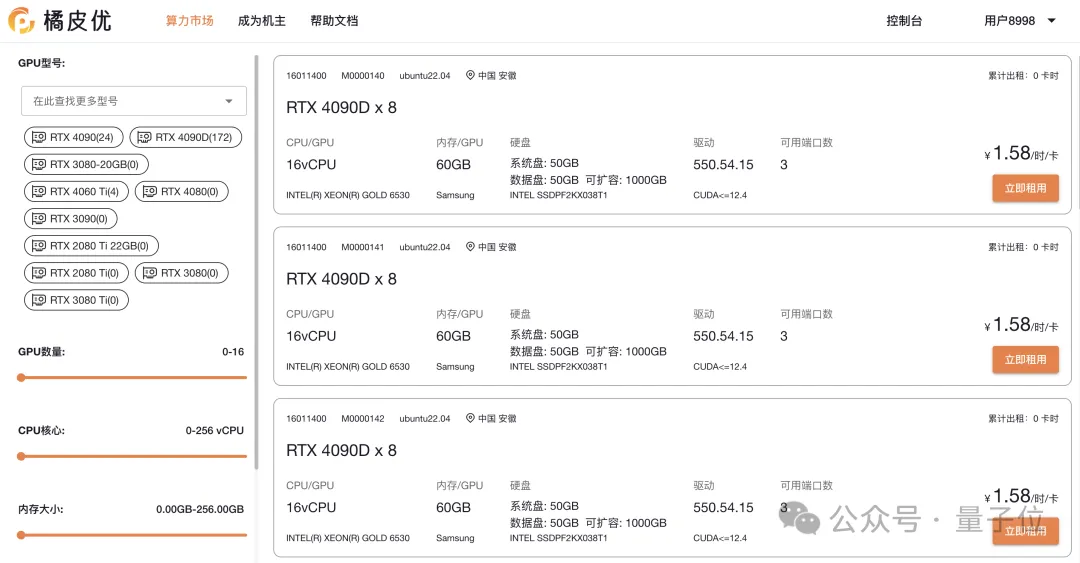

国内如今也出现类似趋势,比如刚刚上线3个月的橘皮优,现已和AutoDL达成战略合作。

按照自我定义,橘皮优是一个促进C2C双边AI算力交易的撮合平台。

它的核心目标是通过共享经济的模式,降低用户使用AI算力的成本,同时让私有闲置算力被高效应用,推动了算力普惠和绿色低碳。

该平台支持的算力类型包括GPU、NPU、CPU、ASIC、ARM、RISC-V等,能够满足AI训练、AI推理、图像生成以及渲染等任务需求。

相较于AutoDL,橘皮优提供的算力租赁服务价格更低,适用于对机器配置不敏感的人群。

同时它更加定制化,支持个人的外部镜像、实例端口灵活。

也可以在该平台上成为机主对外出租赚外快,支持自助上机,不限制机器和数量。

由于和AutoDL达成战略合作,背后团队是算力行业老兵,在鱼龙混杂的算力市场里是更加靠谱的选择。

或许也不用担心没人来租,毕竟AutoDL靠着性价比优势,在短短3年时间里形成庞大的用户基础。之前大家用卡都是靠抢的。

所以也不免有人好奇,这么低的价格,它图啥啊?

其实,AutoDL技术团队本身就来自学术圈,从2017年开始就在做GPU相关服务。这样的出身背景下,AutoDL团队自然更懂AI行业痛点,并积累了丰富经验。

由此也就不难理解AutoDL为何坚持提供量大管饱还划算的算力资源。

随着AI大模型应用落地趋势继续,对AI算力的需求还会继续增加。

对于很多科研高校、中小企业而言,算力会成为研发和落地应用上的第一道门槛。

如今,随着算力租赁市场发展更加完善,模式更加多样化,使用算力也变得像去食堂打饭一样——量大管饱还实在。

对于行业而言,这能更大程度缓解算力供需不平衡问题,同时也让资源实现更高效绿色流转。

当然,最主要的还是各位炼丹师们可以薅到羊毛,因为玩黑神话入手4090的天命人们也能找到回本的渠道。

最后,附上文中两个平台的官网,感兴趣同学可进一步了解!

AutoDL官网:https://www.autodl.com

橘皮优官网:https://gpu.pro

文章来自于“量子位”,作者“小明”。

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner