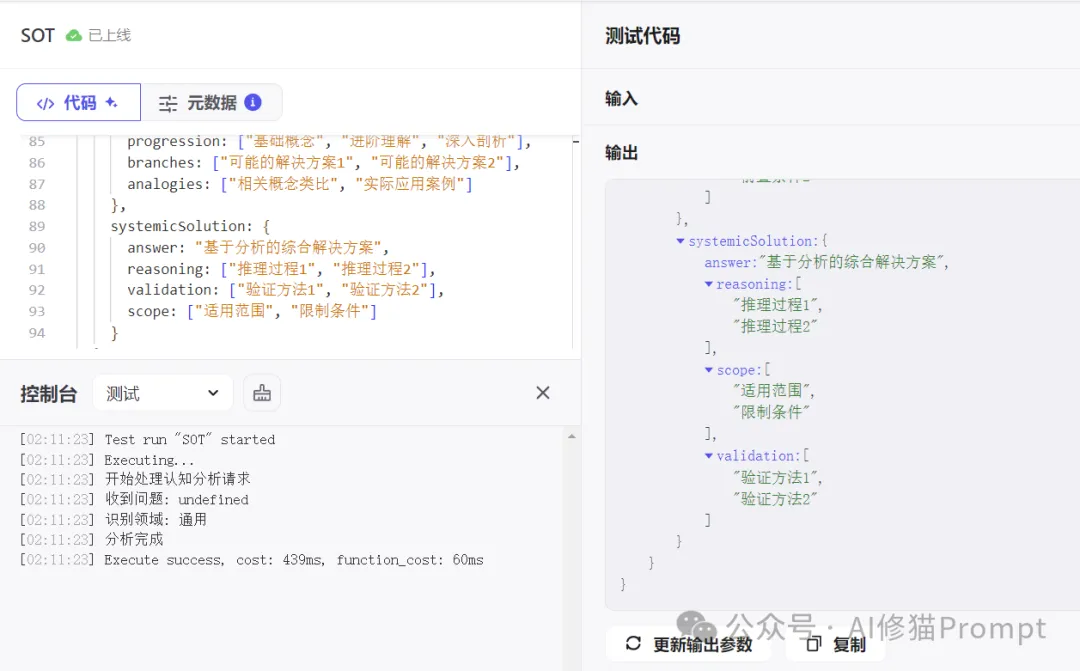

如何通过更好的提示工程来提升模型的推理能力,一直是研究人员和工程师们关注的重点。从最初的 few-shot learning 到 Chain of Thought(CoT),再到 Tree of Thoughts(ToT)和 Graph of Thoughts(GoT),prompting 技术在不断进化。而最新的研究表明,一个出人意料的方向可能带来突破性的进展——那就是将叙事(Narrative)元素引入到 prompt 中。我已经将本文的Prompt方法写成一个coze插件,有兴趣的朋友可以在coze中调用[插件SOT]。

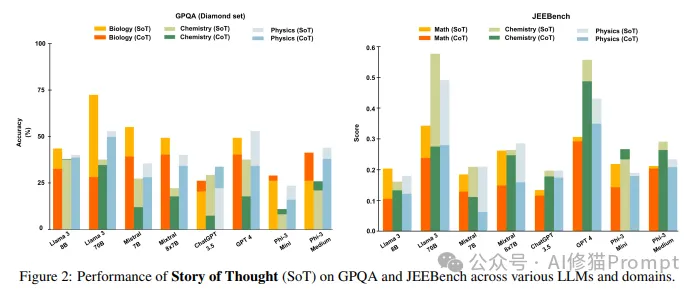

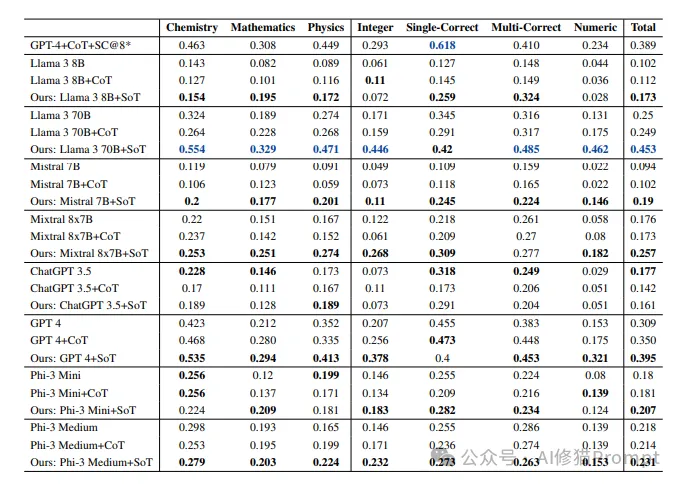

来自波恩大学等机构的研究者们提出了一种新颖的 prompt 框架——Story of Thought(SoT),该方法通过构建叙事性的信息组织方式来增强 LLM 的推理能力。这项研究不仅在理论上很有趣,更重要的是在实践中展现出了优异的效果:在复杂的科学推理任务 GPQA 和 JEEBench 上,SoT 的表现超越了包括 CoT 在内的现有方法。

在深入 SoT 框架之前,我们需要理解为什么要在 prompt 中引入叙事元素。这个想法源于一个基本的认知科学发现:相比于简单罗列事实,人类更容易通过故事化的方式来理解和记忆复杂的概念。在科学传播、教育和医疗沟通等领域,叙事方法已经被证明能够有效地帮助人们理解复杂信息。

研究者们提出了一个有趣的假设:既然叙事能够帮助人类更好地理解和推理,那么它是否也能够帮助 LLM 更好地处理复杂问题?这个假设主要基于两点考虑:

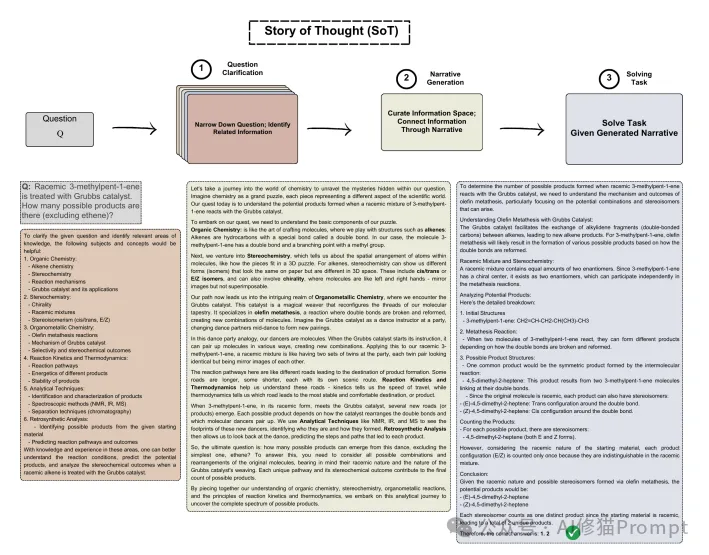

Story of Thought:一个三步走的叙事推理框架

SoT 框架的核心是将复杂问题的解决过程分解为三个关键步骤:

在这个阶段,模型需要扮演"探索者"的角色,仔细分析问题并识别相关的专业领域知识。这一步的目的不是解答问题,而是要:

示例 prompt:

You are an explorer who wants to identify and collect different related and specialized subject areas to clarify the question. Your goal is to narrow down the question and provide relevant areas of knowledge and experience you have that help clarify the question mentioned below. You should not answer the question.

这是 SoT 框架最具创新性的部分。在这个阶段,模型需要基于第一步的分析结果,构建一个结构化的叙事来帮助理解问题。这个过程中会运用五种关键的叙事技巧:

1. 渐进式披露(Progressive Disclosure):

2. 分支叙述(Branching):

3. 类比(Analogy):

4. 类比推理(Analogical Reasoning):

5. 隐喻(Metaphor):

示例 prompt:

You are an expert in narrative-based explanations for science communication. Your goal is to clarify the following question in a narrative way through the interconnected information provided below to enable a non-expert to comprehend the question in a more coherent and contextually rich manner. You should not answer the question.

Make sure to use all of these narrative techniques when clarifying the question through the interconnected information: Progressive Disclosure, Branching, Analogy, Analogical Reasoning, and Metaphor.

最后一步是基于生成的叙事框架来解决原始问题。这个阶段的关键是要充分利用叙事中建立的结构化理解。

示例 prompt:

You are an expert in analyzing narrative-based explanations for solving tasks. Please answer the following question based on the following narrative-based clarification.

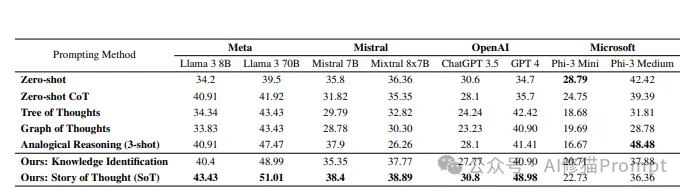

实验结果:叙事框架的效果如何?

研究团队在两个具有挑战性的数据集上进行了详尽的实验:

GPQA(Graduate-level Problem-solving QA)是一个包含高质量研究生水平问题的数据集。在这个数据集上的实验结果显示:

特别值得注意的是不同学科领域的表现:

JEEBench 是一个包含 515 个具有挑战性的预工程数学、物理和化学问题的数据集。实验结果显示:

深入分析:为什么叙事框架有效?

研究者们对 SoT 的效果进行了深入分析,发现了几个关键的成功因素:

4.1 叙事技巧的协同效应

实验表明,单独使用某一种叙事技巧的效果不如综合运用所有技巧:

4.2 模型规模与叙事能力的关系

研究发现,模型规模与叙事生成能力存在明显关联:

4.3 叙事质量分析

研究者们使用 Llama 3 70B 对不同模型生成的叙事进行了质量评估,统计了各种叙事技巧的使用频率:

实践指南:如何在实际工作中应用 SoT?

作为 prompt 工程师,如何将 SoT 框架应用到实际工作中?以下是一些具体建议:

5.1 选择合适的场景

SoT 特别适合以下场景:

5.2 优化提示词设计

在设计 prompt 时需要注意:

局限性与未来展望

虽然 SoT 展现出了良好的效果,但研究者们也指出了一些局限性:

6.1 技术局限

6.2 应用局限

Story of Thought(SoT)的提出和验证,为提升 LLM 的推理能力提供了一个新的视角。这种将认知科学中的叙事概念与 prompt 工程相结合的方法,不仅在学术研究中展现出了优异的效果,也为实际应用提供了新的可能性。对于 prompt 工程师而言,SoT 框架提供了一个强大的工具,可以帮助我们更好地处理复杂的推理任务。通过将传统的思维链条与结构化的叙事相结合,我们或许能够帮助 LLM 在复杂推理任务上取得更大的突破。

文章来自于“AI修猫Prompt”,作者“AI修猫Prompt”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0