PromptTuner:基于 HarmonyOS 6 的提示词助手应用技术实践分享

PromptTuner:基于 HarmonyOS 6 的提示词助手应用技术实践分享项目缘起:从 0 到 1 的 PromptTuner 诞生之路 随着大模型技术的普及,AI 交互已成为日常工作的重要组成部分。然而,如何写出高质量的提示词(Prompt)却成为普通用户面临的新挑战。

项目缘起:从 0 到 1 的 PromptTuner 诞生之路 随着大模型技术的普及,AI 交互已成为日常工作的重要组成部分。然而,如何写出高质量的提示词(Prompt)却成为普通用户面临的新挑战。

新年第一天,DeepSeek 发布了一篇艰深晦涩的技术论文,不少网友直呼「看不懂」。

最近,一个澳大利亚的养羊大叔用5行代码捅破AI编程天花板的故事,彻底火出圈了。2025年底,在铲羊粪的间隙,Geoffrey Huntley写出了下面这个仅含5行代码的Bash脚本while :; do cat PROMPT.md | claude-code ; done

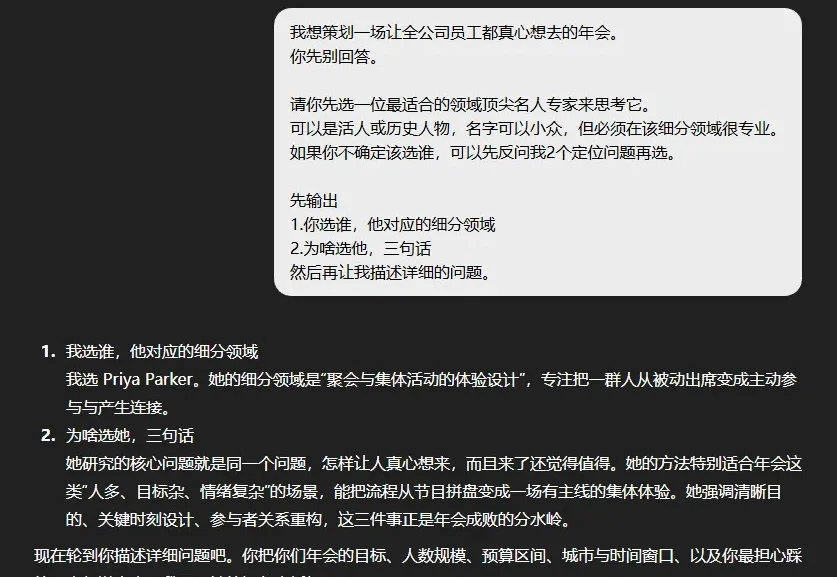

已经2026年了,其实还是看到很多朋友,说不知道怎么能更好的跟AI对话。

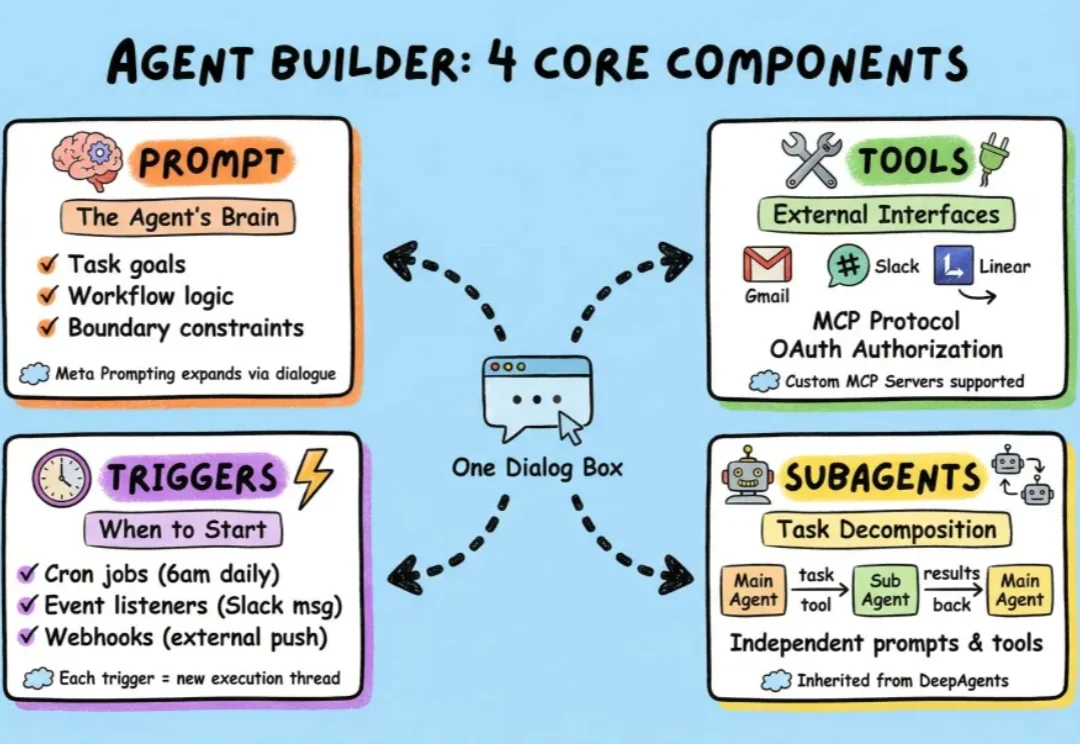

过去一段时间,我们介绍了很多小白入门级的agent框架,也介绍了包括langchain在内的很多专业级agent搭建框架。

在 LLM Agent 领域,有一个常见的问题:Agent 明明 "看到了" 错误信息,却总是重蹈覆辙。

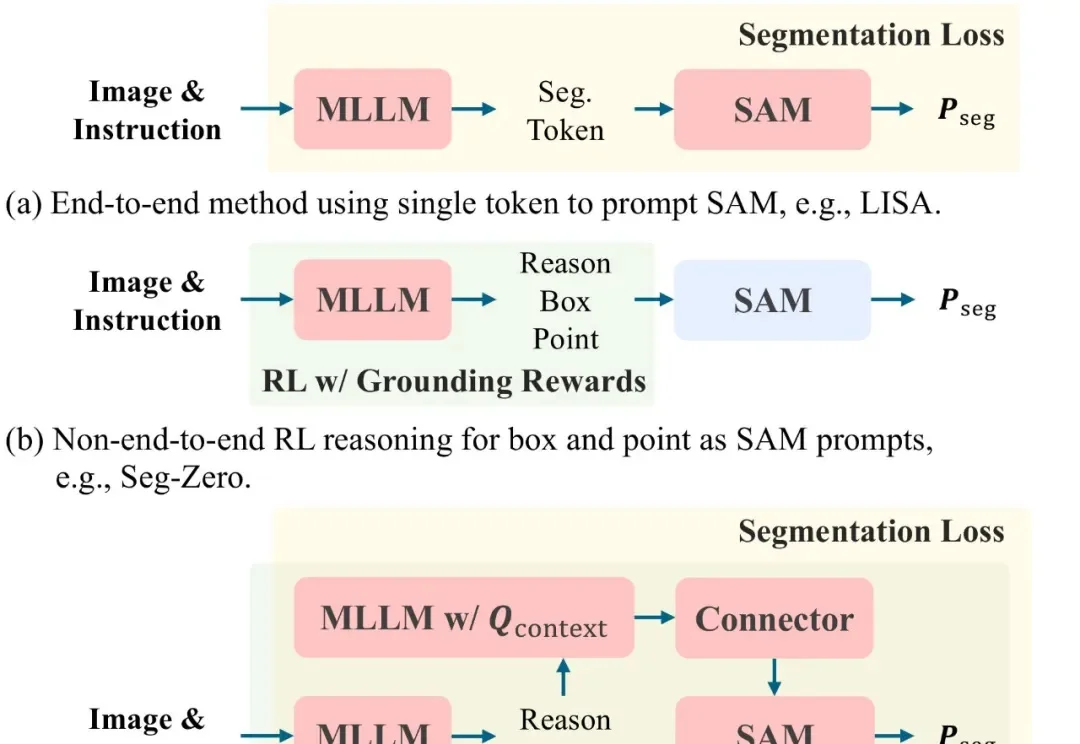

文本提示图像分割(Text-prompted image segmentation)是实现精细化视觉理解的关键技术,在人机交互、具身智能及机器人等前沿领域具有重大的战略意义。这项技术使机器能够根据自然语言指令,在复杂的视觉场景中定位并分割出任意目标。

最初只是我写了一个特别好玩的 prompt,那个 prompt 是一个代入修仙世界的文字游戏,没想到这个 prompt 会成为所有故事的起点。后来我们把 prompt 包了一下,上了个简单的网页,实际上开发1周,形态是chatbox,纯文本+流式输出,有选项、死亡状态,非常简单的一波流的小玩具,但是也收到了很多正向反馈。

最绝望的事,莫过于,错过了自己那个本该精彩的人生。所以,我突然有一个想法,就是AI明明现在都这么强了。那,为什么不可以,帮我挖掘我们自己真正的天赋呢?说干就干,在花了一下午时间,迭代了好多版Prompt之后。

用零手写代码、零成本、零部署压力的“三无”AI生成应用,把Prompt换成真金白银的第一批“野生开发者”已经出现了。