两个月前,马斯克才刚刚自曝了xAI的Colossus超算,称其是世界上最强大的AI训练系统。

最近,马斯克又宣布了一条振奋人心的消息——集群即将扩展到20万张H100/H200显卡!

同时,ServeTheHome也发布了一条15分钟的视频,公布了这台超算的详情!

来自ServeTheHome的Patrick Kennedy带着摄影机探访了这台超级计算机

这台全球最大的AI超级计算机Colossus位于美国田纳西州孟菲斯,配备了10万个英伟达Hopper GPU,并由英伟达Spectrum-X以太网提供网络传输支持。

目前,Colossus的第一阶段建设已完成,集群全面上线,但这并不是终点。它将很快迎来升级,GPU容量将翻倍,新增5万块H100 GPU和5万块下一代H200 GPU。

Colossus正在用于训练xAI的Grok,并为X Premium订阅用户提供聊天机器人功能。

在训练超大规模的Grok时,Colossus展现了前所未有的网络性能。在网络结构的所有层级中,系统在流量冲突的情况下没有经历任何应用延迟降级或数据包丢失。

通过Spectrum-X拥塞控制,它保持了95%的数据吞吐量。这种性能水平无法通过标准以太网实现,标准以太网在传输中会产生数千次流量冲突,数据吞吐量仅能达到60%。

由于保密协议的限制,这台超级计算机的一些细节并没有透露。不过,像Supermicro GPU服务器等关键部件的介绍在视频中都有所涉及。

Colossus集群的基本构建单元是Supermicro液冷机架。

每个机架包含八台4U服务器,每台服务器配备八个英伟达H100,共计64个GPU。

八台此类GPU服务器再加上一个Supermicro冷却分配单元(CDU)及相关硬件,构成了一个GPU计算机架。

这些机架以八台为一组排列,共512个GPU,并通过网络连接,形成更大系统中的小型集群。

xAI使用的是Supermicro 4U通用GPU系统。

这是目前市面上最先进的AI服务器,有2个原因:其一是它的液冷程度;其二是设备的可维护性。

该系统被放置在托盘上,无需将系统从机架中移出即可维护。1U机架分流器可为每个系统引入冷却液并排出温热液体。快速断开装置让液冷系统可以迅速移除,甚至可以人工单手拆装;移除后,托盘即可拉出以便维护。

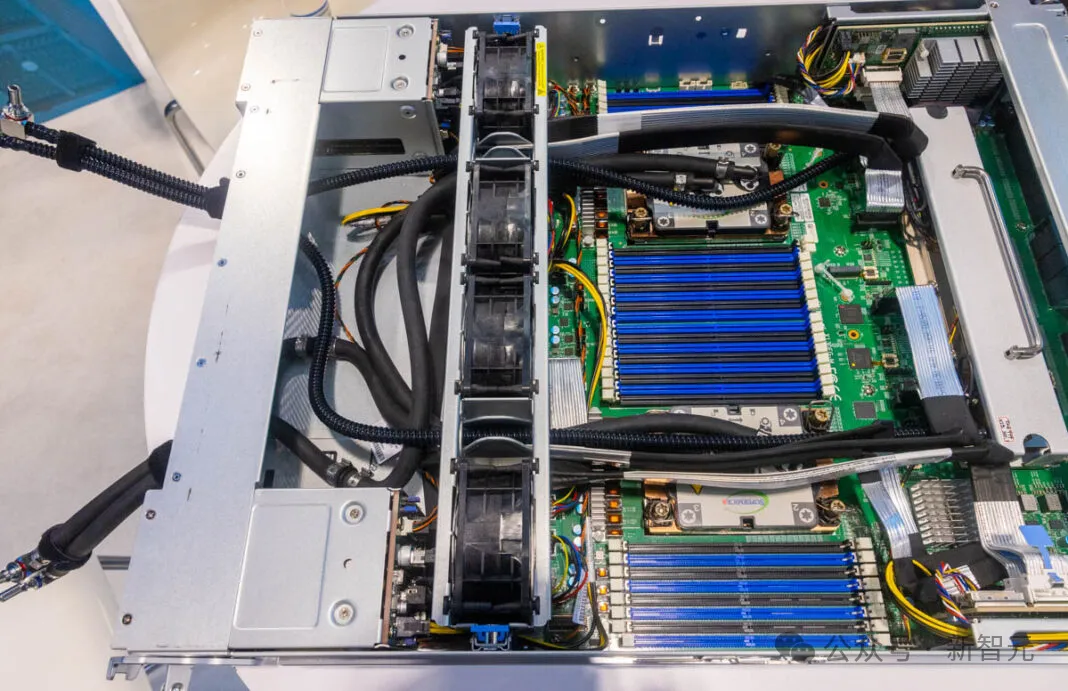

下图是一张该服务器原型的照片,展示了这些系统的内部构造。

SC23展示的Supermicro 4U通用GPU系统:支持液冷英伟达HGX H100和HGX 200

上图SC23原型中的两个x86 CPU液冷模块相对常见。

特别之处在于右侧:Supermicro的主板集成了几乎所有HGX AI服务器中使用的四个Broadcom PCIe交换机,而非将其单独安装在另一块板上。Supermicro为这四个PCIe交换机设计了定制液冷模块。

其他AI服务器通常是在风冷设计的基础上加装液冷,而Supermicro的设计则完全从零开始,为液冷而打造,且所有组件均来自同一供应商。

打个通俗的比方,这类似于汽车——有些车型先设计为燃油车,之后再安装电动动力系统,而有些车型从一开始就是为电动车设计的。这款Supermicro系统就属于后者,而其他HGX H100系统则属于前者。

Patrick怒赞道:测评了各种各样的液冷系统设计,这款Supermicro系统遥遥领先于其他系统!

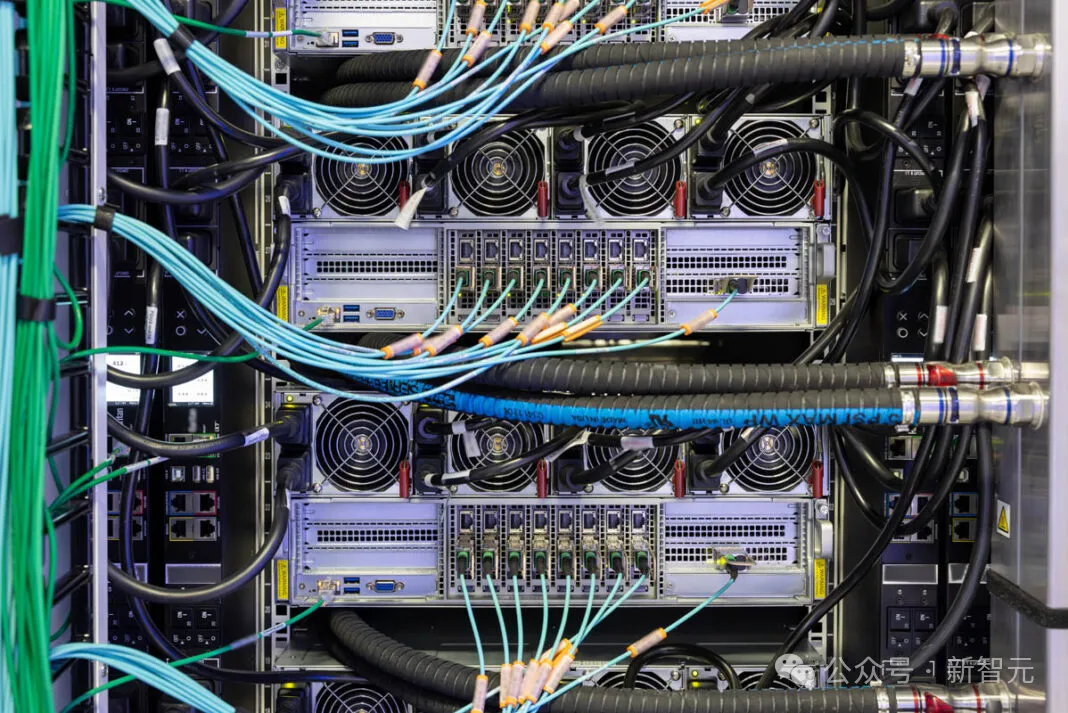

这里的每条光纤连接速率为400GbE,是常见1GbE网络速率的400倍。此外,每个系统拥有9条这样的连接,意味着每台GPU计算服务器的带宽达到约3.6Tbps。

打个比方,如果1GbE的普通家庭网络好比是一条单车道公路,那这个400GbE就像是一条拥有400车道的高速公路。而每个系统有9条这样的「高速公路」,相当于每台GPU计算服务器拥有9条这样的超宽带公路,总带宽达到3.6Tbps。

这个带宽甚至超过了2021年初顶级Intel Xeon服务器处理器在所有PCIe通道上所能处理的连接总量。

GPU的RDMA网络构成了该带宽的大部分。每个GPU都有自己的NIC。

在这里,xAI使用英伟达BlueField-3 SuperNIC和Spectrum-X网络。英伟达的网络堆栈中加入了一些独特技术,可以帮助数据绕过集群中的瓶颈,确保数据准确地传输到指定位置。

这是一个重大突破!许多超级计算机网络使用的是InfiniBand或其他技术,而这里采用的是以太网。

以太网是互联网的骨干,因此它具有极强的扩展性。这些庞大的AI集群已扩展到一些更小众技术未能触及的规模。对于xAI团队而言,这确实是一个大胆的举措。

除了GPU的RDMA网络外,CPU也配备了400GbE连接,但使用完全不同的交换结构。xAI为其GPU和集群的其余部分分别配置了独立的网络,这在高性能计算集群中是非常常见的设计。

除了高速集群网络外,还有低速网络用于管理接口和环境设备,这些都是此类集群的重要组成部分。

参考资料:

https://www.servethehome.com/inside-100000-nvidia-gpu-xai-colossus-cluster-supermicro-helped-build-for-elon-musk/3/

文章来自于微信公众号“新智元”