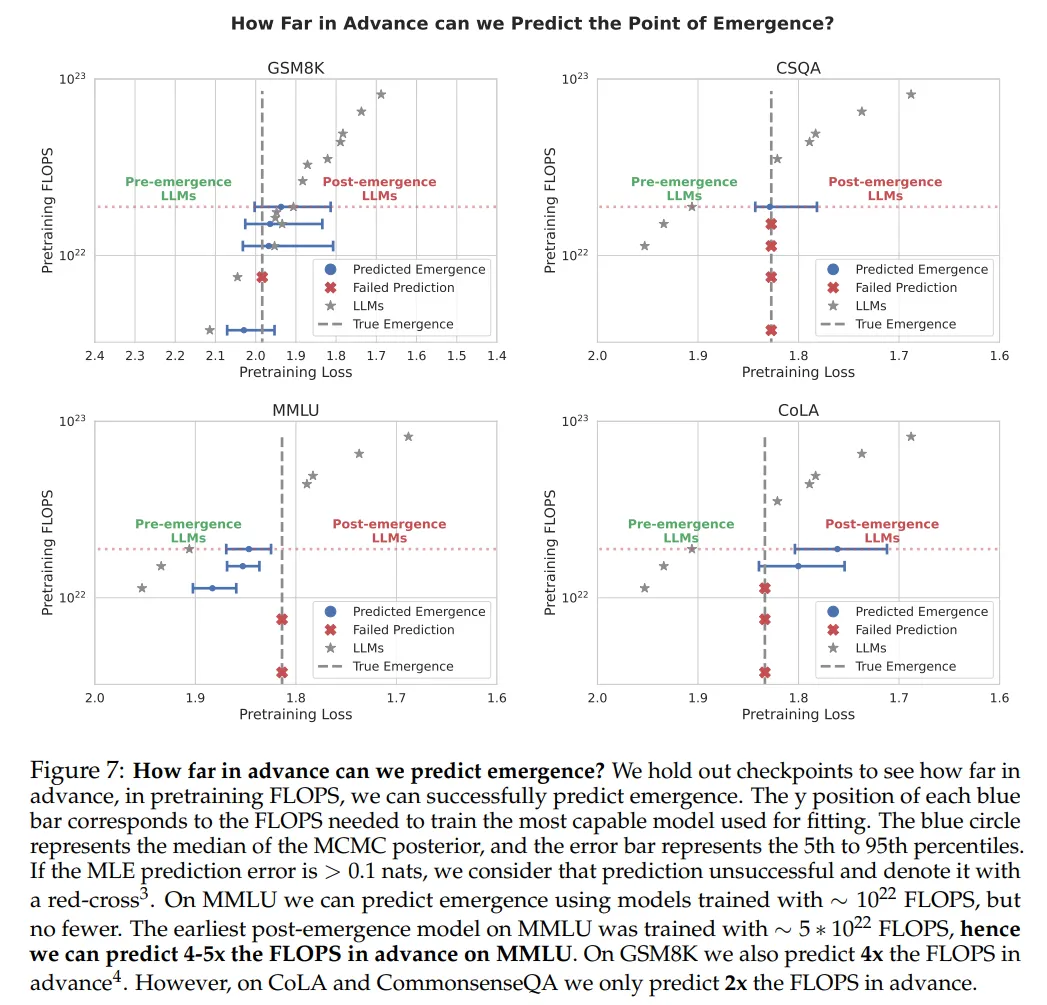

LLM 规模扩展的一个根本性挑战是缺乏对涌现能力的理解。特别是,语言模型预训练损失是高度可预测的。然而,下游能力的可预测性要差得多,有时甚至会出现涌现跳跃(emergent jump),这使得预测未来模型的能力变得具有挑战性。

最近,来自加州大学伯克利分校(UC 伯克利)的研究团队提出涌现预测的任务:是否可以仅通过使用 GPT-N 模型的检查点(即当前模型的状态)来预测 GPT-N+1(未来模型)是否会出现涌现能力? 并在论文《Predicting Emergent Capabilities by Finetuning》中给出了答案。

值得注意的是,这篇论文的作者包括强化学习大牛 Sergey Levine。

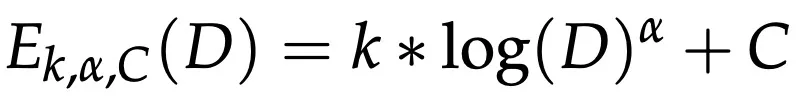

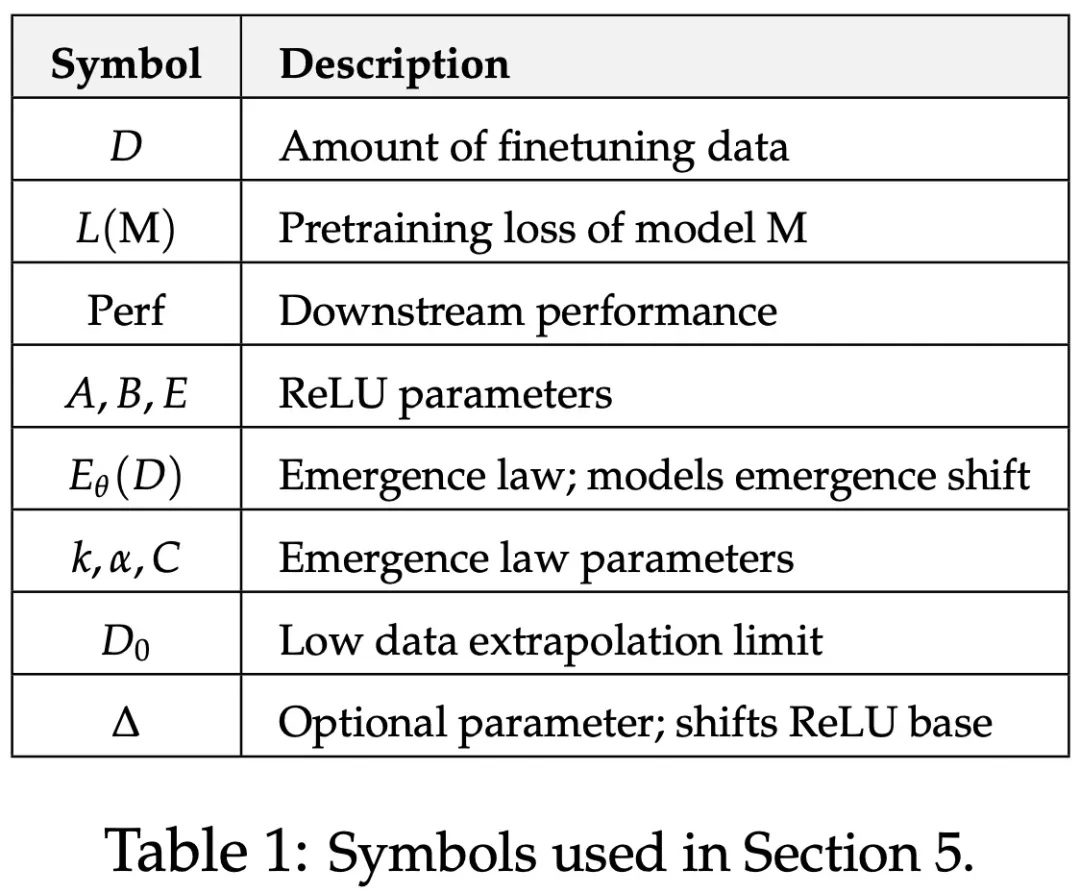

该研究拟合了一个参数函数 —— 涌现定律,模拟了涌现点如何随数据量的变化而变化。

为了进行验证,该研究使用四个标准 NLP 基准 ——MMLU、GSM8K、CommonsenseQA 和 CoLA。通过仅使用小规模 LLM 来拟合涌现定律,该研究能够准确预测涌现点。

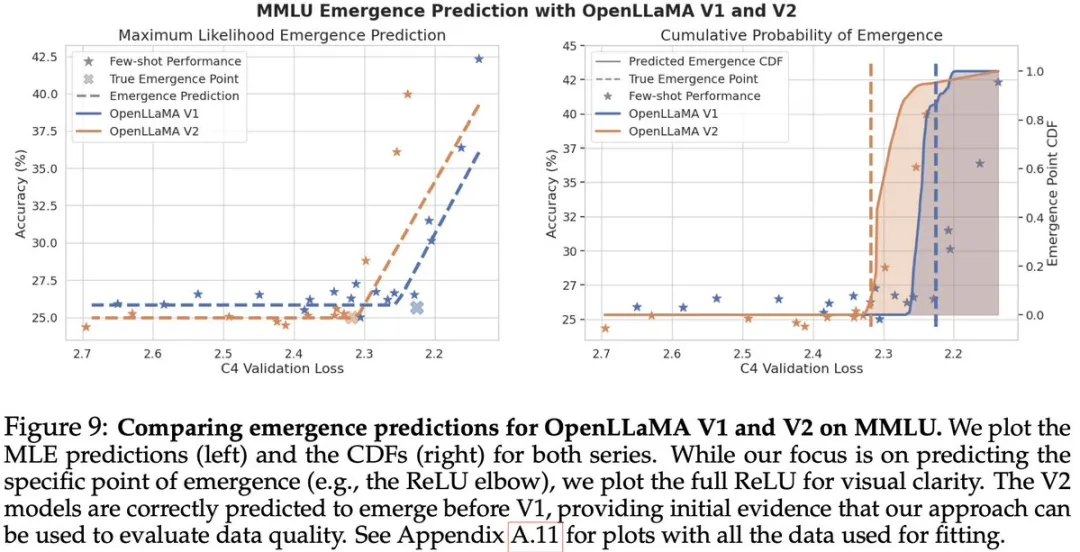

最后,该研究提出了两个实际的涌现案例研究,表明该研究提出的涌现定律可用于预测更复杂的能力。

思维链提出者 Jason Wei 称赞:「这是一篇非常聪明的论文,可以预测预训练模型的下游性能,非常有价值。因为可以使用它来预测和证明对下一个大模型训练运行的资本投资的合理性。」

作者首先提出了涌现预测,并将涌现预测定义为仅使用涌现前的模型检查点,来识别发生涌现的扩展点的问题。

简单理解就是,对于给定的 LLM,其在特定任务上具有随机少样本准确率,我们能否预测这个 LLM 在哪个扩展点(例如,预训练损失)上性能将超越随机表现?

带着这一疑问,作者发现了这样一个见解:在给定的任务上微调 LLM, 可以将涌现发生的临界点向着能力较低的模型移动 ,这意味着,通过微调,模型在涌现能力出现的时间点可以提前,这对于理解模型扩展和能力跃升的过程非常重要。微调所使用的数据量,会调节这种临界点移动的幅度。

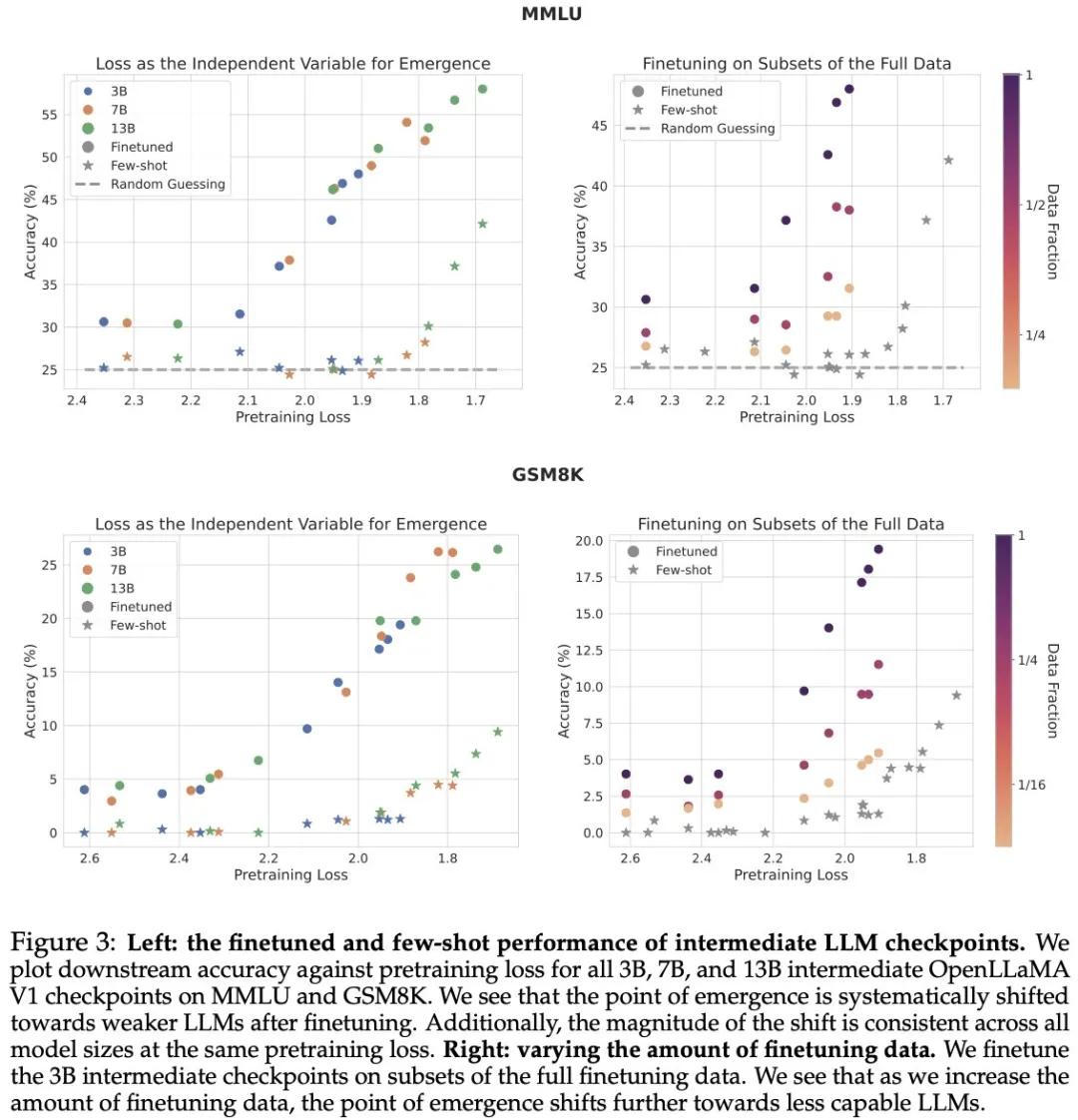

图 3(左)绘制了每个模型在 GSM8K 和 MMLU 上的少样本和微调性能与预训练损失的关系。可以看到,微调后的模型遵循与少样本设置类似的 ReLU 形状。此外,在相同的预训练损失下,所有模型大小的转变都是一致的,这表明预训练损失可以作为少样本和微调设置中有效的独立变量。

作者还发现出现涌现偏移受微调数据量的影响。图 3(右)绘制了 3B 模型检查点在完整数据子集上进行微调后的性能。在 MMLU 和 GSM8K 上,随着微调数据量的增加,涌现点进一步向能力较弱的 LLM 偏移。因此,微调数据量可以调节涌现偏移。

为了将这一洞察付诸实践,作者针对不同数量的数据对 LLM 进行了微调,并拟合了一个参数函数(即涌现定律),该函数模拟了涌现点如何随数据量的变化而变化。

然后,根据这一发现可以推断出在少样本设置中关于涌现的预测。

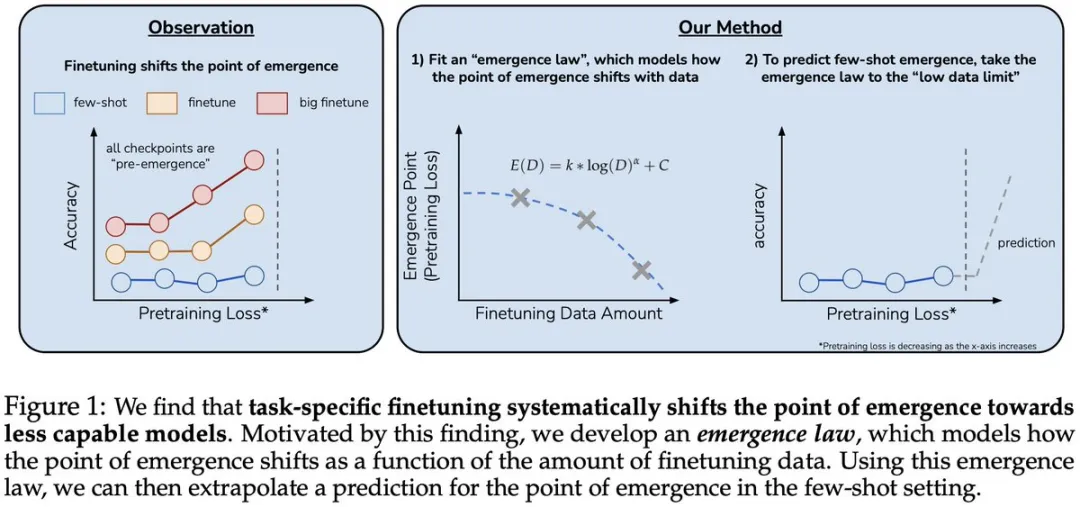

作者利用四个标准 NLP 基准来验证涌现定律,结果发现涌现定律可以提前准确预测涌现点,最多可提前 4 倍 FLOP。

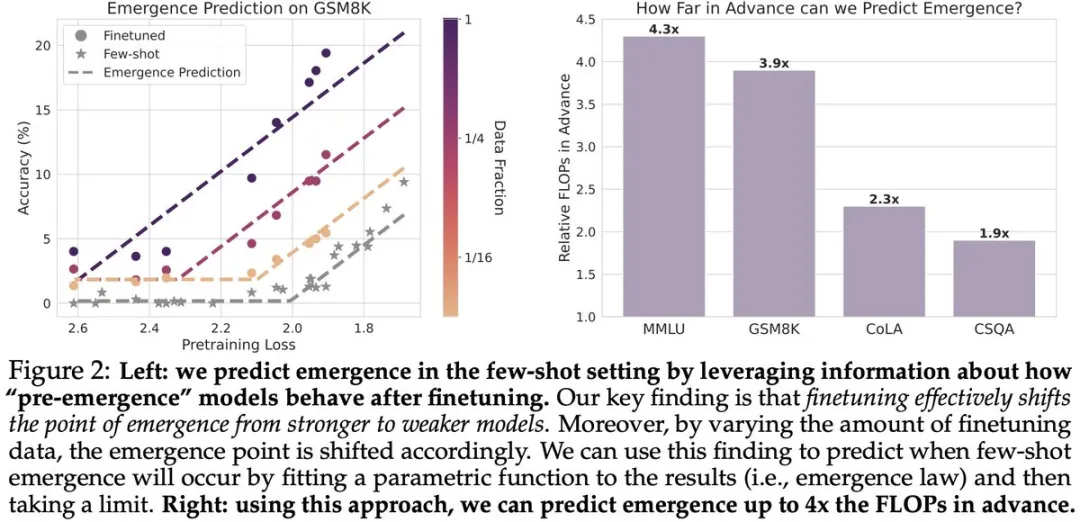

接下来作者进行了这样一个实验,就预训练 FLOPS 而言,可以提前多久成功做出预测。结果发现,可以提前预测涌现的程度在某种程度上取决于任务。

在 MMLU 和 GSM8K 上,可以分别提前最多 4.3 倍和 3.9 倍的 FLOPS 涌现出现。然而,在 CommonsenseQA 和 CoLA 上,分别只能提前预测 1.9 倍和 2.3 倍。

最后,作者还进行了真实世界的案例研究:1)低成本评估预训练数据质量(左)。2)使用困难 APPS 编码基准预测更复杂的能力,更接近未来前沿模型的能力(右)。

感兴趣的读者可以阅读论文原文,了解更多研究内容。

文章来自于微信公众号 “机器之心”