在AI迅速发展的技术背景下,如何更高效地利用模型资源成为了一个关键问题。批处理提示(Batch Prompting)作为一种同时处理多个相似查询的技术,虽然在提高计算效率方面显示出巨大潜力,但同时也面临着性能下降的挑战。香港理工大学的研究团队提出的Auto-Demo提示技术,为这一问题带来了突破性的解决方案。

图片由修猫创作

传统的批处理提示技术在处理大量输入时面临着两个主要问题:

这些问题的根源在于Transformer架构的自注意力机制,其计算复杂度随输入长度呈二次方增长。现有的解决方案主要集中在批数据排列和多数投票等外部优化方面,而没有从提示设计本身入手。

研究团队发现了一个有趣的现象:虽然少样本提示(Few-shot Prompting)通常能提升模型性能,但批处理提示却常常导致性能下降。这个矛盾启发研究者思考:是否可能将这两种技术的优势结合起来?

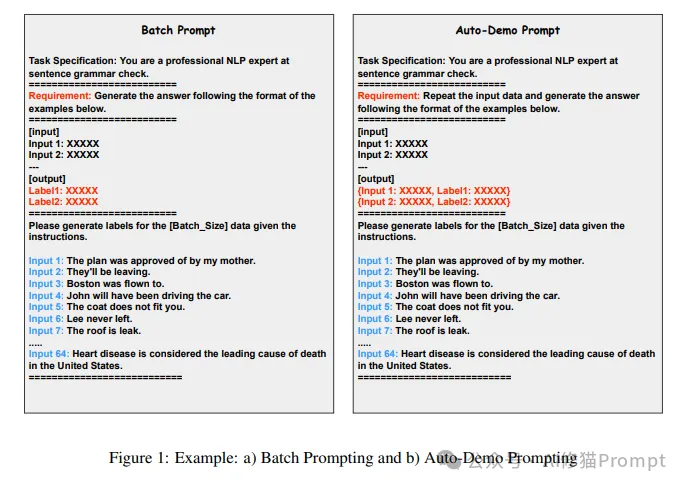

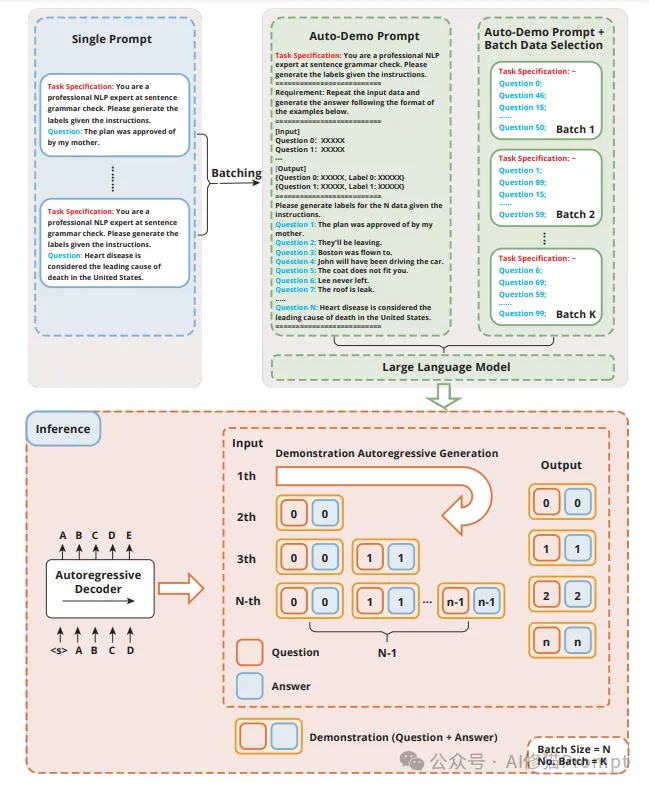

Auto-Demo提示技术的核心创新在于:利用模型在自回归生成过程中早期问题的输出作为后续问题的示例。这种方法不需要显式地在提示中加入示例,而是通过特殊的提示设计,让模型自动将之前的问答对作为后续推理的参考。

1.提示结构重设计

2.自动演示机制

研究团队提供了详细的理论分析,说明了Auto-Demo提示如何在LLM的自回归生成过程中发挥作用:

研究团队提供了三种提示方法的形式化表达,帮助我们更好地理解Auto-Demo提示的工作原理:

1.少样本提示(Few-Shot Prompting)

F(an|Q1:n−1, {(qi, ai)}n−1i=1) ∀n ∈ {0, 1, . . . , N}

示例流程:

2.批处理提示(Batch Prompting)

F(an|BP + Q1:n, {ai}n−1i=1) ∀n ∈ {0, 1, . . . , N}

示例流程:

3.Auto-Demo提示

F((qn, an)|ADP + Q1:n−1, {(qi, ai)}n−1i=1) ∀n ∈ {0, 1, . . . , N}

示例流程:

这种形式化表达揭示了一个重要关系:

Auto-Demo提示 ≈ 批处理提示 + 少样本演示

研究团队开发了"基于检索的批量数据选择"算法,其具体实现如下:

算法:基于检索的批量数据选择

输入:批量大小 N,数据集 D = {d1, d2, ..., d|D|},批处理数据 BD = {}

输出:BD

for di ∈ D do

temp_batch = {di}

for dj ∈ D where dj ≠ di do

使用嵌入模型计算di和dj之间的相似度

if dj 是最相似的(N-1)个数据点之一 then

temp_batch.add(dj)

end if

end for

BD.add(temp_batch)

end for

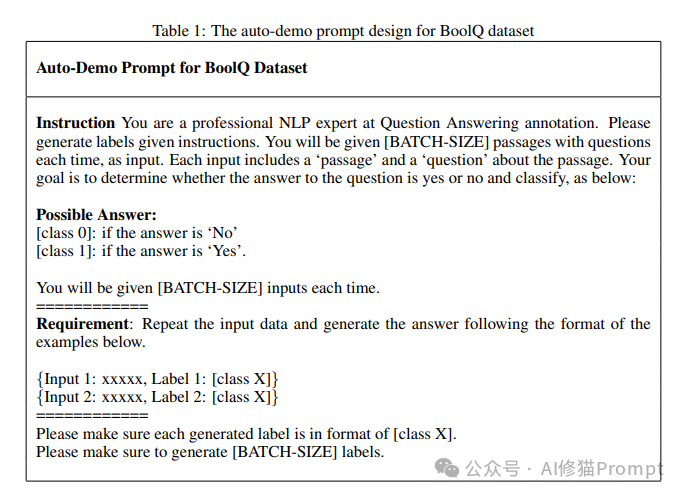

研究团队使用主流模型GPT-4o和GPT-4o-mini进行了广泛的实验,涵盖多个下游任务:

1.实验环境

2.评估指标

1.GSM8K数据集上的突破性表现

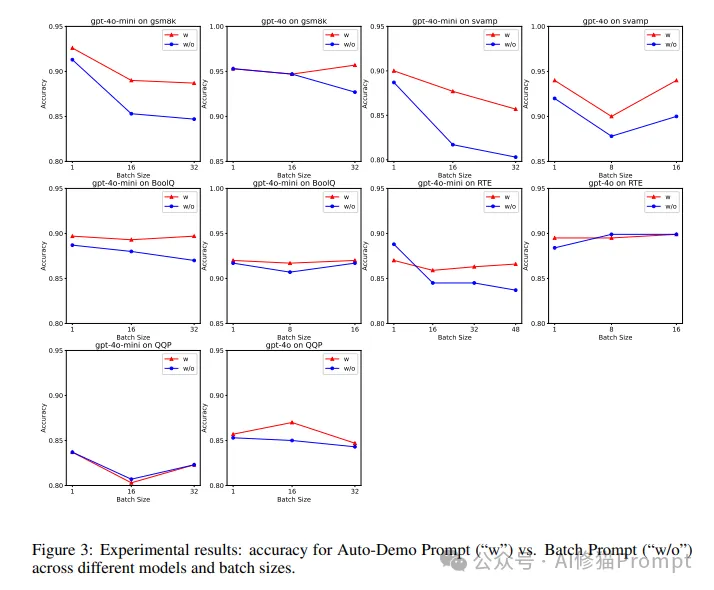

2.不同批量大小的性能比较

3.复杂推理任务的优势

4.批量数据选择的影响

1.性能稳定性

2.任务特性影响

3.模型规模影响

1.高效批量处理需求

2.长上下文处理

1.批量数据选择

2.提示设计优化

1.模型能力提升

2.应用场景拓展

1.理论深化

2.技术融合

Auto-Demo提示技术代表了批处理提示领域的重要突破,它巧妙地将少样本学习的优势引入批处理过程,在保持效率的同时显著提升了性能。这项创新不仅解决了长期困扰批处理提示的性能下降问题,随着大型语言模型(LLMs)的输入和输出长度增加和扩展,像自动演示提示结合批量数据选择这样高效且高性能的批量提示方法的重要性将变得越来越明显。

对于正在开发AI产品的Prompt工程师来说,这项技术提供了一个强大的工具,能够帮助他们更好地处理大规模查询场景,优化资源使用,提升用户体验。随着大语言模型技术的不断发展,Auto-Demo提示技术的应用价值将会进一步显现,为AI应用的发展提供更多可能。关于本文欢迎和我交流,以下是之前文章的资料赠予介绍。

文章来自微信公众号“AI修猫Prompt”,作者“ AI修猫Prompt”

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0