本文属于“亲爱的数据”美国硅谷访客系列,

本文观点向某国产AI芯片初创公司产品总监Winnie致谢,

向各位硅谷受访者致谢,

并向华为中央软件院匿名专家致谢。

天下熙攘,皆为利来。

从AI芯片到AI用户这个端到端的产业链中,

贡献价值最高的“那个人”拿走最大的利润。

“那个人”目前是英伟达,

对产业链价值的贡献最大。

很遗憾,暂时,国内大模型公司在产业链里的利润贡献还没有超过英伟达。

以前,做英特尔的产业链,

大家钱分得很清楚,

从头到尾挣100块钱的话,

英特尔拿70,剩下的人分30块钱。

做服务器的人可能就分5块钱,

做软件的人可能分20块。

比例并不精确,仅用于描绘大致的利润分配逻辑。

这种局面维持了多年。

直到AI大模型来了,

于是,从台积电等代工厂(芯片制造),

到英伟达(芯片设计),

再到AI开发框架(用API训练模型)

到云计算(采购GPU提供算力服务),

再到GPU算力租赁商,

再到推理优化服务商,部署服务商,

到OpenAI做成chatGPT把它卖出去为止,

再往细看,AI大模型,

基础模型是一层,

各种Agent是一层,APP是一层,

而APP这一层现在还没有出现超级产品。

这是一整个产业链。

有一天,如果情况有变,

用OpenAI的这个模型,

或者国内用各个品牌的国产大模型,

就比用其他的开源模型(Llama)多赚了5块钱。

产业链参与者就会说,

我吃的是OpenAI(模型公司)的钱。

我跑Llama挣2块钱,

我跑你挣2.1块钱,哪怕多一毛钱。

那你我的挣的钱肯定不是闭源模型的钱,

这个价值是Llama创造的。

至少,AI芯片上跑的闭源模型,

和开源模型的效果拉开差距,

现在很多国内创业公司的模型效果差强人意,

广告效果远高实际模型效果。

产业链参与者想好好吃模型创造的利润,

仍需等待。

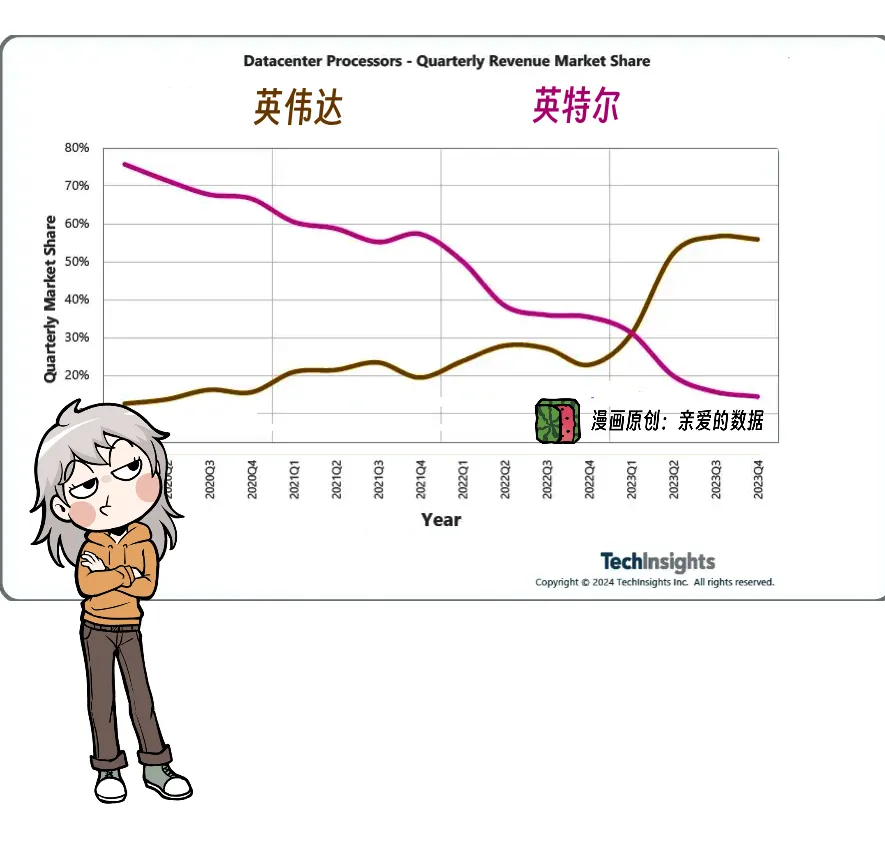

英伟达快速崛起与英特尔市场份额持续下滑。

以前软硬件层垒起来,是个倒金字塔形,

硬件的人赚小钱,软件的人赚了大头,

应用层在顶上,也赚得最多。

超级APP价值创造得很好。

也获得了应有的市值和利润。

现在是英伟达赚得最多,

软硬件层垒起来是个正金字塔,

底座大,塔尖小。

产业链上所有分利润的参与者,

赚的钱来自英伟达的利润,

而不是模型公司创造的利润。

凡事当有其节奏,不可操之过急。

有朝一日,正金字塔会变成倒金字塔,

总有一天,模型公司对产业链价值的贡献最大,

取代英伟达。

目前,大多数产业链的参与者,

主要赚的是那些“炼大模型”的公司的钱,

包括服务费用”或“支持费用”,

少量“用大模型产品”公司的钱

也就是,产业链上赚的是“支持模型跑起来的钱”,

而非模型本身的钱。

部分玩家赚到“私有模型私有部署”的费用,

这既包括模型创造的直接价值,

也包括产业链服务的价值。

但核心驱动力仍然来自模型本身的能力。

未来,如果模型产品和生态成熟,

其他支持成本(部署,算力优化服务)可能下降,

模型的直接产生的价值就会变大。

有朝一日,大模型成为成熟商品,

产业链参与者赚的就是模型本身的钱。

AI 模型的架构创新正在逐渐收敛,

在模型创造价值超过英伟达之前,

现阶段,产业链玩家直接参与模型本身的经济效益分成的情况比较少。

而“垂直整合”的情况很多,

产业界开始从“深度协同优化”中寻找新的增长点,

而不是单纯依赖模型设计上的突破。

而是垂直整合的优势,

这里的垂直是指什么呢?

就是AI芯片往上的所有软件层,

当然要把芯片本身算上。

“垂直整合”这个说法有点装,

换个接地气的,

就是不同软件层硬件层“联手”,

这是一种组合拳,

组合对象不同,玩法不同,

这篇聊的是:

“如何联手”“跨层握手”。

这种合作是由技术需求、经济利益和竞争格局共同驱动的结果。

原因无外乎:

一硬件厂商寻求出路,

当前 AI 市场被英伟达牢牢掌控,

非英伟达们需要通过与软件层合作形成竞争优势,

否则很难打破 垄断格局。

二软件厂商向下延伸,

靠优化GPU,其模型性能已接近天花板,

因此逐渐向硬件领域延伸。

本质上,单点突破不够,

是局部优化,还是全局优化。

我们聊下,正在发生的垂直整合的方式:

方式一,云厂商:自研AI芯片+云服务

云厂商本身也是英伟达的大客户,

尤其超大规模云计算公司,

软硬件层也占了好几层,

这种玩法,可以将自研芯片与自有的云计算基础设施整合,

云厂商减少了对外部芯片供应商的依赖,

能够在产业链中获取更高的利润份额。

比如,亚马逊云科技,

AI训练芯片Trainium3。

国内云厂商也有“动态”,但不能写,懂得都懂。

按照硅谷芯片研发小哥哥Ryan对我说的就是:

“硅谷哪个大厂谁家要自研芯片,是没有秘密的。”

方式二:“硬件层+整机系统层”联手。

比如,苹果公司正与博通合作开发AI服务器芯片。

博通是芯片设计和制造公司,专注于硬件底层,

尤其是通信芯片和特定用途的ASIC(专用芯片)。

在这个合作中,博通提供了底层的硬件支持,

比如 AI 服务器所需的:

高效通信芯片、网络互连芯片,

以及定制的计算芯片。

苹果作为整机系统层的主导者,

负责从用户体验到全栈优化的一整套设计,

包括硬件、系统软件和应用生态。

在这个合作中,

苹果以其对 AI 算法和硬件需求的深刻理解,

指导博通开发出更契合其生态的芯片产品。

“硬件为软件服务,软件指导硬件开发”,

这是典型的深度协同模式。

方式三:AI芯片+AI框架

这也是自己整合自己的又一种玩法,

专用框架可充分挖掘芯片潜力,

避免因兼容性问题而牺牲性能。

同时,对抗主流AI框架Pytorch。

比如,谷歌TPU+JAX,

华为芯片+MindSpore,

苹果芯片+MLX框架。

通过优化“芯片-框架-模型”这一链条,

厂商可以在性能上超越仅依赖通用框架的对手。

不是所有的开源框架使命都是一样的,

像 PyTorch 这样的开源框架,

主要使命是争夺行业实施标准。

在兼容性、生态、开发友好几个方面吸引人气,

最终形成行业事实上的软件标准。

而谷歌的 JAX或华为的MindSpore,

这些框架的首要任务是,

充分释放其自家硬件的潜力。

这类框架的核心价值在于,

通过深度结合硬件达到性能最优,

而不是单纯以通用性或生态广度为目标。

AI框架和AI芯片做垂直整合,

是有机会做出性能优势的。

这种“组合拳”的核心在于,

每一层都在为整体性能服务,

而不是单纯追求某一层的领先。

但当硬件厂商通过垂直整合建立起闭环后,

通用框架的角色可能被削弱。

越是模型结构收敛,

这种厂商越是有机会。

方式四,AI芯片+推理云

美国不少AI芯片初创公司在搞推理云,

也就是,硬件厂商向软件领域扩展,

外在表现是从卖硬件到卖服务。

例如,SambaNova、Groq、Cerebras,

三家领先的AI芯片初创公司,

都有推理软件服务:推理云。

一种AI芯片初创公司的玩法是,

专注AI大模型快速推理,

拿出数倍于英伟达GPU的推理性能,

训练市场太难了,那就先抢推理市场的蛋糕。

这是一个清晰的整合逻辑,

芯片公司有的是芯片,

发愁的是客户怎么用起来。

芯片和“推理云”整合,

不再依赖云厂商作为中间环节的商业模式。

将芯片推理性能优势直接提供成服务。

推理云不仅是计算能力的输出,

也可以将硬件复杂性隐藏在软件后,

芯片是一次性购买的产品,市场容量有限。

即便推理性能比英伟达优秀,

也很难短期内取代CUDA的生态优势。

搞推理云,可以绕过“芯片怎么用起来,还得用得好”这个问题,

直接吸引客户。

芯片公司本身投入巨大,

这种模式还能在过程中实现“资金回流”。

实际上,这种模式甚至可以整合三层:

模型+芯片+推理服务。

可以研究适合芯片架构的模型结构,

将性能推上一个极致。

通过控制推理云,

芯片公司在软件层面获得了一定的主动权,

而不再单纯依赖硬件性能来竞争。

方式五,AI芯片+多金特色场景客户

部分AI芯片初创公司青睐于特定架构的专用硬件。

超级企业级大客户也是AI芯片初创公司的理想合作伙伴。

能源医疗生物金融这种多金好客户,

都是为特定应用场景定制优化芯片的好目标。

方式六,最后说的才最重要的。

谁不想抱大腿,

人人都想和超级APP垂直整合。

超级APP在英特尔主导产业链那轮就是金字塔的顶端。

现有超级APP有资格有任何软件层硬件层握手,

最想抢先合作的就是AI初创芯片公司。

最想和超级APP一起搞个大的。

站在超级APP厂商的立场,

非英伟达AI芯片比英伟达做的性价比高一倍。

你问他用不用?他马上就用。

尽管软件生态上的缺陷让硬件用起来很难,

至少得多花几个月基础软件,算子优化投入。

再加上买新芯片的投入,

都是一种很激进的做法。

新芯片难用没生态,

模型开发和部署里的天坑,

那就只能硬堆基础软件的高手的“人天”解决。

这也是我们看到科大讯飞,

中国移动用华为的软件的时候,

华为派出很多工程师现场支援。

这个人力成本也不低。

如果帐算的过来,

AI芯片上省出的大钱确实是赚的,

但风险也挺大的。

英伟达是贵,但是稳。

而且大厂的人待久了,

很难咬牙搞这么大的创新。

万一性能不稳定,性价比做不高呢?

万一芯片公司掉链子呢?

超级APP厂商对非英伟达芯片的选择,

取决于性能+稳定性+成本的综合评估,

而风险则集中在这些变量的不确定性上。

挑战者要在短时间内撼动英伟达的地位非常困难。

搞定超级APP这种重点客户模式是可行的路,

就看人家愿不愿意冒险。

说到底,玩家们搞垂直整合的驱动力还是挺大的:

技术需求、经济利益和竞争格局。

文章来自微信公众号 “亲爱的数据”,作者“亲爱的数据”

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md