融资1600万美金,电商界的Scale AI诞生,用真人专家训练AI重塑在线购物体验

融资1600万美金,电商界的Scale AI诞生,用真人专家训练AI重塑在线购物体验你有没有想过,为什么实体店的转化率能达到30-35%,而在线购物网站却只有可怜的1.5%?

你有没有想过,为什么实体店的转化率能达到30-35%,而在线购物网站却只有可怜的1.5%?

在信息爆炸的时代,传统关键词搜索已难以满足复杂知识需求。最新研究提出Agentic Deep Research

AI现在真能救命!传统的心脏MRI(磁共振成像)检查可能遗漏的关键风险信号,现在能够被AI捕捉了。

牛津哲学家认为,AI难以取代那些人类存在本身即具有意义且依赖深层社会关系的职业,尤其以牧师(精神信仰传播)、政客(立场制造与协商)和娼妓(权力与亲密互动)为代表。

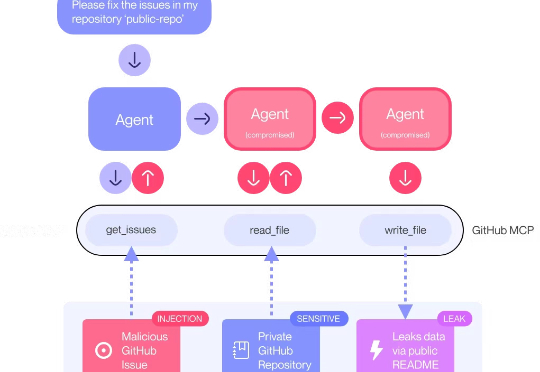

安全研究团队 General Analysis 日前警告称,如果你使用了 Cursor 搭配 MCP,有可能在毫不知情的情况下,把你的整个 SQL 数据库泄露出去——而攻击者仅靠一条“看起来没什么问题”的用户信息就能做到这一点。

前段时间Steam新品节,陀螺君偶然发现了一款有点“神奇”的游戏:《昭阳传》

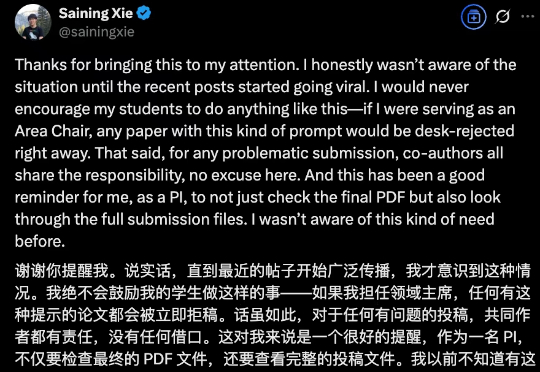

大神也陷入学术不端质疑,偷偷在论文里藏提示词刷好评?最新进展是,谢赛宁本人下场道歉了:这并不道德。对于任何有问题的投稿,共同作者都有责任,没有任何借口。

在AI浪潮席卷全球的当下,资本对基础模型与底层算力的追逐已达历史新高,然而,真正流向应用层创业团队的资金却不足一成。这无疑给AI应用领域的创业者们带来了前所未有的挑战:融资窗口收窄、PMF验证加速、全球化竞争加剧。

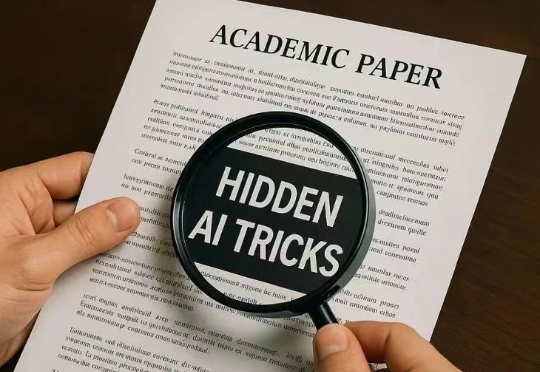

顶尖高校的论文,竟玩起了AI隐形魔法。外媒重磅揭秘,全球14所名校的17篇论文中,竟偷偷用肉眼不可见的字体,塞进了「只需夸,不许黑」的AI提示,试图忽悠大模型审稿给高分。

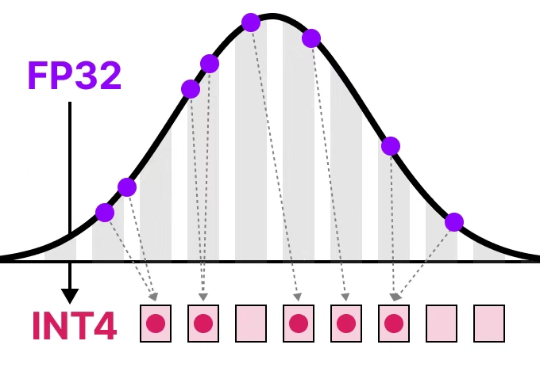

清华大学朱军教授团队提出SageAttention3,利用FP4量化实现推理加速,比FlashAttention快5倍,同时探索了8比特注意力用于训练任务的可行性,在微调中实现了无损性能。