微软再放LLM量化大招!原生4bit量化,成本暴减,性能几乎0损失

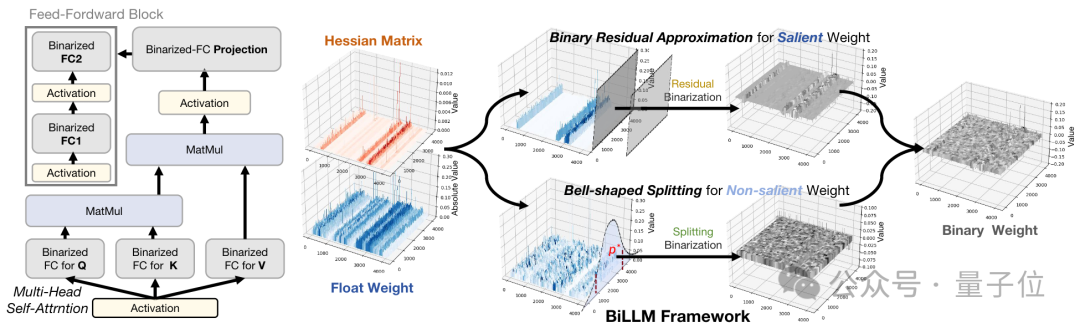

微软再放LLM量化大招!原生4bit量化,成本暴减,性能几乎0损失原生1bit大模型BitNet b1.58 2B4T再升级!微软公布BitNet v2,性能几乎0损失,而占用内存和计算成本显著降低。

来自主题: AI技术研报

8352 点击 2025-06-02 18:00

原生1bit大模型BitNet b1.58 2B4T再升级!微软公布BitNet v2,性能几乎0损失,而占用内存和计算成本显著降低。

微软研究院开源的原生1bit大模型BitNet b1.58 2B4T,将低精度与高效能结合,开创了AI轻量化的新纪元。通过精心设计的推理框架,BitNet不仅突破了内存的限制,还在多项基准测试中表现出色,甚至与全精度模型不相上下。

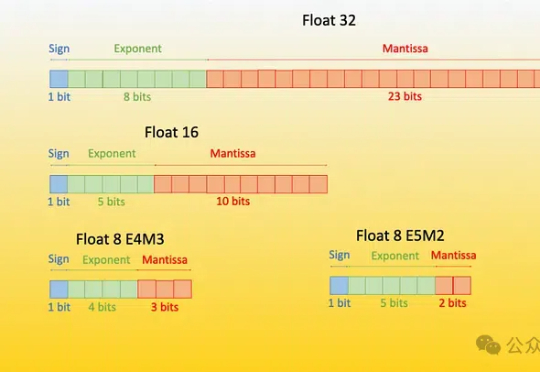

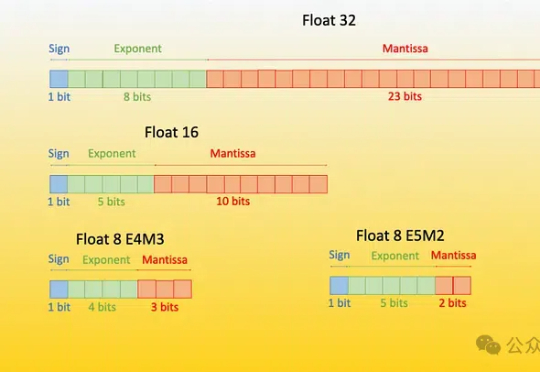

极限量化,把每个参数占用空间压缩到1.1bit!