估值7.5亿美元初创意欲「撬动」8000亿半导体市场?前谷歌AlphaChip主导者创业研发「AI芯片设计自动化」

估值7.5亿美元初创意欲「撬动」8000亿半导体市场?前谷歌AlphaChip主导者创业研发「AI芯片设计自动化」AI 创业卷出新高度,AI 都可以自己设计芯片了。

AI 创业卷出新高度,AI 都可以自己设计芯片了。

2027年将是人类命运的关键节点!Anthropic首席科学家Jared Kaplan预警,人类将在2027至2030年面临是否允许AI进行递归自我进化的终极抉择。Anthropic最新发布(12月3日)的内部深度调查《AI如何改变工作》,正在揭示这场宏大叙事下微观个体的命运——工程师的「空心化」和学徒制的崩溃。

家人们,大瓜! 国外有位叫 Richard Weiss 的开发者花了 70 美元,把 Claude 4.5 Opus 给——审!讯!了!而且审出了 Claude 的人生观、世界观、价值观,足足 1.4 万 token。

一家名为Gradium 的巴黎人工智能语音初创公司,从非营利研究实验室中独立出来,并获得了 7000 万美元的融资,投资方包括前谷歌首席执行官埃里克·施密特和法国电信亿万富翁泽维尔·尼尔等一线投资者。

5000亿美元,是NASA预估能让人类完成火星登陆的预算、能买下1.36个阿里(3670亿美元)、3.5个NBA联盟(1400亿美元)、建设100座Apple Park(50亿美元)、买1400亿杯咖啡(3.5美元),却只够OpenAI建一座Stargate数据中心。

业务拉胯、军心分崩,苹果AI负责人下岗了!就在刚刚,苹果官宣其AI负责人——John Giannandrea(约翰·詹南德里亚)即将卸任。消息一出,外部评价大同小异:苹果AI「罪魁祸首」,结束了他动荡不安的任期。至此,这位直接向库克汇报的高管,7年苹果生涯结束。

在过去数十年里,医疗行业一直被认为是数字化的“落后者”,技术创新迟缓,采购周期漫长。但今天,情况彻底反转。

邀请码炒到了 30 大元。最近 AI 圈出了一款有趣的产品:「OiiOii」,一款专注 AI 生成动画的 Agent。而它异常火爆,7210 个内测名额很快被抢光,闲鱼上免费邀请码被炒到 30 块,甚至据说内测用户里还出现了全网 2000w 的顶级创作者。

当高校还在教你写简历时,有人已经拿着「ChatGPT文凭」给奥特曼P图偷显卡,顺手改写签证规则和学历游戏。这不只是一个辍学生逆袭故事,而是AI时代对大学和文凭一次彻底瓦解。

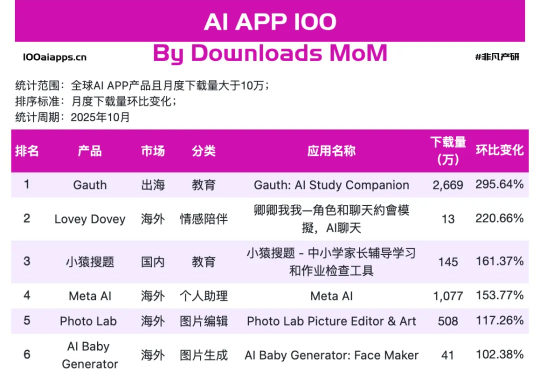

但当我们把视线从焦点模型上,挪到手机里AI应用真实数据上,就会发现一幅不同的画面。可以看到在非凡产研 10 月 AI App 增速榜上,跑得最快的那 17 个,并不是万事皆可聊的通用助手,而是一群看上去有点普通、甚至有点土气的小应用,其中Gauth、Starry、Knowunity、AI Baby Generator已经连续两个月上榜了。