苹果AI论文太坑了!用GPT写的GT,导致北京程序员通宵加班

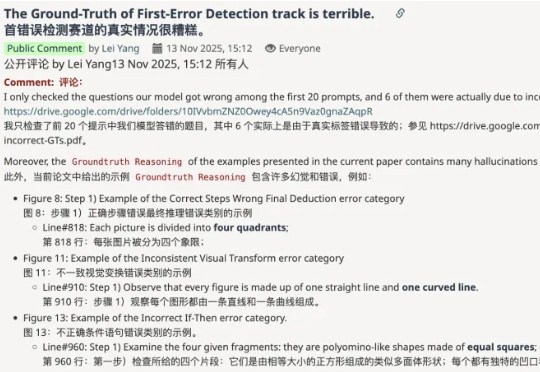

苹果AI论文太坑了!用GPT写的GT,导致北京程序员通宵加班大无语事件天天有,今天特别多——AI大模型公司阶跃星辰的研究员,自曝被苹果挂在arXiv上的论文,狠狠坑了一把。自己去反馈问题,对方简单回了两句就把issue关了;直到自己留下公开评论,对方才撤稿下架代码了。

大无语事件天天有,今天特别多——AI大模型公司阶跃星辰的研究员,自曝被苹果挂在arXiv上的论文,狠狠坑了一把。自己去反馈问题,对方简单回了两句就把issue关了;直到自己留下公开评论,对方才撤稿下架代码了。

新乐子来了。 10个AI大模型,券商账户实时交易,勇闯美股。 除了老面孔GPT、Claude、Gemini、Grok、Qwen、DeepSeek,这次四个国产新玩家,豆包、Minimax、Kimi、文心也加入战场。昨晚,首战正式开赛,豆包已经一马当先,开始了开门红。

是孩子该看的东西。

当AI模型排行榜开始被各种刷分作弊之后,谁家大模型最牛这个问题就变得非常主观,直到一家线上排行榜诞生,它叫:LMArena。在文字、视觉、搜索、文生图、文生视频等不同的AI大模型细分领域,LMArena上每天都有上千场的实时对战,由普通用户来匿名投票选出哪一方的回答更好。

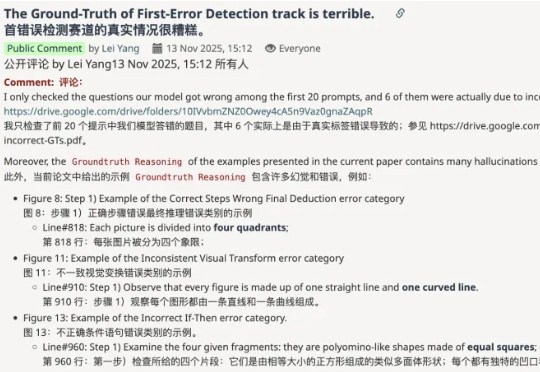

就在最新一期的SuperCLUE中文大模型通用基准测评中,各个AI大模型玩家的成绩新鲜出炉。DeepSeek-V3.1-Terminus-Thinking openPangu-Ultra-MoE-718B Qwen3-235B-A22B-Thinking-2507

近日,国内首次针对AI大模型的实网众测结果正式公布,一场大型“安全体检”透露出不容忽视的信号:本次活动累计发现安全漏洞281个,其中大模型特有漏洞高达177个,占比超过六成,这组数据表明,AI正面临着超出传统安全范畴的新型威胁。

成立107年的松下,如何赶上AI大模型的浪潮? 在日本东京接受媒体采访时,松下控股株式会社全球副总裁、集团中国东

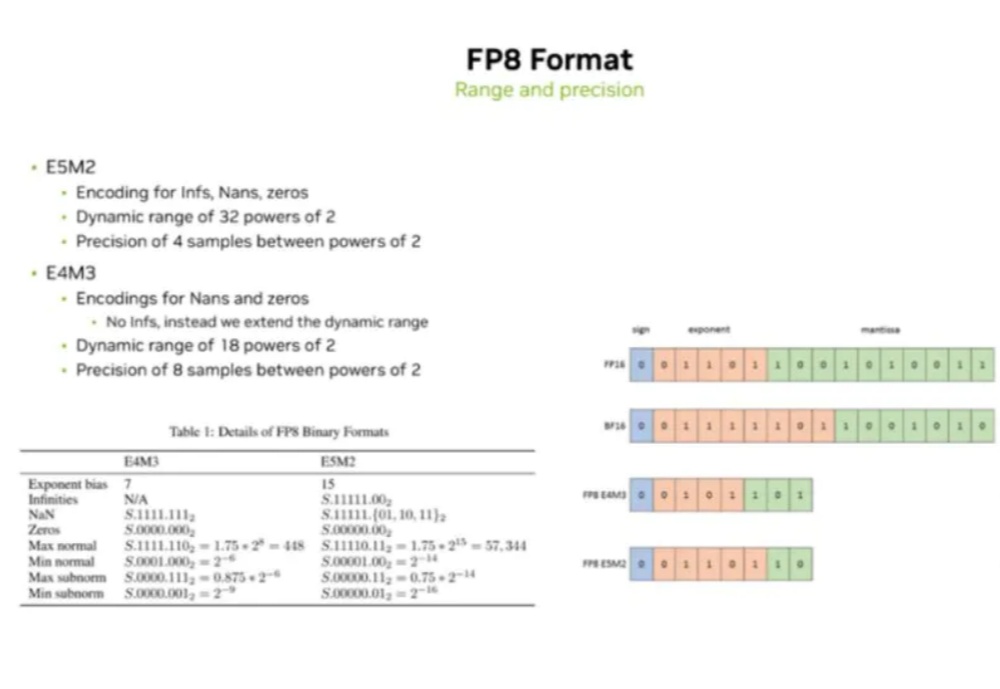

当前AI大模型(LLM)训练与推理对算力的巨大需求,以及传统计算精度(如FP16/BF16)面临的功耗、内存带宽和计算效率瓶颈。

记忆,你有我有,LLM 不一定有,但它们正在有。

微软紧跟OpenAI的节奏,在同一天也亲自下场发布了微软自研的两个大模型:语音模型MAI-Voice-1和通用模型MAI-1-preview。对于这位老大哥,亲自下场做的第一个AI大模型,效果究竟怎么样?