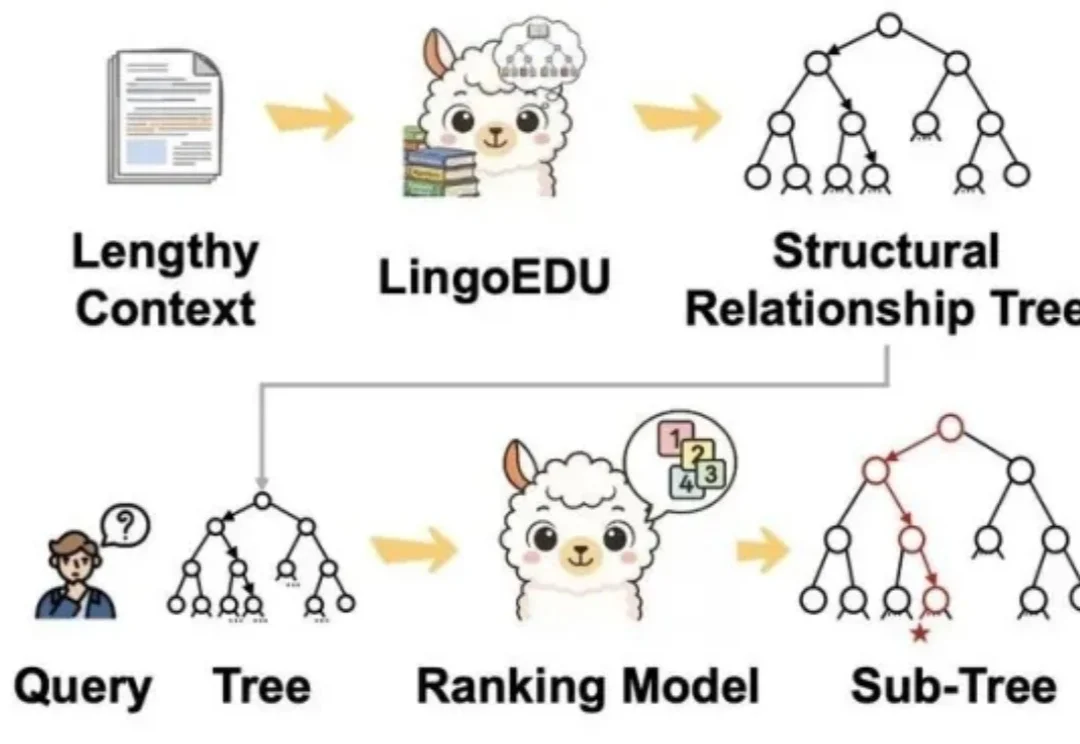

结构化预处理让DeepSeek准确率提升51%,现已开源丨清华&深言

结构化预处理让DeepSeek准确率提升51%,现已开源丨清华&深言零成本降低大模型幻觉新方法,让DeepSeek准确率提升51%!

零成本降低大模型幻觉新方法,让DeepSeek准确率提升51%!

香港中文大学提出了一个全新的算法框架RankSEG,用于提升语义分割任务的性能。传统方法在预测阶段使用threshold或argmax生成掩码,但这种方法并非最优。RankSEG无需重新训练模型,仅需在推理阶段增加三行代码,即可显著提高Dice或IoU等分割指标。

Notion 创始人 Ivan Zhao 在最新的博文中提到,我们正处于 AI 的「水车阶段」,还在试图把新时代的引擎,硬塞进旧时代的马车里。 原文🔗 https://www.notion.com/b

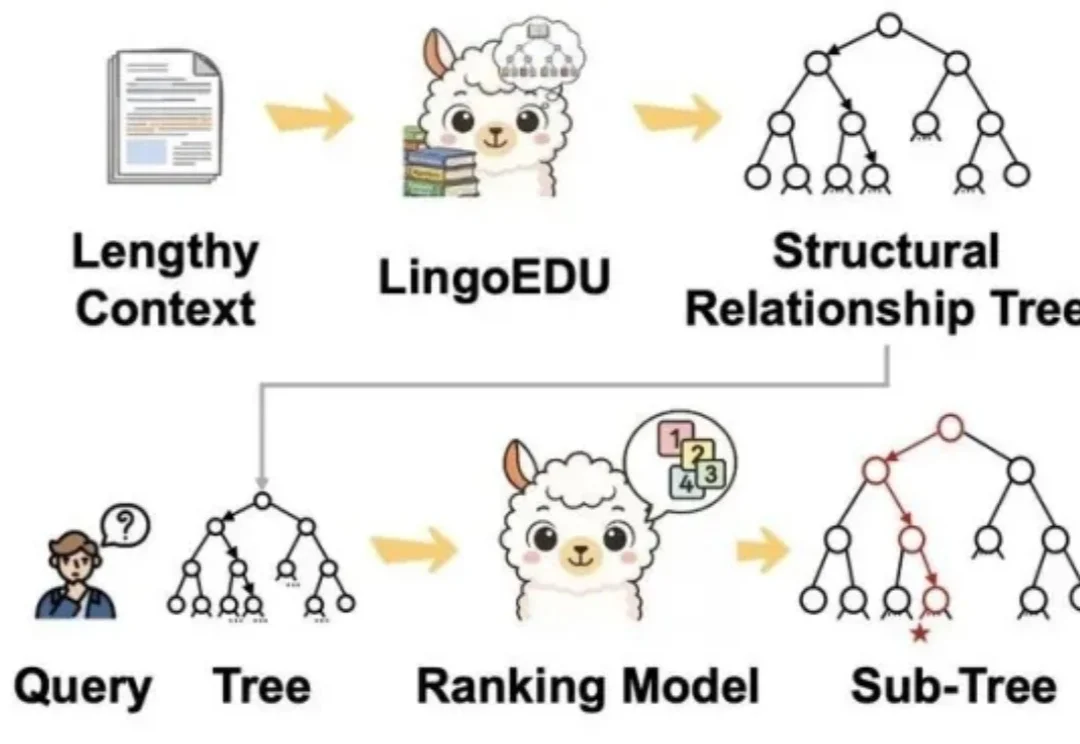

从“不用AI”到“离不开AI”,一家初创公司如何重塑专利律师的工作时钟?成立仅两年多,团队仅15人,零销售团队,却拿下了400多家顶级客户,今年ARR增长更是超过10倍,还完成了5500万美元融资——Solve Intelligence的故事,几乎违背了SaaS创业的常识。

为什么 AI 陪伴赛道,还没有跑出来一个千万级别 DAU 的产品?

十年前,三星工程师 June Paik 因跟腱断裂卧床,却意外在床上洞察到了 AI 浪潮。十年后,他创立的 FuriosaAI 拒绝了 Meta 的收购,带着名为「叛逆者(RNGD)」的芯片,誓要在英伟达主宰的算力帝国中撕开一道缺口。

最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。

刚刚,AI 前线获悉,前华为天才少年、原华为云具身智能核心负责人李元庆已正式加入乐享科技,后续将重点负责乐享科技的创新业务战略规划与核心技术攻关。

24条AI幽灵文献,坑惨港大某副院长。

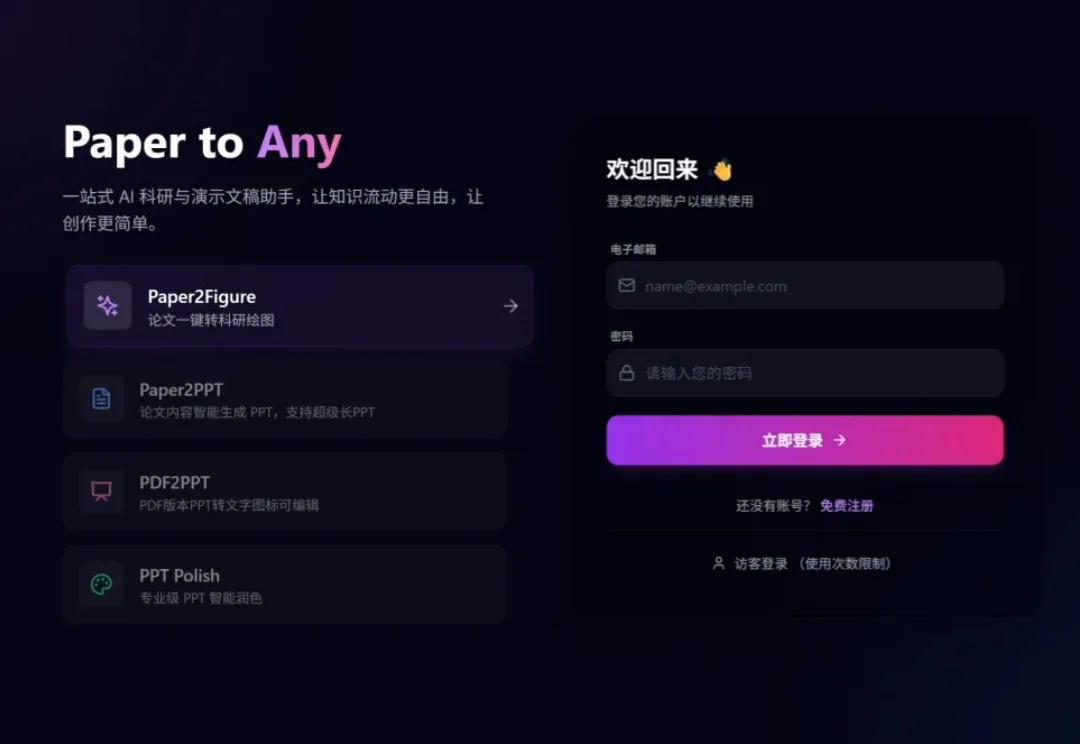

你是否经历过这样的至暗时刻: 明明实验数据已经跑通,核心逻辑也已梳理完毕,却在面对空白的 PPT 页面时陷入停滞; 明明脑海里有清晰的系统架构,却要在 Visio 或 Illustrator 里跟一根歪歪扭扭的线条较劲半小时; 好不容易用 AI 生成了一张精美的流程图,却发现上面的文字是乱码,或者为了改一个配色不得不重新生成几十次……