最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。报告还提出改进方向和新评测范式的思考,强调生成式模型虽有潜力,但与专用模型仍有差距。

过去几年,文本生成图像(T2I)与多模态生成式模型的能力突飞猛进,已经能稳定地产生高质量、具备细节与语义一致性的图像内容。

报告关注的核心矛盾在于:这些「擅长生成」的模型,是否也能在传统低层视觉任务中充当通用求解器(generalist)?

低层视觉(low-level vision)通常强调对图像退化的「精确逆过程」:例如去雾、超分、去噪、去雨、去模糊、去反射、去光晕等。

这类任务的经典评价方式往往依赖 PSNR/SSIM 等参考指标,强调像素级一致性。但生成式模型天生带有「补全/重建」的倾向:它们可能会依据先验去「合理地编造」高频细节,从人眼观感看更清晰、更「像真的」,却在像素对齐意义上偏离GT。

华中科技大学的研究人员最近发布了一篇报告,把这种冲突概括为「人类感知偏好 vs. 传统指标导向」的张力。

项目主页:https://lowlevelbanana.github.io

论文链接:https://arxiv.org/abs/2512.15110

开源仓库:https://huggingface.co/datasets/jlongzuo/LowLevelEval

报告中提出一个非常直接的问题:Nano Banana Pro能否成为低层视觉全能选手?

报告采用了一个刻意「极简」的使用范式:不训练、不微调,只用「输入图 + 简单文本 prompt」直接让Nano Banana Pro输出结果,对其进行zero-shot基准评测。

研究人员把评测扩展到14个低层视觉任务、40个数据集,覆盖三大类能力:图像恢复(restoration)、图像增强(enhancement)、图像融合(fusion)。

任务清单包括:Dehazing、Super-Resolution、Deraining、Deshadowing、Motion Deblur、Defocus Deblur、Denoising、Reflection Removal、Flare Removal、Low-Light Enhancement、Underwater Enhancement、HDR Imaging、Multi-focus Fusion、Infrared-Visible Fusion;

图中用颜色区分了restoration / enhancement / fusion三类任务。

保守估测性能

报告特别强调:当前结论是对模型能力的保守估计,即研究人员没有做精细 prompt tuning,也没有用多轮推理去「挑选最好看的输出」,而是用固定、简单的提示词来模拟一种更接近「普通用户上手」的用法。

闭源模型的评测约束

在一些任务章节里,研究人员也说明了评测工程细节:由于模型以API方式调用且闭源,无法做任务定制训练;并且生成输出分辨率可能固定在约1024尺度,因此需要将输出resize回与GT一致的分辨率再计算指标,以保证定量比较尽量公平。

报告最重要的结论可以概括为一句话:

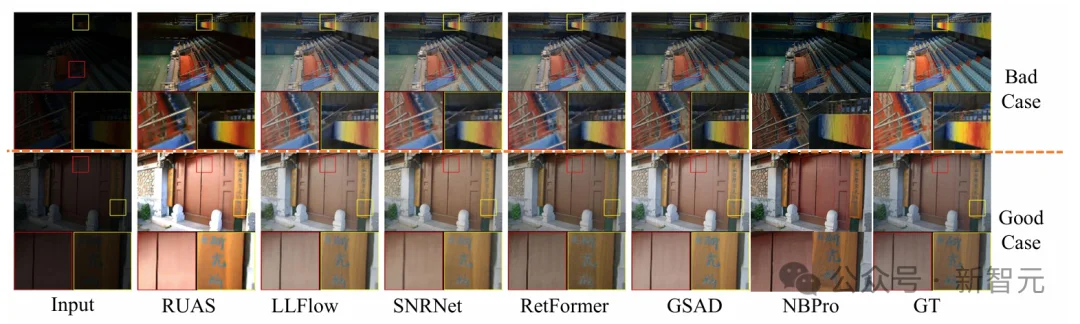

Nano Banana Pro在主观视觉质量上往往更讨好,但在PSNR/SSIM等传统参考指标上整体落后于专用模型。

研究人员将其归因于生成式模型的内在属性:生成式模型更倾向于追求「语义可信/感知合理」,而非严格的像素级对齐;同时模型输出带有随机性(stochasticity),使得稳定性与可复现性也成为部署障碍。

系统性现象:感知质量与指标不一致

以Flare Removal为例,研究人员观察到一种非常典型的现象:有些样本视觉上已经「挺干净、挺舒服」,但因为亮度/颜色等与GT存在偏差,量化分数依然不高,这反映了像素级指标对生成式增强的惩罚机制。

同时,研究人员也指出生成模型存在「高上限、低下限」的特征:在合适输入上,它可能在细节恢复上超过 SOTA,但这种优势会被扩散/生成模型的随机性与语义漂移所抵消,出现明显方差与语义幻觉,prompt 工程也只能部分缓解,难以保证工业级确定性。

稳健但不极致:生成式模型有时会选择更保守的输出

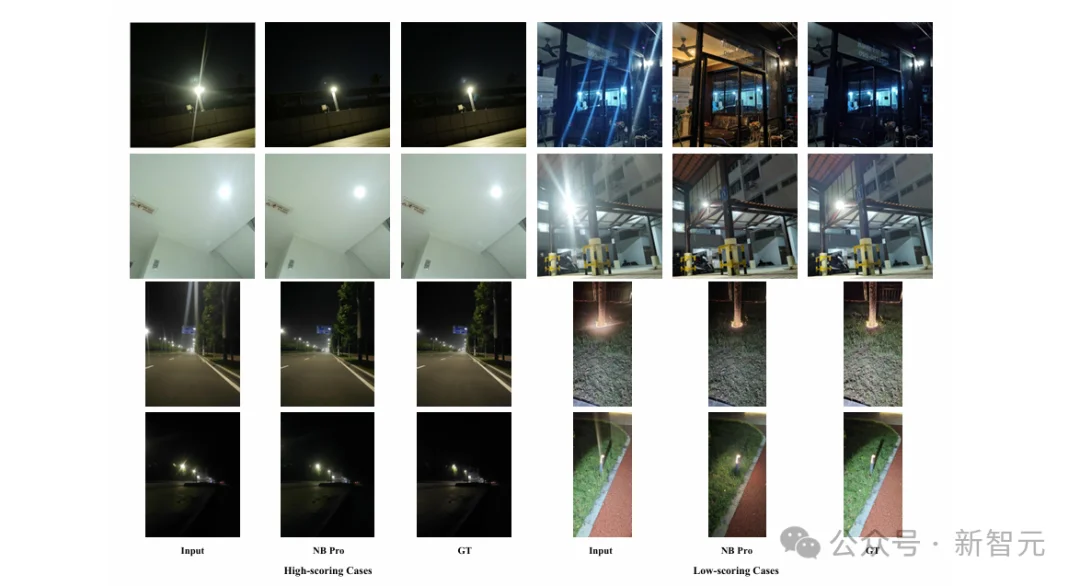

在低光增强(Low-Light Enhancement)的分析中,研究人员给出另一个视角:

Nano Banana Pro可能不太会引入显著的光晕、结构破坏、严重色偏等「灾难性伪影」,这使得它在某些实际应用中具备吸引力;

但它也会出现亮度控制不一致、对prompt敏感、以及与benchmark的GT定义不完全匹配等问题,因此整体仍难以与专用方法竞争。

更进一步,报告还给出可能的改进方向:更具体的prompt设计、few-shot示例对齐、轻量适配/微调、以及把统一多模态模型与任务模块结合的混合范式。

报告贡献与意义:它不只是在「打分」,而是在推动重新定义评测与目标

这份报告的价值不止在于给Nano Banana Pro下结论,更在于它把一个长期存在但常被忽略的问题摆到台面上:

报告明确指出:Nano Banana Pro作为零样本低层视觉求解器,已经是一个很强的 baseline,并展示出跨任务的「泛化潜力」;但要达到专用模型那种高保真、可控、稳定的水准仍有明显鸿沟。

参考资料:

https://arxiv.org/abs/2512.15110

文章来自于“新智元”,作者 “LRST”。

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0