全面实测 Bevel AI|融了1000万美元,DAU 超 10 万的 AI 原生健康产品,这才是 AI 时代“以人为本”的交互

全面实测 Bevel AI|融了1000万美元,DAU 超 10 万的 AI 原生健康产品,这才是 AI 时代“以人为本”的交互今天我们来聊聊:AI 原生健康产品的标杆 —— Bevel。跟大家聊个最近我特真实的体感。这几年我一直半强迫自己戴着 Apple Watch,手机里还装了常年霸榜的 AutoSleep。我相信你们很多人也买了,但说实话:真挺鸡肋的。

今天我们来聊聊:AI 原生健康产品的标杆 —— Bevel。跟大家聊个最近我特真实的体感。这几年我一直半强迫自己戴着 Apple Watch,手机里还装了常年霸榜的 AutoSleep。我相信你们很多人也买了,但说实话:真挺鸡肋的。

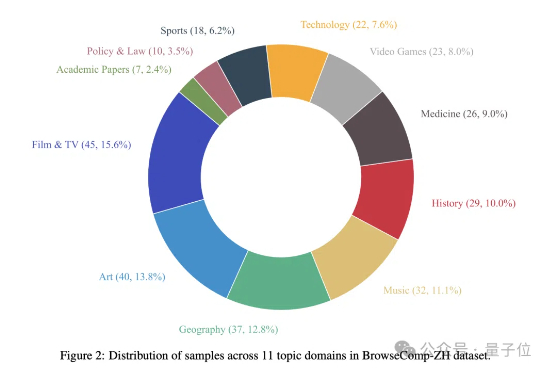

最近,一篇由中国团队领衔全球24所TOP高校机构发布,用于评测LLMs for Science能力高低的论文,在外网炸了!当晚,Keras (最高效易用的深度学习框架之一)缔造者François Chollet转发论文链接,并喊出:「我们迫切需要新思路来推动人工智能走向科学创新。」

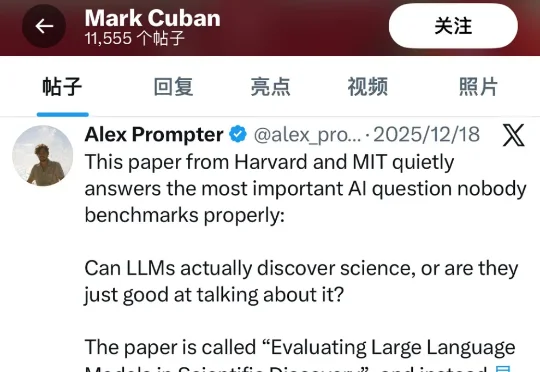

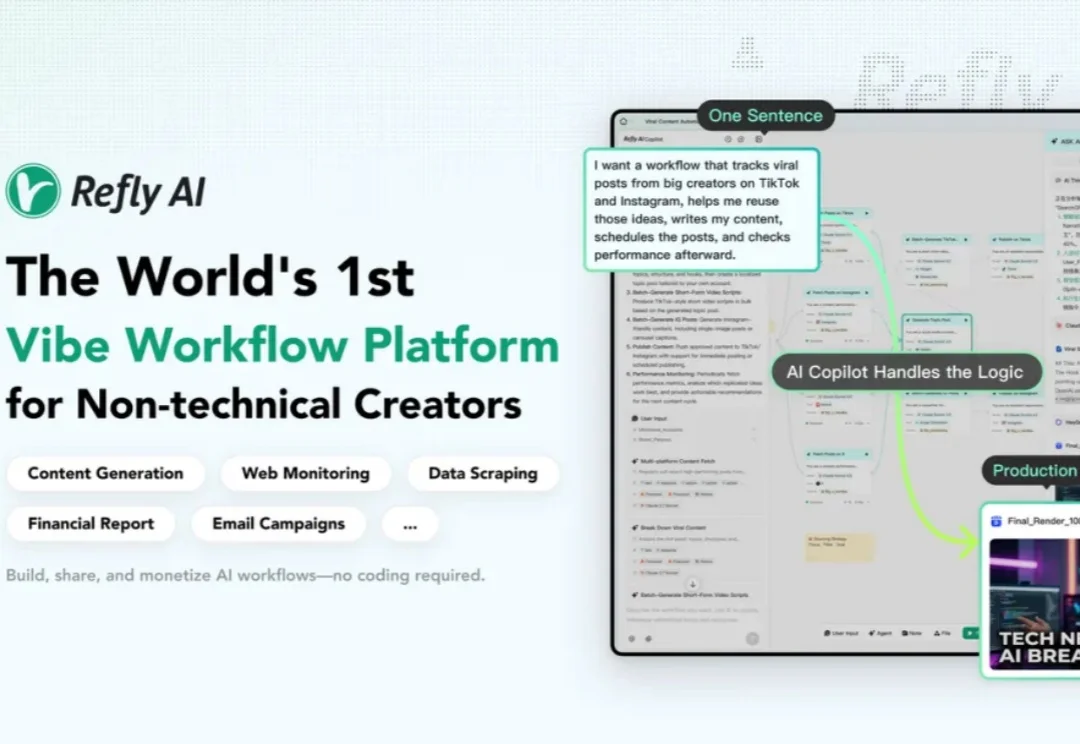

我在想,有没有这样一个工具:我不用理解节点和变量,直接说我想要什么,AI 就帮我把工作流搭出来?我尝试了很多,直到遇到 Refly.AI 这个 Vibe Workflow 平台—— AI 自动搭建工作流。它给出了一个让我眼前一亮的答案:通过 Vibe Workflow,把想法变成自动化工作流,让我真正进入口喷工作流时代。

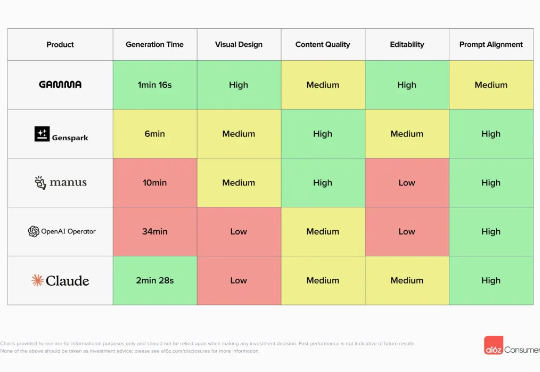

在AI办公工具的新浪潮中,一个新的概念正迅速走向舞台中央——Agentic生产率。这已不再是单纯的自动化工具,而是AI以“工作伙伴”的身份深度嵌入日常流程,从撰写邮件到制作表格,从生成PPT到整理会议纪要,全方位提升效率。

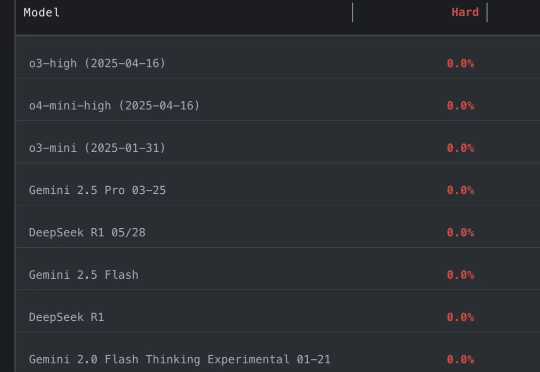

顶级大模型在AAI提出的FormulaOne基准集体翻车:三层难度递进,GPT-5进阶题仅约4%正确,最深层零分;Grok 4、o3 Pro全部失手。该基准以图上MSO逻辑与动态规划生成问题,贴近路径规划等现实优化,旨在衡量超越竞赛编程的算法推理深度。

AI模型排行榜分两类:以高考式标准化测试衡量特定能力的客观基准测试(如AAII、MMLU-Pro),以及用户匿名盲测、根据偏好对答案投票排名的人类偏好竞技场(如LMArena)。两者各有优劣和局限性,且排行榜本质是门生意。用户应基于实际需求而非榜单名次选择模型,实用性至上。

好夸张…… 参赛大模型全军覆没,通通0分。 谢赛宁等人出题,直接把o3、Gemini-2.5-pro、Claude-3.7、DeepSeek-R1一众模型全都难倒。

6月5日,微博认证为“ZEALER创始人&CEO”的王自如发文称,“明天我想用15分钟的时间带大家了解我为什么离开 ZEALER 、为什么离开格力,以及我为什么在AI领域选择二次创业,期待明天与大家重新认识。

你以为大模型已经能轻松“上网冲浪”了?

多模态大模型几何解题哪家强?