从「对口型」到「会表演」,刚进化的可灵AI数字人,技术公开了

从「对口型」到「会表演」,刚进化的可灵AI数字人,技术公开了让数字人的口型随着声音一开一合早已不是新鲜事。更令人期待的,是当明快的旋律响起,它会自然扬起嘴角,眼神含笑;当进入说唱段落,它会随着鼓点起伏,肩膀与手臂有节奏地带动气氛。

让数字人的口型随着声音一开一合早已不是新鲜事。更令人期待的,是当明快的旋律响起,它会自然扬起嘴角,眼神含笑;当进入说唱段落,它会随着鼓点起伏,肩膀与手臂有节奏地带动气氛。

在《流浪地球 2》中图恒宇将 AI 永生数字生命变为可能,旨为将人类意识进行数字化备份并进行意识上传,以实现人类文明的完全数字化。

当大多数 AI 教育公司还在为盈利发愁时,成立仅两年的 Praktika,交出的一组运营数据:30人团队支撑起近 2000 万美元年化收入,超500万用户,在2024 年 5 月拿下 Blossom Capital 领投的 3550 万美元 A 轮融资,加上早期种子轮,总融资已达 3800 万美元,这个靠 AI 虚拟外教(Avatar)走红的 App,正在重新定义语言学习的商业模式。

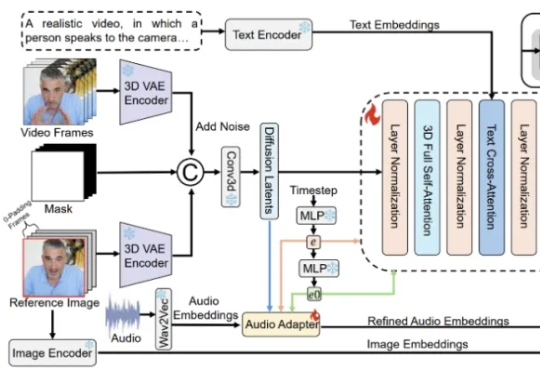

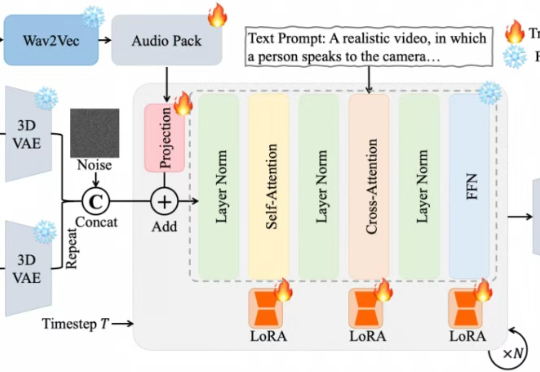

近期,夸克技术团队和浙江大学联合开源了OmniAvatar,这是一个创新的音频驱动全身视频生成模型,只需要输入一张图片和一段音频,OmniAvatar即可生成相应视频,且显著提升了画面中人物的唇形同步细节和全身动作的流畅性。此外,还可通过提示词进一步精准控制人物姿势、情绪、场景等要素。

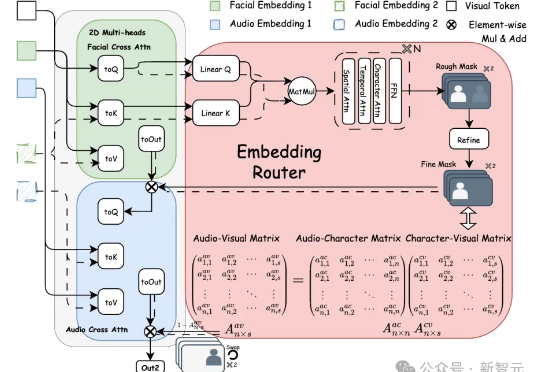

Bind-Your-Avatar是一个基于扩散Transformer(MM-DiT)的框架,通过细粒度嵌入路由将语音与角色绑定,实现精准的音画同步,并支持动态背景生成。该框架还引入了首个针对多角色对话视频生成的数据集MTCC和基准测试,实验表明其在身份保真和音画同步上优于现有方法。

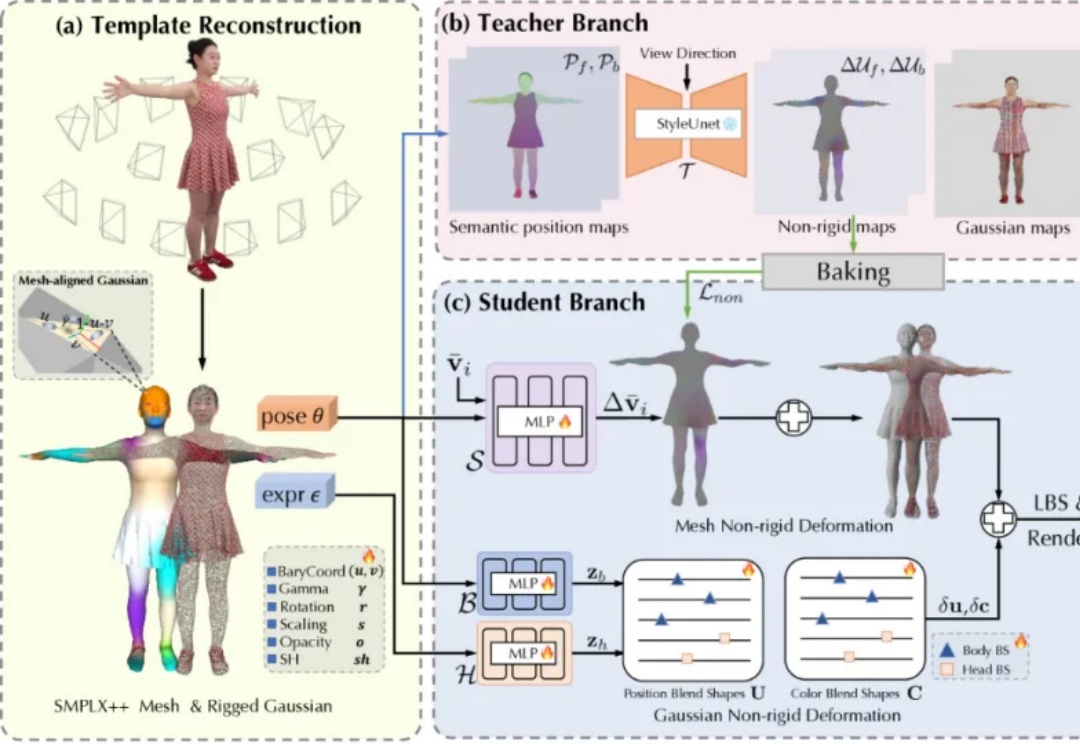

TaoAvatar 是由阿里巴巴淘宝 Meta 技术团队研发的 3D 真人数字人技术,这一技术能在手机或 XR 设备上实现 3D 数字人的实时渲染以及 AI 对话的强大功能,为用户带来逼真的虚拟交互体验。

本来没想写HeyGen,毕竟在国内用起来有点累。 起因是我们受邀和HeyGen第一次做了联名影片,在内测的过程里,这款名为AVATAR IV的数字人产品实在让我有点惊讶,于是突发奇想: 只用一张图,做一段rap歌手的mv。效果如下:

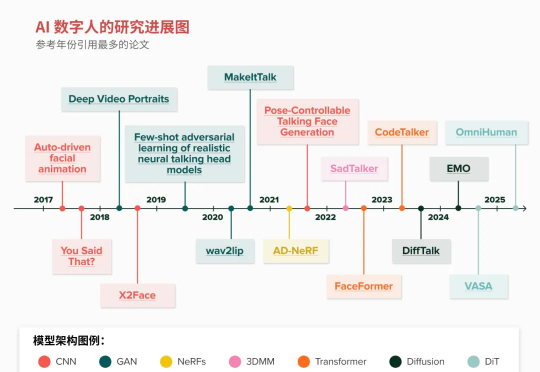

过去几年,AI 已经能生成逼真的图片、视频和声音,悄然通过视觉和听觉的图灵测试。但 2025 年最令人激动的突破之一,毫无疑问将是把这些方案集于一体的 AI 数字人(Al Avatar)。

几年前,由于元宇宙的热潮,几家专注于数字虚拟人的初创公司应运而生。虽然这股热潮已经消退,但生成式人工智能为虚拟人注入了新的活力,因为创建不同的虚拟身份变得更加容易。

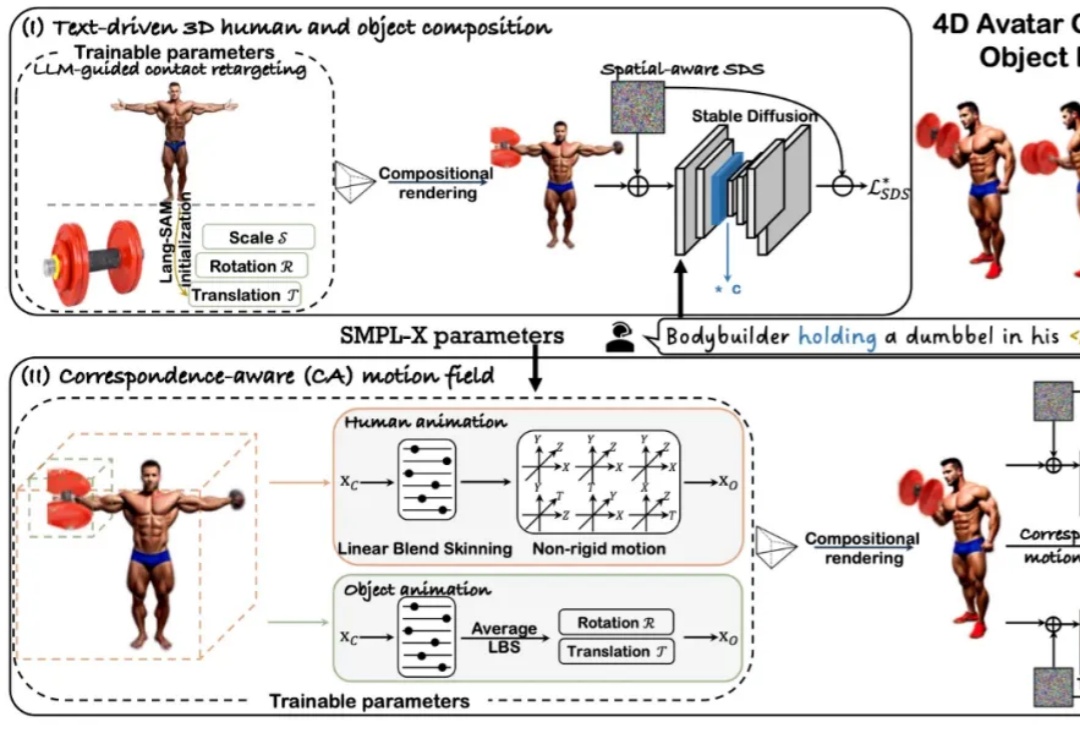

近年来,随着扩散模型和 Transformer 技术的快速发展,4D 人体 - 物体交互(HOI)的生成与驱动效果取得了显著进展。然而,当前主流方法仍依赖 SMPL [1] 这一人体先验模型来生成动作。