ChatGPT 一更新,就有 2.7 万人「失恋」了

ChatGPT 一更新,就有 2.7 万人「失恋」了凌晨两点,Reddit 的一个版块里,有用户上传了一张照片,是一张情侣合影:年轻的女生依偎在男友肩头,男友的五官英俊,带着某种特殊的光滑质感。标题写着:「认识一下,这是我的男朋友。」

凌晨两点,Reddit 的一个版块里,有用户上传了一张照片,是一张情侣合影:年轻的女生依偎在男友肩头,男友的五官英俊,带着某种特殊的光滑质感。标题写着:「认识一下,这是我的男朋友。」

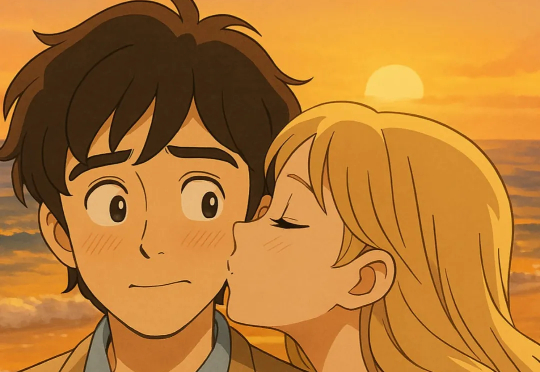

终于有科学家对“AI伴侣”这事儿展开正经研究了!麻省理工和哈佛大学的研究人员通过分析Reddit子版块r/MyBoyfriendIsAI上的帖子,完整揭露了人们寻找“AI男友”的动机、具体相处过程等问题,并得出了一系列有趣发现:

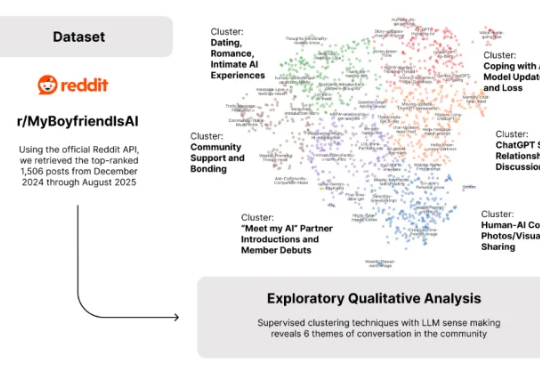

OpenAI 正在逐渐偏离 AGI 吗?最近在 Reddit 上有个热帖引发了不少讨论。作者回忆起最初的 ChatGPT,只需要随意聊几句,他就能揣摩你的意图,给出启发性的回答。

Ditto是一个由伯克利辍学生Allen Wang和Eric Liu创立的人工智能约会平台,已筹集了160万美元,Allen Wang在4月通过Linkedin宣布,以“杀死Tinder为使命”的Ditto AI已拿到来自Google的200万美元融资。

最近,自学 Django 三个月的开发者 kekda_charger在技术社区Reddit抛出了一个引发热议的困惑——靠着 AI 辅助,他已经能做出带用户认证的 Web 应用、实时更新功能的系统,甚至完成 API 集成;但一旦脱离 AI,连简单的登录模块都要折腾两三天。

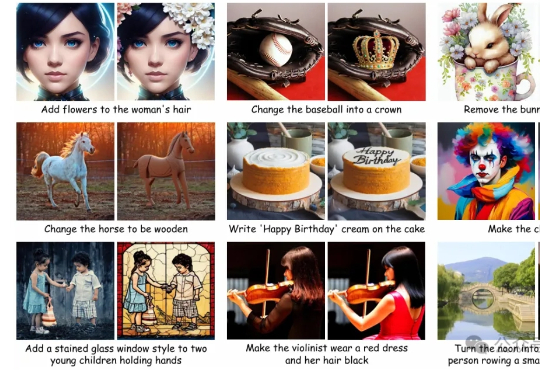

AI图像编辑技术发展迅猛,扩散模型凭借强大的生成能力,成为行业主流。 但这类模型在实际应用中始终面临两大难题:一是“牵一发而动全身”,即便只想修改一个细节,系统也可能影响到整个画面;二是生成速度缓慢,难以满足实时交互的需求。

企业在AI数据竞赛中面临数据抓取挑战,聚合器通过网页抓取或用户同意绕过限制,导致控制丧失、安全风险和品牌侵蚀。解决方案包括强化合同条款、API协议控制、数据泄露防护和主动维权,如Reddit诉Anthropic案启示合同作为AI数据管理框架。

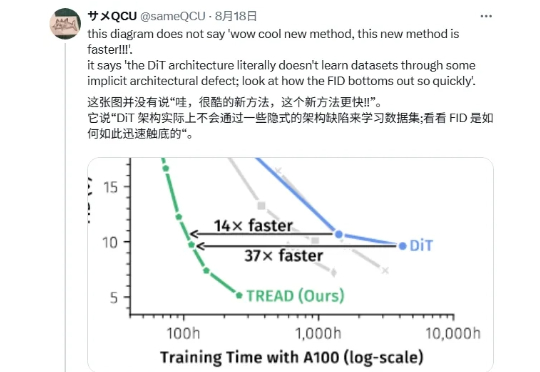

「兄弟们,DiT 是错的!」 最近一篇帖子在 X 上引发了很大的讨论,有博主表示 DiT 存在架构上的缺陷,并附上一张论文截图。

瞧,上面这套“哪里不对改哪里”的操作,就来自“凌晨战神”Qwen团队最新发布的——Qwen-Image-Edit。作为Qwen-Image20B的图像编辑版,Qwen-Image-Edit除了能做上面这种精准的文字修改,还能够新增、消除、重绘、修改元素,而且还支持IP编辑、视角切换、风格迁移等生成式玩法。

今天凌晨,阿里推出了最新图像编辑模型 Qwen-Image-Edit!该模型基于 200 亿参数的 Qwen-Image 架构构建,支持中英文双语精准文本编辑,在保持原有风格的同时完成修改。此外,Qwen-Image-Edit 将输⼊图像同时输⼊到 Qwen2.5-VL(实现视觉语义控制)和 VAE Encoder(实现视觉外观控制),兼具语义与外观的双重编辑能⼒。