免费用!阿里通义大模型上新,超逼真音视频生成SOTA!

免费用!阿里通义大模型上新,超逼真音视频生成SOTA!近日,阿里通义实验室推出了全新数字人视频生成大模型 OmniTalker,只需上传一段参考视频,不仅能学会视频中人物的表情和声音,还能模仿说话风格。相比传统的数字人生产流程,该方法能够有效降低制作成本,提高生成内容的真实感和互动体验,满足更广泛的应用需求。目前该项目已在魔搭社区、HuggingFace 开放体验入口,并提供了十多个模板,所有人可以直接免费使用。

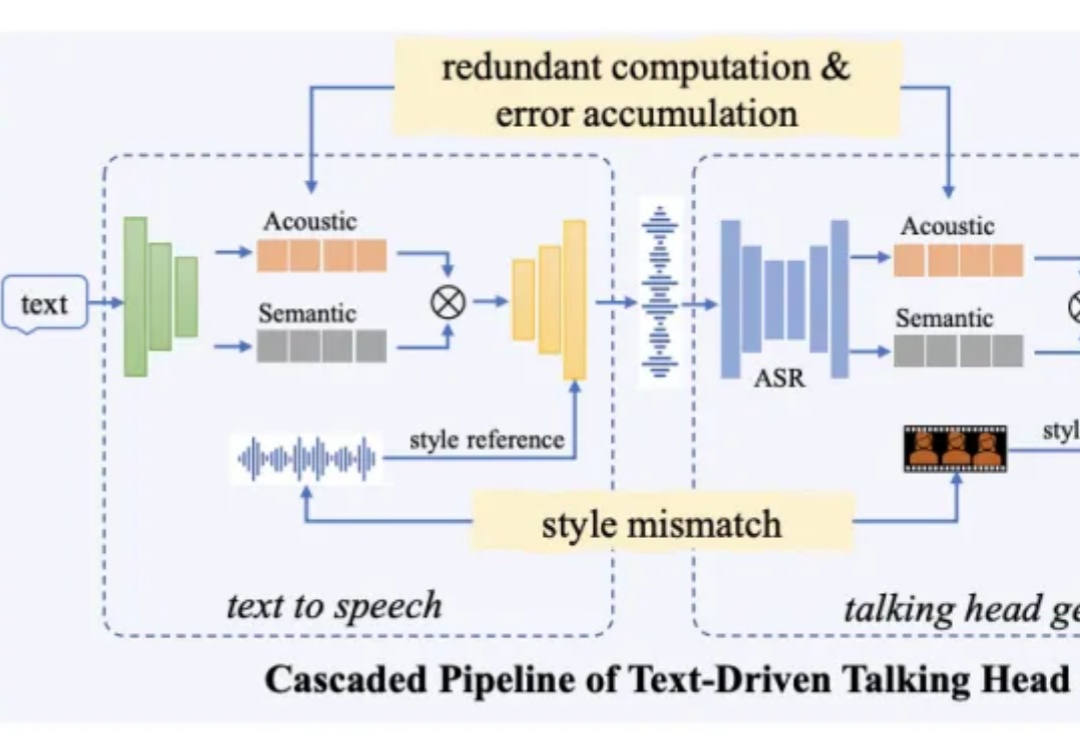

近日,阿里通义实验室推出了全新数字人视频生成大模型 OmniTalker,只需上传一段参考视频,不仅能学会视频中人物的表情和声音,还能模仿说话风格。相比传统的数字人生产流程,该方法能够有效降低制作成本,提高生成内容的真实感和互动体验,满足更广泛的应用需求。目前该项目已在魔搭社区、HuggingFace 开放体验入口,并提供了十多个模板,所有人可以直接免费使用。

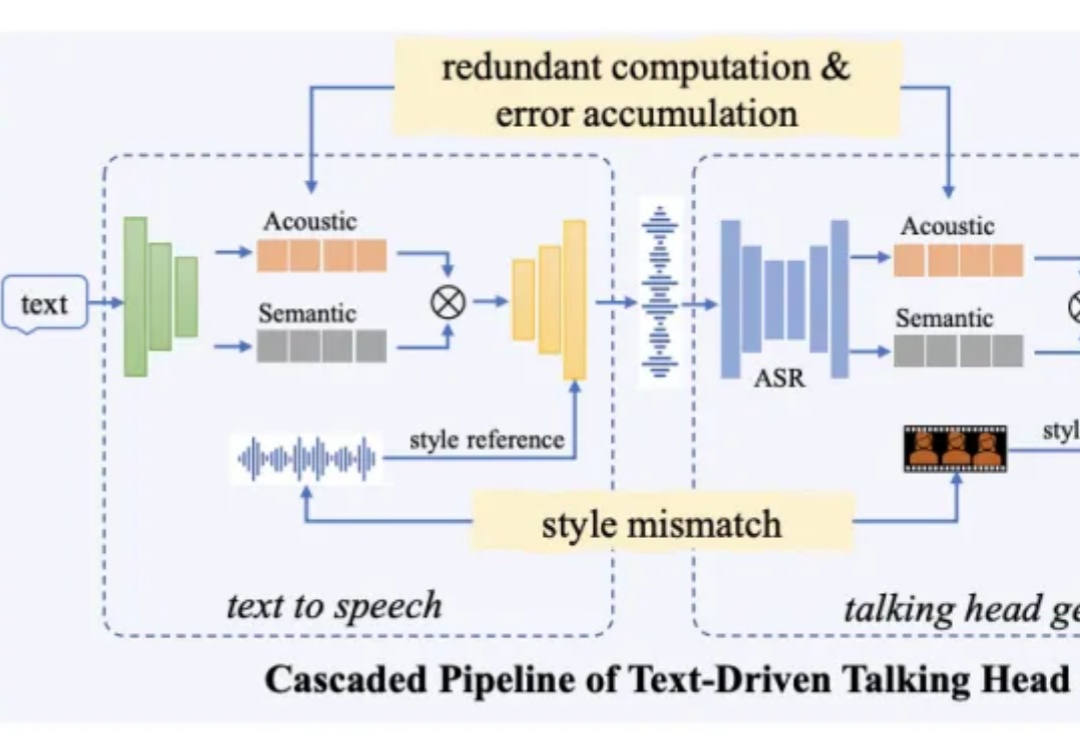

尽管这些论文的结论统统指向了强化学习带来的显著性能提升,但来自图宾根大学和剑桥大学的研究者发现,强化学习导致的许多「改进」可能只是噪音。「受推理领域越来越多不一致的经验说法的推动,我们对推理基准的现状进行了严格的调查,特别关注了数学推理领域评估算法进展最广泛使用的测试平台之一 HuggingFaceH4,2024;AI - MO。」

CAMEL-AI 团队在 Manus 上线后 1 天内推出的 OWL 就是其中最具代表性的一个,项目实测成绩达到开源界 GAIA 性能天花板,达到了 58.18%,超越 Huggingface 提出的 Open Deep Research 55.15% 的表现。

Dima Shvets作为天使投资人兼Reface联合创始人,其打造的AI换脸应用下载量突破2.5亿次。该应用的成功源于"实时换脸"技术的先发优势与病毒式传播特性的双重驱动。以下是Dima分享关于如何成功打造Reface的经验分享

今天,百图生科宣布开源其领先的xTrimo V2中的蛋白质语言模型xTrimoPGLM,7个不同参数量的模型均已发布在huggingface和github,供全球用户自由获取和使用。xTrimoPGLM是全球首个千亿参数的蛋白质语言模型,性能超越了ESM-2、ProGen2等此前业界领先的蛋白质模型,并在药物分子设计和优化、抗体工程与疫苗开发、酶工程和生物催化剂设计等领域展现出广泛应用前景。

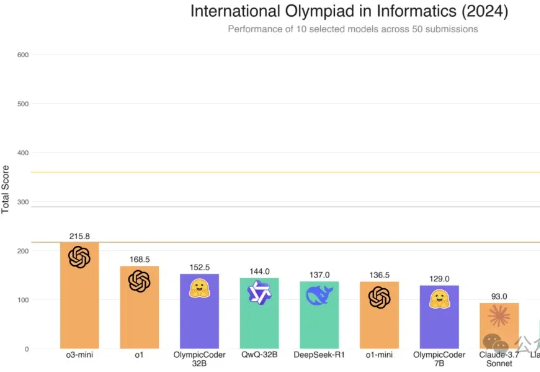

Hugging Face的Open R1重磅升级,7B击败Claude 3.7 Sonnet等一众前沿模型。凭借CodeForces-CoTs数据集的10万高质量样本、IOI难题的严苛测试,以及模拟真实竞赛的提交策略优化,这款模型展现了惊艳的性能。

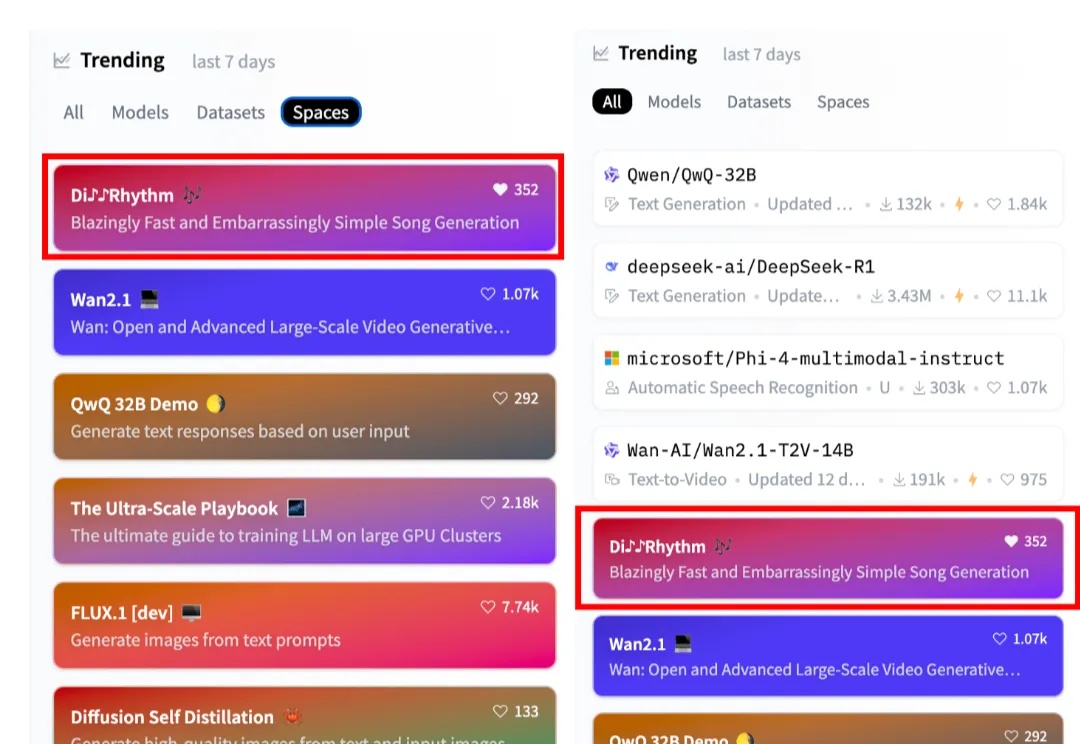

DiffRhythm是一款新型AI音乐生成模型,能在10秒内生成长达4分45秒的完整歌曲,包含人声和伴奏。它采用简单高效的全diffusion架构,仅需歌词和风格提示即可创作,还支持本地部署,最低只需8G显存。

HuggingFace热门榜单几乎被中国模型“承包”了!

Hugging Face发布了「超大规模实战手册」,在512个GPU上进行超过4000个scaling实验。联创兼CEO Clement对此感到十分自豪。

就在刚刚,网上已经出现了一波复现DeepSeek的狂潮。UC伯克利、港科大、HuggingFace等纷纷成功复现,只用强化学习,没有监督微调,30美元就能见证「啊哈时刻」!全球AI大模型,或许正在进入下一分水岭。