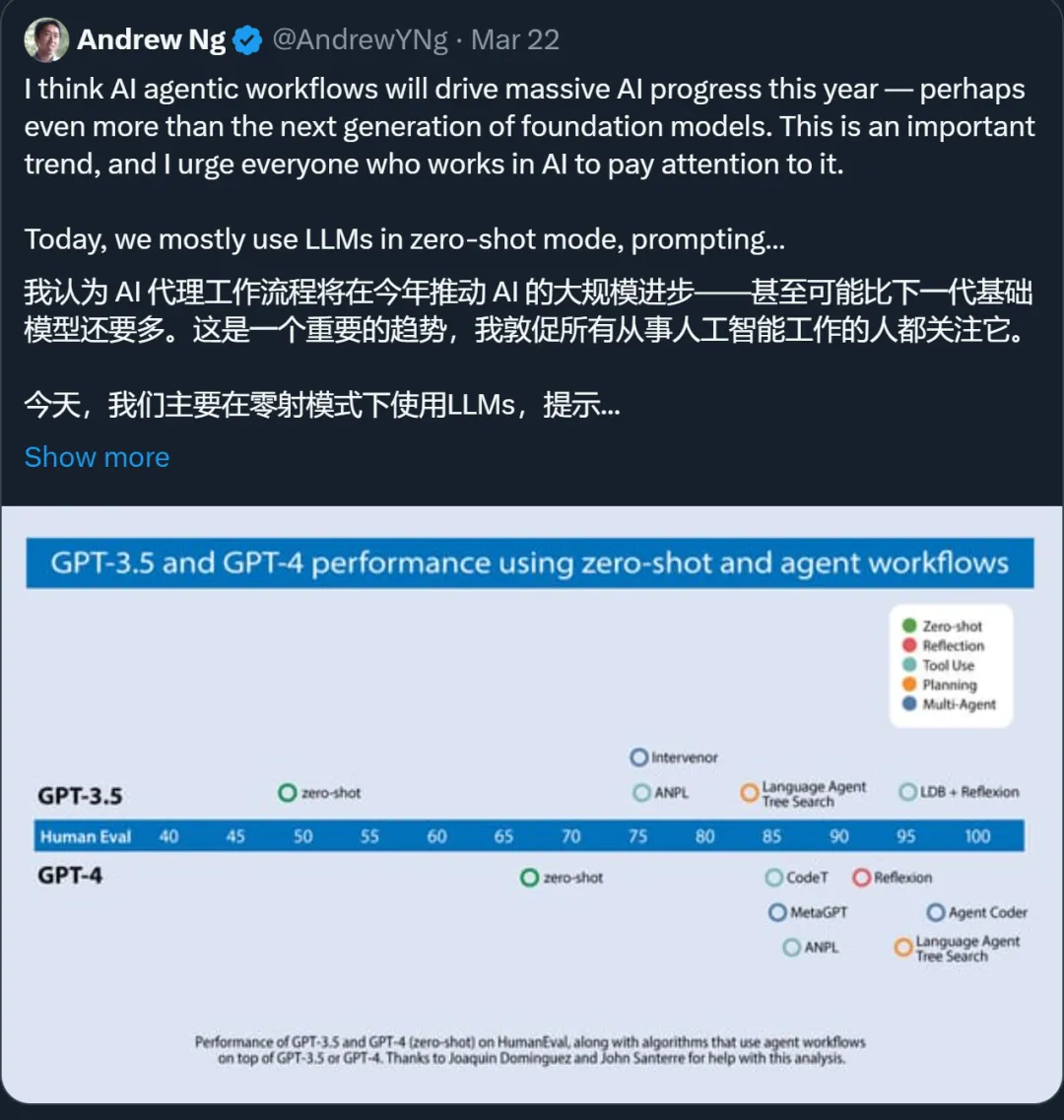

吴恩达:别光盯着GPT-5,用GPT-4做个智能体可能提前达到GPT-5的效果

吴恩达:别光盯着GPT-5,用GPT-4做个智能体可能提前达到GPT-5的效果AI 智能体是去年很火的一个话题,但是 AI 智能体到底有多大的潜力,很多人可能没有概念。 最近,斯坦福大学教授吴恩达在演讲中提到,他们发现,基于 GPT-3.5 构建的智能体工作流在应用中表现比 GPT-4 要好。当然,基于 GPT-4 构建的智能体工作流效果更好。由此看来,AI 智能体工作流将在今年推动人工智能取得巨大进步,甚至可能超过下一代基础模型。这是一个值得所有人关注的趋势。