喧嚣背后,国产GPU距离“平替”英伟达还有多远?

喧嚣背后,国产GPU距离“平替”英伟达还有多远?2024年上海的7月是一个沉闷的雨季,但对国产AI 行业来说,却迎来了堪比摇滚乐集会的WAIC(世界人工智能大会)。

来自主题: AI资讯

8757 点击 2024-08-12 17:38

2024年上海的7月是一个沉闷的雨季,但对国产AI 行业来说,却迎来了堪比摇滚乐集会的WAIC(世界人工智能大会)。

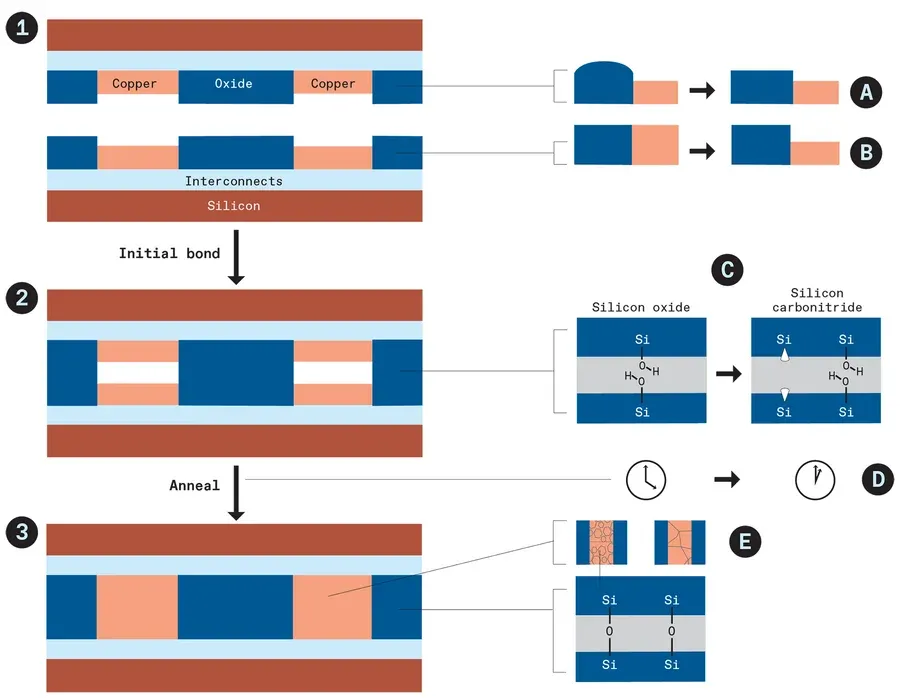

在一平方毫米的硅片上建立数百万个连接。

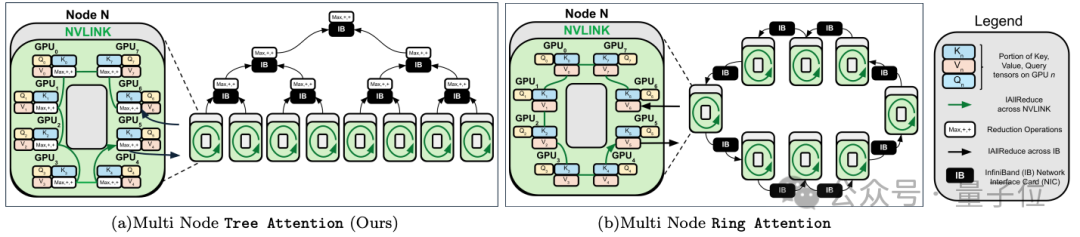

跨GPU的注意力并行,最高提速8倍,支持512万序列长度推理。

有CPU就能跑大模型,性能甚至超过NPU/GPU!

一场未完成的投资改变了什么?

AI重新定义游戏体验的时代。

a16z的氧气计划

谷歌TPU核心团队创立,要做世界最快推理。

Groq又双叒给英伟达上压力了!不仅之前展现了每秒1256个token的破纪录输出速度,最新获得的一轮6.4亿美元融资更提供了在AI芯片领域挑战英伟达的底气。

Llama 3.1刚发布不久,Llama 4已完全投入训练中。 这几天,小扎在二季度财报会上称,Meta将用Llama 3的十倍计算量,训练下一代多模态Llama 4,预计在2025年发布。