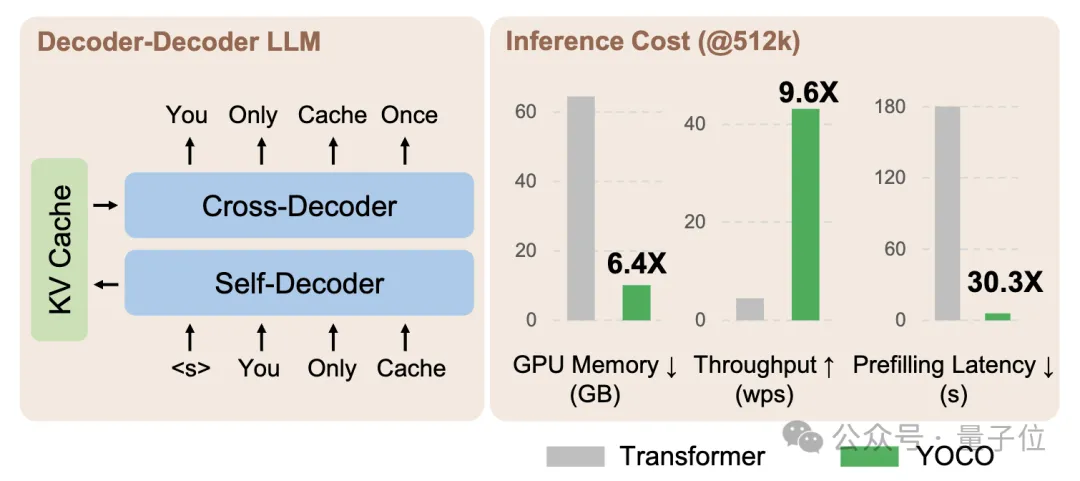

微软打破Decoder-Only架构!大幅降低GPU内存需求,网友:把Llama3 70B弄20GB GPU上运行

微软打破Decoder-Only架构!大幅降低GPU内存需求,网友:把Llama3 70B弄20GB GPU上运行微软&清华最新研究,打破GPT系列开创的Decoder-Only架构——

微软&清华最新研究,打破GPT系列开创的Decoder-Only架构——

在一个昏暗的机箱里,一台 RTX 3090 GPU「唱」着经典英语儿歌《一闪一闪亮晶晶》(Twinkle,Twinkle,Little Star)的旋律。

有数据统计,2022年全年,全国数据中心耗电量达到2700亿千瓦时,占全社会用电量约3%。预计2024年全国数据中心的耗电量将在3400亿至3600亿度之间,到2025年可能增长至4000亿至4400亿度。

尽管苹果在生成式 AI 方面的进展没有像谷歌、Meta 和微软等竞争对手那样高调,但该公司一直在进行相关研究,其构筑新生态的思路总是显得与众不同。

据《华尔街日报》7日报道,苹果公司正在为数据中心服务器研发设计运行人工智能(AI)软件的芯片,这一举措或将使苹果在日益激烈的AI领域军备竞赛中占据优势。

4月下旬,台积电发布了一种新版本4nm制程工艺——N4C,计划在2025年上线量产。这款工艺产品的核心价值是降低了成本。

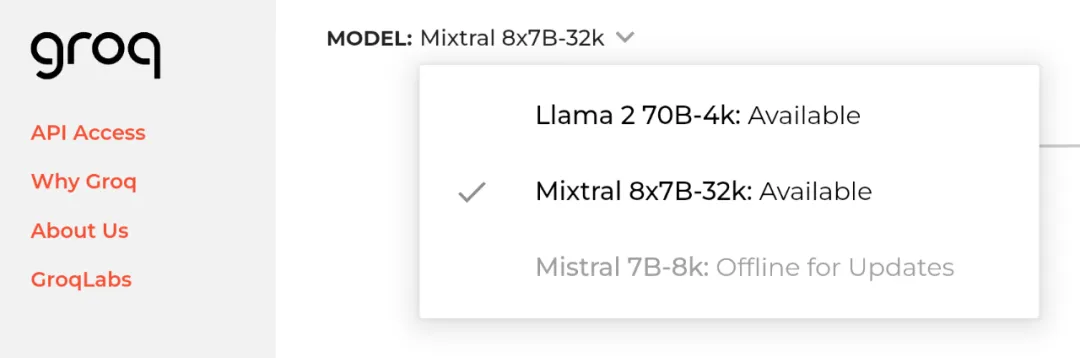

2024 年 4 月 20 日,即 Meta 开源 Llama 3 的隔天,初创公司 Groq 宣布其 LPU 推理引擎已部署 Llama 3 的 8B 和 70B 版本,每秒可输出token输提升至800。

AI PC的竞争,越来越火热了!

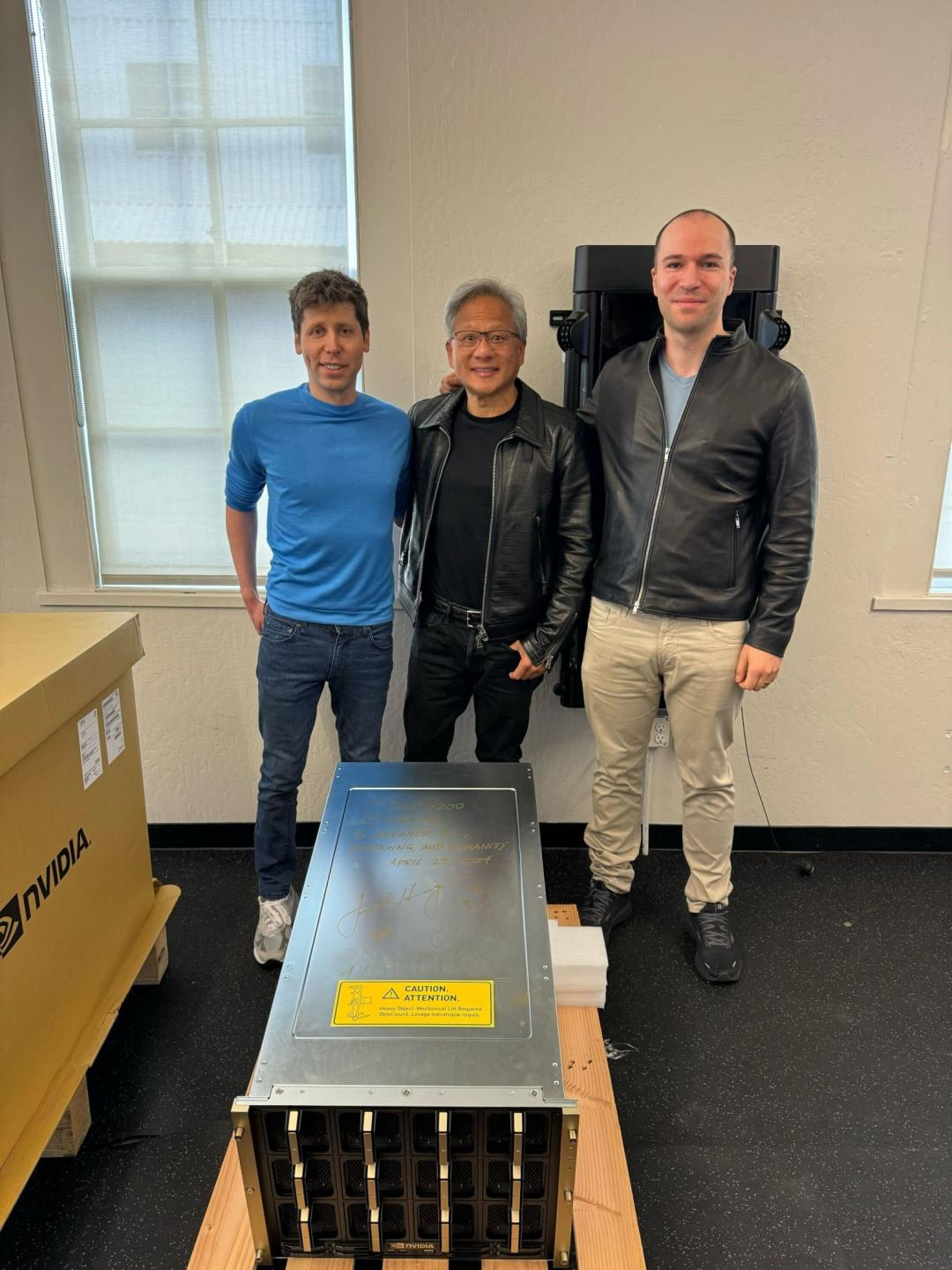

全球首台,黄仁勋亲自送货上门,OpenAI首发,DGX H200算是把流量拉满了。

2024年4月下旬,AMD方面发布了锐龙8000系列的专业向桌面版产品线,也就是锐龙PRO的8000系列家族。与大家熟知的“普通版”锐龙8000系列相比,“专业线”的锐龙PRO 8000系列其实变化并不大,它们主要是增加了对于微软安全处理器(Microsoft Pluton)、ECC内存、安全虚拟化,以及远程管理等专业功能的支持。