国产GPU重大利好!“中国英伟达”千卡集群已就位

国产GPU重大利好!“中国英伟达”千卡集群已就位算力基础设施建设,北京市有了最新的大动作—— 《北京市算力基础设施建设实施方案(2024-2027年)》

算力基础设施建设,北京市有了最新的大动作—— 《北京市算力基础设施建设实施方案(2024-2027年)》

Llama 3诞生整整一周后,直接将开源AI大模型推向新的高度。

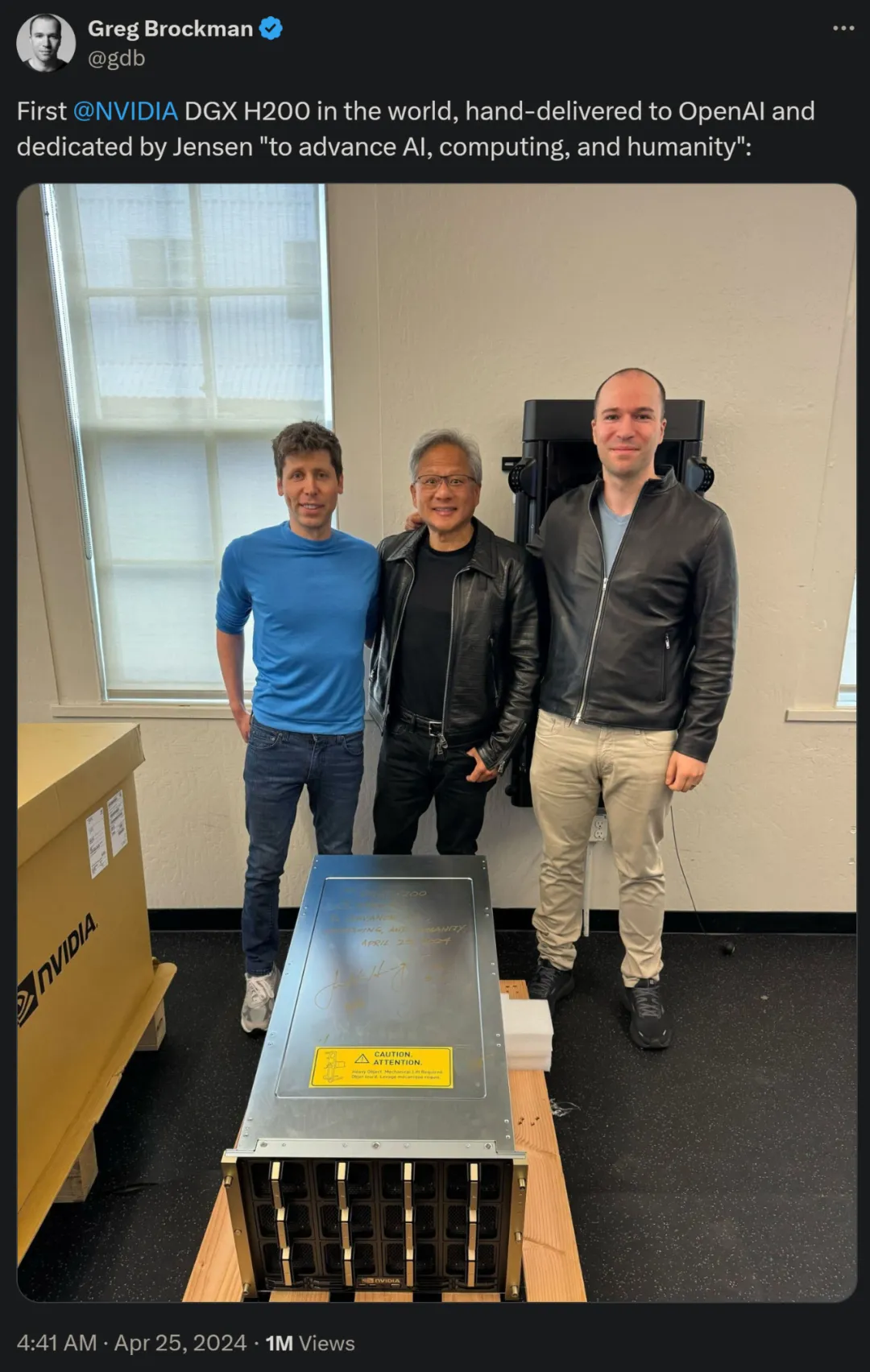

昨天,黄仁勋亲自为 OpenAI 送来了全球第一台 Nvidia DGX H200 超级计算机,三人合影(老黄、奥特曼、Greg Brockman )引得大家津津乐道。

AI届大红人Altman在母校斯坦福开讲当天,在场的学生挤爆了英伟达礼堂。 去礼堂路的上,人满为患,超1000人早早排在了门口。

昨天,黄仁勋亲自为 OpenAI 送来了全球第一台 Nvidia DGX H200 超级计算机,三人合影(老黄、奥特曼、Greg Brockman )引得大家津津乐道。

皮衣老黄亲自上门送货!OpenAI收到世界上第一台DGX H200超算。

刚刚,世界首台DGX H200,由老黄亲自交付给OpenAI!

今天,黄仁勋又来送 AI 芯片了,还是超强悍的那种。

国内AI不行,是因为芯片不行? 我们跟国外的差距,是因为和英伟达芯片的差距过大?

4月18日,以“AI for All,让世界充满AI”为主题的联想创新科技大会(2024 Lenovo Tech World)在上海举办。