英伟达官方盘点2023年10大研究!「神经朗琪罗」秒变逼真大卫,用AI生成3D虚拟世界

英伟达官方盘点2023年10大研究!「神经朗琪罗」秒变逼真大卫,用AI生成3D虚拟世界英伟达官方盘点2023年10大研究,从CV到AI,从智能体到生成式AI。英伟达不但现实世界中用GPU收割全世界,也在虚拟世界中用一项项匪夷所思的技术展开了一场革命。

英伟达官方盘点2023年10大研究,从CV到AI,从智能体到生成式AI。英伟达不但现实世界中用GPU收割全世界,也在虚拟世界中用一项项匪夷所思的技术展开了一场革命。

算力不足仍然是制约通用人工智能发展的重要因素。GPU Utils 今年 8 月的一份数据显示,全球目前 H100 等效算力的供给缺口达到 43 万张。在解决算力不足的问题上,除了抢购和囤积英伟达,更多的方案正在浮出水面。

国内首个以国产全功能GPU为底座的大规模算力集群,正式落地了!这便是来自摩尔线程的KUAE智算中心,全国产千卡千亿模型训练平台。

2023这个大模型爆发的元年即将过去,展望未来,比尔盖茨,李飞飞,吴恩达等人对2024年人工智能的发展作出了自己的预测。

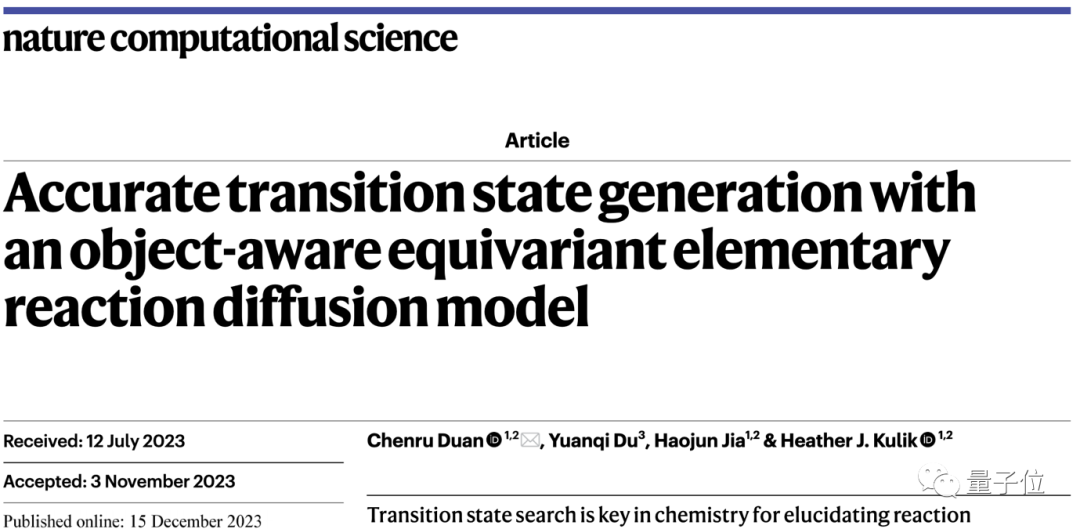

用扩散模型预测化学反应,速度直接暴涨1000倍!原本需要用计算机硬算几小时甚至一天,现在单个GPU用6秒钟就能搞定。

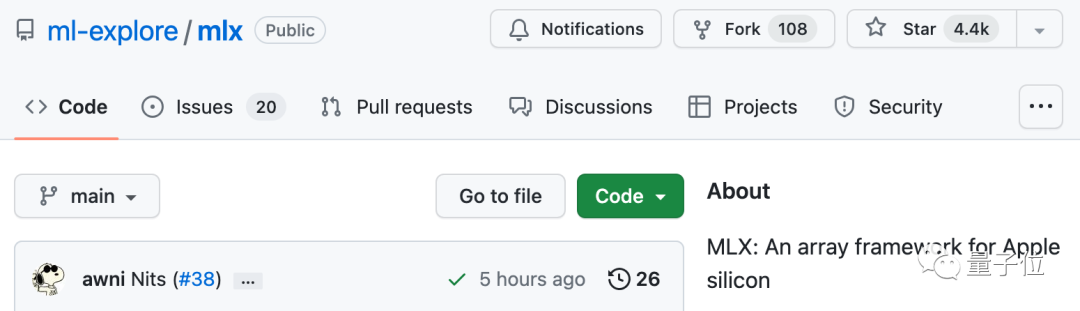

苹果M系列芯片专属的机器学习框架,开源即爆火!现在,用上这个框架,你就能直接在苹果GPU上跑70亿参数大模型、训练Transformer模型或是搞LoRA微调。

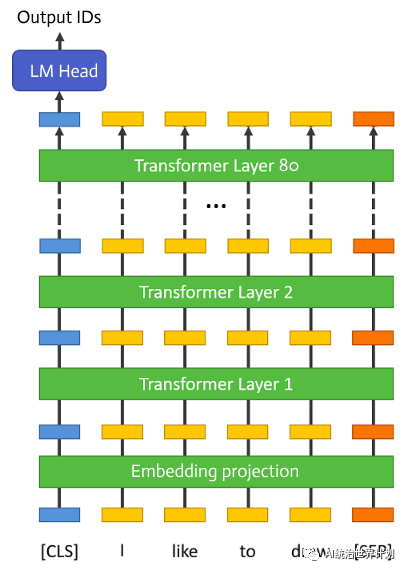

大语言模型需要消耗巨量的GPU内存。有可能一个单卡GPU跑推理吗?可以的话,最低多少显存?70B大语言模型仅参数量就有130GB,仅仅把模型加载到GPU显卡里边就需要2台顶配100GB内存的A100。

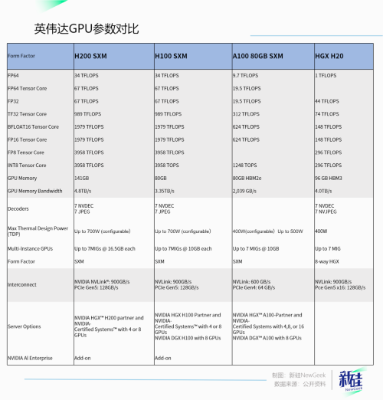

英伟达推出的新一代GPU,NVIDIA HGX H200,被称为“最强AI芯片”。H200在推理速度、显存容量和带宽等方面相较于H100有显著提升。文章还提到了英伟达为中国市场推出的改良版GPU H20,虽然性能较H200有所降低,但在带宽方面更高,成本也更低。

英伟达老黄,带着新一代GPU芯片H200再次炸场。官网毫不客气就直说了,“世界最强GPU,专为AI和超算打造”。

提及人工智能AI相关的算力芯片,现在绝大多数人的第一反应都是英伟达NVIDIA的GPU,作为AI模型搭建的基础,英伟达的A100/H100几乎成为了一块块“金砖”,深受业界喜爱。