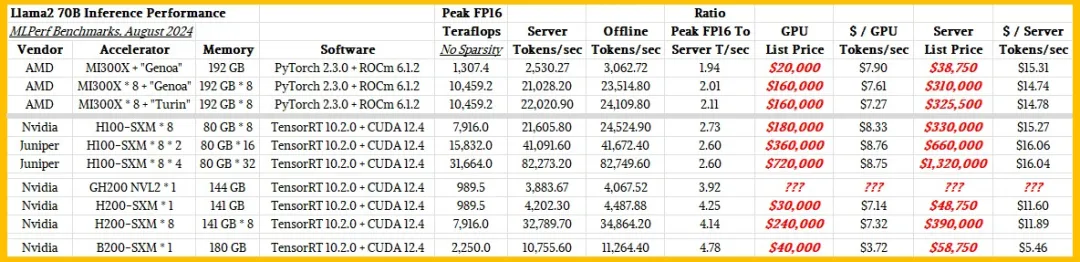

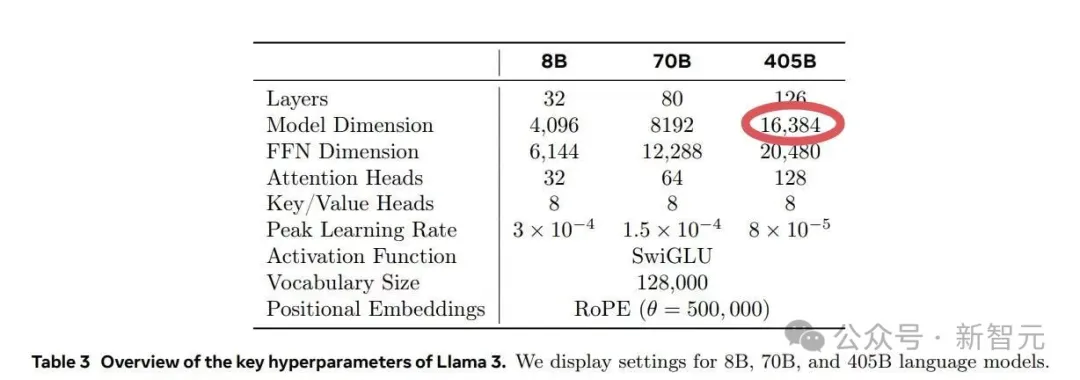

AMD的GPU跑AI模型终于Yes了?PK英伟达H100不带怕的

AMD的GPU跑AI模型终于Yes了?PK英伟达H100不带怕的都很贵。

都很贵。

大摩认为,GPU供应仍然比较紧张,需求继续超过供应。过去6个月中H100租赁价格有所下降,但价格的绝对水平表明硬件的投资回报率非常高,回本期在一年以内。

LLM若以每秒1000+token高速推理,当前最先进的GPU根本无法实现!Cerebras Inference一出世,推理速度赶超英伟达GPU,背靠自研的世界最大芯片加持。而且,还将推理价格打了下来。

多年来,马斯克一直在公开谈论Dojo——这台超算将成为特斯拉人工智能雄心的基石。他最近表示,随着特斯拉准备在10月推出Robotaxi,AI团队将「加倍投入」Dojo。

埃隆·马斯克掌控的那几家公司——包括SpaceX、特斯拉、xAI乃至X(原Twitter)——都需要大量的GPU,而且也都是为自己的特定AI或者高性能计算(HPC)项目服务。

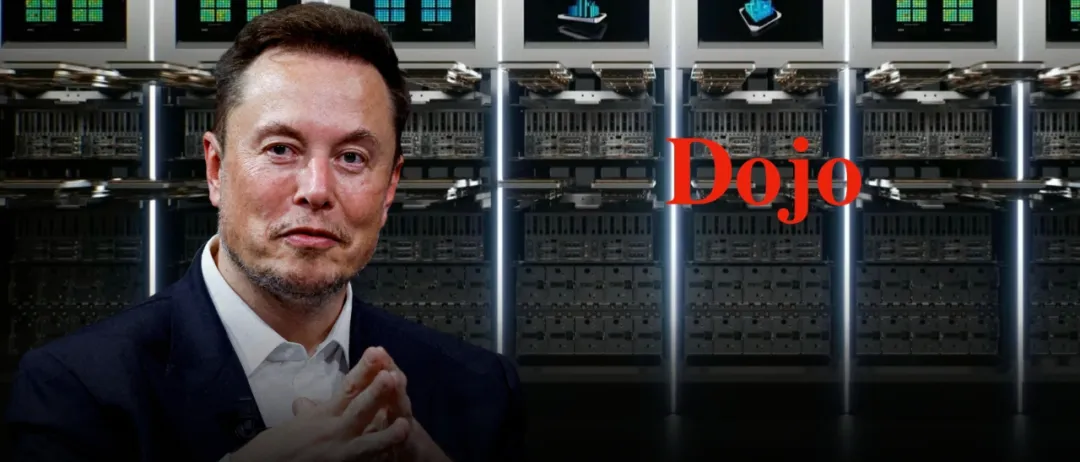

面对LLM逐渐膨胀的参数规模,没有H100的开发者和研究人员们想出了很多弥补方法,「量化」技术就是其中的一种。这篇可视化指南用各种图解,将「量化」的基本概念和分支方法进行了全方位总结。

在Meta的Llama 3.1训练过程中,其运行的1.6万个GPU训练集群每3小时就会出现一次故障,意外故障中的半数都是由英伟达H100 GPU和HBM3内存故障造成的。

每3个小时1次、平均1天8次,Llama 3.1 405B预训练老出故障,H100是罪魁祸首?

榨干16000块H100、基于15亿个Tokens训练。

世界最强AI集群,马斯克建成了! 这一爆炸消息,由老马在推特上亲自官宣。