马斯克19天建成世界最强AI集群!10万块H100「液冷怪兽」即将觉醒

马斯克19天建成世界最强AI集群!10万块H100「液冷怪兽」即将觉醒10万块液冷H100正式开工,马斯克19天建成世界最强AI训练集群。

10万块液冷H100正式开工,马斯克19天建成世界最强AI训练集群。

不用H100,三台苹果电脑就能带动400B大模型。 背后的功臣,是GitHub上的一个开源分布式AI推理框架,已经斩获了2.5k星标。

整个市场不再追求大而全,都在走小而精的路线了。

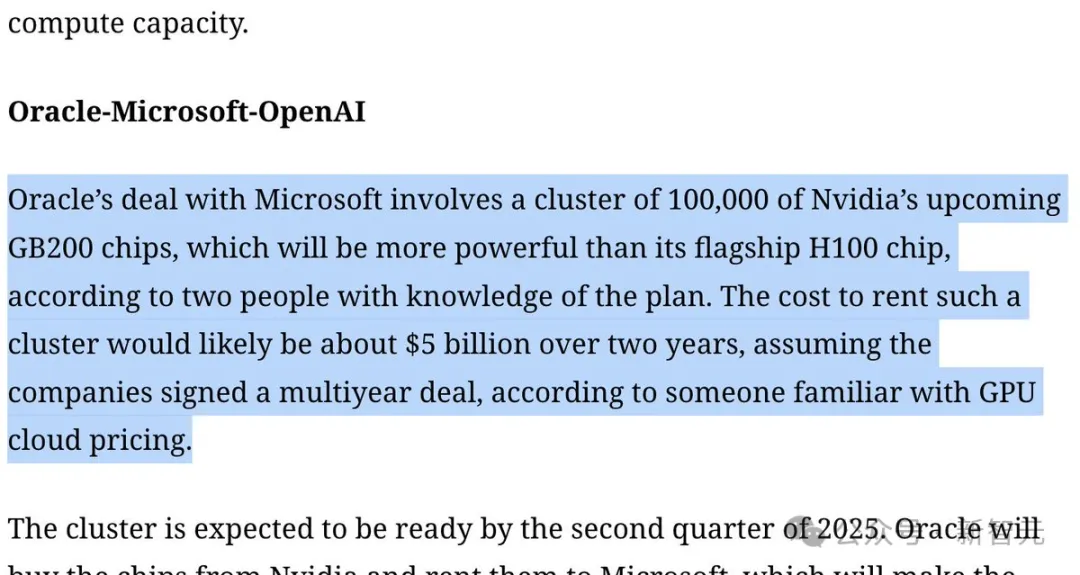

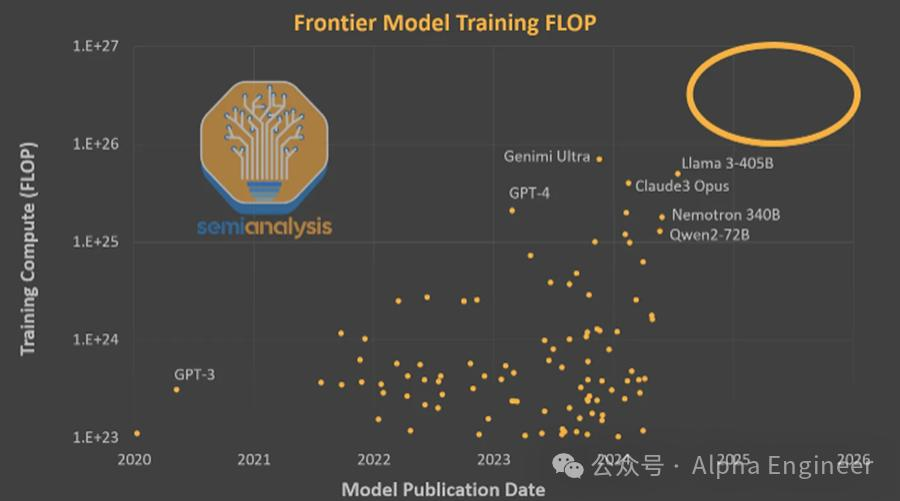

马斯克官宣xAI建造的世界最大超算集群,由10万块H100搭建,预计本月末开始投入训练。另一边,OpenAI再次加码,将打造由10万块GB200组成的超算,完全碾压xAI。

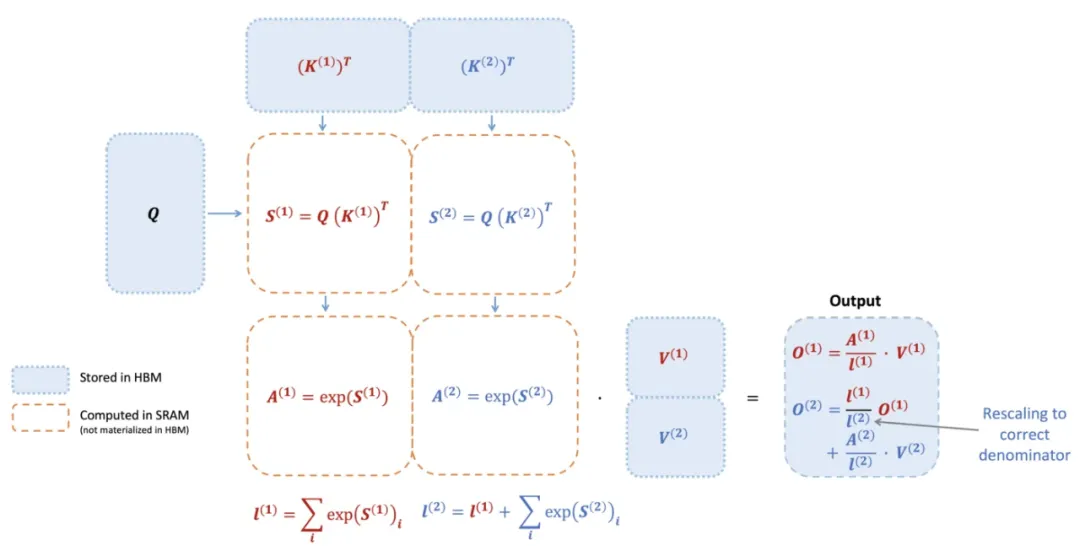

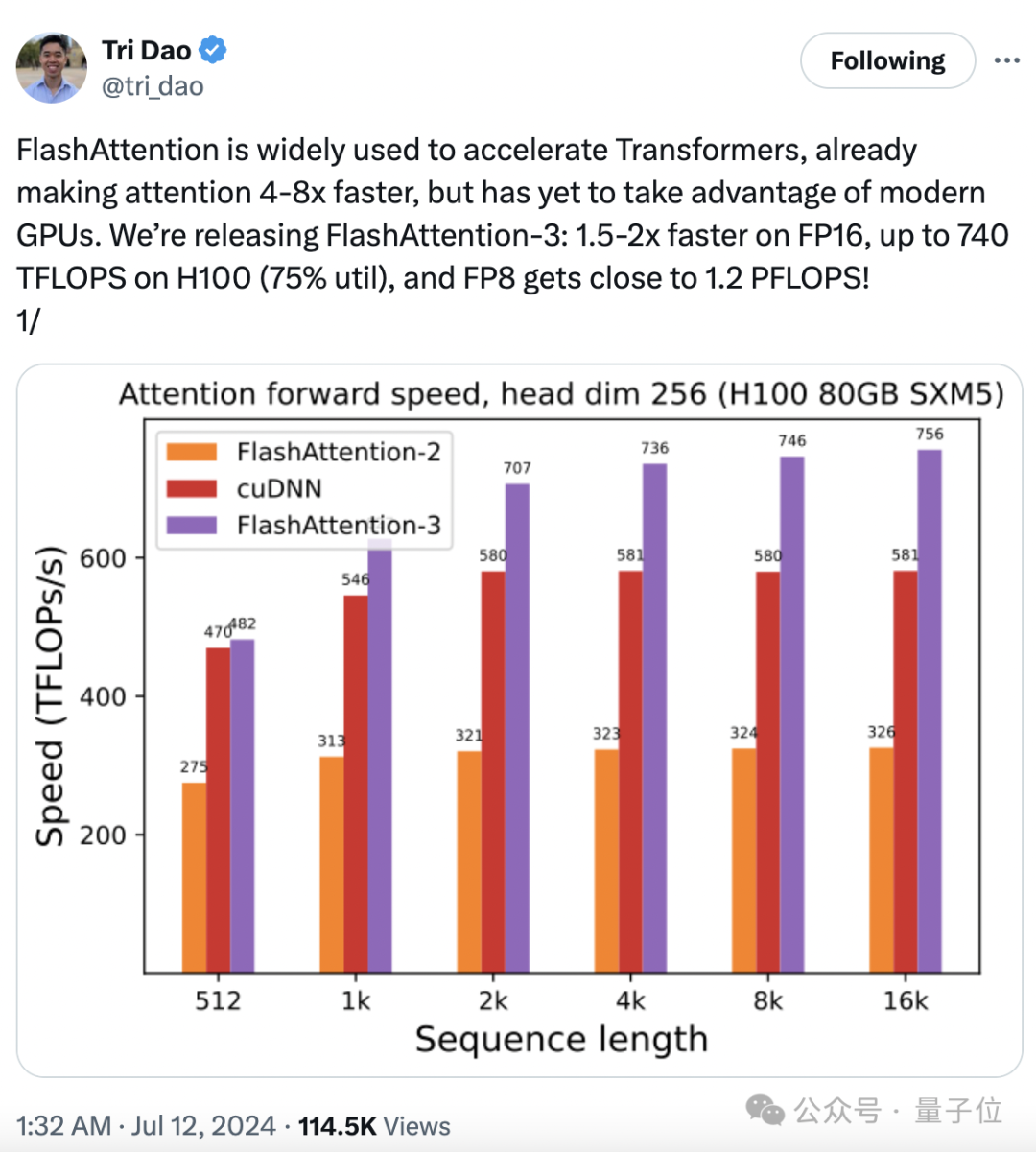

740 TFLOPS!迄今最强 FlashAttention 来了。

时隔一年,FlashAttention又推出了第三代更新,专门针对H100 GPU的新特性进行优化,在之前的基础上又实现了1.5~2倍的速度提升。

大模型训练推理神作,又更新了!

马斯克为Grok 3要豪掷近40亿美元狂买10万张H100,GPT-6的训练则可能要耗资百亿。然而红杉和高盛近日都给行业泼了冷水:每年要挣6000亿美元才能支付的巨额硬件支出,换来的却只是OpenAI 34亿美元的收入,绝大多数初创连1亿美元都达不到。而如果全世界的AI泡沫都被戳破,很可能就会导致新的经济危机。

马斯克连回两条推文为xAI造势,宣布8月发布Grok 2,年底将推出在10万张H100上训练的Grok 3,芯片加持创新数据训练,打造对标GPT的新一代大语言模型。

10万张H100卡构成的超级AI算力集群就像是现代人类文明的奇观,是人类通向AGI的钥匙。AI时代的军备竞赛已经拉开帷幕,赌注是天量的Capex支出,胜者则有机会成为AI时代的造物主。