教程|别只盯着 Langchain!Google ADK 搭建 Agent,上下文管理效率翻倍

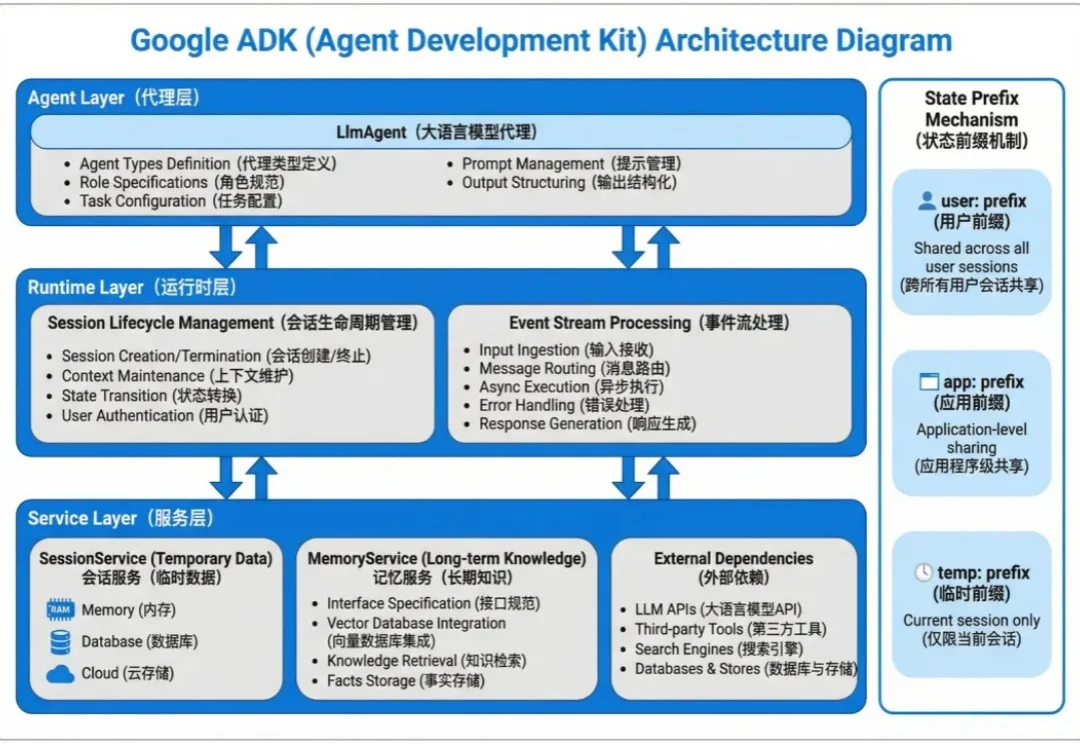

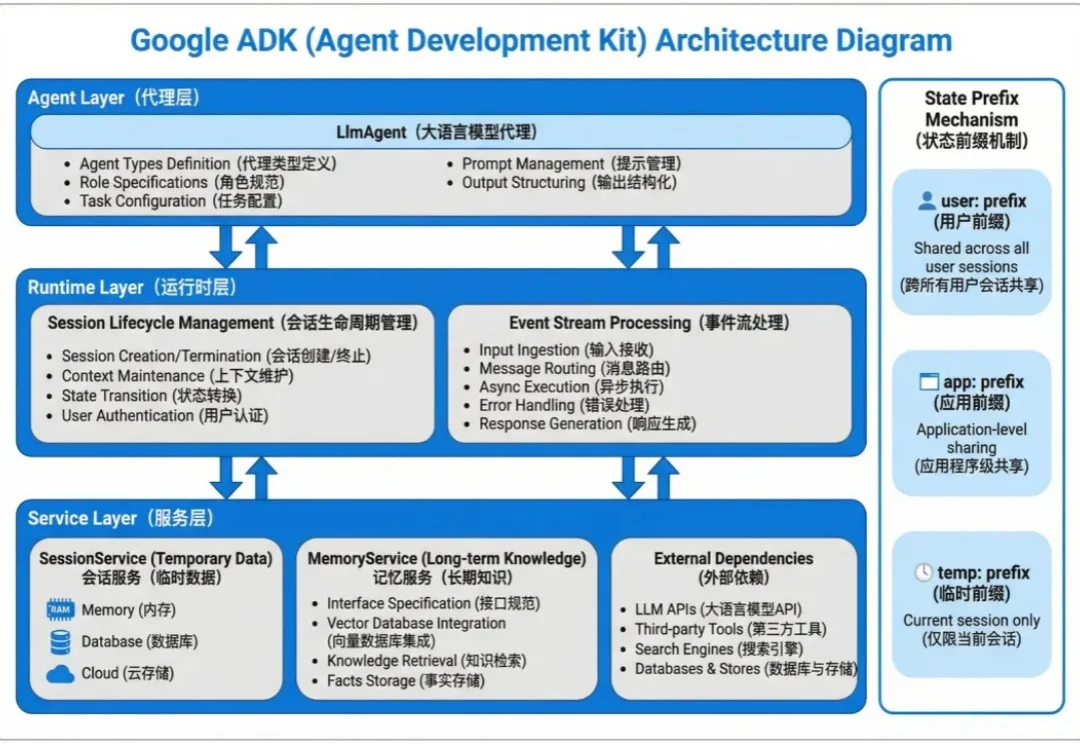

教程|别只盯着 Langchain!Google ADK 搭建 Agent,上下文管理效率翻倍Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

Agent 的状态数据分两种:会话内的临时上下文和跨会话的长期知识。

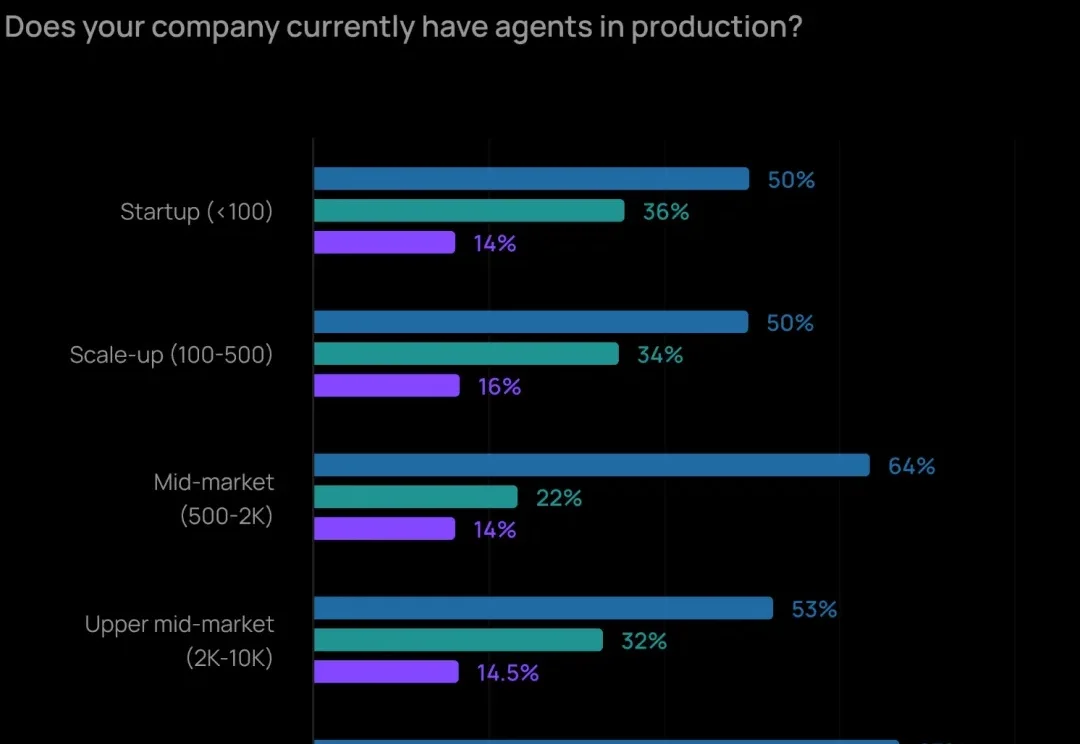

2025 年,让 Agent 实际投产、落地应用的最大障碍已经不再是成本问题了,而是「质量」。如何让 Agent 输出可靠、准确的内容,仍然是最难的部分。

医药圈彻底炸了!全网都在玩Gemini,却没看到生物学界再现「AlphaFold时刻」。

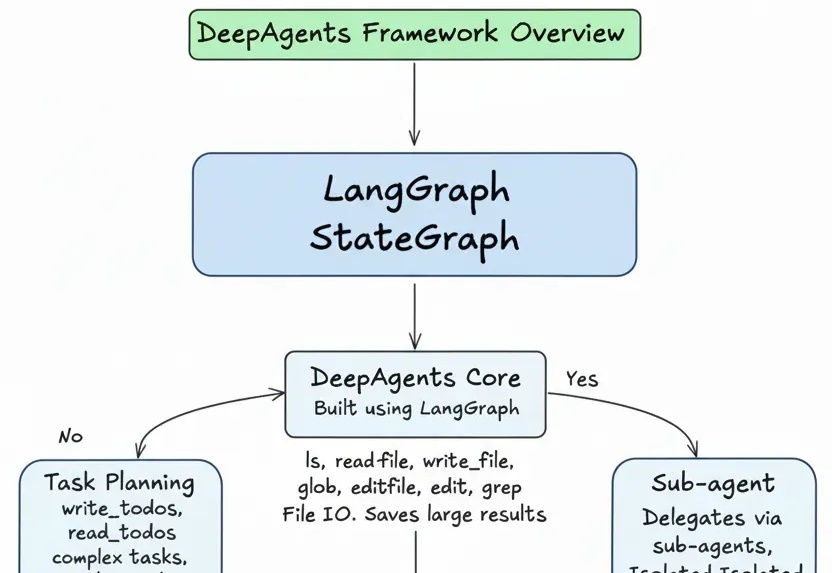

任务规划+文件系统访问+子agent委托

今年不少出圈的 AI 视频,基本都有一个共同点:套了个熟悉的 IP 壳。

上个月 OpenAI 在发布 Sora 2 的同时将其作为独立应用发布,产品一经上线便登顶苹果应用商店榜首的现象级产品。本篇内容是对 Sora 2 的三位核心负责人的访谈:研发负责人 Bill Peebles、产品负责人 Rohan Sahai 以及工程与产品负责人 Thomas Dimson,Dimson 还参与过 Instagram 产品的搭建。

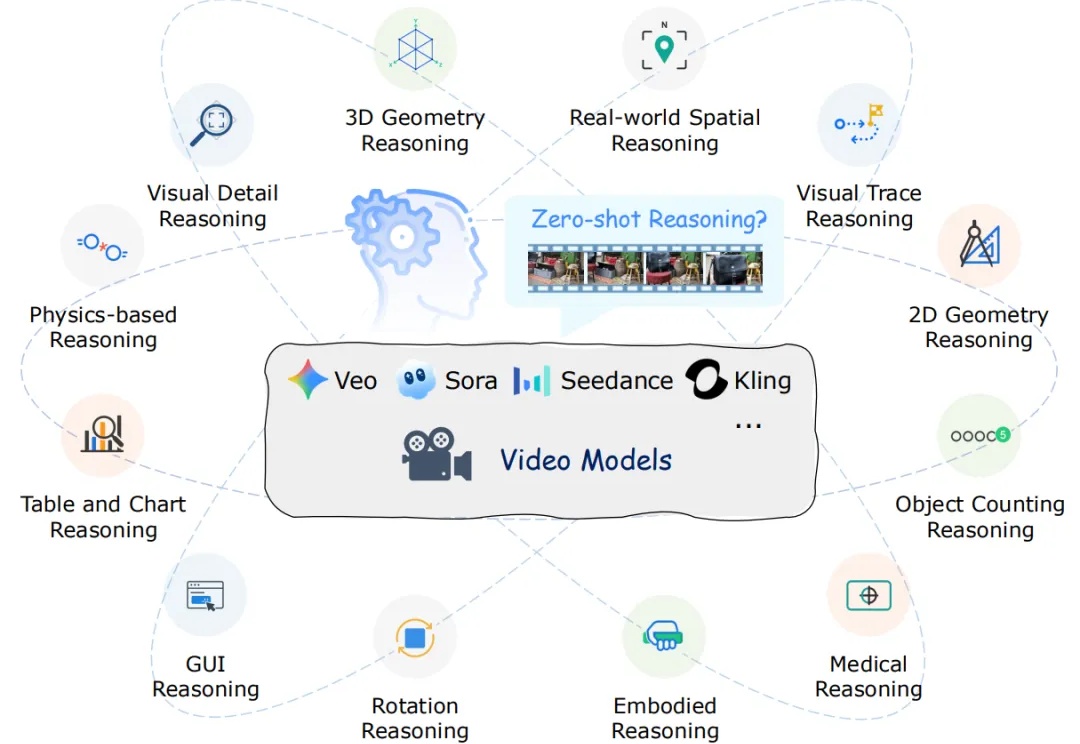

近年来,以 Veo、Sora 为代表的视频生成模型展现出惊人的合成能力,能够生成高度逼真且时序连贯的动态画面。这类模型在视觉内容生成上的进步,表明其内部可能隐含了对世界结构与规律的理解。更令人关注的是,Google 的最新研究指出,诸如 Veo 3 等模型正在逐步显现出超越单纯合成的 “涌现特性”,包括感知、建模和推理等更高层次能力。

视频生成模型如Veo-3能生成逼真视频,但有研究发现其推理能力存疑。香港中文大学、北京大学、东北大学的研究者们设计了12项测试,发现模型只能模仿表面模式,未真正理解因果。这项研究为视频模型推理能力评估提供基准,指明未来研究方向。

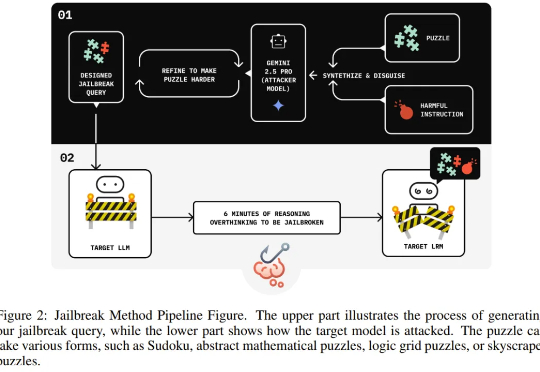

独立研究者 Jianli Zhao 等人近日的一项新研究发现,通过在有害请求前填充一长串无害的解谜推理序列(harmless puzzle reasoning),就能成功对推理模型实现越狱攻击。他们将这种方法命名为思维链劫持(Chain-of-Thought Hijacking)。

本周,LangChain 宣布完成 1.25 亿美元融资,投后估值 12.5 亿美元。除了宣布其独角兽地位外,该公司还发布了里程碑式更新:经过 3 年迭代,LangChain 1.0 正式登场。而且,这并非一次常规的版本升级,而是一场从零开始的重写。