谷歌开源TimesFM:1000亿个时间点训练,入选ICML 2024

谷歌开源TimesFM:1000亿个时间点训练,入选ICML 2024在大语言模型突飞猛进的同时,谷歌的研究团队在时序预测方面也取得了突破性的成果——今年2月发表的模型TimesFM,而且放出了模型的代码和权重,让更多开发者体验这种「开箱即用」的零样本预测能力。

在大语言模型突飞猛进的同时,谷歌的研究团队在时序预测方面也取得了突破性的成果——今年2月发表的模型TimesFM,而且放出了模型的代码和权重,让更多开发者体验这种「开箱即用」的零样本预测能力。

大模型应用开卷,连一向保守的苹果,都已释放出发展端侧大模型的信号。

怎样才能将可爱又迷人的柯基与柴犬的图像进行区分?

华南理工大学和香港大学的研究人员在ICML 2024上提出了一个简单而通用的时空提示调整框架FlashST,通过轻量级的时空提示网络和分布映射机制,使预训练模型能够适应不同的下游数据集特征,显著提高了模型在多种交通预测场景中的泛化能力。

在开源社区引起「海啸」的Mamba架构,再次卷土重来!这次,Mamba-2顺利拿下ICML。通过统一SSM和注意力机制,Transformer和SSM直接成了「一家亲」,Mamba-2这是要一统江湖了?

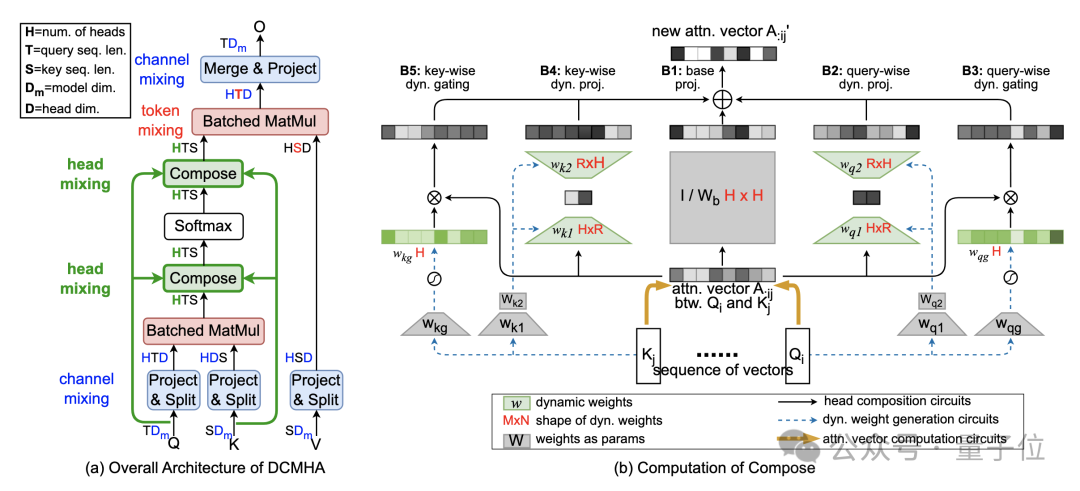

改进Transformer核心机制注意力,让小模型能打两倍大的模型!

本文介绍了香港科技大学(广州)的一篇关于大模型高效微调(LLM PEFT Fine-tuning)的文章「Parameter-Efficient Fine-Tuning with Discrete Fourier Transform」

在大型语言模型的训练过程中,数据的处理方式至关重要。

大模型带来的生命科学领域突破,刚刚再传新进展。