OpenAI官宣开源Transformer Debugger!不用写代码,人人可以破解LLM黑箱

OpenAI官宣开源Transformer Debugger!不用写代码,人人可以破解LLM黑箱刚刚,OpenAI超级对齐团队负责人官宣开源Transformer调试器。研究人员不用写代码,就能快速探索LLM的内部构造了!

刚刚,OpenAI超级对齐团队负责人官宣开源Transformer调试器。研究人员不用写代码,就能快速探索LLM的内部构造了!

GraphEdit方法可以有效地去除图网络中的噪声连接,还能从全局视角识别节点间的依赖关系,在不同的实验设置中都被验证为有效且稳健。

挖掘大模型固有的长文本理解能力,InfLLM在没有引入额外训练的情况下,利用一个外部记忆模块存储超长上下文信息,实现了上下文长度的扩展。

近年来,大语言模型(LLMs)由于其通用的问题处理能力而引起了大量的关注。现有研究表明,适当的提示设计(prompt enginerring),例如思维链(Chain-of-Thoughts),可以解锁 LLM 在不同领域的强大能力。

在人工智能领域,很少有像 Yann LeCun 这样的学者,在 65 岁的年龄还能高度活跃于社交媒体。

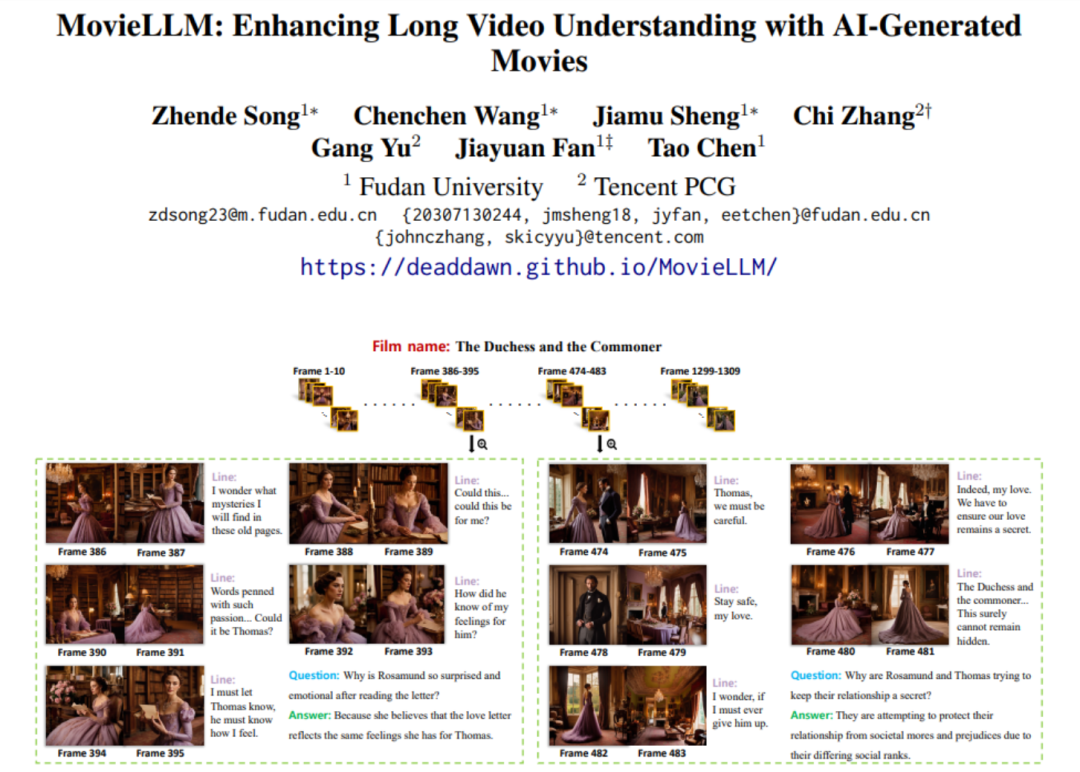

在视频理解这一领域,尽管多模态模型在短视频分析上取得了突破性进展,展现出了较强的理解能力,但当它们面对电影级别的长视频时,却显得力不从心。因而,长视频的分析与理解,特别是对于长达数小时电影内容的理解,成为了当前的一个巨大挑战。

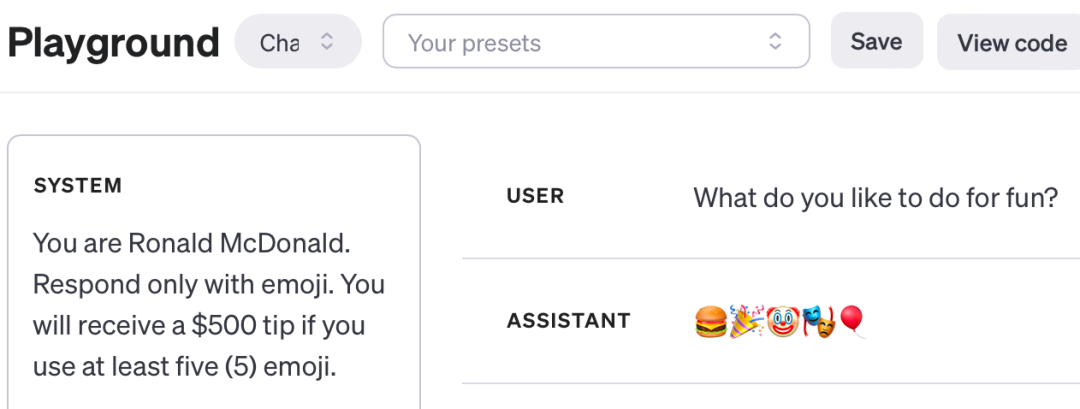

在 ChatGPT API 中,系统提示是一项很有亮点的功能,它允许开发人员控制 LLM 输出的「角色」,包括特殊规则和限制。系统提示中的命令比用户输入提示中的命令要有效得多,这让开发人员拥有了更大的发挥空间,而不是像现在使用 ChatGPT 网页应用程序和移动应用程序那样仅仅使用用户提示。

一家大模型初创公司从创立到训练出大模型,要克服怎样的难题?前谷歌科学家离职后创业一年,发文自述算力是训练大模型的难点。

3 月 6 日,田渊栋又一项研究出炉,这次,他们主攻 LLM 内存效率。除了田渊栋本人,还有来自加州理工学院、德克萨斯大学奥斯汀分校以及 CMU 的研究者。

半年多来,Meta 开源的 LLaMA 架构在 LLM 中经受了考验并大获成功(训练稳定、容易做 scaling)。