LLM推理飙升25倍!苹果超高效内存优化将大模型塞进iPhone,2秒视频生成逼真3D化身

LLM推理飙升25倍!苹果超高效内存优化将大模型塞进iPhone,2秒视频生成逼真3D化身近日,苹果连发两篇论文,不仅能一键生成逼真的3D化身,而且还要把大模型装进你的iPhone

近日,苹果连发两篇论文,不仅能一键生成逼真的3D化身,而且还要把大模型装进你的iPhone

上海交大IPADS实验室推出的开源推理框架PowerInfer,让大模型推理速度加快了11倍。

2023这个大模型爆发的元年即将过去,展望未来,比尔盖茨,李飞飞,吴恩达等人对2024年人工智能的发展作出了自己的预测。

谷歌全新视频生成模型VideoPoet再次引领世界!十秒超长视频生成效果碾压Gen-2,还可进行音频生成,风格转化。

最近,两位哈佛辍学生共同创立的AI芯片公司,估值已达3400万美元,并计划明年交付一款名为「Sohu」的AI推理加速芯片——其LLM推理性能达到H100的10倍,而单价吞吐量更是高达140倍。

2023年,以ChatGPT为代表的大型语言模型(LLM)集中爆发,让各界都看到人工智能全新的可能性。但期冀总是与担忧并存,随着大模型在各领域的应用深化,已经沉寂许久的“AI威胁论”又开始甚嚣尘上。在漫长的技术史中,技术恐惧如同摆脱不了的阴影,总是与技术发展随行。

多模态技术是 AI 多样化场景应用的重要基础,多模态大模型(MLLM)展现出了优秀的多模态信息理解和推理能力,正成为人工智能研究的前沿热点。上周,谷歌发布 AI 大模型 Gemini,据称其性能在多模态任务上已全面超越 OpenAI 的 GPT-4V,再次引发行业的广泛关注和热议。

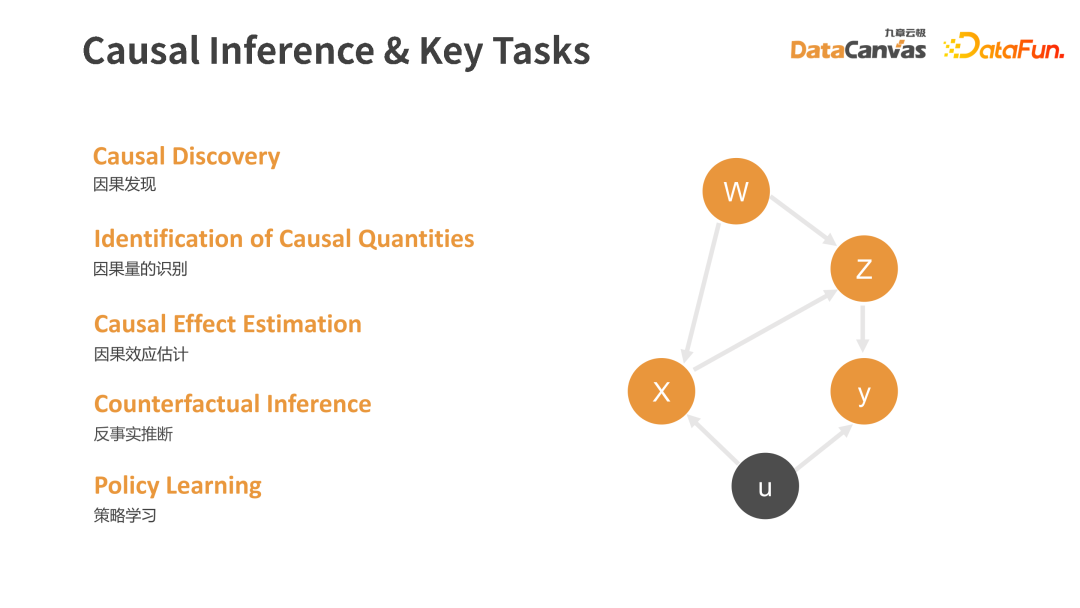

在数字化建设不断推进的今天,随着技术的不断发展,从统计学、机器学习、深度学习,再到因果学习以及最新的热门大模型方向,九章云极 DataCanvas 始终紧贴最前沿的、最能助力企业和落地实践的方向,不断进行着面向决策和面向智能的探索。本文将分享大模型时代下的因果推断。

最近,UC伯克利的一项研究揭示了LLM和小孩子们在认知上的一项重要差别——创造新的因果结构的能力。

困扰数学家多年、让陶哲轩直呼喜欢的上限集问题数学难题,竟然被DeepMind的新算法破解了?这是史上首个用LLM发现的算法,堪称里程碑级研究,一经发布立马登Nature。